Hadoop生态圈-注册并加载协处理器(coprocessor)的三种方式

Hadoop生态圈-注册并加载协处理器(coprocessor)的三种方式

作者:尹正杰

版权声明:原创作品,谢绝转载!否则将追究法律责任。

到目前为止,大家已经掌握了如何使用过滤器来减少服务器端通过网络返回到客户端的数据量。HBase中还有一些特性让用户甚至可以把一部分计算也移动到数据的存放端,他就是本篇博客的主角:协处理器(coprocessor)。

一.协处理器简介

使用客户端API,配合筛选机制,例如,使用过滤器或限制列族的范围,都可以控制被返回到客户端的数据量。如果可以更进一步优化会更好,例如,数据的处理流程直接存放到服务器端执行,然后仅返回一个小的处理结果集。这类似于一个小型的MapReduce框架,该框架将工作分发到整个集群。

协处理器运行用户在region服务器上运行自己的代码,更准确的说是允许用户执行region级的操作,并且可以使用RDBMS中触发器(trigger)类似的功能。在客户端,用户不用关心操作具体在哪里执行,HBase的分布式框架会帮助用户把这些工作变得透明。这里用户可以监听一些隐式的事件,并利用其来完成一些辅助任务。如果这还不够,用户还可以自己扩展现有的RPC协议引用自己的调用,这些调用有客户端出阿发,并在服务器端执行。

协处理器框架已经提供了一些类,用户可以通过继承这些类来扩展自己的功能。这些类主要分为两大类,即observer和endpoint。以下是各个功能的简要介绍。

1>.observer

这一类协处理器与触发器(trigger)类似:回调函数(也被称作钩子函数,hook)在一些特定时间发生时被执行。这些时间包括一些用户产生的事件,也包括服务器内部自动产生的事件,也包括服务器端内部自动产生的事件。协处理器框架提供的接口如下所示:

a>.RegionObserver:用户可以用这种的处理器处理数据修改时间,他们与表的region联系紧密;

b>.MasterObserve:可以被用作管理或DDL类型的操作,这些是集群级事件;

c>.WALObserver:提供控制WAL的钩子函数;

observer提供了一些设计好的回调函数,每个操作在集群服务器端都可以被调用。

2>.endpoint

除了事件处理之外还需要将用户自定义操作添加到服务器端。用户代码可以被部署到管理数据的服务器端,例如,做一些服务器端计算的工作。endpoint通过添加一些远程过程调用来动态扩展RPC协议。可以把他们理解为与RDBMS中类似的存储过程,endpoint可以与observer的实现组合起来直接作用于服务器端的状态。

二.RegionObserver类

在region级别中介绍的Coprocessor第一个子类是RegionObserver类。从名字中可以看出它属于observer协处理器:当一个特定的region级别的操作发生时,他们的钩子函数会被触发。

BaseRegionObserver类可以作为所有用户实现监听类型协处理器的基类。它实现了所有RegionObserver接口的空方法,所有在默认情况下基础这个类的协处理器没有任何功能。用户需要重载他们干星期的方法实现自己的功能。接下来我们体验一下observer。

1>.编写MyRegionObserver.java 文件

/*

@author :yinzhengjie

Blog:http://www.cnblogs.com/yinzhengjie/tag/Hadoop%E8%BF%9B%E9%98%B6%E4%B9%8B%E8%B7%AF/

EMAIL:y1053419035@qq.com

*/

package cn.org.yinzhengjie.coprocessor; import org.apache.hadoop.hbase.Cell;

import org.apache.hadoop.hbase.CoprocessorEnvironment;

import org.apache.hadoop.hbase.client.Delete;

import org.apache.hadoop.hbase.client.Durability;

import org.apache.hadoop.hbase.client.Get;

import org.apache.hadoop.hbase.client.Put;

import org.apache.hadoop.hbase.coprocessor.BaseRegionObserver;

import org.apache.hadoop.hbase.coprocessor.ObserverContext;

import org.apache.hadoop.hbase.coprocessor.RegionCoprocessorEnvironment;

import org.apache.hadoop.hbase.regionserver.wal.WALEdit; import java.io.*;

import java.util.List; public class MyRegionObserver extends BaseRegionObserver {

File f = new File("/home/yinzhengjie/coprocessor.log"); @Override

public void start(CoprocessorEnvironment e) throws IOException {

super.start(e); if(!f.exists()){

f.createNewFile();

}

FileOutputStream fos = new FileOutputStream( f, true);

fos.write("this is a start function\n".getBytes());

fos.close();

} @Override

public void stop(CoprocessorEnvironment e) throws IOException {

super.stop(e);

if(!f.exists()){

f.createNewFile();

}

FileOutputStream fos = new FileOutputStream(f, true);

fos.write("this is a stop function\n".getBytes());

fos.close();

} @Override

public void postFlush(ObserverContext<RegionCoprocessorEnvironment> e) throws IOException {

super.postFlush(e);

if(!f.exists()){

f.createNewFile();

} //

String table = e.getEnvironment().getRegionInfo().getTable().getNameAsString(); FileOutputStream fos = new FileOutputStream(f, true);

fos.write(("this is a flush function, table: " + table + "被刷新了\n ").getBytes());

fos.close(); } @Override

public void postGetOp(ObserverContext<RegionCoprocessorEnvironment> e, Get get, List<Cell> results) throws IOException {

super.postGetOp(e, get, results);

if(!f.exists()){

f.createNewFile();

}

//通过put得到操作行

String row = new String(get.getRow()); //

String table = e.getEnvironment().getRegionInfo().getTable().getNameAsString(); FileOutputStream fos = new FileOutputStream(f, true);

fos.write(("this is a get function, table: " + table + ",row: " + row + "发生了修改\n ").getBytes());

fos.close();

} @Override

public void postPut(ObserverContext<RegionCoprocessorEnvironment> e, Put put, WALEdit edit, Durability durability) throws IOException {

super.postPut(e, put, edit, durability); if(!f.exists()){

f.createNewFile();

} //通过put得到操作行

String row = new String(put.getRow()); //

String table = e.getEnvironment().getRegionInfo().getTable().getNameAsString(); FileOutputStream fos = new FileOutputStream(f, true);

fos.write(("this is a put function, table: " + table + ",row: " + row + "发生了修改\n ").getBytes());

fos.close(); } @Override

public void postDelete(ObserverContext<RegionCoprocessorEnvironment> e, Delete delete, WALEdit edit, Durability durability) throws IOException {

super.postDelete(e, delete, edit, durability); if(!f.exists()){

f.createNewFile();

}

//通过put得到操作行

String row = new String(delete.getRow()); //

String table = e.getEnvironment().getRegionInfo().getTable().getNameAsString(); FileOutputStream fos = new FileOutputStream(f, true);

fos.write(("this is a delete function, table: " + table + ",row: " + row + "发生了修改\n ").getBytes());

fos.close();

}

}

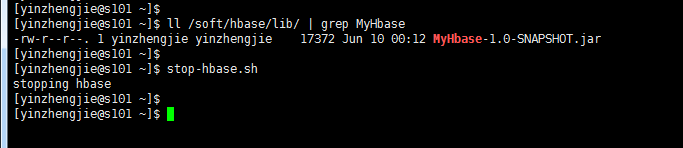

2>.将以上代码进行打包操作,并将其放置/soft/hbase/lib下。并关闭hbase

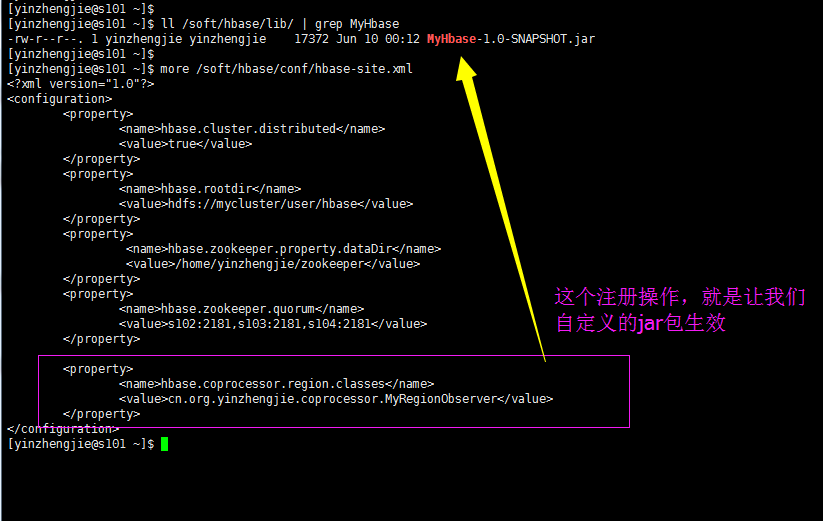

3>.注册(/soft/hbase/conf/hbase-site.xml),目的是使用咱们写的jar包。

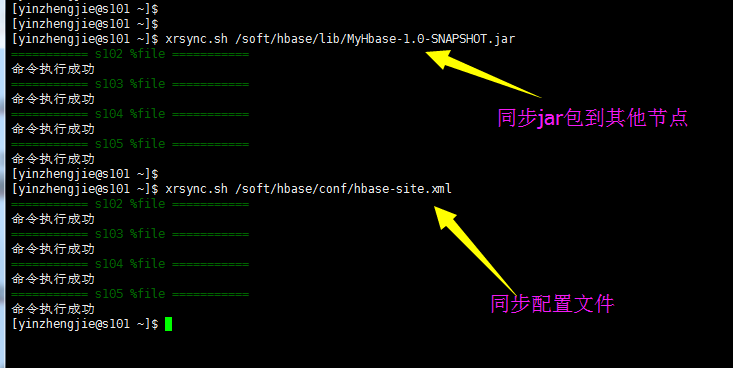

4>.同步文件

[yinzhengjie@s101 ~]$ more `which xrsync.sh`

#!/bin/bash

#@author :yinzhengjie

#blog:http://www.cnblogs.com/yinzhengjie

#EMAIL:y1053419035@qq.com #判断用户是否传参

if [ $# -lt 1 ];then

echo "请输入参数";

exit

fi #获取文件路径

file=$@ #获取子路径

filename=`basename $file` #获取父路径

dirpath=`dirname $file` #获取完整路径

cd $dirpath

fullpath=`pwd -P` #同步文件到DataNode

for (( i=102;i<=105;i++ ))

do

#使终端变绿色

tput setaf 2

echo =========== s$i %file ===========

#使终端变回原来的颜色,即白灰色

tput setaf 7

#远程执行命令

rsync -lr $filename `whoami`@s$i:$fullpath

#判断命令是否执行成功

if [ $? == 0 ];then

echo "命令执行成功"

fi

done

[yinzhengjie@s101 ~]$

[yinzhengjie@s101 ~]$ more `which xrsync.sh`

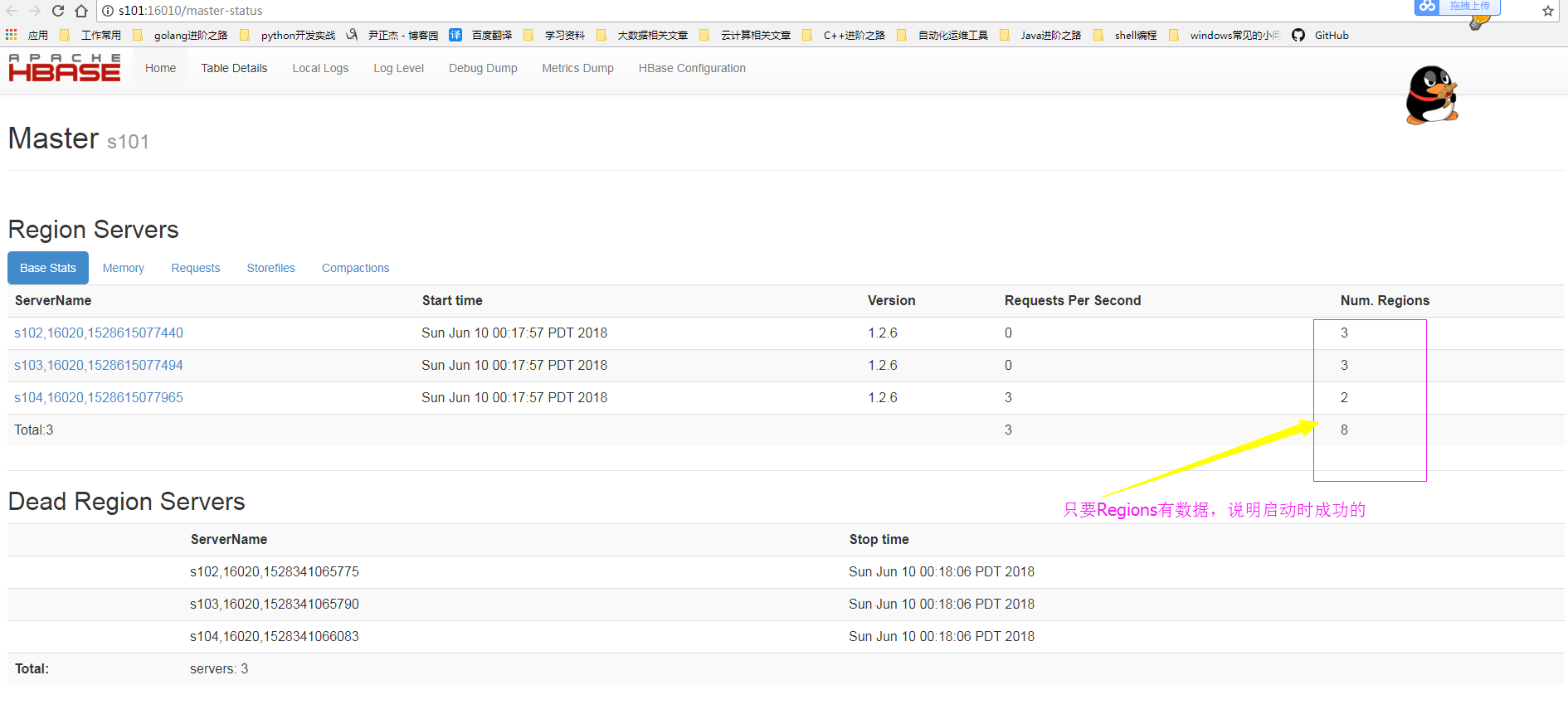

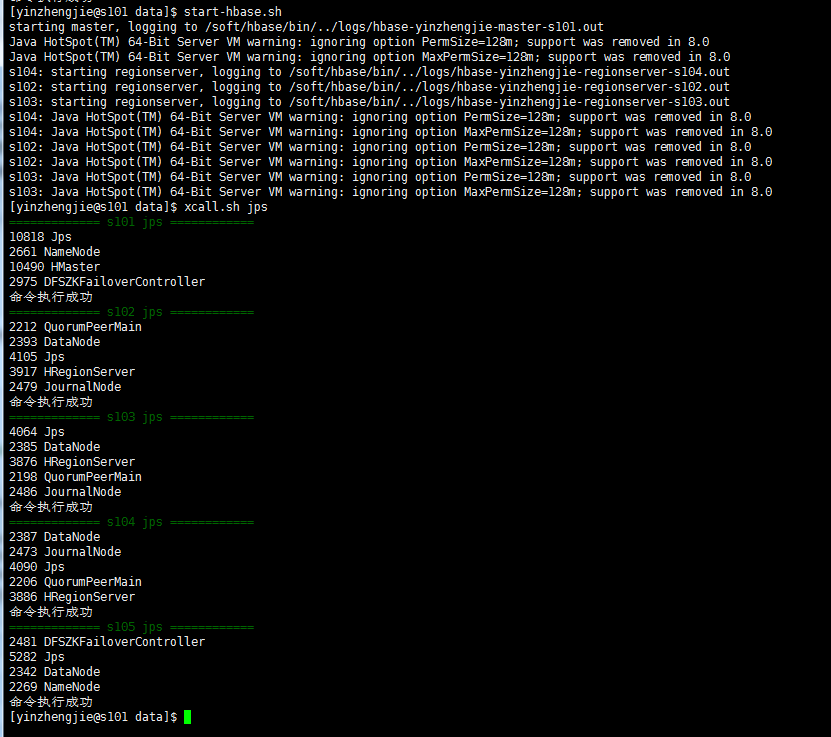

5>.启动hbase

[yinzhengjie@s101 ~]$ start-hbase.sh

starting master, logging to /soft/hbase/bin/../logs/hbase-yinzhengjie-master-s101.out

Java HotSpot(TM) -Bit Server VM warning: ignoring option PermSize=128m; support was removed in 8.0

Java HotSpot(TM) -Bit Server VM warning: ignoring option MaxPermSize=128m; support was removed in 8.0

s104: starting regionserver, logging to /soft/hbase/bin/../logs/hbase-yinzhengjie-regionserver-s104.out

s103: starting regionserver, logging to /soft/hbase/bin/../logs/hbase-yinzhengjie-regionserver-s103.out

s102: starting regionserver, logging to /soft/hbase/bin/../logs/hbase-yinzhengjie-regionserver-s102.out

s104: Java HotSpot(TM) -Bit Server VM warning: ignoring option PermSize=128m; support was removed in 8.0

s104: Java HotSpot(TM) -Bit Server VM warning: ignoring option MaxPermSize=128m; support was removed in 8.0

s103: Java HotSpot(TM) -Bit Server VM warning: ignoring option PermSize=128m; support was removed in 8.0

s103: Java HotSpot(TM) -Bit Server VM warning: ignoring option MaxPermSize=128m; support was removed in 8.0

s102: Java HotSpot(TM) -Bit Server VM warning: ignoring option PermSize=128m; support was removed in 8.0

s102: Java HotSpot(TM) -Bit Server VM warning: ignoring option MaxPermSize=128m; support was removed in 8.0

[yinzhengjie@s101 ~]$

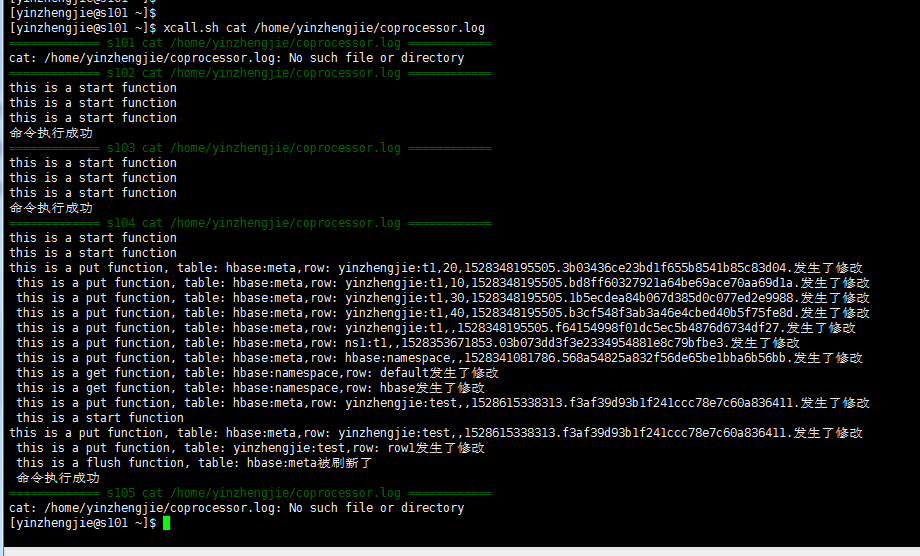

6>.验证(get,put,还有delete等操作都会在“/home/yinzhengjie/coprocessor.log”文件中记录)

[yinzhengjie@s101 ~]$ hbase shell

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/soft/hbase-1.2./lib/slf4j-log4j12-1.7..jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/soft/hadoop-2.7./share/hadoop/common/lib/slf4j-log4j12-1.7..jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.slf4j.impl.Log4jLoggerFactory]

HBase Shell; enter 'help<RETURN>' for list of supported commands.

Type "exit<RETURN>" to leave the HBase Shell

Version 1.2., rUnknown, Mon May :: CDT hbase(main)::> list

TABLE

ns1:t1

yinzhengjie:t1

row(s) in 0.2120 seconds => ["ns1:t1", "yinzhengjie:t1"]

hbase(main)::> create 'yinzhengjie:test','f1'

row(s) in 1.3300 seconds => Hbase::Table - yinzhengjie:test

hbase(main)::> list

TABLE

ns1:t1

yinzhengjie:t1

yinzhengjie:test

row(s) in 0.0080 seconds => ["ns1:t1", "yinzhengjie:t1", "yinzhengjie:test"]

hbase(main)::> put 'yinzhengjie:test','row1','f1:name','yinzhengjie'

row(s) in 0.1720 seconds hbase(main)::>

三.注册并加载协处理器的三种方式

1.使用XML文件进行注册(范围:世界级)

可以参考上面的配置。

2.使用代码,在创建表的时候,加载协处理器 (范围:表级)

1>.将jar包上传到hdfs中

[yinzhengjie@s101 data]$ ll

total

-rw-r--r--. yinzhengjie yinzhengjie May : fastjson-1.2..jar

-rw-r--r--. yinzhengjie yinzhengjie Jun hbase-1.2.-bin.tar.gz

-rw-r--r--. yinzhengjie yinzhengjie Jun : MyHbase-1.0-SNAPSHOT.jar

-rw-r--r--. yinzhengjie yinzhengjie Jun : temptags.txt

-rw-r--r--. yinzhengjie yinzhengjie Jun : yinzhengjieCode-1.0-SNAPSHOT.jar

[yinzhengjie@s101 data]$ hdfs dfs -put MyHbase-1.0-SNAPSHOT.jar /myhbase.jar

[yinzhengjie@s101 data]$

2>.停止HBase服务并清空之前的测试数据

[yinzhengjie@s101 data]$ stop-hbase.sh

stopping hbase................

[yinzhengjie@s101 data]$

[yinzhengjie@s101 data]$ more `which xcall.sh`

#!/bin/bash

#@author :yinzhengjie

#blog:http://www.cnblogs.com/yinzhengjie

#EMAIL:y1053419035@qq.com #判断用户是否传参

if [ $# -lt ];then

echo "请输入参数"

exit

fi #获取用户输入的命令

cmd=$@ for (( i=;i<=;i++ ))

do

#使终端变绿色

tput setaf

echo ============= s$i $cmd ============

#使终端变回原来的颜色,即白灰色

tput setaf

#远程执行命令

ssh s$i $cmd

#判断命令是否执行成功

if [ $? == ];then

echo "命令执行成功"

fi

done

[yinzhengjie@s101 data]$

[yinzhengjie@s101 data]$ xcall.sh rm -rf /home/yinzhengjie/coprocessor.log

============= s101 rm -rf /home/yinzhengjie/coprocessor.log ============

命令执行成功

============= s102 rm -rf /home/yinzhengjie/coprocessor.log ============

命令执行成功

============= s103 rm -rf /home/yinzhengjie/coprocessor.log ============

命令执行成功

============= s104 rm -rf /home/yinzhengjie/coprocessor.log ============

命令执行成功

============= s105 rm -rf /home/yinzhengjie/coprocessor.log ============

命令执行成功

[yinzhengjie@s101 data]$

3>.编辑配置文件(将之前实现的配置删除,具体保留配置如下)

[yinzhengjie@s101 data]$ more /soft/hbase/conf/hbase-site.xml

<?xml version="1.0"?>

<configuration>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.rootdir</name>

<value>hdfs://mycluster/user/hbase</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/home/yinzhengjie/zookeeper</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>s102:,s103:,s104:</value>

</property> </configuration>

[yinzhengjie@s101 data]$

4>.启动HBase并运行以下代码,创建ns1:observer表并指定加载协处理器

/*

@author :yinzhengjie

Blog:http://www.cnblogs.com/yinzhengjie/tag/Hadoop%E8%BF%9B%E9%98%B6%E4%B9%8B%E8%B7%AF/

EMAIL:y1053419035@qq.com

*/

package cn.org.yinzhengjie.coprocessor; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.HColumnDescriptor;

import org.apache.hadoop.hbase.HTableDescriptor;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.Admin;

import org.apache.hadoop.hbase.client.Connection;

import org.apache.hadoop.hbase.client.ConnectionFactory; public class AssignCopro { public static void main(String[] args) throws Exception { Configuration conf = HBaseConfiguration.create();

//先建立连接

Connection conn = ConnectionFactory.createConnection(conf);

Admin admin = conn.getAdmin();

//列描述符

HColumnDescriptor f1 = new HColumnDescriptor("f1");

HColumnDescriptor f2 = new HColumnDescriptor("f2");

HTableDescriptor htd = new HTableDescriptor(TableName.valueOf("ns1:observer")); htd.addCoprocessor("cn.org.yinzhengjie.coprocessor.MyRegionObserver",

new Path("/myhbase.jar"), , null); //表中添加列族

htd.addFamily(f1);

htd.addFamily(f2);

admin.createTable(htd);

admin.close();

}

}

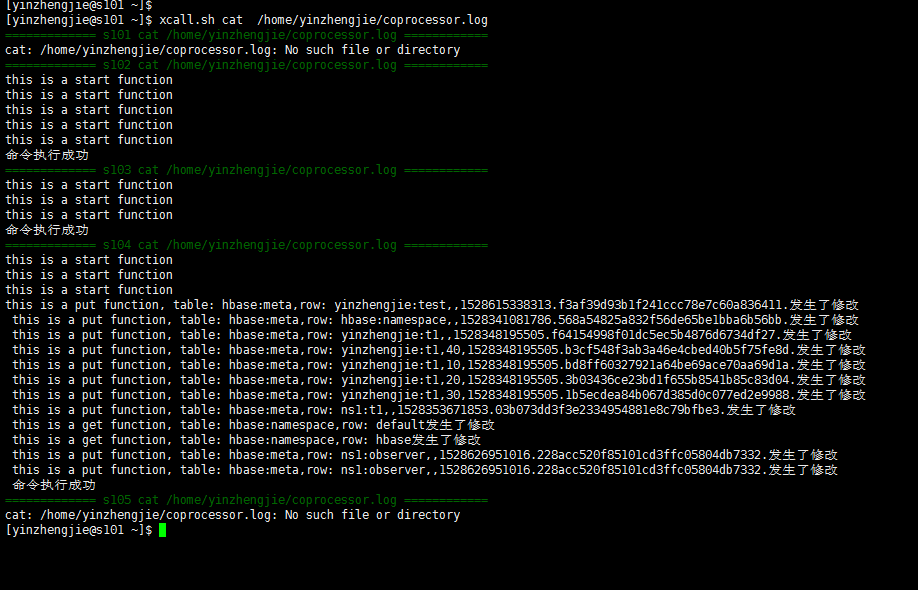

5>.运行以下代码后,查看“/home/yinzhengjie/coprocessor.log”文件如下:

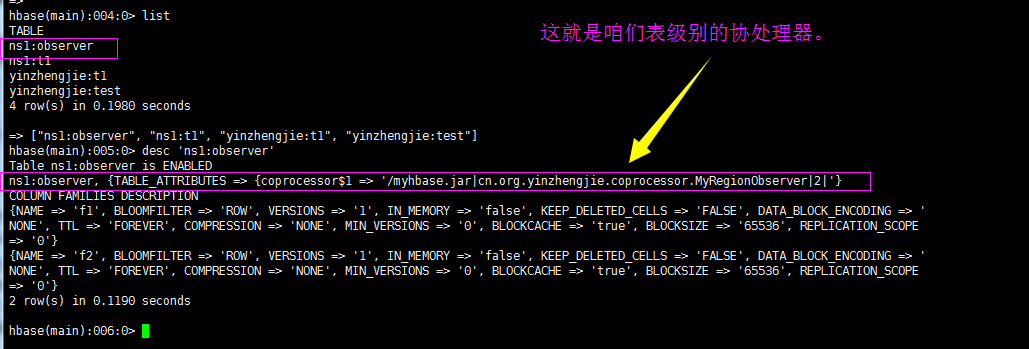

查看HBase内容如下:

3.使用命令激活协处理器(范围:表级)

hbase(main)::> list

TABLE

ns1:observer

ns1:t1

yinzhengjie:t1

yinzhengjie:test

row(s) in 0.0210 seconds => ["ns1:observer", "ns1:t1", "yinzhengjie:t1", "yinzhengjie:test"]

hbase(main)::> disable 'ns1:t1'

row(s) in 2.3300 seconds hbase(main)::> alter 'ns1:t1', 'coprocessor'=>'hdfs://mycluster/myhbase.jar|cn.org.yinzhengjie.coprocessor.MyRegionObserver|0|'

Updating all regions with the new schema...

/ regions updated.

Done.

row(s) in 1.9440 seconds hbase(main)::> enable 'ns1:t1'

row(s) in 1.2570 seconds hbase(main)::>

移除协处理器步骤如下:

Hadoop生态圈-注册并加载协处理器(coprocessor)的三种方式的更多相关文章

- ios网络学习------4 UIWebView的加载本地数据的三种方式

ios网络学习------4 UIWebView的加载本地数据的三种方式 分类: IOS2014-06-27 12:56 959人阅读 评论(0) 收藏 举报 UIWebView是IOS内置的浏览器, ...

- 转 Velocity中加载vm文件的三种方式

Velocity中加载vm文件的三种方式 velocitypropertiespath Velocity中加载vm文件的三种方式: 方式一:加载classpath目录下的vm文件 Prope ...

- Velocity中加载vm文件的三种方式

Velocity中加载vm文件的三种方式: a. 加载classpath目录下的vm文件 /** * 初始化Velocity引擎 * --VelocityEngine是单例模式,线程安全 * @th ...

- iOS --- UIWebView的加载本地数据的三种方式

UIWebView是IOS内置的浏览器,可以浏览网页,打开文档 html/htm pdf docx txt等格式的文件. safari浏览器就是通过UIWebView做的. 服务器将MIM ...

- 加载gif动画的三种方式

GifView.h/** * 调用结束就开始播放动画,如果需要用户指定何时播放的话,只需要把timer的开始放到合适的位置.通过对CFDictonaryRaf 也就是gifProperties的改变, ...

- Spring加载Properties配置文件的三种方式

一.通过 context:property-placeholder 标签实现配置文件加载 1) 用法: 1.在spring.xml配置文件中添加标签 <context:property-plac ...

- MVC加载分布页的三种方式

第一种: @Html.Partial("_分部页") 第二种: @{ Html.RenderPartial("分部页" ...

- 加载xib文件的两种方式

一.加载xib文件的两种方式 1.方法一(NewsCell是xib文件的名称) NSArray *objects = [[NSBundle mainBundle] loadNibNamed:@&quo ...

- Spring加载properties文件的两种方式

在项目中如果有些参数经常需要修改,或者后期可能需要修改,那我们最好把这些参数放到properties文件中,源代码中读取properties里面的配置,这样后期只需要改动properties文件即可, ...

随机推荐

- java第二次试验报告

北京电子科技学院(BESTI) 实 验 报 告 课程:Java程序设计 班级:1353 姓名:郭皓 学号:20135327 成绩: 指导 ...

- SpringMVC(一)-- springmvc的系统学习之配置方式

资源:尚学堂 邹波 springmvc框架视频 一.springMVC 工作流程 页面请求---->控制器(Controller DispatcherServlet)----& ...

- oh my god 四则运算

Week1地址:https://git.coding.net/leiqh549/four.git 需求分析: 1.一个生成n道四则运算的程序,要求数字在0-100间,运算符在3-5个之间且运算符至少包 ...

- Hive与Hbase的区别

1. 两者分别是什么? Apache Hive是一个构建在Hadoop基础设施之上的数据仓库.通过Hive可以使用HQL语言查询存放在HDFS上的数据.HQL是一种类SQL语言,这种语言最终被 ...

- Intellij IDEA中file size exceeds configured limit解决

把Hadoop源码导入IDEA中后,其中有个ClientNamenodeProtocolProtos文件代码高达82997行,IDEA直接就不把它当java类看了,报file size exceeds ...

- Scrum 5.0

5.0--------------------------------------------------- 1.团队成员完成自己认领的任务. 2.燃尽图:理解.设计并画出本次Sprint的燃尽图的理 ...

- Java基本程序设计结构

一.要求: 1.设平面上有一个m×n 的网格,将左下角的网格点标记为(0,0)而右上角的网格点标记为(m,n).某人想从(0,0)出发沿网格线行进到达(m,n),但是在网格点(i,j)处他只能向上行进 ...

- Alpha阶段敏捷冲刺①Scrum 冲刺博客

第 1 篇 Scrum 冲刺博客对整个冲刺阶段起到领航作用,应该主要包含三个部分的内容: 各个成员在 Alpha 阶段认领的任务 成员 任务 张晨晨 完成界面设计(前端) 黄登峰 完成界面设计(前端) ...

- Python学习笔记day01--Python基础

1 python的应用 Python崇尚优美.清晰.简单,是一个优秀并广泛使用的语言. Python可以应用于众多领域,如:数据分析.组件集成.网络服务.图像处理.数值计算和科学计算等 ...

- mysql中字符串类型char(n)和varchar(n)的区别

n的含义 根据网络上找到的结果(不能保证准确),在5.0.3以后版本中,n均代表字符数,而不是字节数:我用来测试的版本是5.7.20,该版本中,n表示字符数. 验证过程如下 建表 CREATE TAB ...