hdfs基本操作命令

hdfs文件的相关操作主要使用hadoop fs、hadoop dfs、hdfs dfs 命令,以下对最常用的相关命令进行简要说明。

hadoop fs -ls 显示当前目录结构,-ls -R 递归显示目录结构

hadoop fs -mkdir 创建目录

hadoop fs -rm 删除文件,-rm -R 递归删除目录和文件

hadoop fs -put [localsrc] [dst] 从本地加载文件到HDFS

hadoop fs -get [dst] [localsrc] 从HDFS导出文件到本地

hadoop fs - copyFromLocal [localsrc] [dst] 从本地加载文件到HDFS,与put一致

hadoop fs -copyToLocal [dst] [localsrc] 从HDFS导出文件到本地,与get一致

hadoop fs -test -e 检测目录和文件是否存在,存在返回值$?为0,不存在返回1

hadoop fs -text 查看文件内容

hadoop fs -du 统计目录下各文件大小,单位字节。-du -s 汇总目录下文件大小,-du -h 显示单位

hadoop fs -tail 显示文件末尾

hadoop fs -cp [src] [dst] 从源目录复制文件到目标目录

hadoop fs -mv [src] [dst] 从源目录移动文件到目标目录

下面的对上面命令的操作演示

1,hadoop fs -ls 显示当前目录结构,-ls -R 递归显示目录结构

hdfs文件的相关操作主要使用hadoop fs、hadoop dfs、hdfs dfs 命令,以下对最常用的相关命令进行简要说明。

hadoop fs -ls 显示当前目录结构,-ls -R 递归显示目录结构

hadoop fs -mkdir 创建目录

hadoop fs -rm 删除文件,-rm -R 递归删除目录和文件

hadoop fs -put [localsrc] [dst] 从本地加载文件到HDFS

hadoop fs -get [dst] [localsrc] 从HDFS导出文件到本地

hadoop fs - copyFromLocal [localsrc] [dst] 从本地加载文件到HDFS,与put一致

hadoop fs -copyToLocal [dst] [localsrc] 从HDFS导出文件到本地,与get一致

hadoop fs -test -e 检测目录和文件是否存在,存在返回值$?为0,不存在返回1

hadoop fs -text 查看文件内容

hadoop fs -du 统计目录下各文件大小,单位字节。-du -s 汇总目录下文件大小,-du -h 显示单位

hadoop fs -tail 显示文件末尾

hadoop fs -cp [src] [dst] 从源目录复制文件到目标目录

hadoop fs -mv [src] [dst] 从源目录移动文件到目标目录

下面的对上面命令的操作演示

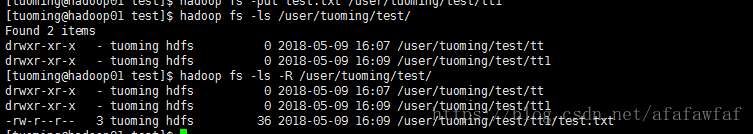

1,hadoop fs -ls 显示当前目录结构,-ls -R 递归显示目录结构

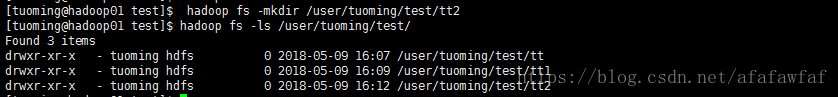

2,hadoop fs -mkdir 创建目录

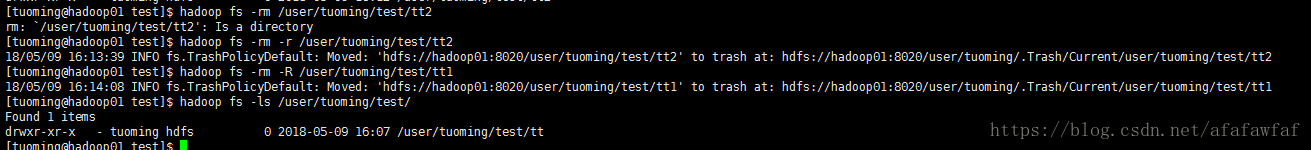

3,hadoop fs -rm 删除文件,-rm -R 递归删除目录和文件

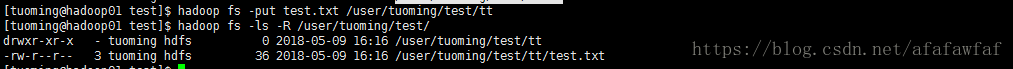

4,hadoop fs -put [localsrc] [dst] 从本地加载文件到HDFS

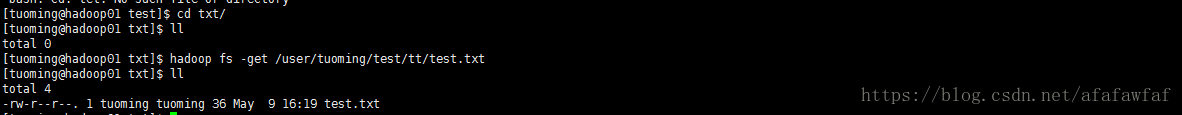

5,hadoop fs -get [dst] [localsrc] 从HDFS导出文件到本地

6,hadoop fs - copyFromLocal [localsrc] [dst] 从本地加载文件到HDFS,与put一致

7,hadoop fs -copyToLocal [dst] [localsrc] 从HDFS导出文件到本地,与get一致

8,hadoop fs -test -e 检测目录和文件是否存在,存在返回值$?为0,不存在返回1

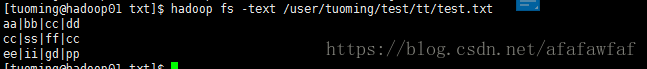

9,hadoop fs -text 查看文件内容

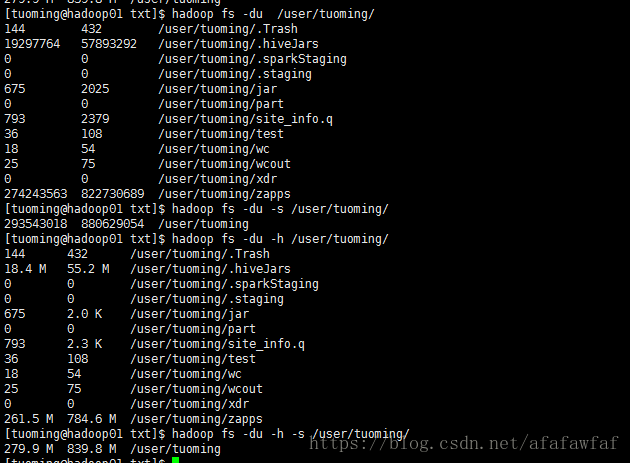

10,hadoop fs -du 统计目录下各文件大小,单位字节。-du -s 汇总目录下文件大小,-du -h 显示单位

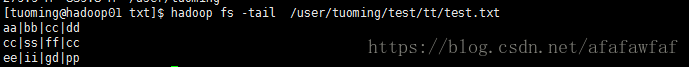

11,hadoop fs -tail 显示文件末尾

12,hadoop fs -cp [src] [dst] 从源目录复制文件到目标目录

13,hadoop fs -mv [src] [dst] 从源目录移动文件到目标目录

hdfs基本操作命令的更多相关文章

- 简单hdfs相关操作命令

HDFS常用操作命令 启动hdfs #start-all.sh 查看hdfs的配置文件 #cat hdfs-site.sh #hadoop fs -put /soft/jdk / #HDFS上传文件命 ...

- HDFS常用操作命令

启动hdfs#start-all.sh查看hdfs的配置文件#cat hdfs-site.sh#hadoop fs -put /soft/jdk /#HDFS上传文件命令查看上传后的文件属性#hado ...

- Hadoop HDFS常用操作命令

hadoop常用命令:hadoop fs查看Hadoop HDFS支持的所有命令 hadoop fs –ls列出目录及文件信息 hadoop fs –lsr循环列出目录.子目录及文件信息 hadoop ...

- HDFS文件操作命令手册

HDFS文件操作的基本格式是: bin/hadoop dfs -cmd <args> 1. cat $ hadoop dfs -cat URI [URI …] #将参数所指示的文件的内容输 ...

- Hadoop框架之HDFS的shell操作

既然HDFS是存取数据的分布式文件系统,那么对HDFS的操作,就是文件系统的基本操作,比如文件的创建.修改.删除.修改权限等,文件夹的创建.删除.重命名等.对HDFS的操作命令类似于Linux的she ...

- Hadoop开发第6期---HDFS的shell操作

一.HDFS的shell命令简介 我们都知道HDFS 是存取数据的分布式文件系统,那么对HDFS 的操作,就是文件系统的基本操作,比如文件的创建.修改.删除.修改权限等,文件夹的创建.删除.重命名等. ...

- (第3篇)HDFS是什么?HDFS适合做什么?我们应该怎样操作HDFS系统?

摘要: 这篇文章会详细介绍HDFS是什么,HDFS的作用,适合和不适合的场景,我们该如何操作HDFS? HDFS文件系统 Hadoop 附带了一个名为 HDFS(Hadoop分布式文件系统)的分布 ...

- HDFS命令实现分析

HDFS命令概述 HDFS命令涉及两类,一类是hadoop命令,一类是hdfs命令,功能也分为两类,第一类是HDFS文件操作命令,第二类是HDFS管理命令. 二者都是shell命令,真正的命令只有ha ...

- HDFS文件系统

Hadoop 附带了一个名为 HDFS(Hadoop分布式文件系统)的分布式文件系统,专门存储超大数据文件,为整个Hadoop生态圈提供了基础的存储服务. 本章内容: 1) HDFS文件系统的特点,以 ...

随机推荐

- Linux上合理设置网卡的MTU值

MTU:是网络的最大传输单元,通信术语:最大传输单元(Maximum Transmission Unit,MTU)是指一种通信协议的某一层上面所能通过的最大数据包大小(以字节为单位).最大传输单元这个 ...

- uni-app仿抖音APP短视频+直播+聊天实例|uniapp全屏滑动小视频+直播

基于uniapp+uView-ui跨端H5+小程序+APP短视频|直播项目uni-ttLive. uni-ttLive一款全新基于uni-app技术开发的仿制抖音/快手短视频直播项目.支持全屏丝滑般上 ...

- 我下载了python所有包,用以备份,有需要的自提

1.背景 我最近准备把1985年-2019年的全国30m分辨率土地利用数据按照地级市进行裁剪与归纳,这需要用到Geopandas对shp数据进行批量操作.在安装Geopandas的python包时,遇 ...

- supermvc介绍

马上要开始写毕设了,需要一个合适的框架.想想自己用过的几个框框speedphp tp啊 还有公司的 dagger啊 ,大同小易.每一种都有自己喜欢的地方.然后想到了二八理论,我们常用的功能可能不到框架 ...

- Jmeter扩展组件开发(9) - 解决空指针问题

问题分析 上一节https://www.cnblogs.com/gltou/p/14967005.html功能描述内容为空,导致Jmeter报空指针 CODE List desc = new Arra ...

- requests接口自动化-动态关联text/html格式

动态关联,前一个接口返回的值为后一个接口请求的参数. # 动态关联 import requests def test_cookies(): # 以百度为例 r_baidu=requests.get(' ...

- 定要过python二级 选择题第5套

1. 2.. 3. https://zhidao.baidu.com/question/1952133724016713828.html 4. 5. 6. 7. 8. 9. 10. 11.

- requests + 正则表达式 获取 ‘猫眼电影top100’。

使用 进程池Pool 提高爬取数据的速度. 1 # !/usr/bin/python 2 # -*- coding:utf-8 -*- 3 import requests 4 from request ...

- asp.net core使用identity+jwt保护你的webapi(一)——identity基础配置

前言 用户模块几乎是每个系统必备的基础功能,如果每次开发一个新项目时都要做个用户模块,确实非常无聊.好在asp.net core给我们提供了Identity,使用起来也是比较方便,如果对用户这块需求不 ...

- Cookie实现是否第一次登陆/显示上次登陆时间

Cookie实现是否第一次登陆/显示上次登陆时间 最近刚好看到Cookie这方面知识,对Servlet部分知识已经生疏,重新翻出已经遗弃角落的<JavaWeb开发实战经典>,重新温习了Co ...