ElasticSearch 中文分词插件ik 的使用

下载

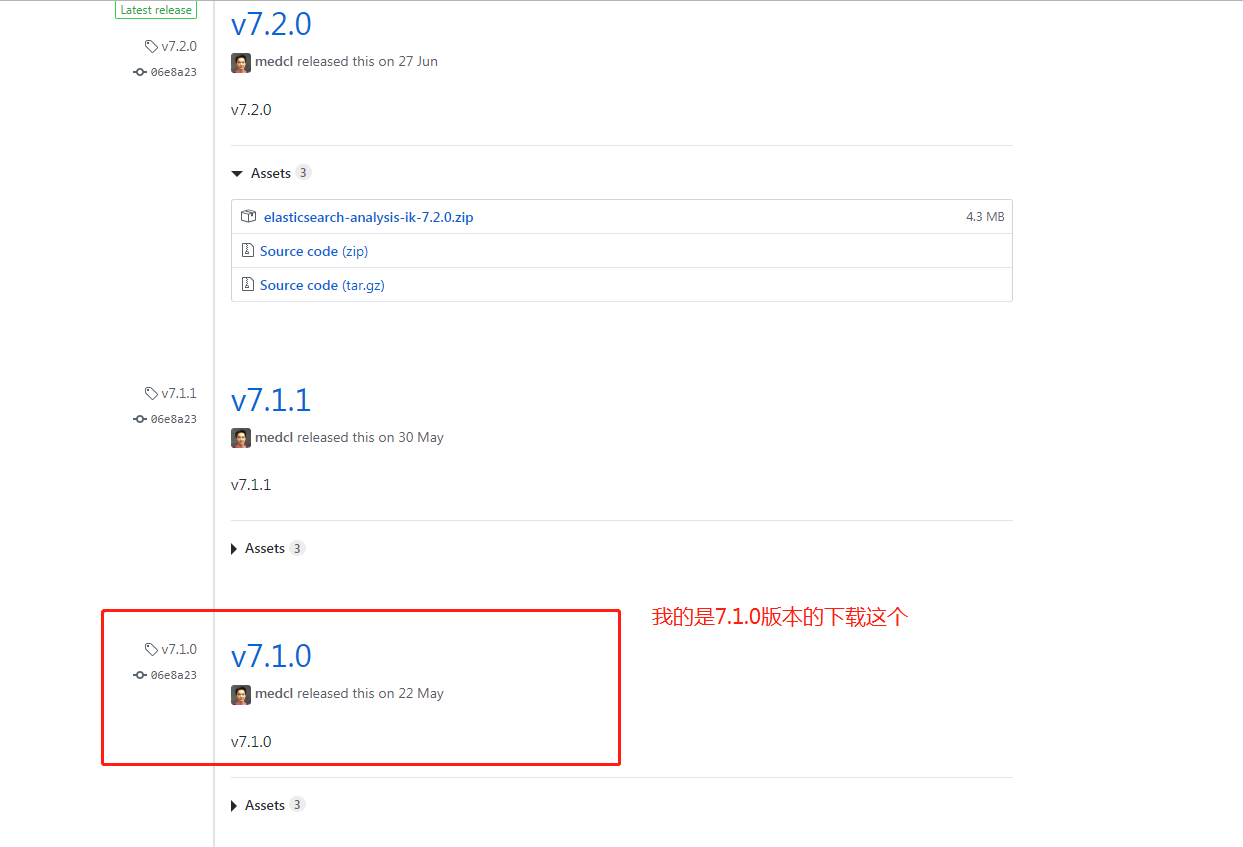

IK 的版本要与 Elasticsearch 的版本一致,因此下载 7.1.0 版本。

安装

1、中文分词插件下载地址:https://github.com/medcl/elasticsearch-analysis-ik

2、拼音分词插件下载地址:https://github.com/medcl/elasticsearch-analysis-pinyin

下载你对应的版本

将解压后的 IK 文件夹,放入 elasticsearch 文件夹下的 plugins/ik 目录下。

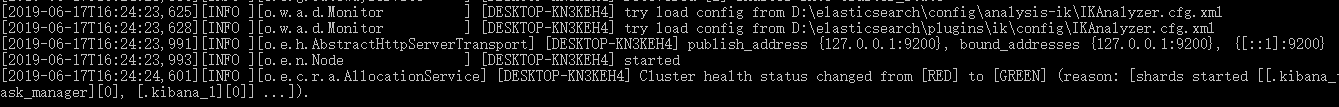

启动 Elasticsearch 后,看到下图,表示启动成功。

扩展本地词库

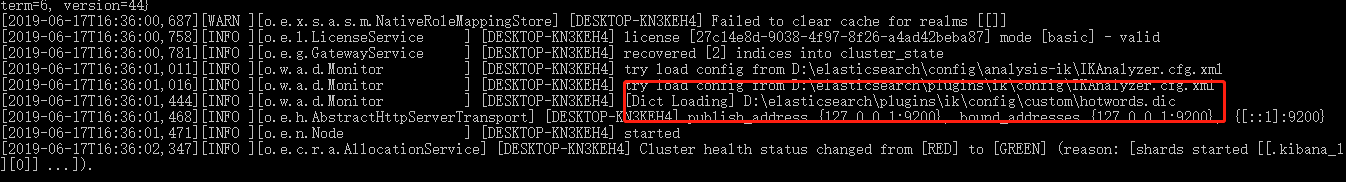

在 plugins\ik\config\custom 目录下新增文件 hotwords.dic。如添加 洪荒之力 。每一个词语一行。

在 plugins\ik\config 文件夹下的 IKAnalyzer.cfg.xml 文件配置本地词库。

<!--用户可以在这里配置自己的扩展字典,如果多个字典,则用分号分隔 custom/mydict.dic;custom/single_word_low_freq.dic-->

<entry key="ext_dict">custom/hotwords.dic</entry>

重新启动 Elasticsearch 显示如下图,表示启动成功。

文档的中文分词使用

IK分词器有两种分词模式:ik_max_word和ik_smart模式。

1、ik_max_word

会将文本做最细粒度的拆分,比如会将“中华人民共和国人民大会堂”拆分为“中华人民共和国、中华人民、中华、华人、人民共和国、人民、共和国、大会堂、大会、会堂等词语。

2、ik_smart

会做最粗粒度的拆分,比如会将“中华人民共和国人民大会堂”拆分为中华人民共和国、人民大会堂。

下面我们分别测试下。

先测试ik_max_word,输入命令如下:

POST http://localhost:9200/_analyze

{

"analyzer": "ik_max_word",

"text": "世界如此之大"

}

响应结果如下:

{

"tokens": [

{

"token": "世界",

"start_offset": ,

"end_offset": ,

"type": "CN_WORD",

"position":

},

{

"token": "如此之",

"start_offset": ,

"end_offset": ,

"type": "CN_WORD",

"position":

},

{

"token": "如此",

"start_offset": ,

"end_offset": ,

"type": "CN_WORD",

"position":

},

{

"token": "之大",

"start_offset": ,

"end_offset": ,

"type": "CN_WORD",

"position":

}

]

}

再测试ik_smart,输入命令如下:

POST http://localhost:9200/_analyze

{

"analyzer": "ik_smart",

"text": "世界如此之大"

}

响应结果如下:

{

"tokens": [

{

"token": "世界",

"start_offset": ,

"end_offset": ,

"type": "CN_WORD",

"position":

},

{

"token": "如此",

"start_offset": ,

"end_offset": ,

"type": "CN_WORD",

"position":

},

{

"token": "之大",

"start_offset": ,

"end_offset": ,

"type": "CN_WORD",

"position":

}

]

}

通过Docker 安装elasticsearch-analysis-ik-6.4.5插件

FROM docker.elastic.co/elasticsearch/elasticsearch:6.4.5

ADD elasticsearch-analysis-ik-6.4.5 /usr/share/elasticsearch/plugins/elasticsearch-analysis-ik-6.4.5

ElasticSearch 中文分词插件ik 的使用的更多相关文章

- ElasticSearch(三) ElasticSearch中文分词插件IK的安装

正因为Elasticsearch 内置的分词器对中文不友好,会把中文分成单个字来进行全文检索,所以我们需要借助中文分词插件来解决这个问题. 一.安装maven管理工具 Elasticsearch 要使 ...

- ElasticSearch(四) ElasticSearch中文分词插件IK的简单测试

先来一个简单的测试 # curl -XPOST "http://192.168.9.155:9200/_analyze?analyzer=standard&pretty" ...

- Elasticsearch安装中文分词插件ik

Elasticsearch默认提供的分词器,会把每一个汉字分开,而不是我们想要的依据关键词来分词.比如: curl -XPOST "http://localhost:9200/userinf ...

- Elasticsearch如何安装中文分词插件ik

elasticsearch-analysis-ik 是一款中文的分词插件,支持自定义词库. 安装步骤: 1.到github网站下载源代码,网站地址为:https://github.com/medcl/ ...

- ElasticSearch中文分词(IK)

ElasticSearch常用的很受欢迎的是IK,这里稍微介绍下安装过程及测试过程. 1.ElasticSearch官方分词 自带的中文分词器很弱,可以体检下: [zsz@VS-zsz ~]$ c ...

- ElasticSearch-5.0.0安装中文分词插件IK

Install IK 源码地址:https://github.com/medcl/elasticsearch-analysis-ik,git clone下来. 1.compile mvn packag ...

- ElasticSearch中文分词器-IK分词器的使用

IK分词器的使用 首先我们通过Postman发送GET请求查询分词效果 GET http://localhost:9200/_analyze { "text":"农业银行 ...

- Elasticsearch 中文分词器IK

1.安装说明 https://github.com/medcl/elasticsearch-analysis-ik 2.release版本 https://github.com/medcl/elast ...

- ElasticSearch搜索引擎安装配置中文分词器IK插件

近几篇ElasticSearch系列: 1.阿里云服务器Linux系统安装配置ElasticSearch搜索引擎 2.Linux系统中ElasticSearch搜索引擎安装配置Head插件 3.Ela ...

随机推荐

- j2ee开发之struts2框架学习笔记

Struts2框架技术重点笔记 1.Struts2 是在webwork基础上发展而来. 2.Struts2 不依赖struts API和 servlet API 3.Struts2提供了拦截器,表现层 ...

- Python爬虫:获取JS动态内容

经过一段时间的python学习,能写出一些爬虫了.但是,遇到js动态加载的网页就犯了难.于是乎谷歌.百度,发现个好介绍http://www.jianshu.com/p/4fe8bb1ea984 主要就 ...

- 02·nginx进阶·服务优化配置管理

企业场景常用的Nginx http功能模块汇总 ngx_ http_ core_ module 包括-些核心的http 参数配置,对应Nginx的配置为HTTP区块部分 ngx_ http _acce ...

- Java 学习笔记之 线程isInterrupted方法

线程isInterrupted方法: isInterrupted()是Thread对象的方法,测试线程是否已经中断. public class ThreadRunMain { public stati ...

- java中的Overload和Override

Overload为重载,它是指我们可以定义一些名称相同的方法,通过定义不同的输入参数来区分这些方法 然后再调用时,就会根据不同的参数样式,来选择合适的方法执行 在使用重载时只能通过不同的参数样式. 例 ...

- Web高性能动画及渲染原理(1)CSS动画和JS动画

目录 一. CSS动画 和 JS动画 1.1 CSS动画 1.2 JS动画 1.3 小结 二. 使用Velocity.js实现动画 示例代码托管在:http://www.github.com/dash ...

- 网络游戏开发-客户端2(自定义websocket协议格式)

Egret官方提供了一个Websocket的库,可以让我们方便的和服务器长连接交互. 标题写的时候自定义websocket的协议格式.解释一下,不是说我们去动websocket本身的东西,我们是在we ...

- 安装VMware Tools显示灰色正确解决办法

首先问题如下: 解决办法如下:1.关闭虚拟机: 2.在虚拟机设置分别设置CD/DVD.CD/DVD2和软盘为自动检测三个步骤: 3.再重启虚拟机,灰色字即点亮. 大功告成,如果解决了你的问题,点个赞鼓 ...

- PHP array_mulitsort

1.函数的作用:对多维数组进行排序 2.函数的例子: 例子一: <?php // http://php.net/manual/zh/function.array-multisort.php $m ...

- Python编程系列---使用字典实现路由静态路由

def index(): print('Index Page....') def bbs(): print('BBS Page....') def login(): print('Login Page ...