05tensorflow分布式会话

一. tensorflow分布式

1. 概念

分布式Tensorflow是由高性能的gRPC框架作为底层技术来支持的。这是一个通信框架gRPC(google remote procedure call),是一个高性能、跨平台的RPC框架。RPC协议,即远程过程调用协议,是指通过网络从远程计算机程序上请求服务。

2. 模式

1)单机单卡 一台服务器上多台设备(GPU)

2)多机多卡(分布式)

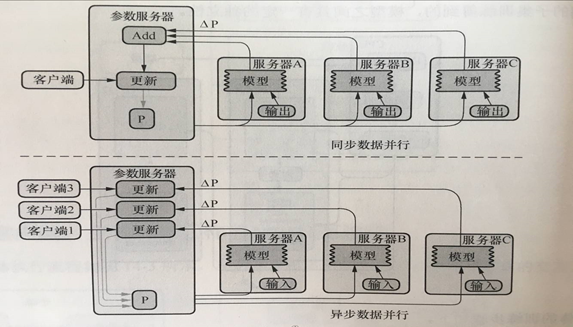

l 参数服务器(parameter server)ps:更新参数、保存参数

l 工作服务器(worker):主要功能是计算。worker节点中需要一个主节点来进行会话初始化,创建文件等操作,其他节点等待进行计算

二. API

1. 分布式会话

MonitoredTrainingSession(master=‘’,is_chief=True,checkpoint_dir=None,hooks=None,save_checkpoint_secs=600,save_summaries_steps=USE_DEFAULT,save_summaries_secs=USE_DEFAULT,config=None) 分布式会话函数

- master:指定运行会话协议IP和端口(用于分布式)

“grpc://192.168.0.1:2000”

- is_chief是否为主worker(用于分布式)

如果True,它将负责初始化和恢复基础的TensorFlow会话。如果False,

它将等待一位负责人初始化或恢复TensorFlow会话。

- checkpoint_dir:检查点文件目录,同时也是events目录

- config:会话运行的配置项, tf.ConfigProto(log_device_placement=True)

- hooks:可选SessionRunHook对象列表

生成的对象可调用的函数:

- should_stop():是否异常停止

- run():跟session一样可以运行op

2. Hook

tf.train.SessionRunHook

- Hook to extend calls to MonitoredSession.run()

- 1、begin():

- 在会话之前,做初始化工作

- 2、before_run(run_context)

在每次调用run()之前调用,以添加run()中的参数。

ARGS:

run_context:一个SessionRunContext对象,包含会话运行信息

return:一个SessionRunArgs对象,例如:tf.train.SessionRunArgs(loss)

- 3、after_run(run_context,run_values)

在每次调用run()后调用,一般用于运行之后的结果处理

该run_values参数包含所请求的操作/张量的结果 before_run()。

该run_context参数是相同的一个发送到before_run呼叫。

ARGS:

run_context:一个SessionRunContext对象

run_values一个SessionRunValues对象, run_values.results

注:在使用钩子的时候需要定义一个全局步数

global_step =

tf.contrib.framework.get_or_create_global_step()

3.

创建集群

cluster =

tf.train.ClusterSpec({"ps": ps_spec, "worker":

worker_spec})

cluster = tf.train.ClusterSpec({

“worker”:[“worker0.example.com:2222”,

/job:worker/task:0

“worker1.example.com:2222”, /job:worker/task:1

“worker2.example.com:2222”],

/job:worker/task:2

"ps":

[“ps0.example.com:2222”, /job:ps/task:0

“ps1.example.com:2222”] /job:ps/task:1

})

4.

创建服务

tf.train.Server(server_or_cluster_def,

job_name=None, task_index=None, protocol=None, config=None, start=True) 创建服务(ps,worker)

l server_or_cluster_def: 集群描述

l job_name: 任务类型名称

l task_index: 任务数

attribute:target

返回tf.Session连接到此服务器的目标

method:join()

参数服务器端,直到服务器等待接受参数任务关闭

5.

工作节点指定设备运行

tf.device(device_name_or_function)

- 选择指定设备或者设备函数

- if device_name:

- 指定设备

- 例如:"/job:worker/task:0/cpu:0”

- if function:

- tf.train.replica_device_setter(worker_device=worker_device,cluster=cluster)

- 作用:通过此函数协调不同设备上的初始化操作

- worker_device:为指定设备,

“/job:worker/task:0/cpu:0” or"/job:worker/task:0/gpu:0"

- cluster:集群描述对象

注:使用with tf.device(),使不同工作节点工作在不同的设备上

三. 案例

1 import tensorflow as tf

2

3 FLAGS = tf.app.flags.FLAGS

4

5 tf.app.flags.DEFINE_string("job_name", " ", "启动服务的类型ps or worker")

6 tf.app.flags.DEFINE_integer("task_index", 0, "指定ps或者worker当中的那一台服务器以task:0 ,task:1")

7

8 def main(argv):

9

10 # 定义全集计数的op ,给钩子列表当中的训练步数使用

11 global_step = tf.contrib.framework.get_or_create_global_step()

12

13 # 指定集群描述对象, ps , worker

14 cluster = tf.train.ClusterSpec({"ps": ["10.211.55.3:2223"], "worker": ["192.168.65.44:2222"]})

15

16 # 创建不同的服务, ps, worker

17 server = tf.train.Server(cluster, job_name=FLAGS.job_name, task_index=FLAGS.task_index)

18

19 # 根据不同服务做不同的事情 ps:去更新保存参数 worker:指定设备去运行模型计算

20 if FLAGS.job_name == "ps":

21 # 参数服务器什么都不用干,是需要等待worker传递参数

22 server.join()

23 else:

24 worker_device = "/job:worker/task:0/cpu:0/"

25

26 # 可以指定设备取运行

27 with tf.device(tf.train.replica_device_setter(

28 worker_device=worker_device,

29 cluster=cluster

30 )):

31 # 简单做一个矩阵乘法运算

32 x = tf.Variable([[1, 2, 3, 4]])

33 w = tf.Variable([[2], [2], [2], [2]])

34

35 mat = tf.matmul(x, w)

36

37 # 创建分布式会话

38 with tf.train.MonitoredTrainingSession(

39 master= "grpc://192.168.65.44:2222", # 指定主worker

40 is_chief= (FLAGS.task_index == 0),# 判断是否是主worker

41 config=tf.ConfigProto(log_device_placement=True),# 打印设备信息

42 hooks=[tf.train.StopAtStepHook(last_step=200)]

43 ) as mon_sess:

44 while not mon_sess.should_stop():

45 print(mon_sess.run(mat))

46

47

48 if __name__ == "__main__":

49 tf.app.run()

05tensorflow分布式会话的更多相关文章

- 补习系列(15)-springboot 分布式会话原理

目录 一.背景 二.SpringBoot 分布式会话 三.样例程序 四.原理进阶 A. 序列化 B. 会话代理 C. 数据老化 小结 一.背景 在 补习系列(3)-springboot 几种scope ...

- 004-restful应用构建、分布式会话、测试工具简介

一.概述 什么是rest(表述性状态转移,Representational State Transfer)是一种架构风格.他定义了创建可扩展Web服务的最佳实践. 1.Richardson成熟度模型 ...

- 第二十三章 多项目集中权限管理及分布式会话——《跟我学Shiro》

二十三章 多项目集中权限管理及分布式会话——<跟我学Shiro> 博客分类: 跟我学Shiro 跟我学Shiro 目录贴:跟我学Shiro目录贴 在做一些企业内部项目时或一些互联网后台时 ...

- 使用Redis实现分布式会话

1. 概述 传统的单体应用中,用户是否登录,通常是通过从Tomcat容器的session中获取登录用户信息判断的. 但在分布式的应用中,通常负载均衡了多台Tomcat,每台Tomcat都有自己独立的s ...

- 使用Spring Session做分布式会话管理

在Web项目开发中,会话管理是一个很重要的部分,用于存储与用户相关的数据.通常是由符合session规范的容器来负责存储管理,也就是一旦容器关闭,重启会导致会话失效.因此打造一个高可用性的系统,必须将 ...

- 使用SpringSession管理分布式会话时遇到的反序列化问题

关于SpringSession相关的介绍和使用指南,可移步如下网址: [SpringSession管理分布式系统的会话Session] https://www.cnblogs.com/captaina ...

- [源码解析] TensorFlow 分布式环境(1) --- 总体架构

[源码解析] TensorFlow 分布式环境(1) --- 总体架构 目录 [源码解析] TensorFlow 分布式环境(1) --- 总体架构 1. 总体架构 1.1 集群角度 1.1.1 概念 ...

- [源码解析] TensorFlow 分布式环境(2)---Master 静态逻辑

[源码解析] TensorFlow 分布式环境(2)---Master 静态逻辑 目录 [源码解析] TensorFlow 分布式环境(2)---Master 静态逻辑 1. 总述 2. 接口 2.1 ...

- [源码解析] TensorFlow 分布式环境(3)--- Worker 静态逻辑

[源码解析] TensorFlow 分布式环境(3)--- Worker 静态逻辑 目录 [源码解析] TensorFlow 分布式环境(3)--- Worker 静态逻辑 1. 继承关系 1.1 角 ...

随机推荐

- Java语言中的访问权限修饰符

一个Java应用有很多类,但是有些类,并不希望被其他类使用.每个类中都有数据成员和方法成员,但是并不是每个数据和方法,都允许在其他类中调用.如何能做到访问控制呢?就需要使用访问权限修饰符. Java语 ...

- rm, git rm, git rm --cached 区别与关系

HEAD, staging area, working copy在上篇<Git命令之回退篇 git revert git reset>已经讲过,不明白请自行传送过去. 1. rm 是仅仅删 ...

- 2022寒假集训day5

day5 五道栈的题加上字符串. 单调队列. T1 表达式括号匹配 洛谷P1739 题目描述 假设一个表达式有英文字母(小写).运算符(+,-,*,/)和左右小(圆)括号构成,以"@&q ...

- 阅读mybatis的源码的思路

■ 阅读源码mybatis操作数据库的过程: /* 测试查询 */ @Test public void testGet() throws IOException { // 1.从classpath路径 ...

- Solution -「SHOI2016」「洛谷 P4336」黑暗前的幻想乡

\(\mathcal{Description}\) link. 有一个 \(n\) 个结点的无向图,给定 \(n-1\) 组边集,求从每组边集选出恰一条边最终构成树的方案树.对 \(10^9+ ...

- Redis小秘密

Redis小秘密 临渊羡鱼,不如退而织网. 一.Redis基本数据类型 想必很多人都能脱口而出String.List.Hash.Sorted Set和Set五种基本数据类型. 以及五大基本数据类型简要 ...

- JMM之Java线程间通讯——等待通知机制及其经典范式

在并发编程中,实际处理涉及两个关键问题:线程之间如何通信及线程之间如何同步(这里的线程是指并发执行的活动实体). 通信是指线程之间以何种机制来交换信息.在共享内存的并发模型里,线程之间共享程序的公共状 ...

- 力扣算法经典第一题——两数之和(Java两种方式实现)

一.题目 难度:简单 给定一个整数数组 nums 和一个整数目标值 target,请你在该数组中找出 和为目标值 target 的那 两个 整数, 并返回它们的数组下标. 你可以假设每种输入只会对应一 ...

- Xshell在Windows和Linux间文件的上传和下载

本文通过lrzsz来实现Windows和Linux间文件间的文件传输. lrzsz使用 XMODEM.YMODEM 和 ZMODEM 文件传输协议来实现文件的上传和下载.相比 FTP 或者 WinSC ...

- [自动化]ssh自动化免密访问配置

ssh简介 SSH(Secure Shell)是一种通信加密协议,加密算法包括:RSA.DSA等 RSA:非对称加密算法,其安全性基于极其困难的大整数的分解(两个素数的乘积): DSA:也是非对称加密 ...