Gluon sgd

from mxnet import nd,autograd,init,gluon

from mxnet.gluon import data as gdata,loss as gloss,nn num_inputs = 2

num_examples = 1000

true_w = [2,-3.4]

true_b = 4.2 features = nd.random.normal(scale=1,shape=(num_examples,num_inputs))

labels = true_w[0]*features[:,0] + true_w[1]*features[:,1] + true_b

labels += nd.random.normal(scale=0.01,shape=labels.shape) # 造小批量数据集

dataset = gdata.ArrayDataset(features,labels)

batch_size = 10

data_iter = gdata.DataLoader(dataset,batch_size,shuffle=True) # 定义网络

net = nn.Sequential()

net.add(nn.Dense(1)) net.initialize(init.Normal(sigma=0)) # 损失函数

loss = gloss.L2Loss() # 优化算法

trainer = gluon.Trainer(net.collect_params(),'sgd',{'learning_rate':0.01}) num_epochs = 3

for epoch in range(1, num_epochs + 1):

for X, y in data_iter:

print(X)

print(y)

with autograd.record():

l = loss(net(X), y)

print(l)

l.backward()

trainer.step(batch_size)

l = loss(net(features), labels)

print('epoch %d, loss: %f' % (epoch, l.mean().asnumpy()))

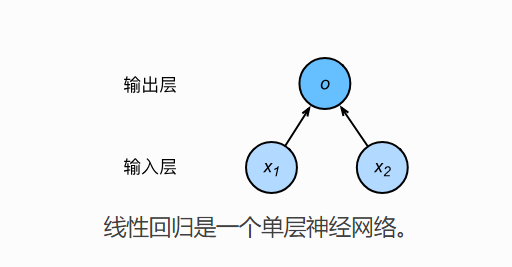

从最简单的线性回归来说,小批量随机梯度下降的时候,X,y 从迭代器中取出,也是bach_size大小的数据集,那么网络的计算,同样也是小批量的。

即代码 l = loss(net(X),y) 包含了,小批量数据集,每一个数据丢到网络中,计算出返回值以后,和真实值得损失。

Gluon sgd的更多相关文章

- 使用MxNet新接口Gluon提供的预训练模型进行微调

1. 导入各种包 from mxnet import gluon import mxnet as mx from mxnet.gluon import nn from mxnet import nda ...

- MXNet的新接口Gluon

为什么要开发Gluon的接口 在MXNet中我们可以通过Sybmol模块来定义神经网络,并组通过Module模块提供的一些上层API来简化整个训练过程.那MXNet为什么还要重新开发一套Python的 ...

- win10 + gluon + GPU

1. 下载教程 可以用浏览器下载zip格式并解压,在解压目录文件资源管理器的地址栏输入cmd进入命令行模式. 也可以 git pull https://github.com/mli/gluon-tut ...

- 机器学习笔记(6):多类逻辑回归-使用gluon

上一篇演示了纯手动添加隐藏层,这次使用gluon让代码更精减,代码来自:https://zh.gluon.ai/chapter_supervised-learning/mlp-gluon.html f ...

- 机器学习笔记(2):线性回归-使用gluon

代码来自:https://zh.gluon.ai/chapter_supervised-learning/linear-regression-gluon.html from mxnet import ...

- MXNET:权重衰减-gluon实现

构建数据集 # -*- coding: utf-8 -*- from mxnet import init from mxnet import ndarray as nd from mxnet.gluo ...

- dropout——gluon

https://blog.csdn.net/lizzy05/article/details/80162060 from mxnet import nd def dropout(X, drop_prob ...

- mxnet(gluon) 实现DQN简单小例子

参考文献 莫凡系列课程视频 增强学习入门之Q-Learning 关于增强学习的基本知识可以参考第二个链接,讲的挺有意思的.DQN的东西可以看第一个链接相关视频.课程中实现了Tensorflow和pyt ...

- Gluon 实现 dropout 丢弃法

多层感知机中: hi 以 p 的概率被丢弃,以 1-p 的概率被拉伸,除以 1 - p import mxnet as mx import sys import os import time imp ...

随机推荐

- Golang教程:包

什么是包?为什么使用包? 到目前为止我们见到的 Go 程序都只有一个文件,文件中包含了一个main函数和几个其他函数.在实际中这种将所有代码都放在一个文件里的组织方式是不可行的.这样的组织方式使得代码 ...

- Java ConcurrentModificationException异常原因和解决方法(转)

摘自:http://www.cnblogs.com/dolphin0520/p/3933551.html#undefined 在前面一篇文章中提到,对Vector.ArrayList在迭代的时候如果同 ...

- Download link in response body does not work--待解决

I am having a problem similar to the ones described in #374 and #1196. I have a service which return ...

- [转]Using OData from ASP.NET

本文转自:http://www.drdobbs.com/windows/using-odata-from-aspnet/240168672 By Gastón Hillar, July 01, 201 ...

- XAMl使用其他命名空间中的类型及加载和编译

以前我们讲过XAMl命名空间.为了使便宜钱知道XAMl文档中元素对应的.NET类型,需要知道XAMl明档中指定特定的两个命名空间.XAML是一种实例化.NET对象的通用方法 ,除了可以实例化一些标准的 ...

- ASP.NET MVC4 新手入门教程之一 ---1.介绍ASP.NET MVC4

你会建造 您将实现一个简单的电影清单应用程序支持创建. 编辑. 搜索和清单数据库中的电影.下面是您将构建的应用程序的两个屏幕截图.它包括显示来自数据库的电影列表的网页: 应用程序还允许您添加. 编辑和 ...

- vscode设置中文,设置中文不成功问题

刚安装好的vscode界面显示英文,如何设置中文呢? 在locale.json界面设置”locale":"zh-cn"也未能实现界面为中文,在网上找了参考了,以下教程真实 ...

- Thrift笔记(七)--回调源码分析

网上找了写代码,东拼西凑写了个demo.开始server用的是阻塞io,不行,换成非阻塞的io就可以.这里可能需要注意下 thrift文件 namespace java com.gxf.thrift ...

- Eclipse自定义启动画面和状态栏图标以及各种小图标的含义

一. 启动画面自定义 第一种情况:纯Eclipse 找到Eclipse安装路径下\eclipse\plugins\org.eclipse.platform_3.7.2.v201202080800,具体 ...

- vim lua对齐indent无效

查了半天,打开命令 :filetype一看是关闭的 filetype detection:ON plugin:ON indent:OFF 在vimrc里打开 filetype indent on ...