Machine Learning 算法可视化实现1 - 线性回归

一、原理和概念

1.回归

回归最简单的定义是,给出一个点集D,用一个函数去拟合这个点集。而且使得点集与拟合函数间的误差最小,假设这个函数曲线是一条直线,那就被称为线性回归;假设曲线是一条二次曲线,就被称为二次回归。

以下仅介绍线性回归的基本实现。

2.假设函数、误差、代价函数

参考 Machine Learning 学习笔记2 - linear regression with one variable(单变量线性回归)

最小化误差一般有两个方法:最小二乘法和梯度下降法

最小二乘法可以一步到位,直接算出未知参数,但他是有前提的。梯度下降法和最小二乘法不一样,它通过一步一步的迭代,慢慢的去靠近到那条最优直线。

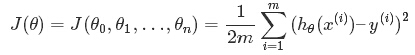

平方误差:

代价函数:

(系数是为了之后求梯度的时候方便)

(系数是为了之后求梯度的时候方便)

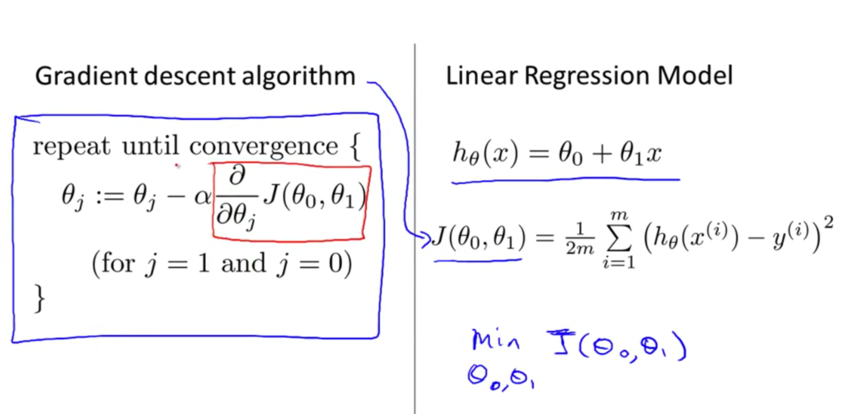

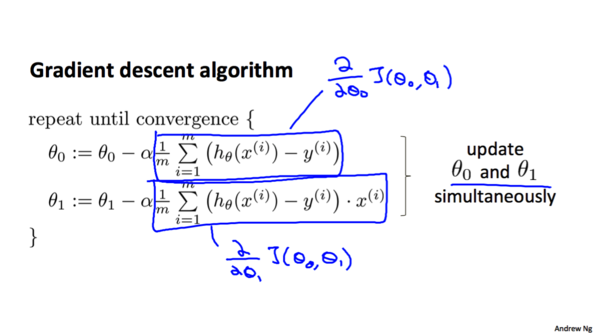

3.梯度下降算法

梯度下降算法是一种优化算法,它可以帮助我们找到一个函数的局部极小值,不仅用在线性回归模型中,非线性也可以。在求解损失函数的最小值时,可以通过梯度下降法来一步步的迭代求解,得到最小化的损失函数和模型参数值。反过来,如果我们需要求解损失函数的最大值,这时就需要用梯度上升法来迭代了。

下图是假设函数 h(x)、 代价函数J()和梯度下降算法:

完整的梯度下降算法:

梯度下降算法的Python实现:

# -*- coding: utf-8 -*-

# @Time : 2018/3/6 18:32

# @Author : TanRong

# @Software: PyCharm

# @File : gradient descent.py import numpy as np

import matplotlib.pyplot

import pylab # 参数含义:y=kx+b;learning_rate学习速率、步长幅度;num_iter迭代的次数 #计算梯度并更新k,b

def gradient(current_k, current_b, data, learning_rate):

k_gradient = 0

b_gradient = 0

m = float(len(data))

for i in range(0, len(data)):

x = data[i,0]

y = data[i,1]

k_gradient += (1/m)*(current_k*x + current_b - y) * x

b_gradient += (1/m)*(current_k*x + current_b - y)

update_k = current_k - learning_rate * k_gradient

update_b = current_b - learning_rate * b_gradient

return[update_k, update_b] #优化器

def optimizer(data, initial_k, initial_b, learning_rate, num_iter):

k = initial_k

b = initial_b #Gradient descent 梯度下降

for i in range(num_iter):

#更新 k、b

k,b = gradient(k, b, data, learning_rate)

return [k,b] #绘图

def plot_data(data, k, b):

x = data[:,0]

y = data[:,1]

y_predict = k * x + b

pylab.plot(x,y,'o')

pylab.plot(x,y_predict,'k-')

pylab.show() #计算平方差

def error(data, k, b):

totalError = 0;

for i in range(0, len(data)):

x = data[i,0]

y = data[i,1]

totalError += (k*x+b-y)**2

return totalError / float(len(data))

#梯度下降算法 实现线性回归

def Linear_regression():

data = np.loadtxt('train_data.csv', delimiter = ',') #训练数据

learning_rate = 0.01

initial_k = 0.0

initial_b = 0.0

num_iter = 1000 [k,b] = optimizer(data, initial_k, initial_b, learning_rate, num_iter)

print("k:", k,";b:", b)

print("平方差/代价函数:", error(data, k, b)) plot_data(data, k, b) Linear_regression()

代码和数据的下载:https://github.com/~~~

(数据用的别人的)

参考代码:

#http://blog.csdn.net/sxf1061926959/article/details/66976356?locationNum=9&fps=1 import numpy as np

import pylab def compute_error(b,m,data): totalError = 0

#Two ways to implement this

#first way

# for i in range(0,len(data)):

# x = data[i,0]

# y = data[i,1]

#

# totalError += (y-(m*x+b))**2 #second way

x = data[:,0]

y = data[:,1]

totalError = (y-m*x-b)**2

totalError = np.sum(totalError,axis=0) return totalError/float(len(data)) def optimizer(data,starting_b,starting_m,learning_rate,num_iter):

b = starting_b

m = starting_m #gradient descent

for i in range(num_iter):

#update b and m with the new more accurate b and m by performing

# thie gradient step

b,m =compute_gradient(b,m,data,learning_rate)

if i%100==0:

print 'iter {0}:error={1}'.format(i,compute_error(b,m,data))

return [b,m] def compute_gradient(b_current,m_current,data ,learning_rate): b_gradient = 0

m_gradient = 0 N = float(len(data))

#Two ways to implement this

#first way

# for i in range(0,len(data)):

# x = data[i,0]

# y = data[i,1]

#

# #computing partial derivations of our error function

# #b_gradient = -(2/N)*sum((y-(m*x+b))^2)

# #m_gradient = -(2/N)*sum(x*(y-(m*x+b))^2)

# b_gradient += -(2/N)*(y-((m_current*x)+b_current))

# m_gradient += -(2/N) * x * (y-((m_current*x)+b_current)) #Vectorization implementation

x = data[:,0]

y = data[:,1]

b_gradient = -(2/N)*(y-m_current*x-b_current)

b_gradient = np.sum(b_gradient,axis=0)

m_gradient = -(2/N)*x*(y-m_current*x-b_current)

m_gradient = np.sum(m_gradient,axis=0)

#update our b and m values using out partial derivations new_b = b_current - (learning_rate * b_gradient)

new_m = m_current - (learning_rate * m_gradient)

return [new_b,new_m] def plot_data(data,b,m): #plottting

x = data[:,0]

y = data[:,1]

y_predict = m*x+b

pylab.plot(x,y,'o')

pylab.plot(x,y_predict,'k-')

pylab.show() def Linear_regression():

# get train data

data =np.loadtxt('data.csv',delimiter=',') #define hyperparamters

#learning_rate is used for update gradient

#defint the number that will iteration

# define y =mx+b

learning_rate = 0.001

initial_b =0.0

initial_m = 0.0

num_iter = 1000 #train model

#print b m error

print 'initial variables:\n initial_b = {0}\n intial_m = {1}\n error of begin = {2} \n'\

.format(initial_b,initial_m,compute_error(initial_b,initial_m,data)) #optimizing b and m

[b ,m] = optimizer(data,initial_b,initial_m,learning_rate,num_iter) #print final b m error

print 'final formula parmaters:\n b = {1}\n m={2}\n error of end = {3} \n'.format(num_iter,b,m,compute_error(b,m,data)) #plot result

plot_data(data,b,m) if __name__ =='__main__': Linear_regression()

有一些其他方法实现某个功能,可以再看一遍

参考链接:https://www.cnblogs.com/yangykaifa/p/7261316.html

http://blog.csdn.net/sxf1061926959/article/details/66976356?locationNum=9&fps=1

Machine Learning 算法可视化实现1 - 线性回归的更多相关文章

- Machine Learning 算法可视化实现2 - Apriori算法实现

目录 关联分析 Apriori原理 Apriori算法实现 - 频繁项集 Apriori算法实现 - 从频繁项集挖掘关联规则 一.关联分析 关联分析是一种在大规模数据集中寻找有趣关系的任务. 这些关系 ...

- 机器学习---用python实现最小二乘线性回归算法并用随机梯度下降法求解 (Machine Learning Least Squares Linear Regression Application SGD)

在<机器学习---线性回归(Machine Learning Linear Regression)>一文中,我们主要介绍了最小二乘线性回归算法以及简单地介绍了梯度下降法.现在,让我们来实践 ...

- 《Machine Learning in Action》—— 浅谈线性回归的那些事

<Machine Learning in Action>-- 浅谈线性回归的那些事 手撕机器学习算法系列文章已经肝了不少,自我感觉质量都挺不错的.目前已经更新了支持向量机SVM.决策树.K ...

- Machine Learning读书会,面试&算法讲座,算法公开课,创业活动,算法班集锦

Machine Learning读书会,面试&算法讲座,算法公开课,创业活动,算法班集锦 近期活动: 2014年9月3日,第8次西安面试&算法讲座视频 + PPT 的下载地址:http ...

- 【Machine Learning】KNN算法虹膜图片识别

K-近邻算法虹膜图片识别实战 作者:白宁超 2017年1月3日18:26:33 摘要:随着机器学习和深度学习的热潮,各种图书层出不穷.然而多数是基础理论知识介绍,缺乏实现的深入理解.本系列文章是作者结 ...

- Coursera《machine learning》--(2)单变量线性回归(Linear Regression with One Variable)

本笔记为Coursera在线课程<Machine Learning>中的单变量线性回归章节的笔记. 2.1 模型表示 参考视频: 2 - 1 - Model Representation ...

- 【Machine Learning】单参数线性回归 Linear Regression with one variable

最近开始看斯坦福的公开课<Machine Learning>,对其中单参数的Linear Regression(未涉及Gradient Descent)做个总结吧. [设想] ...

- [Machine Learning] 浅谈LR算法的Cost Function

了解LR的同学们都知道,LR采用了最小化交叉熵或者最大化似然估计函数来作为Cost Function,那有个很有意思的问题来了,为什么我们不用更加简单熟悉的最小化平方误差函数(MSE)呢? 我个人理解 ...

- machine learning 之 多元线性回归

整理自Andrew Ng的machine learning课程 week2. 目录: 多元线性回归 Multivariates linear regression /MLR Gradient desc ...

随机推荐

- yum报错:Error: Multilib version problems found. This often means that the root

使用yum安装一些依赖库报错: yum -y install gcc gcc-c++ pcre pcre-devel zlib zlib-devel openssl openssl-devel 错误信 ...

- 21)django-csrf(跨站请求伪造)

一:目录 1)简介及无CSRF时存在隐患 2)csrf原理 3)csrf 设置 4)Form提交(CSRF) 5)Ajax提交(CSRF) CSRF请求头 X-CSRFToken 二:csrf简介 c ...

- python-re模块和subprocess模块

一.re模块 re中文为正则表达式,是字符串处理的常用工具,通常用来检索和替换符合某个模式的文本. 注:要搜索的模式和字符串都可以是unicode字符串(str)和8位字符串(bytes),但是不能将 ...

- 无锁编程 - Double-checked Locking

Double-checked Locking,严格意义上来讲不属于无锁范畴,无论什么时候当临界区中的代码仅仅需要加锁一次,同时当其获取锁的时候必须是线程安全的,此时就可以利用 Double-check ...

- swift 实践- 04 -- UIButton

import UIKit class ViewController: UIViewController { // 按钮的创建 // UIButtonType.system: 前面不带图标, 默认文字为 ...

- Struts2框架的概述及学习重点

什么是Struts2的框架 * Struts2是Struts1的下一代产品,是在 struts1和WebWork的技术基础上进行了合并的全新的Struts 2框架. * 其全新的Struts 2的体系 ...

- ios 输入框问题

去除ios输入框阴影 input,textarea{-webkit-appearance:none; outline: none; } ios有边框时设置boder-radius:0: 去除默认圆角问 ...

- django模板 内建标签

autoescape 控制当前自动转义的行为,有on和off两个选项 {% autoescape on %} {{ body }} {% endautoescape %} block 定义一个子模板可 ...

- 【python】json中字典key不可为数值型

遇到了一个很诡异的错误.写一个字典,存入json文件.之后读出判断是否存在key.结果惊奇的发现,同一个key居然存在两次. 原因:json会将数值key转换为unicode 结论:使用json时字典 ...

- Allegro PCB Design GXL (legacy) 将指定的层导出为DXF

Allegro PCB Design GXL (legacy) version 16.6-2015 1.菜单:Display > Color/Visibility... 2.打开Color Di ...