搭建ELK收集PHP的日志

架构:

filebeat --> redis -->logstash --> es --> kibana

- 每个客户端需要安装filebeat收集PHP日志

- filebeat把收集到的日志传到redis

- logstash从redis读取日志,读取一条日志就从redis里删除一条日志

- logstash把日志发送到es

- 最后kibana可视化查询日志

es数据安全建议

- es设置为三个节点为一个集群,集群中的一个节点会被选为主节点,它将临时管理集群级别的一些变更,例如新建和删除索引,增加或移除节点.主节点不参与文档级别的变更或搜索,这意味着流量增长的时候,该节点不会成为集群的瓶颈.

作为用户,我们能与集群中的任何一个节点通信,包括主节点.每一个节点都知道文档存在哪个节点上(因为做了分片,所以一个文档是分散到集群中所有节点上的),他们可以转发请求到相应的节点上.我们访问的节点负责收集各节点返回的数据,最后一起返回给客户端

- es配置文件里设置分片数量和副本数量,分片数量就是把一个文档拆分开来存到集群的机器上,副本就是把数据备份一份

- es配置文件开始恢复备份设置为2,意思是只要有两个节点启动就开始恢复数据,

ELK stack搭建

环境说明

172.16.1.225 es,logstash,redis,kibana(服务器端)

172.16.1.224 filebeat(每个客户端必装收集php)

安装filebeat

172.16.1.224# rpm -ivh filebeat-5.2.-x86_64.rpm

配置filebeat收集日志

filebeat.prospectors: - input_type: log

paths:

- /alidata1/www/timecash22/api3/application/logs/api3//*/*.php

document_type: api3_json

multiline.pattern: '^[0-9]{4}-[0-9]{2}-[0-9]{2}'

multiline.negate: true

multiline.match: after - input_type: log

paths:

- /alidata1/www/timecash22/api3/application/logs/2017/*/*.php

document_type: api3_error_log

multiline.pattern: '^[0-9]{4}-[0-9]{2}-[0-9]{2}'

multiline.negate: true

multiline.match: after - input_type: log

paths:

- /alidata1/www/timecash22/wx/application/logs//*/*.php

document_type: wx_error_log #这是的key是什么,到redis里就是什么

multiline.pattern: '^[0-9]{4}-[0-9]{2}-[0-9]{2}'

multiline.negate: true

multiline.match: after output.redis:

hosts: ["10.45.40.112"]

password: "timecash2016"

#key: "api3_json"

keys:

- key: "%{[type]}"

安装elasticsearch

172.16.1.225# rpm -ivh elasticsearch-2.4.3.rpm

配置elasticsearch

cluster.name: ELK

node.name: node-1

path.data: /data/elasticsearch

path.logs: /var/log/elasticsearch

network.host: 0.0.0.0

安装logstash

172.16.1.225# tar -zxvf logstash-2.4.0.tar.gz

172.16.1.225# cd logstash-2.4.0

172.16.1.225# mkdir conf #创建配置文件存放目录

配置logstash从redis读取数据,然后输出到es

input {

redis {

host => "redis的iP"

password => "redis的密码"

port => 6379

key => "api3_json"

type => "api3_json"

data_type => "list"

}

}

filter {

date {

match => [ "timestamp" , "YYYY-MM-dd HH:mm:ss" ] #时间,从kibana上显示每条日志的时间

}

}

output {

elasticsearch {

hosts => "elasticsearch的IP"

#protocol =>"http"

index=>"api3_json_%{+YYYY.MM.dd}" #存到es里索引的名称

document_type=>"api3_json"

}

stdout{

codec => rubydebug

}

}

安装kibana

172.16.1.225# tar -zxvf kibana-4.6.0-linux-x86_64.tar.gz

配置kibana

172.16.1.225# grep -Ev "^$|#" kibana-4.6.0-linux-x86_64/config/kibana.yml

server.host: "0.0.0.0"

elasticsearch.url: "http://localhost:9200"#elasticsearch的地址

启动kibana

172.16.1.225# ./bin/kibana -c config/kibana.yml

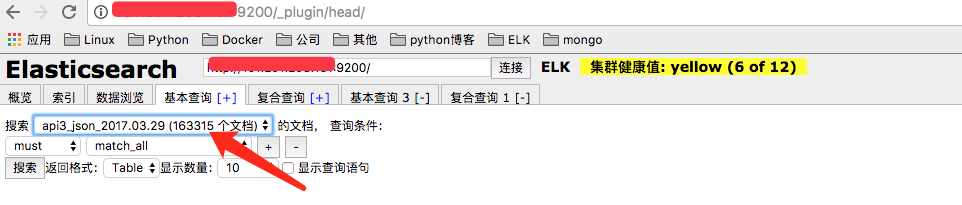

测试es是否有数据

打开X.X.X.X:9200/_plugin/head

测试kibana是否能查看数据

打开x.x.x.x:5601

搭建ELK收集PHP的日志的更多相关文章

- centos7搭建ELK Cluster集群日志分析平台(一):Elasticsearch

应用场景: ELK实际上是三个工具的集合,ElasticSearch + Logstash + Kibana,这三个工具组合形成了一套实用.易用的监控架构, 很多公司利用它来搭建可视化的海量日志分析平 ...

- centos7搭建ELK Cluster集群日志分析平台

应用场景:ELK实际上是三个工具的集合,ElasticSearch + Logstash + Kibana,这三个工具组合形成了一套实用.易用的监控架构, 很多公司利用它来搭建可视化的海量日志分析平台 ...

- centos7搭建ELK Cluster集群日志分析平台(四):Fliebeat-简单测试

续之前安装好的ELK集群 各主机:es-1 ~ es-3 :192.168.1.21/22/23 logstash: 192.168.1.24 kibana: 192.168.1.25 测试机:cli ...

- centos7搭建ELK Cluster集群日志分析平台(三):Kibana

续 centos7搭建ELK Cluster集群日志分析平台(一) 续 centos7搭建ELK Cluster集群日志分析平台(二) 已经安装好elasticsearch 5.4集群和logst ...

- centos7搭建ELK Cluster集群日志分析平台(二):Logstash

续 centos7搭建ELK Cluster集群日志分析平台(一) 已经安装完Elasticsearch 5.4 集群. 安装Logstash步骤 . 安装Java 8 官方说明:需要安装Java ...

- 带你了解zabbix整合ELK收集系统异常日志触发告警~

今天来了解一下关于ELK的“L”-Logstash,没错,就是这个神奇小组件,我们都知道,它是ELK不可缺少的组件,完成了输入(input),过滤(fileter),output(输出)工作量,也是我 ...

- ELK收集Nginx自定义日志格式输出

1.ELK收集日志的有两种常用的方式: 1.1:不修改源日志格式,简单的说就是在logstash中转通过 grok方式进行过滤处理,将原始无规则的日志转换为规则日志(Logstash自定义日志格式) ...

- ELK收集Nginx|Tomcat日志

1.Nginx 日志收集,先安装Nginx cd /usr/local/logstash/config/etc/,创建如下配置文件,代码如下 Nginx.conf input { file { typ ...

- elk收集tomcat的日志

logstash收集tomcat的日志 不要修改下tomcat中server.xml的日志格式,否则tomcat无法启动,试过多次,不行,就用自带的日志让logstash去收集 首先给tomcat日志 ...

随机推荐

- Java快速读取大文件

Java快速读取大文件 最近公司服务器监控系统需要做一个东西来分析Java应用程序的日志. 第一步探索: 首先我想到的是使用RandomAccessFile,因为他可以很方便的去获取和设置文件指针,下 ...

- 迅为IMX6核心板开发平台智能交通解决方案

智能交通系统它是将先进的信息技术.数据通讯传输技术.电子传感技术.控制技术及计算机技术等有效地集成运用于整个地面交通管理系统而建立的一种在大范围内.全方位发挥作用的,实时.准确.高效的综合交通运输管理 ...

- 【Linux】 CentOS免密登录

#sudo ssh-keygen -t rsa #sudo ssh-copy-id ${ipAddress}

- cmanformat - 不是命令啦,是个演示文件

描述 DESCRIPTION cmanformat 是 man pages 格式的演示文件. 由于系统不同会有差异.在 XWindow 下会好些. __________________________ ...

- vue的[__ob__: Observer]

为什么会获取不到里面的值 因为:vue data 里面值都是有这个属性的.这是被vue接管的数据,observer是Vue核心中最重要的一个模块(个人认为),能够实现视图与数据的响应式更新,底层全凭o ...

- 19Web服务

Web服务 Web服务 Micosoft.Net平台架构中的分布式系统主要包括两部分:用ASP.Net技术构建服务器端动态网页,以及Web服务(Web Service或XML Web Service) ...

- 全国绿色计算大赛 模拟赛第一阶段(Python)

第1关求和 class Task: def getSum(self, num1, num2): sum = 0 for i in range(num1, num2 + 1): while (i != ...

- CSU 2018年12月月赛 F(2218): Finding prime numbers

Description xrdog has a number set. There are 95 numbers in this set. They all have something in com ...

- CSU——2161: 漫漫上学路 最短路

Description 众所周知,CSU(California State)University) 的上课地点距离学生公寓很远,对于爱睡懒觉的小Z来说,每天去上课就成了一件非常头疼的事,如果有早课的话 ...

- Broadcasting

目录 Broadcasting Key idea How to understand? Why broadcasting? Broadcastable? Broadcast VS Tile Broad ...