分别用Eclipse和IDEA搭建Scala+Spark开发环境

开发机器上安装jdk1.7.0_60和scala2.10.4,配置好相关环境变量。网上资料很多,安装过程忽略。此外,Eclipse使用Luna4.4.1,IDEA使用14.0.2版本。

1. Eclipse开发环境搭建

1.1. 安装scala插件

安装eclipse-scala-plugin插件,下载地址http://scala-ide.org/download/prev-stable.html

解压缩以后把plugins和features复制到eclipse目录,重启eclipse以后即可。

Window -> Open Perspective -> Other…,打开Scala,说明安装成功。

1.2. 创建maven工程

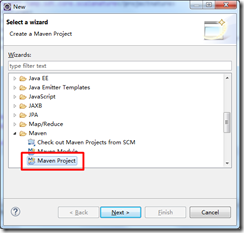

打开File -> New -> Other…,选择Maven Project:

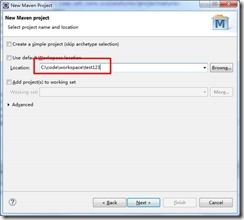

点击Next,输入项目存放路径:

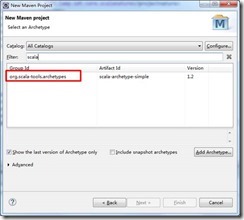

点击Next,选择org.scala-tools.archetypes:

点击Next,输入artifact相关信息:

点击Finish即可。默认创建好的工程目录结构如下:

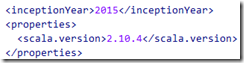

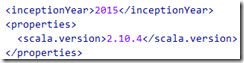

修改pom.xml文件:

至此,一个默认的scala工程新建完成。

2. Spark开发环境搭建

2.1. 安装scala插件

开发机器使用的IDEA版本为IntelliJ IEDA 14.0.2。为了使IDEA支持scala开发,需要安装scala插件,如图:

插件安装完成后,IntelliJ IDEA会要求重启。

2.2. 创建maven工程

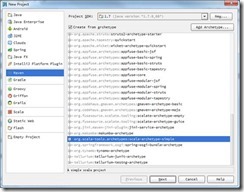

点击Create New Project,在Project SDK选择jdk安装目录(建议开发环境中的jdk版本与Spark集群上的jdk版本保持一致)。点击左侧的Maven,勾选Create from archetype,选择org.scala-tools.archetypes:scala-archetype-simple:

点击Next后,可根据需求自行填写GroupId,ArtifactId和Version(请保证之前已经安装maven)。点击Finish后,maven会自动生成pom.xml和下载依赖包。同1.2章节中eclipse下创建maven工程一样,需要修改pom.xml中scala版本。

至此,IDEA下的一个默认scala工程创建完毕。

3. WordCount示例程序

3.1. 修改pom文件

在pom文件中添加spark和hadoop相关依赖包:

<!-- Spark --> <dependency> <groupId>org.apache.spark</groupId> <artifactId>spark-core_2.10</artifactId> <version>1.1.0</version> </dependency> <!-- Spark Steaming--> <dependency> <groupId>org.apache.spark</groupId> <artifactId>spark-streaming_2.10</artifactId> <version>1.1.0</version> </dependency> <!-- HDFS --> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-client</artifactId> <version>2.6.0</version> </dependency>

在<build></build>中使用maven-assembly-plugin插件,目的是package时把依赖jar也打包。

<plugin> <artifactId>maven-assembly-plugin</artifactId> <version>2.5.5</version> <configuration> <appendAssemblyId>false</appendAssemblyId> <descriptorRefs> <descriptorRef>jar-with-dependencies</descriptorRef> </descriptorRefs> <archive> <manifest> <mainClass>com.ccb.WordCount</mainClass> </manifest> </archive> </configuration> <executions> <execution> <id>make-assembly</id> <phase>package</phase> <goals> <goal>assembly</goal> </goals> </execution> </executions> </plugin>

3.2. WordCount示例

WordCount用来统计输入文件中所有单词出现的次数,代码参考:

package com.ccb

import org.apache.spark.{ SparkConf, SparkContext }

import org.apache.spark.SparkContext._

/**

* 统计输入目录中所有单词出现的总次数

*/

object WordCount {

def main(args: Array[String]) {

val dirIn = "hdfs://192.168.62.129:9000/user/vm/count_in"

val dirOut = "hdfs://192.168.62.129:9000/user/vm/count_out"

val conf = new SparkConf()

val sc = new SparkContext(conf)

val line = sc.textFile(dirIn)

val cnt = line.flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _) // 文件按空格拆分,统计单词次数

val sortedCnt = cnt.map(x => (x._2, x._1)).sortByKey(ascending = false).map(x => (x._2, x._1)) // 按出现次数由高到低排序

sortedCnt.collect().foreach(println) // 控制台输出

sortedCnt.saveAsTextFile(dirOut) // 写入文本文件

sc.stop()

}

}

3.3. 提交spark执行

使用maven pacakge打包得到sparktest-1.0-SNAPSHOT.jar,并提交到spark集群运行。

执行命令参考:

|

./spark-submit --name WordCountDemo --class com.ccb.WordCount sparktest-1.0-SNAPSHOT.jar |

即可得到统计结果。

分别用Eclipse和IDEA搭建Scala+Spark开发环境的更多相关文章

- 【转】Eclipse和PyDev搭建完美Python开发环境(Ubuntu篇)

原文网址:http://www.cnblogs.com/Realh/archive/2010/10/10/1847251.html 前两天在Windows下成功地搭好了一个Python开发环境,这次转 ...

- Eclipse和PyDev搭建完美Python开发环境(Windows篇)(转)

摘要:本文讲解了用Eclipse和PyDev搭建Python的开发环境. 十一长假在家闲着没事儿,准备花点时间学习一下Python. 今儿花了一个下午搭建Python的开发环境,不禁感叹————开 ...

- 【Spark笔记】Windows10 本地搭建单机版Spark开发环境

0x00 环境及软件 1.系统环境 OS:Windows10_x64 专业版 2.所需软件或工具 JDK1.8.0_131 spark-2.3.0-bin-hadoop2.7.tgz hadoop-2 ...

- 搭建eclipse+maven+scala-ide的scala web开发环境

http://www.tuicool.com/articles/NBzAzy 江湖传闻,scala开发的最佳利器乃 JetBrains 的神作 IntelliJ IDEA ,外加构建工具sbt 是也. ...

- Windows下Eclipse+Scala+Spark开发环境搭建

1.安装JDK及配置java环境变量 本文使用版本为jdk1.7.0_79,过程略 2.安装scala 本文使用版本为2.11.8,过程略 3.安装spark 本文使用版本为spark-2.0.1-b ...

- Eclipse和PyDev搭建完美Python开发环境(Windows篇)

目录安装Pythonpython for eclipse插件安装配置PyDev插件测试 安装Python从网站上下载最新的版本,从http://python.org/download/下载.安装过程与 ...

- Eclipse和PyDev搭建完美Python开发环境 Windows篇

1,安装Python Python是一个跨平台语言,Python从3.0的版本的语法很多不兼容2版本,官网找到最新的版本并下载:http://www.python.org, 因为之前的一个项目是2版本 ...

- eclipse+cygwin+cdt搭建c/c++开发环境

Cygwin 是一个用于 Windows 的类 UNIX shell 环境. 它由两个组件组成:一个 UNIX API 库,它模拟 UNIX 操作系统提供的许多特性:以及 Bash shell 的改写 ...

- Intellij IDEA使用Maven搭建spark开发环境(scala)

如何一步一步地在Intellij IDEA使用Maven搭建spark开发环境,并基于scala编写简单的spark中wordcount实例. 1.准备工作 首先需要在你电脑上安装jdk和scala以 ...

随机推荐

- jQuery源码分析系列 : 整体架构

query这么多年了分析都写烂了,老早以前就拜读过, 不过这几年都是做移动端,一直御用zepto, 最近抽出点时间把jquery又给扫一遍 我也不会照本宣科的翻译源码,结合自己的实际经验一起拜读吧! ...

- [TJOI2007]小朋友

题面 Luogu Sol 弦图最大独立集 做法见上篇博客 # include <bits/stdc++.h> # define RG register # define IL inline ...

- Python-并发编程(进程)

接下来我们用几天的时间说一说python中并发编程的知识 一.背景知识 顾名思义,进程即正在执行的一个过程.进程是对正在运行程序的一个抽象. 进程的概念起源于操作系统,是操作系统最核心的概念,也是操作 ...

- webapi下载文件

[HttpGet] public IHttpActionResult ExportData() { ... var dt = ExcelHelper.ListToDataTable(list); va ...

- npm属性笔记

scripts属性,运行脚本命令的npm命令行缩写,常见如下npm run devnpm run startnpm run build dependencies属性,项目运行时配置模块依赖的模块列表, ...

- java断言 assert

关于assert的用法网上教程很多,这里就不说了,只演示一下运行时开启断言的方法. public class A{ public static void main(String[] args){ Cl ...

- angular2 文件上传

ng2-file-upload文件上传 1.安装ng2-file-upload模块 npm install ng2-file-upload --save 2.如果使用systemjs打包,需要在配置s ...

- ieHTTPHeaders使用方法

在http://www.blunck.se/iehttpheaders.html下载软件打开IE浏览器查看-->浏览器栏-->ieHTTPHeaders可以查看httpheader tra ...

- xtrabackup在线迁移mysql并搭建为主主同步

一.背景 工作中有需求数据库需要迁移,但是不能停服,不能锁库锁表影响业务的正常运行,所以使用XtraBackup 二.环境: 操作系统:CentOS Linux release 7.4.1708 (C ...

- February 21 2017 Week 8 Tuesday

To make each day count. 让每一天都物有所值. We always want to make our life meaningful, however, the acutal f ...