猫眼电影爬取(一):requests+正则,并将数据存储到mysql数据库

前面讲了如何通过pymysql操作数据库,这次写一个爬虫来提取信息,并将数据存储到mysql数据库

1.爬取目标

爬取猫眼电影TOP100榜单

要提取的信息包括:电影排名、电影名称、上映时间、分数

2.分析网页HTML源码

可以看到每部电影信息都被包裹在一对<dd>...</dd>标签中,所以我们只需提取出一个标签对中的上述信息即可。使用正则表达式提取

3. 完整过程

这个例子有2个关键点:正则编写和数据处理(写进mysql数据库)

(1) 正则表达式的编写

pattern = re.compile(r'<dd>.*?<i.*?>(\d+)</i>.*?' # 匹配电影排名(加个?表示非贪婪匹配,不是匹配0次或1次)

r'<p class="name"><a.*?data-val=".*?">(.*?)' # 匹配电影名称

r'</a>.*?<p.*?class="releasetime">(.*?)</p>' # 匹配上映时间

r'.*?<i.*?"integer">(.*?)</i>' # 匹配分数的整数位

r'.*?<i.*?"fraction">(.*?)</i>.*?</dd>', re.S) # 匹配分数小数位,re.S表示跨行匹配

m = pattern.findall(html)

# print(m)

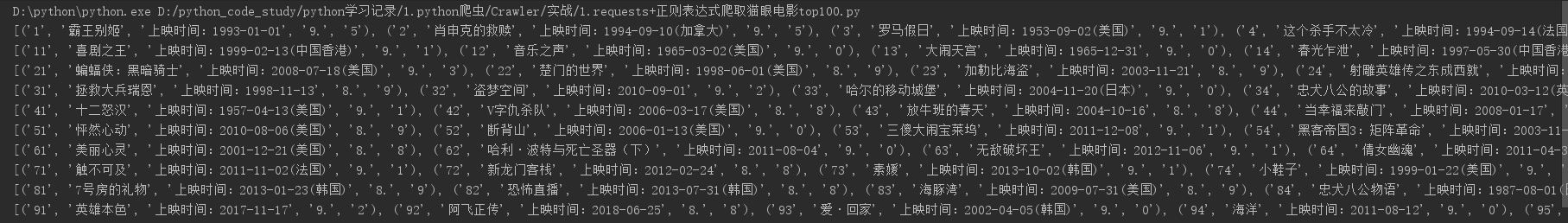

使用findall()方法来匹配所有符合规则的字符,返回一个列表,下面是其中一页的匹配结果

(2)完整代码,注意get_data()函数是如何处理数据,然后通过write_sql()函数是写入数据库的

# coding: utf-8

# author: hmk

import requests

import re

import pymysql

def get_html(url, header):

response = requests.get(url, headers=header)

if response.status_code == 200:

return response.text

else:

return None

def get_data(html, list_data):

pattern = re.compile(r'<dd>.*?<i.*?>(\d+)</i>.*?' # 匹配电影排名

r'<p class="name"><a.*?data-val=".*?">(.*?)' # 匹配电影名称

r'</a>.*?<p.*?class="releasetime">(.*?)</p>' # 匹配上映时间

r'.*?<i.*?"integer">(.*?)</i>' # 匹配分数的整数位

r'.*?<i.*?"fraction">(.*?)</i>.*?</dd>', re.S) # 匹配分数小数位

m = pattern.findall(html)

for i in m: # 因为匹配到的所有结果会以列表形式返回,每部电影信息以元组形式保存,所以可以迭代处理每组电影信息

ranking = i[0] # 提取一组电影信息中的排名

movie = i[1] # 提取一组电影信息中的名称

release_time = i[2] # 提取一组电影信息中的上映时间

score = i[3] + i[4] # 提取一组电影信息中的分数,这里把分数的整数部分和小数部分拼在一起

list_data.append([ranking, movie, release_time, score]) # 每提取一组电影信息就放到一个列表中,同时追加到一个大列表里,这样最后得到的大列表就包含所有电影信息

def write_sql(data):

conn = pymysql.connect(host='localhost',

user='root',

password='123456',

db='test',

charset='utf8')

cur = conn.cursor()

for i in data:

"""这里的data参数是指正则匹配并处理后的列表数据(是一个大列表,包含所有电影信息,每个电影信息都存在各自的一个列表中;

对大列表进行迭代,提取每组电影信息,这样提取到的每组电影信息都是一个小列表,然后就可以把每组电影信息写入数据库了)"""

movie = i # 每组电影信息,这里可以看做是准备插入数据库的每组电影数据

sql = "insert into maoyan_movie(ranking,movie,release_time,score) values(%s, %s, %s, %s)" # sql插入语句

try:

cur.execute(sql, movie) # 执行sql语句,movie即是指要插入数据库的数据

conn.commit() # 插入完成后,不要忘记提交操作

print('导入成功')

except:

print('导入失败')

cur.close() # 关闭游标

conn.close() # 关闭连接

def main():

start_url = 'http://maoyan.com/board/4'

depth = 10 # 爬取深度(翻页)

header = {"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8",

"Accept-Encoding": "gzip, deflate, sdch",

"Accept-Language": "zh-CN,zh;q=0.8",

"Cache-Control": "max-age=0",

"Connection": "keep-alive",

"Host": "maoyan.com",

"Referer": "http://maoyan.com/board",

"Upgrade-Insecure-Requests": "1",

"User-Agent": "Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.75 Safari/537.36"}

for i in range(depth):

url = start_url + '?offset=' + str(10 * i)

html = get_html(url, header)

list_data = []

get_data(html, list_data)

write_sql(list_data)

#print(list_data)

# for i in list_data:

# t = i

# print(t)

if __name__ == "__main__":

main()

注意一点,在请求url时,加了headers,这里必须加,估计是网站做了限制,直接爬的话会失败,可能认出请求链接的不是一个人而是一只虫了

代码中注释写得很详细,不再过多描述了

猫眼电影爬取(一):requests+正则,并将数据存储到mysql数据库的更多相关文章

- 爬取网贷之家平台数据保存到mysql数据库

# coding utf-8 import requests import json import datetime import pymysql user_agent = 'User-Agent: ...

- 猫眼电影爬取(二):requests+beautifulsoup,并将数据存储到mysql数据库

上一篇通过requests+正则爬取了猫眼电影榜单,这次通过requests+beautifulsoup再爬取一次(其实这个网站更适合使用beautifulsoup库爬取) 1.先分析网页源码 可以看 ...

- 猫眼电影爬取(三):requests+pyquery,并将数据存储到mysql数据库

还是以猫眼电影为例,这次用pyquery库进行爬取 1.简单demo,看看如何使用pyquery提取信息,并将提取到的数据进行组合 # coding: utf-8 # author: hmk impo ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

- 单线程多任务协程vip电影爬取

单线程多任务协程vip电影爬取 --仅供学习使用勿作商用如有违规后果自负!!! 这几天一直在使用python爬取电影,主要目的也是为了巩固前段时间强化学习的网络爬虫,也算是一个不错的检验吧,面对众 ...

- 04 Python网络爬虫 <<爬取get/post请求的页面数据>>之requests模块

一. urllib库 urllib是Python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在Python3中的为urllib.request和urllib ...

- python3 爬取汽车之家所有车型数据操作步骤(更新版)

题记: 互联网上关于使用python3去爬取汽车之家的汽车数据(主要是汽车基本参数,配置参数,颜色参数,内饰参数)的教程已经非常多了,但大体的方案分两种: 1.解析出汽车之家某个车型的网页,然后正则表 ...

- python3 爬取boss直聘职业分类数据(未完成)

import reimport urllib.request # 爬取boss直聘职业分类数据def subRule(fileName): result = re.findall(r'<p cl ...

- Scrapy实战篇(七)之爬取爱基金网站基金业绩数据

本篇我们以scrapy+selelum的方式来爬取爱基金网站(http://fund.10jqka.com.cn/datacenter/jz/)的基金业绩数据. 思路:我们以http://fund.1 ...

随机推荐

- 我仅使用到的dd if

备份一个分区 分区 镜像名 读写块大小 dd if=/dev/sdb of=/diskone.img bs=512 注:可以为了提升I/O把bs设为较高的数值例:bs=1024k 挂载一个分区 mou ...

- ODAC(V9.5.15) 学习笔记(四)TMemDataSet (1)

所有的数据集类组件都是从TMemDataSet继承下来的,该组件实现了内存中对数据的管理,其主要的属性.方法和事件如下. 1.数据更新 名称 类型 说明 CachedUpdates Boolean 数 ...

- Python3基础 list reverse 反转列表

Python : 3.7.0 OS : Ubuntu 18.04.1 LTS IDE : PyCharm 2018.2.4 Conda ...

- Android系统分区理解及分区目录细解【转】

本文转载自:https://blog.csdn.net/u010001503/article/details/51853822 Android 通常有以下分区: System分区: 就是我们刷ROM的 ...

- Download and Installation of Kibana

下载以及安装 https://www.elastic.co/downloads/kibana 1.Download and unzip Kibana 2. Open config/kibana.yml ...

- sublime使用技巧总结

软件右下角可以选择文档语法模式 Ctrl + Shift + P ------------------命令模式sshtml模糊匹配-----语法切换到html模式,同理所得,ss+相应文件名匹配相应模 ...

- 两个线程分别打印 1- 100,A 打印偶数, B打印奇数。

1. 直接用CAS中的AtomicInteger package concurency.chapter13; import java.util.concurrent.atomic.AtomicInte ...

- Asp.net 之 window 操作命令

命令:cmd 打开执行窗口 命令:inetmgr.打开iis管理器 命令:dcomcnfg 打开组件服务 命令:regedit 打开注册表

- C++变量的默认初始化规则

定义没有初始化式的变量时,系统有时候会帮我们初始化变量.系统如何初始化取决于变量的类型以及变量定义的位置. 内置类型变量是否自动初始化取决于变量定义的位置.函数体外定义的变量初始成0:函数体内定义的变 ...

- CSU 2005 Nearest Maintenance Point(最短路+bitset)

https://vjudge.net/problem/CSU-2005 题意:给出带权值的图,图上有一些特殊点,现在给出q个询问,对于每个询问,输出离该点最近的特殊点,如果有多个,则按升序输出. 思路 ...