Hadoop_FileInputFormat分片

Hadoop学习笔记总结

01. InputFormat和OutFormat

1. 整个MapReduce组件

InputFormat类和OutFormat类都是抽象类。

可以实现文件系统的读写,数据库的读写,服务器端的读写。

这样的设计,具有高内聚、低耦合的特点。

2. 提交任务时,获取split切片信息的流程

JobSubmitter初始化submitterJobDir资源提交路径,是提交到HDFS保存文件路径,一些Jar包和配置文件:

接下来,是JobSubmitter中将切片信息写入submitJobDir目录。

int maps = writeSplits(job, submitJobDir);writeSplits方法中,首先会通过反射拿到用户设置的InputFormat子类的实例(默认为TextInputFormat类),然后调用FileInputFormat的getSplit方法(父类公共方法)再获得切片的信息,封装到InputSplit中,返回List。

InputFormat<?, ?> input =

ReflectionUtils.newInstance(job.getInputFormatClass(), conf);

List<InputSplit> splits = input.getSplits(job);

最后将切片描述信息写到submitterJobDir资源提交路径中。

JobSplitWriter.createSplitFiles(jobSubmitDir, conf, jobSubmitDir.getFileSystem(conf), array);

InputSplit包含block块所在位置主机,路径,偏移量等信息。分片数据不包含数据本身,而是指向数据的引用。

input.getSplits()方法解析

由FileInputFormat类中getSplits方法决定。

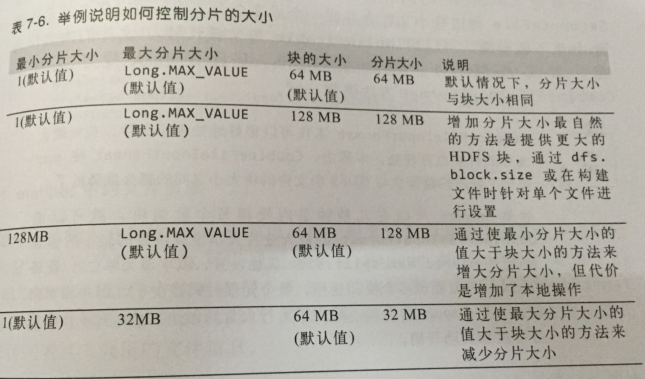

计算公式://computeSplitSize中

minSize=max{getFormatMinSplitSize(),mapred.min.split.size} (getFormatMinSplitSize()大小默认为1B)

maxSize=mapred.max.split.size(不在配置文件中指定时大小为Long.MAX_VALUE)

//blockSize是默认的配置大小:128MB //分片大小的计算公式

splitSize=max{minSize,min{maxSize,blockSize}}

默认情况下,minSize < blockSize < maxSize

所以,默认不在配置文件配置split最大值和最小值,分片大小就是blockSize,128MB。

公式的含义:取分片大小不大于block,并且不小于在mapred.min.split.size配置中定义的最小Size。

举例说明如何控制分片大小:

3. 为什么Hadoop不擅长小文件

逻辑上,FileInputFormat生成的分块是一个文件或者该文件的一部分,如果是很多小文件,就生成了很多的逻辑block。默认情况下,一个分片就是一个block,因而,会有很多个map任务,每次map操作都有很多额外的开销。

因此,运行大量小文件的任务,会增加运行作业的额外开销;浪费NameNode内存。

解决:CombineFileInputFormat

参考《Hadoop权威指南》

初接触,记下学习笔记,还有很多问题,望指导,谢谢。

Hadoop_FileInputFormat分片的更多相关文章

- elasticsearch高级配置一 ---- 分片分布规则设置

cluster.routing.allocation.allow_rebalance 设置根据集群中机器的状态来重新分配分片,可以设置为always, indices_primaries_active ...

- redis分片

本文是在window环境下测试 什么是分片 当数据量大的时候,把数据分散存入多个数据库中,减少单节点的连接压力,实现海量数据存储 那么当多个请求来取数据时,如何知道数据在哪个redis呢,redis有 ...

- CephRGW 在多个RGW负载均衡场景下,RGW 大文件并发分片上传功能验证

http://docs.ceph.com/docs/master/radosgw/s3/objectops/#initiate-multi-part-upload 根据分片上传的API描述,因为对同一 ...

- Ceph RGW服务 使用s3 java sdk 分片文件上传API 报‘SignatureDoesNotMatch’ 异常的定位及规避方案

import java.io.File; import com.amazonaws.AmazonClientException; import com.amazonaws.auth.profile ...

- IP分片详解

IP分片是网络上传输IP报文的一种技术手段.IP协议在传输数据包时,将数据报文分为若干分片进行传输,并在目标系统中进行重组.不同的链路类型规定有不同最大长度的链路层数据帧,称为链路层MTU(最大传输单 ...

- MongoDB的分片(9)

什么是分片 分片是指将数据库拆分,将其分散在不同的机器上的过程.将数据分散到不同的机器上,不需要功能强大的服务器就可以存储更多的数据和处理更大的负载.基本思想就是将集合切成小块,这些块分散到若干片里, ...

- 搭建高可用mongodb集群(四)—— 分片(经典)

转自:http://www.lanceyan.com/tech/arch/mongodb_shard1.html 按照上一节中<搭建高可用mongodb集群(三)-- 深入副本集>搭建后还 ...

- 用百度webuploader分片上传大文件

一般在做文件上传的时候,都是通过客户端把要上传的文件上传到服务器,此时上传的文件都在服务器内存,如果上传的是视频等大文件,那么服务器内存就很紧张,而且一般我们都是用flash或者html5做异步上传, ...

- mongodb分片配置

通过YUM库自动安装Mongodb 手动安装配置mongodb 验证mongodb主从复制过程 验证mongodb副本集并实现自动切换 实验mongodb使用gridfs存放一个大文件 1.创建数据目 ...

随机推荐

- Android开发总是难以入门

发现自己很难入门,是真的太难,还是自己主观拒绝.

- trie树---(插入、删除、查询字符串)

HDU 5687 Problem Description 度熊手上有一本神奇的字典,你可以在它里面做如下三个操作: 1.insert : 往神奇字典中插入一个单词 2.delete: 在神奇字 ...

- [moka同学笔记]yii2.0数据库操作以及分页

1.model中models/article.php 1 <?php 2 3 namespace app\models; 4 5 use Yii; 6 7 /** 8 * This is the ...

- jQuery corner 圆角插件

jquery.corner是一款强大的圆角插件(所产生的不止只是圆角效果),兼容包括IE6.IE7.IE8.firefox.Opera .Safari.Chrome等主流浏览器,唯一的缺点是为了产生边 ...

- SVG描边动画原理

SVG描边动画原理其实很简单,主要利用以下两个属性 stroke-dasharray 制作虚线,使得黑白相间, stroke-dashoffset 使得虚线向开头偏移,这里的1500不精确,是我随便取 ...

- MSCRM 修改 默认组织

目前组织管理器上的方法是无效的,期待MS打补丁吧. 下面介绍修改DB的方法: 1)打开Sql server management,找到MSCRM_config数据库,打开数据表:SystemUser和 ...

- SharePoint 2010 文档管理之过期归档工具

前言:使用过SharePoint的人都知道,SharePoint对于操作是便捷的,但是对于数据量承载却是不令人满意的,这样,就要求我们需要更加合理的使用,规范大家的使用规则和习惯,所以,定期清理不必要 ...

- 2015年第12本(英文第8本):the Old Man and the Sea 老人与海

书名:The Old Man and The Sea(老人与海) 作者:Ernest Hemingway 单词数:2.7万 不重复单词数:2600 首万词不重复单词数:1500 蓝思值:940 阅读时 ...

- 安卓开发_浅谈OptionsMenus(选项菜单)

Android平台下所提供的菜单大体上可分为三类:选项菜单.上下文菜单和子菜单. 当Activity在前台运行时,如果用户按下手机上的Menu键,此时就会在屏幕低端弹出相应的选项菜单.但这个功能需要开 ...

- iOS设计模式之迭代器模式

迭代器模式 基本理解 迭代器模式(Iterrator):提供一个方法顺序访问一个聚合对象中的各个元素,而又不暴露该元素的内部表示. 当你访问一个聚合对象,而且不管这些对象是什么都需要遍历的时候,你就应 ...