python——爬虫&问题解决&思考(四)

继续上一篇文章的内容,上一篇文章中已经将url管理器和下载器写好了。接下来就是url解析器,总的来说这个模块是几个模块中比较难的。因为通过下载器下载完页面之后,我们虽然得到了页面,但是这并不是我们想要的结果。而且由于页面的代码很多,我们很难去里面找到自己想要的数据。所幸,我们下载的是html页面,它是一种由多个多层次的节点组成的树型结构的文本文件。所以,相较于txt文件,我们更加容易定位到我们要找的数据块。现在我们要做的就是去原页面去分析一下,我们想要的数据到底在哪。

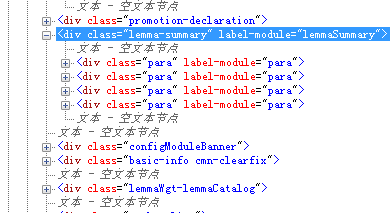

打开百度百科pyton词条的页面,然后按F12调出开发者工具。通过使用工具,我们就能定位到页面的内容:

这样我们就找到了我们想要的信息处在哪个标签里了。

import bs4

import re

from urllib.parse import urljoin

class HtmlParser(object):

"""docstring for HtmlParser"""

def _get_new_urls(self, url, soup):

new_urls = set()

links = soup.find_all('a', href = re.compile(r'/item/.'))

for link in links:

new_url = re.sub(r'(/item/)(.*)', r'\1%s' % link.getText(), link['href'])

new_full_url = urljoin(url, new_url)

new_urls.add(new_full_url)

return new_urls

def _get_new_data(self, url, soup):

res_data = {}

#url

res_data['url'] = url

#<dd class="lemmaWgt-lemmaTitle-title">

title_node = soup.find('dd', class_ = "lemmaWgt-lemmaTitle-title").find('h1')

res_data['title'] = title_node.getText()

#<div class="lemma-summary" label-module="lemmaSummary">

summary_node = soup.find('div', class_ = "lemma-summary")

res_data['summary'] = summary_node.getText()

return res_data

def parse(self, url, html_cont):

if url is None or html_cont is None:

return

soup = bs4.BeautifulSoup(html_cont, 'lxml')

new_urls = self._get_new_urls(url, soup)

new_data = self._get_new_data(url, soup)

return new_urls, new_data

解析器只有一个外部方法就是parse方法,

a.首先它会接受url, html_cont两个参数,然后进行判断页面内容是否为空

b.调用bs4模块的方法来解析网页内容,'lxml'为文档解析器,默认的为html.parser,bs官方推荐我们用lxml,那就听它的吧,谁让人家是官方呢。

c.接下来就是调用两个内部函数来获取新的url列表和数据

d.最后将url列表和数据返回

这里有一些注意点

1.bs的方法调用还有一个参数,from_encoding 这个和我在下载器那里的重复了,所以我就取消了,两个的功能是一样的。

2.获取url列表的内部方法,需要用到正则表达式,这里我也是摸着石头过河,不是很会,中间也调试过许多次。

3.数据是放在字典中的,这样可以通过key来增改删除数据。

最好,就直接数据输出了,这个比较简单,直接上代码。

class HtmlOutputer(object):

"""docstring for HtmlOutputer"""

def __init__(self):

self.datas = []

def collect_data(self, new_data):

if new_data is None:

return

self.datas.append(new_data)

def output_html(self):

fout = open('output1.html', 'w', encoding = 'utf-8')

fout.write('<html>')

fout.write('<head><meta charset="utf-8"></head>')

fout.write('<body>')

fout.write('<table>')

for data in self.datas:

fout.write('<tr>')

fout.write('<td>%s</td>' % data['url'])

fout.write('<td>%s</td>' % data['title'])

fout.write('<td>%s</td>' % data['summary'])

fout.write('</tr>')

fout.write('</table>')

fout.write('</body>')

fout.write('</html>')

fout.close()

这里也有两个注意点

1.fout = open('output1.html', 'w', encoding = 'utf-8'),这里的encoding参数一定要加,不然会报错,在windows平台,它默认是使用gbk编码来写文件的。

2.fout.write('<head><meta charset="utf-8"></head>'),这里的meta标签也要加上,因为要告诉浏览器使用什么编码来渲染页面,这里我一开始没加弄了很久,我打开页面的内容,发现里面是中文的,结果浏览器展示的就是乱码。总的来说,因为整个页面采集过程结果好几个模块,所以编码问题要非常小心,不然少不留神就会出错。

最后总结,这段程序还有许多方面可以深入探讨:

1.页面的数据量过小,我尝试了10000个页面的爬取。一旦数据量剧增之后,就会带来一下问题,第一是待爬取url和已爬取url就不能放在set集合中了,要么放到radi缓存服务器里,要么放到mysql数据库中

2.第二,数据也是同样的,字典也满足不了了,需要专门的数据库来存放

3.第三量上去之后,对爬取效率就有要求了,那么多线程就要加进来

4.第四,一旦布置好任务,单台服务器的压力会过大,而且一旦宕机,风险很大,所以分布式的高可用架构也要跟上来

5.一方面是页面的内容过于简单,都是静态页面,不涉及登录,也不涉及ajax动态获取

6.这只是数据采集,后续还有建模,分析…………

综上所述,路还远的很呢,加油!

python——爬虫&问题解决&思考(四)的更多相关文章

- python——爬虫&问题解决&思考(1)

最近刚接触python,找点小任务来练练手,希望自己在实践中不断的锻炼自己解决问题的能力.这个小爬虫来自慕课网的一门课程,我在这里记录的是自己学习的过程中遇到的问题和解决方法以及爬虫之外的思考. 这次 ...

- python——爬虫&问题解决&思考(三)

继续上一篇文章的内容,上一篇文章中,将爬虫调度器已经写好了,调度器是整个爬虫程序的"大脑",也可以称之为指挥中心.而现在,我们要做的就是去将调度器中用到的其他组件写好.首先是url ...

- Python爬虫学习:四、headers和data的获取

之前在学习爬虫时,偶尔会遇到一些问题是有些网站需要登录后才能爬取内容,有的网站会识别是否是由浏览器发出的请求. 一.headers的获取 就以博客园的首页为例:http://www.cnblogs.c ...

- python爬虫入门(四)利用多线程爬虫

多线程爬虫 先回顾前面学过的一些知识 1.一个cpu一次只能执行一个任务,多个cpu同时可以执行多个任务2.一个cpu一次只能执行一个进程,其它进程处于非运行状态3.进程里包含的执行单元叫线程,一个进 ...

- Python 爬虫入门(四)—— 验证码上篇(主要讲述验证码验证流程,不含破解验证码)

本篇主要讲述验证码的验证流程,包括如何验证码的实现.如何获取验证码.识别验证码(这篇是人来识别,机器识别放在下篇).发送验证码.同样以一个例子来说明.目标网址 http://icp.alexa.cn/ ...

- Python爬虫(二十四)_selenium案例:执行javascript脚本

本章叫介绍如何使用selenium在浏览器中使用js脚本,更多内容请参考:Python学习指南 隐藏百度图片 #-*- coding:utf-8 -*- #本篇将模拟执行javascript语句 fr ...

- python爬虫入门---第四篇:网站对爬虫的限制及突破测试

大部分网站对网络爬虫都有限制,限制方式有两种: 一.Robots协议:二.网站通过判断对网站访问http的头部信息来查看是否是爬虫,并对爬虫做相关拦截 第一种限制是书面限制,第二种是强制性阻拦限制.那 ...

- Python爬虫基础(四)Requests库的使用

requests文档 首先需要安装:pip install requests get请求 最基本的get: # -*- coding: utf-8 -*-import requests respons ...

- python爬虫---实现项目(四) 用BeautifulSoup分析新浪新闻数据

这次只演示了,如何在真实项目内用到BeautifulSoup库来解析网页,而新浪的新闻是ajax加载过来的数据,在这里我们只演示解析部分数据(具体反扒机制没做分析). 代码地址:https://git ...

随机推荐

- 读书笔记 effective c++ Item 54 让你自己熟悉包括TR1在内的标准库

1. C++0x的历史渊源 C++标准——也就是定义语言的文档和程序库——在1998被批准.在2003年,一个小的“修复bug”版本被发布.然而标准委员会仍然在继续他们的工作,一个“2.0版本”的C+ ...

- JavaScript中的数据结构及实战系列(2):栈

开题: 不冒任何险,什么都不做,什么也不会有,什么也不是. 本文目录 栈介绍: JavaScript实现栈: 栈的应用: 栈介绍: 和队列一样,栈也是一种表结构,但是和队列的"先进先出&qu ...

- python字符串实战

haproxy配置文件 思路:读一行,写一行 global log 127.0.0.1 local2 daemon maxconn 256 log 127.0.0.1 local2 info defa ...

- javascript中的apply,call,bind详解

apply.call 在 javascript 中,call 和 apply 都是为了改变某个函数运行时的上下文(context)而存在的,换句话说,就是为了改变函数体内部 this 的指向. Jav ...

- spring计划任务

Spring3中加强了注解的使用,其中计划任务也得到了增强,现在创建一个计划任务只需要两步就完成了: 创建一个Java类,添加一个无参无返回值的方法,在方法上用@Scheduled注解修饰一下: 在S ...

- Lua快捷键

快捷键 含义 ctrl + shift + L 多行编辑 ctrl + D 继续向下选中下一个相同的文本 Alt + F3 选中所有相同所选中德文本

- javascript 函数和作用域(函数,this)(六)

重点. 一.函数 1.函数介绍 函数是一块JavaScript代码,被定义一次,但可执行和调用多次.JS中的函数也是对象,所以JS函数可以像其他对象那样操作和传递,所以我们也常叫JS中的函数为函数对象 ...

- JavaScript异步编程

前言 如果你有志于成为一个优秀的前端工程师,或是想要深入学习JavaScript,异步编程是必不可少的一个知识点,这也是区分初级,中级或高级前端的依据之一.如果你对异步编程没有太清晰的概念,那么我建议 ...

- redis单机主从搭建

tar zxvf redis-2.8.13.tar.gz cd redis-2.8.13 make 1.安装主库 mkdir /opt/redis/sbin -p mkdir /opt/redi ...

- IDEA下使用maven构建web项目(SpringMVC+Mybatis整合)

需求背景:由于最近总是接到一些需求,需要配合前端团队快速建设移动端UI应用或web应用及后台业务逻辑支撑的需求,若每次都复用之前复杂业务应用的项目代码,总会携带很多暂时不会用到的功能或组件,这样的初始 ...