softmax交叉熵损失函数求导

来源:https://www.jianshu.com/p/c02a1fbffad6

简单易懂的softmax交叉熵损失函数求导

来写一个softmax求导的推导过程,不仅可以给自己理清思路,还可以造福大众,岂不美哉~

softmax经常被添加在分类任务的神经网络中的输出层,神经网络的反向传播中关键的步骤就是求导,从这个过程也可以更深刻地理解反向传播的过程,还可以对梯度传播的问题有更多的思考。

softmax 函数

softmax(柔性最大值)函数,一般在神经网络中, softmax可以作为分类任务的输出层。其实可以认为softmax输出的是几个类别选择的概率,比如我有一个分类任务,要分为三个类,softmax函数可以根据它们相对的大小,输出三个类别选取的概率,并且概率和为1。

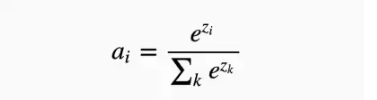

softmax函数的公式是这种形式:

S_i代表的是第i个神经元的输出。

ok,其实就是在输出后面套一个这个函数,在推导之前,我们统一一下网络中的各个表示符号,避免后面突然出现一个什么符号懵逼推导不下去了。

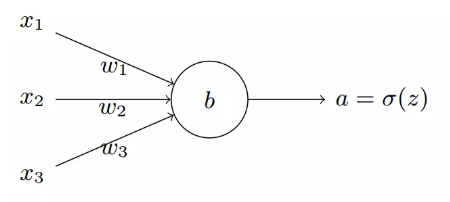

首先是神经元的输出,一个神经元如下图:

神经元的输出设为:

其中w_{ij}是第i个神经元的第j个权重,b是偏移值。z_i表示该网络的第i个输出。

给这个输出加上一个softmax函数,那就变成了这样:

a_i代表softmax的第i个输出值,右侧就是套用了softmax函数。

损失函数 loss function

在神经网络反向传播中,要求一个损失函数,这个损失函数其实表示的是真实值与网络的估计值的误差,知道误差了,才能知道怎样去修改网络中的权重。

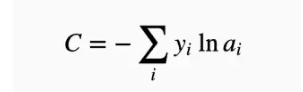

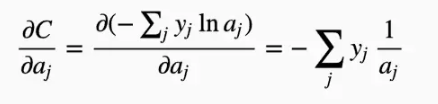

损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵的函数是这样的:

其中y_i表示真实的分类结果。

到这里可能嵌套了好几层,不过不要担心,下面会一步步推导,强烈推荐在纸上写一写,有时候光看看着看着就迷糊了,自己边看边推导更有利于理解~

最后的准备

在我最开始看softmax推导的时候,有时候看到一半不知道是怎么推出来的,其实主要是因为一些求导法则忘记了,唉~

所以这里把基础的求导法则和公式贴出来~有些忘记的朋友可以先大概看一下:

推导过程

好了,这下正式开始~

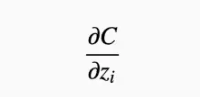

首先,我们要明确一下我们要求什么,我们要求的是我们的loss对于神经元输出(z_i)的梯度,即:

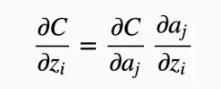

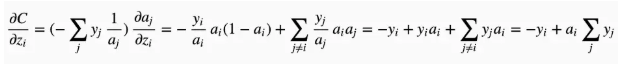

根据复合函数求导法则:

有个人可能有疑问了,这里为什么是a_j而不是a_i,这里要看一下softmax的公式了,因为softmax公式的特性,它的分母包含了所有神经元的输出,所以,对于不等于i的其他输出里面,也包含着z_i,所有的a都要纳入到计算范围中,并且后面的计算可以看到需要分为i = j和i ≠ j两种情况求导。

下面我们一个一个推:

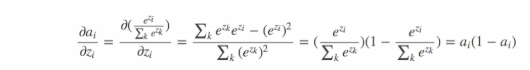

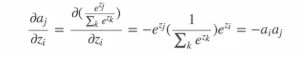

第二个稍微复杂一点,我们先把它分为两种情况:

如果i=j:

如果i≠j:

ok,接下来我们只需要把上面的组合起来:

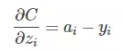

最后的结果看起来简单了很多,最后,针对分类问题,我们给定的结果y_i最终只会有一个类别是1,其他类别都是0,因此,对于分类问题,这个梯度等于:

来源:https://www.jianshu.com/p/c02a1fbffad6

softmax交叉熵损失函数求导的更多相关文章

- 简单易懂的softmax交叉熵损失函数求导

参考: https://blog.csdn.net/qian99/article/details/78046329

- 【转载】深度学习中softmax交叉熵损失函数的理解

深度学习中softmax交叉熵损失函数的理解 2018-08-11 23:49:43 lilong117194 阅读数 5198更多 分类专栏: Deep learning 版权声明:本文为博主原 ...

- 深度学习原理与框架-神经网络结构与原理 1.得分函数 2.SVM损失函数 3.正则化惩罚项 4.softmax交叉熵损失函数 5. 最优化问题(前向传播) 6.batch_size(批量更新权重参数) 7.反向传播

神经网络由各个部分组成 1.得分函数:在进行输出时,对于每一个类别都会输入一个得分值,使用这些得分值可以用来构造出每一个类别的概率值,也可以使用softmax构造类别的概率值,从而构造出loss值, ...

- softmax+交叉熵

1 softmax函数 softmax函数的定义为 $$softmax(x)=\frac{e^{x_i}}{\sum_j e^{x_j}} \tag{1}$$ softmax函数的特点有 函数值在[0 ...

- [ch03-02] 交叉熵损失函数

系列博客,原文在笔者所维护的github上:https://aka.ms/beginnerAI, 点击star加星不要吝啬,星越多笔者越努力. 3.2 交叉熵损失函数 交叉熵(Cross Entrop ...

- 关于交叉熵损失函数Cross Entropy Loss

1.说在前面 最近在学习object detection的论文,又遇到交叉熵.高斯混合模型等之类的知识,发现自己没有搞明白这些概念,也从来没有认真总结归纳过,所以觉得自己应该沉下心,对以前的知识做一个 ...

- 深度学习面试题07:sigmod交叉熵、softmax交叉熵

目录 sigmod交叉熵 Softmax转换 Softmax交叉熵 参考资料 sigmod交叉熵 Sigmod交叉熵实际就是我们所说的对数损失,它是针对二分类任务的损失函数,在神经网络中,一般输出层只 ...

- 深度学习:Sigmoid函数与损失函数求导

1.sigmoid函数 sigmoid函数,也就是s型曲线函数,如下: 函数: 导数: 上面是我们常见的形式,虽然知道这样的形式,也知道计算流程,不够感觉并不太直观,下面来分析一下. 1.1 ...

- softmax 损失函数求导过程

前言:softmax中的求导包含矩阵与向量的求导关系,记录的目的是为了回顾. 下图为利用softmax对样本进行k分类的问题,其损失函数的表达式为结构风险,第二项是模型结构的正则化项. 首先,每个qu ...

随机推荐

- troubleshoot之:分析OutOfMemoryError异常

目录 简介 OutOfMemoryError java.lang.OutOfMemoryError: Java heap space java.lang.OutOfMemoryError: GC Ov ...

- pycharm激活,此方法为永久激活。

1.下载JetbrainsCrack-3.1-release-enc.jar文件 链接: https://pan.baidu.com/s/1eN4paXtLVLeUN1nLP335rA 提取码: yg ...

- C++生成元

生成元对于正整数N,N的数字总和定义为N本身及其数字的总和.当M 是N的数字总和,我们称N为M的生成元. 例如,245的数字总和为256(= 245 + 2 + 4 + 5).因此,245是 256. ...

- JavaScript学习系列博客_3_JavaScript中的变量、常量、标识符

常量:就是改变不了的,也是可以直接使用的. 变量:可以改变的,不确定的. var =123456; 通过 var 声明一个变量,同时赋值给它 标识符:在JS中所有的可以自主命名的内容,都可以认为是一个 ...

- python基础 Day3

python Day3 1.作业回顾 设定一个理想的数字比如88,让用户输入数字,如果比88大,则显示猜测的结果大:如果比66小,则显示猜测的结果小了,给用户三次猜测机会,如果显示猜测正确退出循环,如 ...

- Ubutun重启网卡

一.network利用root帐户# service networking restart 或者/etc/init.d/networking restart 二.ifdown/ifup# ifdown ...

- 【接口自动化】Python+Requests接口自动化测试框架搭建【三】

经过上两篇文章的讲解,我们已经完成接口自动化的基础框架,现在开始根据实际项目丰满起来. 在PyCharm中新建项目,项目工程结构如下: config:配置文件夹,可以将一些全局变量放于配置文件中,方便 ...

- 微信access token过期

两台服务器使用同一个微信账号(同一个app id) 时,当其中一台服务器向微信请求access token时,会造成另一台服务器的access token过期

- ceph 开启mgr balancer

参考链接: mgr balancer模式探索及配置方法1 mgr balancer模式探索及配置方法2 1.ceph mgr module enable balancer [root@controll ...

- Python1--简介及基础语法

0. 简介 Python易于学习的编程语言,有很多现成的第三方库可以调用,不用重复造轮子,老话说:"人生苦短,我用 Python" 1. 安装Python Mac:brew ins ...