scrapy框架学习

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。 可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中。

其最初是为了 页面抓取 (更确切来说, 网络抓取 )所设计的, 也可以应用在获取API所返回的数据(例如 Amazon Associates Web Services ) 或者通用的网络爬虫。

本文档将通过介绍Scrapy背后的概念使您对其工作原理有所了解, 并确定Scrapy是否是您所需要的。

当您准备好开始您的项目后,您可以参考 入门教程 。

二、Scrapy安装介绍

Scrapy框架运行平台及相关辅助工具

- Python 2.7(Python最新版3.5,这里选择了2.7版本)

- Python Package: pip and setuptools. 现在 pip 依赖 setuptools ,如果未安装,则会自动安装setuptools 。

- lxml. 大多数Linux发行版自带了lxml。如果缺失,请查看http://lxml.de/installation.html

- OpenSSL. 除了Windows(请查看 平台安装指南)之外的系统都已经提供。

您可以使用pip来安装Scrapy(推荐使用pip来安装Python package).

pip install Scrapy

Windows下安装流程:

1、安装Python 2.7之后,您需要修改 PATH 环境变量,将Python的可执行程序及额外的脚本添加到系统路径中。将以下路径添加到 PATH 中:

C:\Python27\;C:\Python27\Scripts\;

除此之外,还可以用cmd命令来设置Path:

c:\python27\python.exe c:\python27\tools\scripts\win_add2path.py

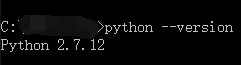

安装配置完成之后,可以执行命令python --version查看安装的python版本。(如图所示)

2、从 http://sourceforge.net/projects/pywin32/ 安装 pywin32

请确认下载符合您系统的版本(win32或者amd64)

从 https://pip.pypa.io/en/latest/installing.html 安装 pip

3、打开命令行窗口,确认 pip 被正确安装:

pip --version

4、到目前为止Python 2.7 及 pip 已经可以正确运行了。接下来安装Scrapy:

pip install Scrapy

至此windows下Scrapy安装已经结束。

三、Scrapy入门教程

1、在cmd中创建Scrapy项目工程。

scrapy startproject tutorial

H:\python\scrapyDemo>scrapy startproject tutorial

New Scrapy project 'tutorial', using template directory 'f:\\python27\\lib\\site-packages\\scrapy\\templates\\project', created in:

H:\python\scrapyDemo\tutorial You can start your first spider with:

cd tutorial

scrapy genspider example example.com

2、文件目录结构如下: 。

。

解析scrapy框架结构:

scrapy.cfg: 项目的配置文件。tutorial/: 该项目的python模块。之后您将在此加入代码。tutorial/items.py: 项目中的item文件。tutorial/pipelines.py: 项目中的pipelines文件。tutorial/settings.py: 项目的设置文件。tutorial/spiders/: 放置spider代码的目录。

3、编写简单的爬虫

1、在item.py中配置需采集页面的字段实例。

1 # -*- coding: utf-8 -*-

2

3 # Define here the models for your scraped items

4 #

5 # See documentation in:

6 # http://doc.scrapy.org/en/latest/topics/items.html

7

8 import scrapy

9 from scrapy.item import Item, Field

10

11 class TutorialItem(Item):

12 title = Field()

13 author = Field()

14 releasedate = Field()

2、在tutorial/spiders/spider.py中书写要采集的网站以及分别采集各字段。

1 # -*-coding:utf-8-*-

2 import sys

3 from scrapy.linkextractors.sgml import SgmlLinkExtractor

4 from scrapy.spiders import CrawlSpider, Rule

5 from tutorial.items import TutorialItem

6

7 reload(sys)

8 sys.setdefaultencoding("utf-8")

9

10

11 class ListSpider(CrawlSpider):

12 # 爬虫名称

13 name = "tutorial"

14 # 设置下载延时

15 download_delay = 1

16 # 允许域名

17 allowed_domains = ["news.cnblogs.com"]

18 # 开始URL

19 start_urls = [

20 "https://news.cnblogs.com"

21 ]

22 # 爬取规则,不带callback表示向该类url递归爬取

23 rules = (

24 Rule(SgmlLinkExtractor(allow=(r'https://news.cnblogs.com/n/page/\d',))),

25 Rule(SgmlLinkExtractor(allow=(r'https://news.cnblogs.com/n/\d+',)), callback='parse_content'),

26 )

27

28 # 解析内容函数

29 def parse_content(self, response):

30 item = TutorialItem()

31

32 # 当前URL

33 title = response.selector.xpath('//div[@id="news_title"]')[0].extract().decode('utf-8')

34 item['title'] = title

35

36 author = response.selector.xpath('//div[@id="news_info"]/span/a/text()')[0].extract().decode('utf-8')

37 item['author'] = author

38

39 releasedate = response.selector.xpath('//div[@id="news_info"]/span[@class="time"]/text()')[0].extract().decode(

40 'utf-8')

41 item['releasedate'] = releasedate

42

43 yield item

3、在tutorial/pipelines.py管道中保存数据。

1 # -*- coding: utf-8 -*-

2

3 # Define your item pipelines here

4 #

5 # Don't forget to add your pipeline to the ITEM_PIPELINES setting

6 # See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

7 import json

8 import codecs

9

10

11 class TutorialPipeline(object):

12 def __init__(self):

13 self.file = codecs.open('data.json', mode='wb', encoding='utf-8')#数据存储到data.json

14

15 def process_item(self, item, spider):

16 line = json.dumps(dict(item)) + "\n"

17 self.file.write(line.decode("unicode_escape"))

18

19 return item

4、tutorial/settings.py中配置执行环境。

1 # -*- coding: utf-8 -*-

2

3 BOT_NAME = 'tutorial'

4

5 SPIDER_MODULES = ['tutorial.spiders']

6 NEWSPIDER_MODULE = 'tutorial.spiders'

7

8 # 禁止cookies,防止被ban

9 COOKIES_ENABLED = False

10 COOKIES_ENABLES = False

11

12 # 设置Pipeline,此处实现数据写入文件

13 ITEM_PIPELINES = {

14 'tutorial.pipelines.TutorialPipeline': 300

15 }

16

17 # 设置爬虫爬取的最大深度

18 DEPTH_LIMIT = 100

5、新建main文件执行爬虫代码。

1 from scrapy import cmdline

2 cmdline.execute("scrapy crawl tutorial".split())

最终,执行main.py后在data.json文件中获取到采集结果的json数据。

scrapy框架学习的更多相关文章

- 自己的Scrapy框架学习之路

开始自己的Scrapy 框架学习之路. 一.Scrapy安装介绍 参考网上资料,先进行安装 使用pip来安装Scrapy 在开始菜单打开cmd命令行窗口执行如下命令即可 pip install Scr ...

- scrapy框架学习之路

一.基础学习 - scrapy框架 介绍:大而全的爬虫组件. 安装: - Win: 下载:http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted pip3 ...

- Scrapy框架学习 - 使用内置的ImagesPipeline下载图片

需求分析需求:爬取斗鱼主播图片,并下载到本地 思路: 使用Fiddler抓包工具,抓取斗鱼手机APP中的接口使用Scrapy框架的ImagesPipeline实现图片下载ImagesPipeline实 ...

- Scrapy框架学习笔记

1.Scrapy简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网 ...

- Scrapy框架学习(一)Scrapy框架介绍

Scrapy框架的架构图如上. Scrapy中的数据流由引擎控制,数据流的过程如下: 1.Engine打开一个网站,找到处理该网站的Spider,并向该Spider请求第一个要爬取得URL. 2.En ...

- Scrapy框架学习参考资料

00.Python网络爬虫第三弹<爬取get请求的页面数据> 01.jupyter环境安装 02.Python网络爬虫第二弹<http和https协议> 03.Python网络 ...

- scrapy框架学习第一天

今天是学习的第一天: 知识总结如下: 1,调试器相当于原料出口地(URL提供) 2,scrapy相当于中间加工商(具有销售权利)封装URL为request(请求) 3,下载器使用request(请求) ...

- Scrapy框架学习(三)Spider、Downloader Middleware、Spider Middleware、Item Pipeline的用法

Spider有以下属性: Spider属性 name 爬虫名称,定义Spider名字的字符串,必须是唯一的.常见的命名方法是以爬取网站的域名来命名,比如爬取baidu.com,那就将Spider的名字 ...

- Scrapy 框架 (学习笔记-1)

环境: 1.windows 10 2.Python 3.7 3.Scrapy 1.7.3 4.mysql 5.5.53 一.Scrapy 安装 1. Scrapy:是一套基于Twisted的一部处理框 ...

随机推荐

- swfupload组件上传文件

前段时间做文件上传用的是H5的一个插件,由于浏览器的兼容性不好,所以又换了一个Flash版本的上传文件插件,感觉这个上传插件的使用方式跟H5的差不多,有些雷同.不过,由于后续浏览不再支持Flash(略 ...

- swift使用查阅资料备份2

Swift3.0朝圣之路-Then协议库-绝妙的初始化方式 https://www.jianshu.com/p/6cc1e21df6ac DisposeBag http://southpeak.git ...

- iOS构建流畅的交互界面--CPU,GPU资源消耗的原因和解决方案

CPU资源消耗的原因和解决方案对象创建轻量对象代替重量对象* 不需要响应触摸事件的控件:CALayer显示* 对象不涉及UI操作,则尽量放到后台线程创建* 包含有CALayer的控件只能在主线程创建和 ...

- day01 编程概述及计算机组成原理

目录 编程概述 计算机硬件的五大组成部分 Central Processing Unit(cpu中央处理器) 存储器 输入,输出设备 打开QQ的流程 计算机五大组成部分补充 多核CPU ×64/x86 ...

- 根据 thread id 停止一个线程

出自 https://github.com/Bogdanp/dramatiq/blob/master/dramatiq/middleware/threading.py#L62 thread_id = ...

- IOS - autoresizingMask

提醒:当frame设定死,慎用autoresizingMask:否则该frame变形的难以想象.

- django-10-中间件和上下文管理器

<<<中间件的引入>>> 用户<->中间件<->url->视图 在app目录里面 middleware.py (1)中间件就是一个 ...

- dubbo知识点理解

1.分布式服务架构关键在于:用于提高业务复用及整合的 分布式服务框架(RPC) 是关键.注册中心是关键,提供业务复用和整合. 2.dubbo在消费方,获取服务列表后提供软负载均衡.dubbo在消费方提 ...

- [Angular] Send Data via HTTP using Angular HttpParams

Obviously in a real world application we do not only fetch data from the backend, but we also send d ...

- [Hyperapp] Render Text with JSX in Hyperapp

Hyperapp is an ultra lightweight (1kb), minimal, functional, JavaScript library for building UIs. It ...