hadoop-hive的内表和外表

--创建内表

create table if not exists employee(

id int comment 'empoyeeid',

dateincompany string comment 'data come in company',

money float comment 'work money',

mapdatamap array<string>,

arraydata array<int>,

structordata struct<col1:string,col2:string>)

partitioned by (century string comment 'centruycome in company',

year string comment 'come in comany year')

row format delimited fields terminated by ','

collection items terminated by '@'

map keys terminated by '$'

stored as textfile;

数据文件:

[hadoop@master hivetest]$ more employee.txt

1,huawei,1000.2,m1$a,1@2@3@4,c1@c2

装载数据:

hive>LOAD DATA LOCAL INPATH '/home/hadoop/tmp/hivetest/employee.txt' INTO TABLE employee PARTITION(century='zhengzhou', year='20180910');

查询数据:

hive> select * from employee;

OK

1 huawei 1000.2 ["m1$a"] [1,2,3,4] {"col1":"c1","col2":"c2"} zhengzhou 20180910

Time taken: 0.638 seconds, Fetched: 1 row(s)

给出的现象是:

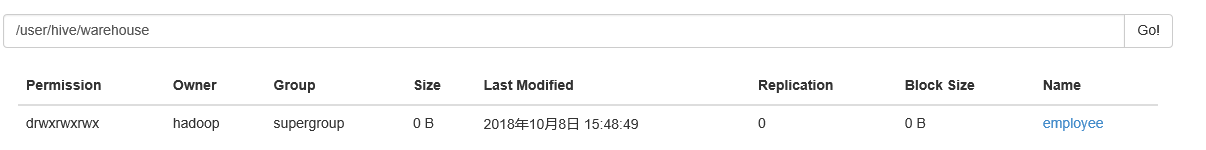

在HDFS上,默认的路径下/user/hive/warehouse/employee生成一个目录,在前台界面,也是一个目录。

删除内表,目录都不存在了。

还可以指定目录(HDFS上)

create table if not exists test1(id int, name string)

row format delimited fields terminated by ',' stored as textfile location '/tmp/data';

> load data inpath '/tmp/test1.txt' into table test1 ;

> select * from test1;

OK

1 zhangwei

Time taken: 0.593 seconds, Fetched: 1 row(s)

/tmp/test1.txt在加载的时候,删除掉了,数据加载到表里,其实就是落成文件到/tmp/data/test1.txt

删除表后,数据都删除了,data目录都删除了。

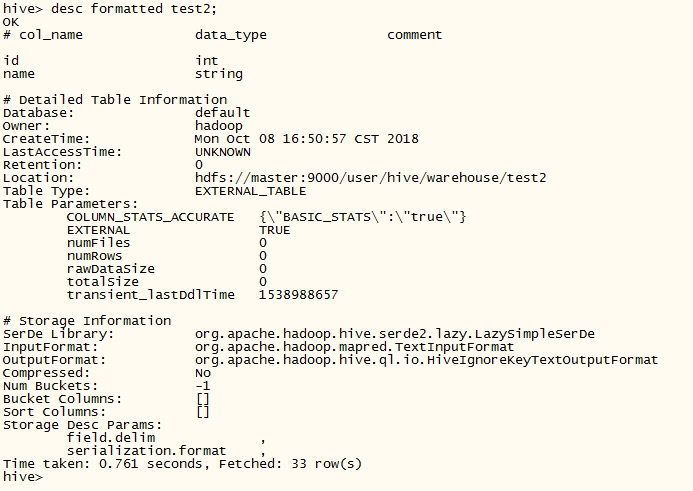

--创建外表

create external table if not exists test2 (id int,name string)

row format delimited fields terminated by ',' stored as textfile;

会在/user/hive/warehouse/新建一个表目录test2

hive> load data inpath '/tmp/test1.txt' into table test2 ;

Loading data to table default.test2

OK

Time taken: 1.053 seconds

hive> select * from test2;

OK

1 zhangwei

Time taken: 0.281 seconds, Fetched: 1 row(s)

现象: 在load的那一步,会把/tmp/test1.txt文件移动到/user/hive/warehouse/test2这个目录下。

数据的位置发生了变化!

本质是load一个hdfs上的数据时会转移数据!删除表后,数据文件在留在HDFS上。

2、在删除内部表的时候,Hive将会把属于表的元数据和数据全部删掉;而删除外部表的时候,Hive仅仅删除外部表的元数据,数据是不会删除的!

3. 在创建内部表或外部表时加上location 的效果是一样的,只不过表目录的位置不同而已,加上partition用法也一样,只不过表目录下会有分区目录而已,load data local inpath直接把本地文件系统的数据上传到hdfs上,有location上传到location指定的位置上,没有的话上传到hive默认配置的数据仓库中。

外部表相对来说更加安全些,数据组织也更加灵活,方便共享源数据。

那么,应该如何选择使用哪种表呢?在大多数情况没有太多的区别,因此选择只是个人喜好的问题。但是作为一个经验,如果所有处理都需要由Hive完成,那么你应该创建表,否则使用外部表!

有一个命令:

时光如水,悄然而逝。

hadoop-hive的内表和外表的更多相关文章

- Hive 7、Hive 的内表、外表、分区(22)

Hive 7.Hive 的内表.外表.分区 1.Hive的内表 Hive 的内表,就是正常创建的表,在 http://www.cnblogs.com/raphael5200/p/5208437.h ...

- Hive的内表和外表以及分区表

1. 内表和外表的区别 内表和外表之间是通过关键字EXTERNAL来区分.删除表时: 内表:在删除时,既删除内表的元数据,也删除内表的数据 外表:删除时,仅仅删除外表的元数据. CREATE [EXT ...

- Hive 7、Hive 的内表、外表、分区

1.Hive的内表 Hive 的内表,就是正常创建的表,在 http://www.cnblogs.com/raphael5200/p/5208437.html 中已经提到: 2.Hive的外表 创建H ...

- Hive内表和外表的区别

本文以例子的形式介绍一下Hive内表和外表的区别.例子共有4个:不带分区的内表.带分区的内表.不带分区的外表.带分区的外表. 1 不带分区的内表 #创建表 create table innerTabl ...

- hive内表和外表的创建、载入数据、区别

创建表 创建内表 create table customer( customerId int, firstName string, lastName STRING, birstDay timestam ...

- hadoop Hive 的建表 和导入导出及索引视图

1.hive 的导入导出 1.1 hive的常见数据导入方法 1.1.1 从本地系统中导入数据到hive表 1.创建student表 [ROW FORMAT DELIMITED]关键字,是用来设 ...

- hadoop系列 第二坑: hive hbase关联表问题

关键词: hive创建表卡住了 创建hive和hbase关联表卡住了 其实针对这一问题在info级别的日志下是看出哪里有问题的(为什么只能在debug下才能看见呢,不太理解开发者的想法). 以调试模式 ...

- kylin加载hive表错误:ERROR [http-bio-7070-exec-10] controller.TableController:189 : org/apache/hadoop/hive/conf/HiveConf java.lang.NoClassDefFoundError: org/apache/hadoop/hive/conf/HiveConf 解决办法

一.问题背景 在kylin中加载hive表时,弹出提示框,内容是“oops!org/apache/hadoop/hive/conf/HiveConf”,无法加载hive表,查找kylin的日志时发现, ...

- hive中删除表的错误Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask. MetaException

hive使用drop table 表名删除表时报错,return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask. MetaException 刚 ...

随机推荐

- python 生成词云

1.知识点 """ WordCloud参数讲解: font_path表示用到字体的路径 width和height表示画布的宽和高 prefer_horizontal可以调 ...

- JVM学习笔记之初识JVM(三)

一.JVM在计算机中的位置 JVM调用操作系统,操作系统调用硬件,硬件反馈信息至操作系统,操作系统反馈信息至JVM 二.JVM的体系结构 JVM在执行过程中对内存的管理分为5个区域: 1.PC寄存器 ...

- 小D课堂-SpringBoot 2.x微信支付在线教育网站项目实战_5-5.HttpClient4.x工具获取使用

笔记 5.HttpClient4.x工具获取使用 简介:讲解httpClient4.x相关依赖,并封装基本方法. 1.加入依赖 <dependency> ...

- spark学习中一些小问题---1

1.linux文件查找命令.这个很关键 find / -name employees.json 2.hdfs命令上传整个文件夹或文件 hadoop dfs -put /home/root/apache ...

- python用cx_Oracle连接oracle

确认版本: oracle版本:64位 python版本:64位 下载cx_Oracle的whl包:64位 安装whl包:pip install wheel cd到下载路径安装cx_Oracle的whl ...

- HDFS的基础与操作

一 HDFS概念 1.1 概念 HDFS,它是一个文件系统,全称:Hadoop Distributed File System,用于存储文件通过目录树来定位文件:其次,它是分布式的,由很多服务器联合起 ...

- Java集合(4):未获支持的操作及UnsupportedOperationException

执行各种添加和移除的方法在Collection中都是可选操作的,这意味着实现类并不需要为这些方法提供实现.当我们调用这些方法时,将不会执行有意义的行为,而是通常抛出UnsupportedOperati ...

- Java类的加载及初始化

每个类的编译代码都存在于它自己的独立文件中,该文件在需要使用该程序代码时才会被加载.通常有以下三种加载情况: (1) 访问了子类的静态变量或静态方法:仅对类的静态变量,静态块执行初始化操作,并仅初始化 ...

- 关键字 using语句 大神的神扯

using 是非托管资源: 解析:在C#应用托管到.NET Framework.但是他可以释放非托管资源. using 关键字有两个作用: 1:作为关键字,using可以导入命名空间 2:座位C#语句 ...

- GIL全局解释器锁,线程池与进程池 同步异步,阻塞与非阻塞,异步回调

GIL全局解释器锁 1.什么是GIL 官方解释:'''In CPython, the global interpreter lock, or GIL, is a mutex that prevents ...