Apache Kafka(十一)Topic 的配置与组成

Topic 的配置与组成

之前我们仅主要介绍了Kafka Producer与Kafka Consumer 的相关配置,而未详细介绍过有关topic的配置。Topic的配置在Kafka 使用中也至关重要,因为它的参数足以影响集群性能以及topic 的行为。

在一个topic被创建后,会有它默认的参数,不过有些topic的参数可能仍需要根据实际情况进行一些调整,例如:

- Replication Factor

- Partition数目

- Message Size

- Compression level

- Log Cleanup Policy

- Min Insync Replicas

- …

其中Replication Factor与Partition数目之前有被提及,所以我们主要关注之前未提及过的参数配置。

1. 如何配置一个 Kafka Topic

这里我们会简单地介绍如何使用kafka cli 为一个topic 修改配置。首先我们创建一个topic:

> kafka-topics.sh --zookeeper 172.31.24.148:2181 --create --topic configured-topic --partitions 3 --replication-factor 1

我们可以使用 kafka-configs cli 配置topic 的参数,例如:

kafka-configs.sh --zookeeper 172.31.24.148 --entity-type topics --entity-name configured-topic --add-config min.insync.replicas=2 --alter

然后describe 这个 topic:

kafka-topics.sh --zookeeper 172.31.24.148:2181 --describe --topic configured-topic

Topic:configured-topic PartitionCount:3 ReplicationFactor:1 Configs:min.insync.replicas=2

Topic: configured-topic Partition: 0 Leader: 0 Replicas: 0 Isr: 0

Topic: configured-topic Partition: 1 Leader: 0 Replicas: 0 Isr: 0

Topic: configured-topic Partition: 2 Leader: 0 Replicas: 0 Isr: 0

可以看到在Configs一栏,多出了一个配置。

也可以使用--delete-config 选项,删除一个配置:

kafka-configs.sh --zookeeper 172.31.24.148 --entity-type topics --entity-name configured-topic --delete-config min.insync.replicas --alter

Completed Updating config for entity: topic 'configured-topic'.

2. Partitions 与Segments

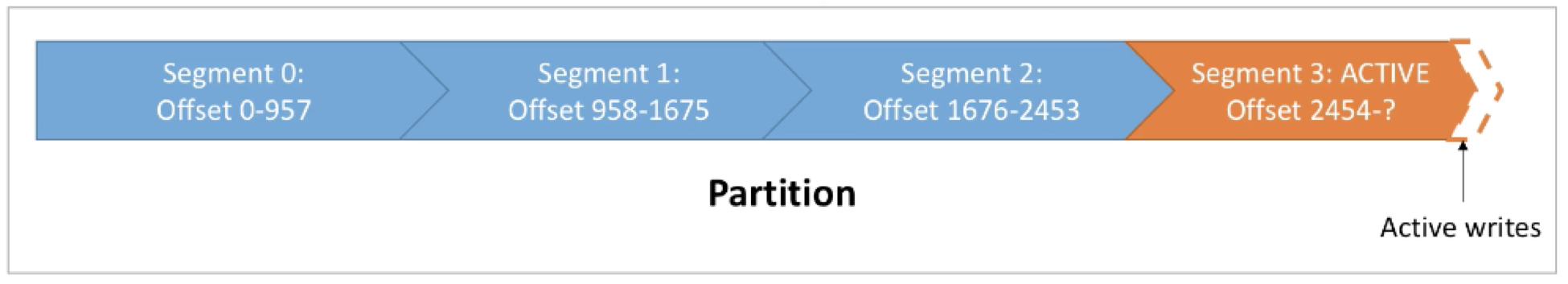

我们知道一个topic是由一个或多个partitions组成。而对于一个partition来说,它是由一个或多个segments (本质是文件)组成。如下图所示:

每个segment都会有一个starting offset以及一个ending offset。下一个segment的starting offset为前一个segment 的ending offset + 1。最后一个segment 称为active segment,意味着当前segment仍为“被写入”状态。也就是说,若是有新的record写入,则是写入到这个active segment中。在active segment中的offset达到预期值后,则此segment会被关闭,并开启一个新的segment。

所以在任何时刻,均只有一个segment为ACTIVE 状态(也就是数据被写入的segment)。

有关segment 的参数有两个:

- log.segment.bytes:单个segment可容纳的最大数据量,默认为1GB

- log.segment.ms:Kafka在commit一个未写满的segment前,所等待的时间(默认为7天)

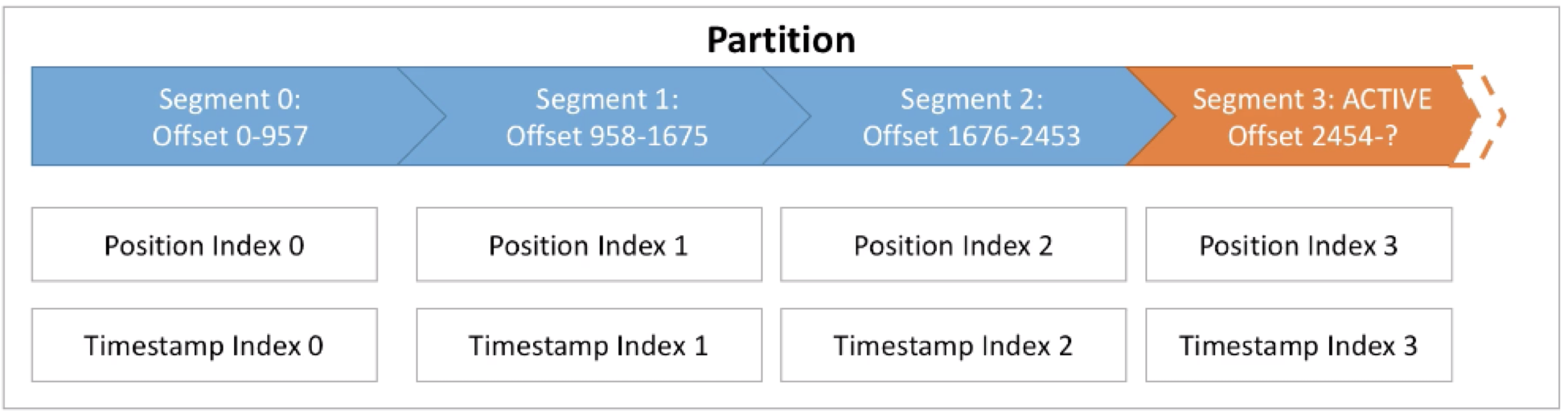

3. Segment 与 Indexes

每个Segment 均有与之对应的两个index文件:

- Offset 与 Position 之间映射的索引:用于让Kafka通过offset在segment中找到一条message

- Timestamp 与 Offset之间的索引:用于让Kafka通过一个timestamp找到一条message

也是基于这些index文件,使得Kafka可以在一个常数时间内找到数据。在找到此条数据后,会继续顺序读取之后的数据。这也就是为什么Kafka仅适用于顺序读写,而不适用于随机读写。

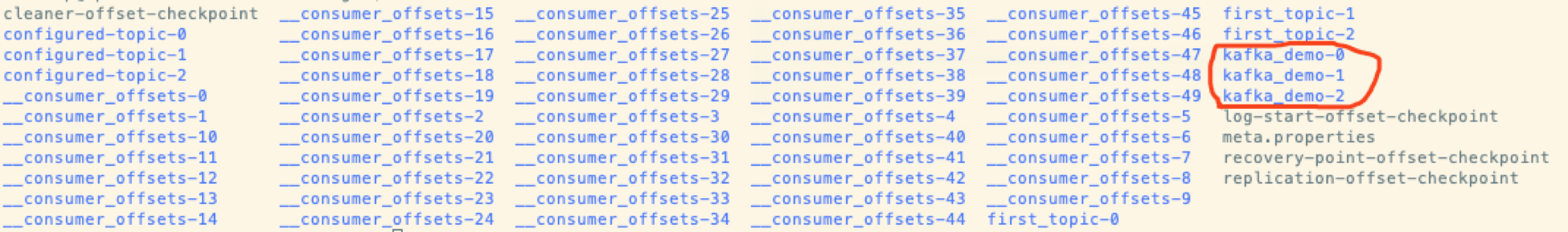

我们进一步可以再查看真正对应到这些概念的文件。之前我们定义了kafka 的log.dirs 为:

/home/hadoop/kafka_2.12-2.3.0/data/kafka-logs

进入到此目录,可以看到所有列出来的topics,以及它们对应的partitions:

进入到kafka_demo-0 这个partition目录中可以看到:

其中.log 为存储message的文件,.index 为Offset与Position之间的索引文件,.timeindex为Timestamp与 Offset之间的索引文件。

4. Segment 配置

在进一步了解了segment后,再回头看看segment的两个配置log.segment.bytes与log.segment.ms。

若是将log.segment.bytes(大小,默认为1GB)调小,则意味着:

- 每个partition对应更多的segments

- Log Compaction发生的会更频繁

· Kafka 会维护更多的open files(报错:Too many open files)

在决定此参数的大小时,需要考虑到业务吞吐的大小。如果业务的数据量是每天一个GB的数据,则默认的配置即可适用此场景;而如果业务的数据量是一周一个GB,则可以适当调小此值。

而若是将 log.segment.ms(默认为一周)调小,则意味着:

- 更频繁的log compaction(触发的更频繁)

- 生成更多的文件

在决定此参数的大小时,需要考虑到:业务中需要log compaction 发生的频率。Log Compaction会在之后介绍。

Apache Kafka(十一)Topic 的配置与组成的更多相关文章

- Kafka中Topic级别配置

一.Kafka中topic级别配置 1.Topic级别配置 配置topic级别参数时,相同(参数)属性topic级别会覆盖全局的,否则默认为全局配置属性值. 创建topic参数可以设置一个或多个--c ...

- 【转】apache kafka技术分享系列(目录索引)

转自: http://blog.csdn.net/lizhitao/article/details/39499283 估计大神会不定期更新,所以还是访问这个链接看最新的目录list比较好 apa ...

- apache kafka技术分享系列(目录索引)--转载

原文地址:http://blog.csdn.net/lizhitao/article/details/39499283 kafka开发与管理: 1)apache kafka消息服务 2)kafak安装 ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十一)定制一个arvo格式文件发送到kafka的topic,通过Structured Streaming读取kafka的数据

将arvo格式数据发送到kafka的topic 第一步:定制avro schema: { "type": "record", "name": ...

- Apache Kafka使用默认配置执行一些负载测试来完成性能测试和基准测试

Kafka是一种分布式,分区,复制的提交日志服务.它提供了消息传递系统的功能. 我们先来看看它的消息传递术语: Kafka在称为主题的类别中维护消息的提要. 我们将调用向Kafka主题生成器发布消 ...

- Error when sending message to topic test with key: null, value: 2 bytes with error: (org.apache.kafka.clients.producer.internals.ErrorLoggingCallback)

windows下使用kafka遇到这个问题: Error when sending message to topic test with key: null, value: 2 bytes with ...

- CDH下集成spark2.2.0与kafka(四十一):在spark+kafka流处理程序中抛出错误java.lang.NoSuchMethodError: org.apache.kafka.clients.consumer.KafkaConsumer.subscribe(Ljava/util/Collection;)V

错误信息 19/01/15 19:36:40 WARN consumer.ConsumerConfig: The configuration max.poll.records = 1 was supp ...

- kafka删除topic后再创建同名的topic报错(ERROR org.apache.kafka.common.errors.TopicExistsException)

[hadoop@datanode3 logs]$ kafka-topics.sh --delete --zookeeper datanode1:2181 --topic firstTopic firs ...

- Kafka设计解析(十一)Kafka无消息丢失配置

转载自 huxihx,原文链接 Kafka无消息丢失配置 目录 一.Producer端二.Consumer端 Kafka到底会不会丢数据(data loss)? 通常不会,但有些情况下的确有可能会发生 ...

随机推荐

- 牛客寒假6-F十字阵列

链接:https://ac.nowcoder.com/acm/problem/201986来源:牛客网 题目描述 小 Q 新学会了一种魔法,可以对一个 N行M列 的网格上的敌人造成伤害 第 i 次使用 ...

- IntelliJ IDEA提示URI is not registered几种解决方法

IntelliJ IDEA提示URI is not registered几种解决方法使用IntelliJ IDEA (以下简称IDEA)导入项目或是在maven生成 archetype时候,如果提示 ...

- 5.Docker Compose 部署 Harbor

什么是 Harbor Harbor 是一个用于存储和分发 Docker 镜像的企业级 Registry 服务器,通过添加一些企业必需的功能特性,例如安全.标识和管理等,扩展了开源 Docker Dis ...

- 2019-2020-2 《网络对抗技术》Exp0 环境搭建-Kali Linux 的安装

2019-2020-2 20175334 环境搭建-Kali Linux 的安装 一.Kali的下载与安装 在Kali官网中下载镜像文件 打开Vmware开始创建新虚拟机 选择镜像文件 选择操作系统 ...

- C++ lambda函数及其用法(转)

由于接触C++不久,很多东西比较陌生,今天看阿里云OSS的C++ SDK文件下载部分例子,发现有如下lambda表达式用法,故了解一下相关知识 /*获取文件到本地文件*/ GetObjectReque ...

- pandas玩转excel-> (1)如何利用pandas创建excel数据文件

#在Anaconda3 的Spyder中 #定义pandas模块为pd import pandas as pd #创建一个新的DataFrame对象,定义这个对象中有两个字段:ID和Name, ...

- vue自学入门-7(vue style scope)

vue自学入门-1(Windows下搭建vue环境) vue自学入门-2(vue创建项目) vue自学入门-3(vue第一个例子) vue自学入门-4(vue slot) vue自学入门-5(vuex ...

- k8s部署k8s-dashboard(v2.0.0-rc5)

部署dashboard 版本问题 dashboard版本更新换代很快,而且每个版本对应的k8s版本都有可能不同,所以第一步要确定版本对应关系. 查看页面可以确认版本对应关系 版本对应不上可能出现很多语 ...

- CSS的文本样式

CSS的文本样式 1.颜色 2.文本对齐方式 3.首行缩进 4.行高 5.装饰 1. 文本位置 居中: text-align: center; 靠左: text-align: left; 靠右: te ...

- Python-Django学习笔记(一)-MTV设计模式

Django是开源的.大而且全的Web应用框架. 它独具特色,采用了MTV设计模式. MTV框架包括:Model(模型).Template(模板)和View(视图) Model(模型):负责业务对象与 ...