Apache版hadoop编译

前言

做为大数据入门的基础,hadoop是每个大数据开发人员几乎不可避免的基础,目前hadoop已经发展到3.x.x版本,但当前企业使用的主流还是2.x.x版本,hadoop官网提供了编译后的hadoop,但这个是32位的,并且未供带C程序访问的接口,我们在使用本地库(可以用来做压缩,以及支持C程序等等)的时候就会出问题,所以需要自己再编译,之前自己编译过一次,但没有做总结,这次重新编译,做个总结记录一下。

一、环境准备

我是用的是 hadoop-2.8.5-src.tar.gz 版本,解压后找到BUILDING.txt

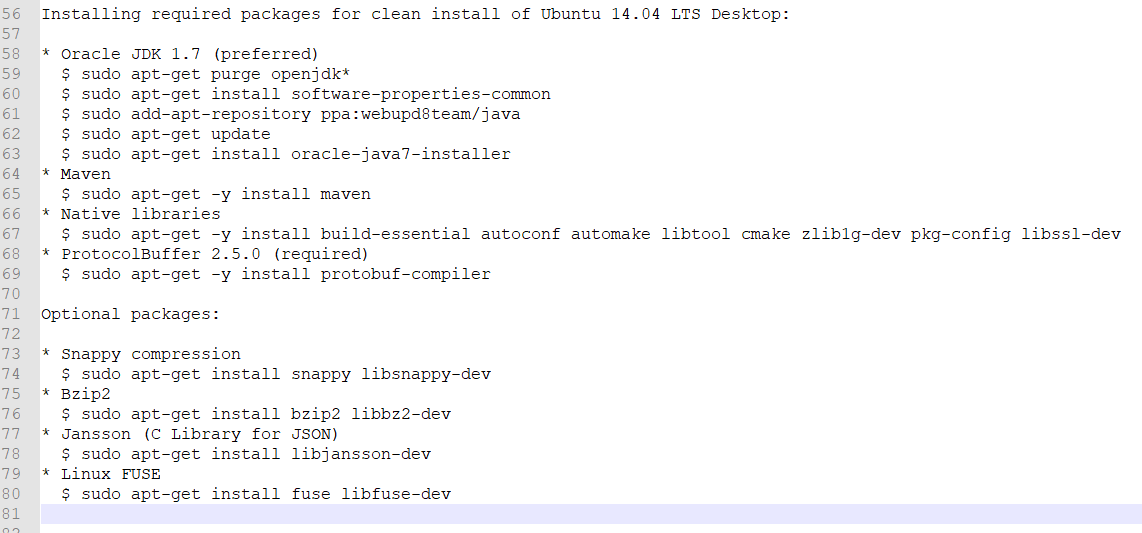

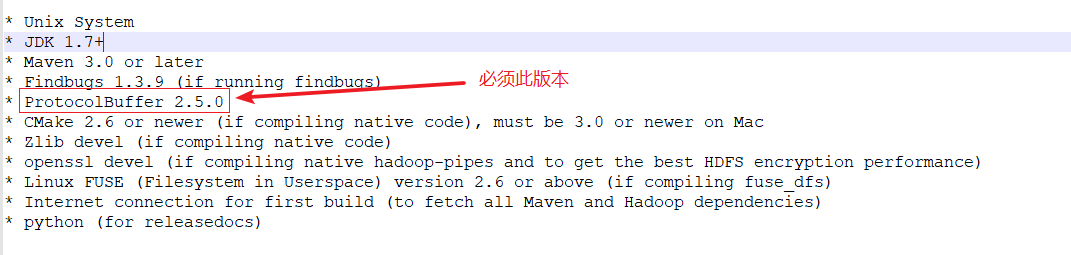

此文件列出了我们需要使用的一些环境,官方给的是在Ubuntu上进行编译,这里我使用的是CentOS7 minimal,部分软件下载 Ubuntu和CentOS不同,这里给大家总结了出来,执行以下命令即可

yum install -y gcc

yum install -y gcc-c++

yum install -y cmake

yum install -y snappy

yum install -y snappy-devel

yum install -y openssl

yum install -y autoconf

yum install -y libtool

yum install -y zlib-devel

yum install -y pkgconfig

yum install -y openssl-devel

yum install -y bzip2

yum install -y bzip2-devel

yum install -y bzip2-libs

上面是直接使用yum即可安装的,下面是需要我们自己下载相关文件编译安装,这里就不写这些软件的安装方式了,其中protobuf必须使用 2.5.0版本(注:谷歌将protobuf buffers放到github上后,已经找不到2.5.0官方版本了,这里提供一个从别人那里Fork到的提供给大家,protobuf-2.5.0)

- 系统:CentOS Linux release 7.4.1708(minimal)

- JDK: java version "1.8.0_202"

- MAVEN: apache-maven-3.6.0

- ant: apache-ant-1.10.5

- protobuf: protobuf-2.5.0 (必须)

二、执行安装

进入解压后的hadoop-2.8.5-src,执行 (这里maven可以将仓库挂载到宿主机的maven仓库,减少网络压力,挂载方法可以参考这里)

mvn package -Pdist,native -Drequire.snappy -DskipTests -Dtar

要确保网络的通常,此过程比较耗时,中间可能会出现有关jar包下载失败导致编译失败,再次编译即可

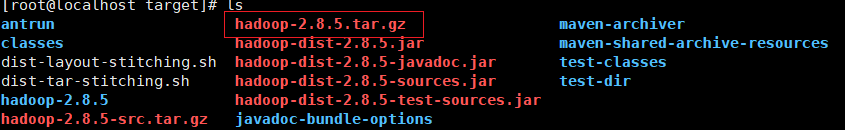

编译完成后,hadoop-2.8.5-src/hadoop-dist/target 目录下即可找到我们编译后的文件

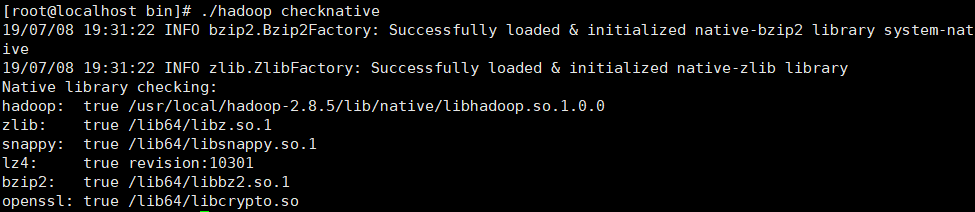

解压 hadoop-2.8.5-src/hadoop-dist/target/hadoop-2.8.5.tar.gz , bin文件夹下执行 ./hadoop checknative,即可查看是否成功将本地相关库编译成功

最后啰嗦一下:

java -version #java查看版本

mvn -v #maven查看版本

ant -version #ant查看版本

protoc --version #protocol查看版本

Apache版hadoop编译的更多相关文章

- Hadoop介绍及最新稳定版Hadoop 2.4.1下载地址及单节点安装

Hadoop介绍 Hadoop是一个能对大量数据进行分布式处理的软件框架.其基本的组成包括hdfs分布式文件系统和可以运行在hdfs文件系统上的MapReduce编程模型,以及基于hdfs和MapR ...

- Windows Azure HDInsight 支持预览版 Hadoop 2.2 群集

Windows Azure HDInsight 支持预览版 Hadoop 2.2 群集 继去年 10 月推出 Windows Azure HDInsight 之后,我们宣布 Windows Az ...

- Hadoop编译打包记录

Hadoop编译打包,基于2.7.2版本的源码. # 打包过程中需要使用到的工具 java -version mvn -version ant -version type protoc type cm ...

- APUE学习--第三版apue编译

第三版apue编译: 1. 首先在 http://www.apuebook.com/ 下载源码解压: tar zxvf src.3e.tar.gz 看完Readme可知,直接执 ...

- discuz论坛apache日志hadoop大数据分析项目:清洗数据核心功能解说及代码实现

discuz论坛apache日志hadoop大数据分析项目:清洗数据核心功能解说及代码实现http://www.aboutyun.com/thread-8637-1-1.html(出处: about云 ...

- Golang版protobuf编译

官方网址: https://developers.google.com/protocol-buffers/ (需要FQ) 代码仓库: https://github.com/google/protobu ...

- exception: java.net.ConnectException: Connection refused; For more details see: http://wiki.apache.org/hadoop/ConnectionRefused

1.虽然,不是大错,还说要贴一下,由于我运行run-example streaming.NetworkWordCount localhost 9999的测试案例,出现的错误,第一感觉就是Spark没有 ...

- Linux - Unix环境高级编程(第三版) 代码编译

Unix环境高级编程(第三版) 代码编译 本文地址:http://blog.csdn.net/caroline_wendy 时间:2014.10.2 1. 下载代码:http://www.apuebo ...

- Hadoop编译源码

Hadoop编译源码 克隆一个虚拟机 然后一步一步安装就行 安装所需:链接: https://pan.baidu.com/s/1jIZlQmi 密码: gggv 5.1 前期准备工作 1)CentOS ...

随机推荐

- C++基础知识随记

一.什么情况必须使用初始化列表的方式声明构造函数? 1.包含常量类型的成员 2.包含引用类型的成员 3.包含没有默认构造函数的类类型成员 4.优点:对于包含有类类型成员的类来说,省去了调用一次默认构造 ...

- PHP实现RSA2加密

PHP实现RSA2加密 1. 需要开启php的 php_openssl扩展 <?php /* * RSA2签名 * @param array 请求的参数 * @param string 私钥 * ...

- 文件转byte[ ]

/** * 将文件转换成byte数组 * @param tradeFile * @return */public byte[] fileToByte(String fileUrl){ // 第1步.使 ...

- 不用 PS 和 AI,5个网站能做出更好看的设计

要完成漂亮的设计,一定要掌握 PS.AI.Sketch 等专业的做图工具才可以.其实,现在有很多网站可以帮助不会专业设计工具的我们,做出很多很漂亮的设计,完成自己的设计需求.今天,我们就来介绍一下这些 ...

- Linux解压rar文件

Linux解压rar文件(unrar安装和使用,分卷解压) windows平台很多压缩文档为rar文件,那么怎么做到Linux解压rar文件(unrar安装和使用)? 简单,centos5安装unra ...

- k8s容器-节点部署篇

一. k8s节点部署 1. 环境规划 系统环境概述 系统环境说明 操作系统 Ubuntu16.04 or CentOS7 选的是CentOS7 - Kubernetes版本 ...

- Nodejs去掉/favicon.ico的请求

const http=require("http"); const server=http.createServer(); server.on("request" ...

- mysql莫名报"unknown column ... in 'on clause'"

今天遇见个会诡异的问题 一个web程序本地调试的好好的,结果发布到服务器上程序就报错了,报"unknown column ... in 'on clause'",网上搜了下,说是m ...

- koa 中间件 koa-art-template 的使用

例子 const Koa = require('koa'); const render =require('koa-art-template'); const path= require('path' ...

- koa2 使用 async 、await、promise解决异步的问题

koa代码编写上避免了多层的嵌套异步函数调用 async await来解决异步 - async await 需要依赖于promise 三主角: __函数前面 async, 内部才能await,要想aw ...