五.hadoop 从mysql中读取数据写到hdfs

目录:

本文是基于windows下来操作,linux下,mysql-connector-java-5.1.46.jar包的放置有讲究。

mr程序

import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.util.Iterator; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.io.Writable;

import org.apache.hadoop.mapred.FileOutputFormat;

import org.apache.hadoop.mapred.JobClient;

import org.apache.hadoop.mapred.JobConf;

import org.apache.hadoop.mapred.MapReduceBase;

import org.apache.hadoop.mapred.Mapper;

import org.apache.hadoop.mapred.OutputCollector;

import org.apache.hadoop.mapred.Reducer;

import org.apache.hadoop.mapred.Reporter;

import org.apache.hadoop.mapred.lib.db.DBConfiguration;

import org.apache.hadoop.mapred.lib.db.DBInputFormat;

import org.apache.hadoop.mapred.lib.db.DBWritable; /**

* @author DELL_pc

* @date 2017年6月27日

*/

public class DbaMysql {

public static class DBAccessMapper extends MapReduceBase implements Mapper<LongWritable,StudentRecord , IntWritable, Text>

{

public void map(LongWritable key, StudentRecord value, OutputCollector<IntWritable, Text> output,

Reporter reporter) throws IOException {

// TODO Auto-generated method stub

output.collect(new IntWritable(value.id), new Text(value.toString()));

}

}

public static class DBAccessReduce extends MapReduceBase implements Reducer<IntWritable, Text, IntWritable, Text>

{

public void reduce(IntWritable key, Iterator<Text> values, OutputCollector<IntWritable, Text> output,

Reporter reporter) throws IOException {

while (values.hasNext()) {

output.collect(key, values.next());

}

}

}

public static void main(String[] args) {

System.setProperty("hadoop.home.dir", "D:\\hadoop-2.7.6");//这一行一定要

Configuration configuration=new Configuration();

JobConf jobConf=new JobConf(configuration); jobConf.setOutputKeyClass(IntWritable.class);

jobConf.setOutputValueClass(Text.class);

jobConf.setInputFormat(DBInputFormat.class); // String[] fields={"id,name"};

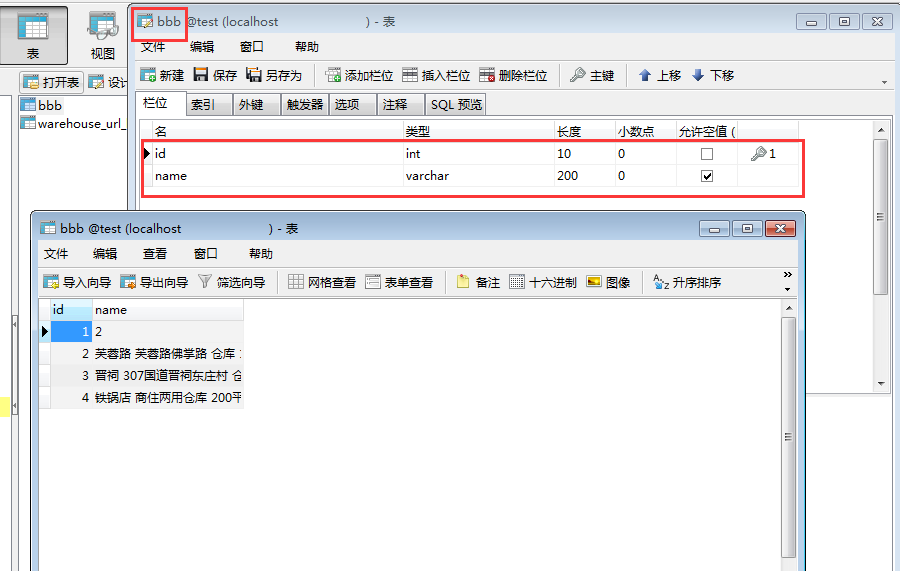

// DBInputFormat.setInput(jobConf, StudentRecord.class, "bbb", "length(name)>2", "",fields );//bbb是表名,读取方式1 DBInputFormat.setInput(jobConf, StudentRecord.class,"select id,name from bbb","select 3 from dual");//读取方式2 DBConfiguration.configureDB(jobConf, "com.mysql.jdbc.Driver", "jdbc:mysql://localhost:3306/test","root","admin");

jobConf.setMapperClass(DBAccessMapper.class);

jobConf.setReducerClass(DBAccessReduce.class);

FileOutputFormat.setOutputPath(jobConf,new Path("output_mysql"));

try {

JobClient.runJob(jobConf);

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

public static class StudentRecord implements Writable, DBWritable {

int id;

String name;

//构造方法

public StudentRecord() { }

//Writable接口是对数据流进行操作的,所以输入是DataInput类对象

public void readFields(DataInput in) throws IOException {

this.id = in.readInt(); //输入流中的读取下一个整数,并返回

this.name = Text.readString(in);

}

public String toString() {

return new String(this.id + " " + this.name);

}

//DBWritable负责对数据库进行操作,所以输出格式是PreparedStatement

//PreparedStatement接口继承并扩展了Statement接口,用来执行动态的SQL语句,即包含参数的SQL语句

public void write(PreparedStatement stmt) throws SQLException {

stmt.setInt(, this.id);

stmt.setString(, this.name);

}

//DBWritable负责对数据库进行操作,输入格式是ResultSet

// ResultSet接口类似于一张数据表,用来暂时存放从数据库查询操作所获得的结果集

public void readFields(ResultSet result) throws SQLException {

this.id = result.getInt();

this.name = result.getString();

}

//Writable接口是对数据流进行操作的,所以输出是DataOutput类对象

public void write(DataOutput out) throws IOException {

out.writeInt(this.id);

Text.writeString(out, this.name);

}

}

}

pom.xml:

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>2.7.</version>

</dependency>

<!-- https://mvnrepository.com/artifact/mysql/mysql-connector-java -->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.</version>

</dependency>

</dependencies>

————————————————————————————————————————————

附录:

本程序在windows上成功后,把打好的jar包 mstest.jar(jar包内已包含mysql驱动类)丢linux的hadoop上跑,会报错,说

// :: WARN mapreduce.JobResourceUploader: No job jar file set. User classes may not be found. See Job or Job#setJar(String).

// :: INFO mapreduce.JobSubmitter: Cleaning up the staging area file:/usr/software/hadoop/tmp/mapred/staging/root1889661768/.staging/job_local1889661768_0001

Exception in thread "main" java.lang.RuntimeException: java.lang.RuntimeException: java.lang.ClassNotFoundException: com.mysql.jdbc.Driver

at org.apache.hadoop.mapreduce.lib.db.DBInputFormat.setConf(DBInputFormat.java:)

at org.apache.hadoop.util.ReflectionUtils.setConf(ReflectionUtils.java:)

at org.apache.hadoop.util.ReflectionUtils.newInstance(ReflectionUtils.java:)

既使手动丢个mysql-connector-java-5.1.46.jar到java_home下没用,丢hadoop_home下没用,

最终丢的目录:

[hadoop_home]/share/hadoop/yarn/

然后,mysql就能被hdfs用到了

参考:Sqoop安装与MapReduce读MySql写HDFS加载不了JDBC驱动问题

五.hadoop 从mysql中读取数据写到hdfs的更多相关文章

- Hadoop 从URL中读取数据

package com.hadoop; import java.io.IOException; import java.io.InputStream; import java.net.URL; imp ...

- 一步一步跟我学习hadoop(7)----hadoop连接mysql数据库运行数据读写数据库操作

为了方便 MapReduce 直接訪问关系型数据库(Mysql,Oracle).Hadoop提供了DBInputFormat和DBOutputFormat两个类.通过DBInputFormat ...

- Sqoop(三)将关系型数据库中的数据导入到HDFS(包括hive,hbase中)

一.说明: 将关系型数据库中的数据导入到 HDFS(包括 Hive, HBase) 中,如果导入的是 Hive,那么当 Hive 中没有对应表时,则自动创建. 二.操作 1.创建一张跟mysql中的i ...

- JDBC Java 程序从 MySQL 数据库中读取数据,并备份到 xml 文档中

MySQL 版本:Server version: 5.7.17-log MySQL Community Server (GPL) 相关内容:JDBC Java 程序从 MySQL 数据库中读取数据,并 ...

- hadoop项目实战--ETL--(二)实现自动向mysql中添加数据

四 项目开发 1 创建数据库db_etl,新建两张表user 和oder.表结构如第一部分图所示. 2 编写python脚本,实现自动向mysql中插入数据. 新建python 项目,目录结构如下图 ...

- PHP读取mysql中的数据

<!DOCTYPE HTML> <html> <head> <title> PHP动态读取mysql中的数据 </title> <me ...

- 修改MySQL中的数据

一:insert语句 1.介绍 在执行插入语句前,需要具有执行INSERT语句的INSERT权限. 2.准备环境 3.简单insert语句 4.插入多行 在这种形式中,每行的值列表用逗号分隔. 如果为 ...

- 一个I/O线程可以并发处理N个客户端连接和读写操作 I/O复用模型 基于Buf操作NIO可以读取任意位置的数据 Channel中读取数据到Buffer中或将数据 Buffer 中写入到 Channel 事件驱动消息通知观察者模式

Tomcat那些事儿 https://mp.weixin.qq.com/s?__biz=MzI3MTEwODc5Ng==&mid=2650860016&idx=2&sn=549 ...

- 利用Ajax实现数据的同步传输,从mysql中提取数据,通过echarts可视化

如何将mysql数据库中的方式通过echarts可视化呢,以下面这个简单的例子向大家进行演示: 步骤一:mysql的创表和插入数据,当然这些数据也可以是你通过爬虫抓取的. 步骤二: 创 ...

随机推荐

- TCP通信实现对接硬件发送与接收十六进制数据 & int与byte的转换原理 & java中正负数的表示

今天收到的一份需求任务是对接硬件,TCP通信,并给出通信端口与数据包格式,如下: 1.首先编写了一个简单的十六进制转byte[]数组与byte[]转换16进制字符串的两个方法,如下: /** * 将十 ...

- java的引用

一.值类型与引用类型 1.变量初始化 int num = 10; String str = "hello"; num是int基本类型变量,值就直接保存在变量中.str是String ...

- (ScrollViewer或者有滚动条的控件)嵌套一个(ScrollViewer或者有滚动条的控件)禁用里面的滚动条

转自:http://blog.csdn.net/haylhf/article/details/8351203 后有改动 在C# 中,两个ScrollViewer嵌套在一起或者ScrollViewer里 ...

- mac环境下支持PHP调试工具xdebug,phpstorm监听

先让php支持xdebug 方式一: https://xdebug.org/download.php 下载相应的xdebug 可以到http://xdebug.org/wizard.php 把php ...

- web层直接调用 dubbo的服务,合适吗?

目前很多互联网app项目,都是采用这样的一个基本项目结构:即由后端提供Restful的api接口,然后供前端例如IOS.Android或者H5端去调用,如图: 在这种结构下,后台的代码分层常规一般会有 ...

- unigui 在单据中,某输入为必填项的 JS代码

给大家分享下在单据中,某输入为必填项,用红框标示的简单处理方法:UniSession.AddJS(UniEdit1.JSName+ '.el.setStyle({"border" ...

- boost 实现http断点续传

// testc.cpp : Defines the entry point for the console application. // #include "stdafx.h" ...

- Server-side activities have been updated. You need to restart SharePoint Designer to use the updated version of activities

一,环境: SharePoint Online Win10 + SharePoint Designer 2013 错误描述: 使用SPD3013打开SPO站点,然后编辑已有工作流(2013),报错: ...

- 使用js下载文件

使用Echarts地图时,需要一些地图数据,到Echarts下载地图数据文件时,发现其下载是直接通过js下载,从其网站上扒下来的记录于此 FileSave.min.js网络地址:http://ecom ...

- java 系统属性

java.version Java 运行时环境版本 java.vendor Java 运行时环境供应商 java.vendor.url Java 供应商的 URL java.home Java ...