Hadoop学习笔记(五):java开发MapReduce

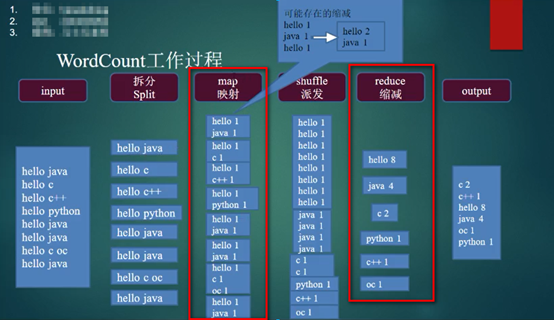

1. MapReduce的流程图(摘自马士兵老师视频),我们开发的就是其中的这两个(红框)过程。简述一下这个图,input就是我们需要处理的文件(datanode上文件的一个分块);Split就是将这个文件进行拆分,默认的就是按照行来拆分,拆分的结果是一个key-value对,key是这一行起始的位置,value就是这一行的内容;map是我们需要开发的内容,也就是对这一行数据的处理,产生的结果也是一个key-value对;shuffle是把上一步处理后的数据进行一个汇总,把同样的key合并到一起,把所有的value放到一个容器里;reduce缩减,就是将上一步容器里的值进行求和,也是一个key-value对;output就是输出。

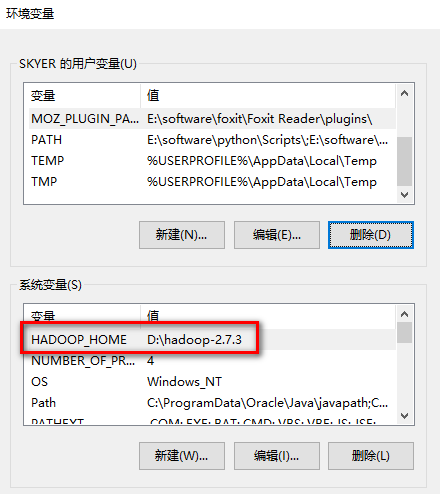

2. 如果是在windows机器上进行开发,需要对环境进行一些配置:

a). 首先添加hadoop的环境变量HADOOP_HOME指向hadoop的安装目录:

b). 把HADOOP_HOME/bin加到PATH环境变量(非必要)

c). 覆盖HADOOP_HOME/bin(到此处https://github.com/srccodes/hadoop-common-2.2.0-bin下载bin文件)

d). 将hadoop.dll复制到c:\windows\system32目录下(重启电脑)

3. 新建java项目,引入相应的jar包,jar包都位于HADOOP_HOME目录下的share/hadoop中,以下是jar清单:

a). common下hadoop-common-2.7.3.jar,已经common/lib下所有jar包。

b). hdfs下所有jar包,以及hdfs/lib下所有jar包。

c). mapreduce下所有jar包,以及mapreduce/lib下所有jar包。

d). yarn下所有jar包,以及yarn/lib下所有jar包。

4. 编写map层代码,新建WordMapper.java类:

import java.io.IOException; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; public class WordMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

@Override

protected void map(LongWritable key, Text value, Mapper<LongWritable, Text, Text, IntWritable>.Context context) throws IOException, InterruptedException {

final IntWritable ONE = new IntWritable(1);

String s = value.toString();

String[] words = s.split(" ");

for (String word : words) {

context.write(new Text(word), ONE);

}

}

}

5. 编写reduce层代码,新建WordReduce.java文件:

import java.io.IOException; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; public class WordReduce extends Reducer<Text, IntWritable, Text, LongWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Reducer<Text, IntWritable, Text, LongWritable>.Context content) throws IOException, InterruptedException {

long count = 0;

for (IntWritable v : values) {

count += v.get();

}

content.write(key, new LongWritable(count));

}

}

6. 编程测试层代码,新建Test.java(程序可以在windows独立运行,不用启动hadoop服务)

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class Test {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration(); Job job = Job.getInstance(conf); job.setMapperClass(WordMapper.class);

job.setReducerClass(WordReduce.class); job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class); job.setOutputKeyClass(Text.class);

job.setOutputValueClass(LongWritable.class); FileInputFormat.setInputPaths(job, "E:/input.txt");

FileOutputFormat.setOutputPath(job, new Path("E:/out/")); job.waitForCompletion(true);

}

}

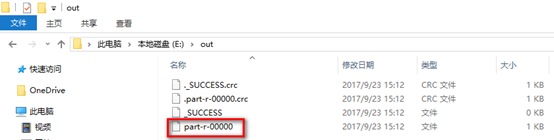

7. 运行测试代码,去到输出目录进行查看:

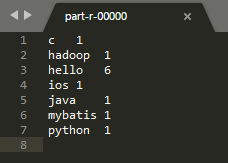

8. 打开该文件,查看运行结果:

9. 下面将这个程序扔到hadoop中运行。

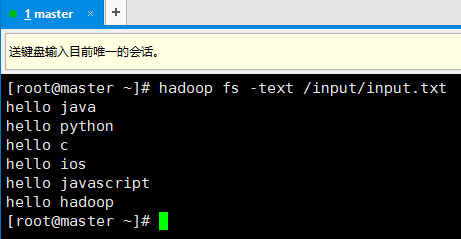

10. 首先在hadoop上准备一个需要处理文件

11. 修改测试代码,只要修改两行就好了,然后运行(记得启动hadoop和yarn):

FileInputFormat.setInputPaths(job, "hdfs://192.168.74.100:9000/input");

FileOutputFormat.setOutputPath(job, new Path("hdfs://192.168.74.100:9000/output"));

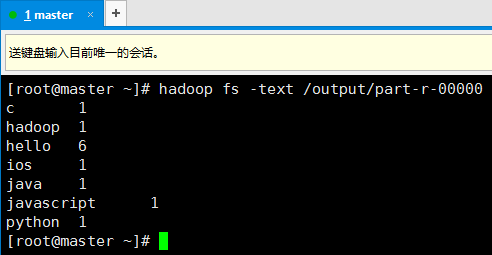

12. 在hadoop中查看运行结果

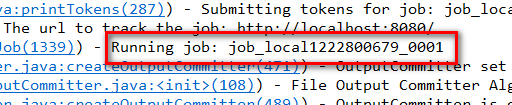

13. 需要注意的是(观看Eclipse的控制台),这个任务仍然是在本地执行的,也就是说,这个程序需要先将需要处理的文件下载的本地,然后再进行处理,显而易见,如果文件很大,这是很不合适的。

14. 我们要做的是将程序给hadoop执行,而不是将datanode的文件下载到本地,然后用本地的程序执行。修改后测试代码如下,注意,这里需要进行两个配置,在windows的host文件中添加master的ip:

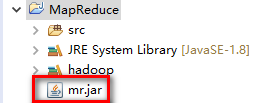

然后,将项目打成jar包放到项目根目录下:

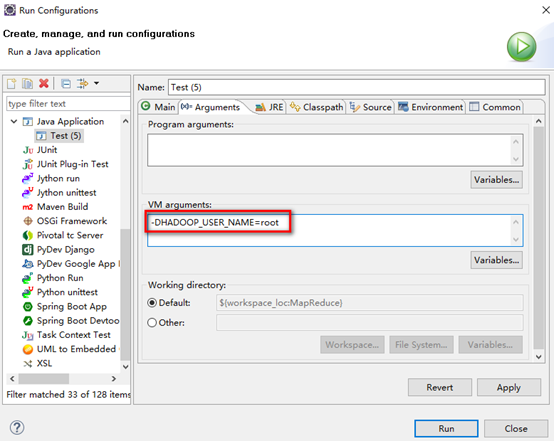

运行的时候,右击测试文件,选择Run Configurations,在Arguments的VM arguments中输入-DHADOOP_USER_NAME=root,然后点击Run

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class Test {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration(); conf.set("fs.defaultFS", "hdfs://192.168.74.100:9000/");

conf.set("mapreduce.job.jar", "mr.jar");

conf.set("mapreduce.framework.name", "yarn");

conf.set("yarn.resourcemanager.hostname", "master");

conf.set("mapreduce.app-submission.cross-platform", "true"); Job job = Job.getInstance(conf); job.setMapperClass(WordMapper.class);

job.setReducerClass(WordReduce.class); job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class); job.setOutputKeyClass(Text.class);

job.setOutputValueClass(LongWritable.class); FileInputFormat.setInputPaths(job, "/input/");

FileOutputFormat.setOutputPath(job, new Path("/output2/")); job.waitForCompletion(true);

}

}

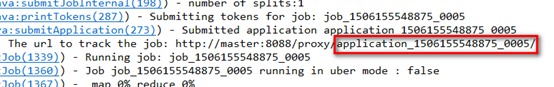

15. 查看该任务ID

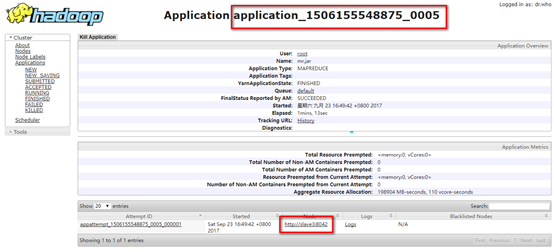

16. 运行完上述代码,查看测试结果(自行查看),宿主机浏览器查看刚才的任务,发现刚才的任务是在slave3上执行的。

Hadoop学习笔记(五):java开发MapReduce的更多相关文章

- Hadoop学习笔记(4) ——搭建开发环境及编写Hello World

Hadoop学习笔记(4) ——搭建开发环境及编写Hello World 整个Hadoop是基于Java开发的,所以要开发Hadoop相应的程序就得用JAVA.在linux下开发JAVA还数eclip ...

- Java学习笔记二:Java开发工具Eclipse的安装与使用

Java开发工具Eclipse的安装与使用 正如office一样我们在开发java语言过程中同样需要依款不错的开发工具,目前市场上的IDE很多,这里只演示Eclipse的安装: 一:下载软件: 1.下 ...

- Hadoop 学习笔记 (十一) MapReduce 求平均成绩

china:张三 78李四 89王五 96赵六 67english张三 80李四 82王五 84赵六 86math张三 88李四 99王五 66赵六 77 import java.io.IOEx ...

- Hadoop 学习笔记 (十) MapReduce实现排序 全局变量

一些疑问:1 全排序的话,最后的应该sortJob.setNumReduceTasks(1);2 如果多个reduce task都去修改 一个静态的 IntWritable ,IntWritable会 ...

- Hadoop学习笔记五

一.uber(u:ber)模式 MapReduce以Uber模式运行时,所有的map,reduce任务都在一个jvm中运行,对于小的mapreduce任务,uber模式的运行将更为高效. uber模式 ...

- Java学习笔记五:Java中常用的运算符

Java中常用的运算符 运算符是一种“功能”符号,用以通知 Java 进行相关的运算.譬如,我们需要将变量 score 的值设置为 20 ,这时候就需要一个“=”,告诉程序需要进行赋值操作. Java ...

- Java基础学习笔记五 Java基础语法之面向对象

面向对象 理解什么是面向过程.面向对象 面向过程与面向对象都是我们编程中,编写程序的一种思维方式.面向过程的程序设计方式,是遇到一件事时,思考“我该怎么做”,然后一步步实现的过程.例如:公司打扫卫生( ...

- Java 学习笔记 (五) Java Compile\Build\Make的区别

以下内容引自: http://blog.51cto.com/lavasoft/436216 Compile.Make和Build的区别 原创leizhimin2010-11-30 11:30:20评论 ...

- Vue学习笔记(五)——配置开发环境及初建项目

前言 在上一篇中,我们通过初步的认识,简单了解 Vue 生命周期的八个阶段,以及可以应用在之后的开发中,针对不同的阶段的钩子采取不同的操作,更好的实现我们的业务代码,处理更加复杂的业务逻辑. 而在这一 ...

- 【原】Java学习笔记001 - JAVA开发环境搭建

1.JDK下载并安装,以jdk-7u45-windows-i586.exe为例(注意JDK的安装和JRE的安装是分开的) 2.“我的电脑”右键属性,找到“高级系统设置”,找到“高级”tab下的“环境变 ...

随机推荐

- canvas画布如何画图案例

<!DOCTYPE html><html lang="en"><head> <meta charset="UTF-8" ...

- 利用IO和File类实现拷贝文件目录问题

/* 复制文件夹 参数 File src,File dest */ public static void copy(File src,File dest){ if (src.isDirectory() ...

- shiro简单配置 (写的不错 收藏一下)

抄袭的连接:https://blog.csdn.net/clj198606061111/article/details/24185023 注:这里只介绍spring配置模式. 因为官方例子虽然中有更加 ...

- Dev gridcontrol 添加多列按钮

gridcontrol中添加按钮的步骤: 1. 把列的ColumnEdit属性设置为RepositoryItemButtonEdit 2. 把TextEditStyle属性设置为HideTextEdi ...

- python_flask框架学习之路(1)

1.初识web,了解utl . 术语: scheme://host:port/path?query-string=xxx#yyyy 例子:https://i.cnblogs.com/EditArtic ...

- 【收藏】JS获取鼠标的X,Y坐标位置

JS的方法: <html> <head> <meta http-equiv="Content-Type" content="text/htm ...

- ByteArrayInputStream

package org.example.io; import java.io.ByteArrayInputStream;import java.io.IOException; /** * ByteAr ...

- Openvswitch手册(9): Flow

这一节我们将flow table flow table主要由ovs-ofctl命令操作 ovs-ofctl可以走和openflow controller一样的协议: ssl:ip[:port]: Th ...

- post上传和压缩、插件模拟请求

gzip gzip一种压缩方式,或者是文件形式,它主要用于网络传输数据的压缩 gzip压缩好不好用 浏览器:网速一定.内容越小.请求响应的速度是不是更快 手机server:返回数据类型是json/ ...

- WebView的知识

一.基本介绍 WebView是一个显示页面的组件. 二.基本使用 访问网页需要网络,所以在AndroidManifest.xml文件中添加网络权限. <uses-permission andro ...