058 kafka与log4j集成

1.首先在resources下面写log4j.properties

主要是因为kafka.producer.KafkaLog4jAppender类的存在。

log4j.rootLogger=INFO,console,KAFKA ## appender KAFKA

log4j.appender.KAFKA=kafka.producer.KafkaLog4jAppender

## topic must exitss

log4j.appender.KAFKA.topic=beifeng

log4j.appender.KAFKA.brokerList=linux-hadoop01.ibeifeng.com:9092,linux-hadoop01.ibeifeng.com:9093

log4j.appender.KAFKA.compressionType=none

log4j.appender.KAFKA.syncSend=false

log4j.appender.KAFKA.layout=org.apache.log4j.PatternLayout

log4j.appender.KAFKA.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %-5p %c{1}:%L %% - %m ## appender console

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d (%t) [%p - %l] %m%n

2.测试类

package com.jun.it;

import org.apache.log4j.Logger;

public class KafkaLoggerTest {

public static final Logger logger = Logger.getLogger(KafkaLoggerTest.class);

public static void main(String[] args) throws InterruptedException {

for(int i=0;i<50;i++) {

logger.debug("debug_" + i);

logger.info("info_" + i);

logger.warn("warn_" + i);

logger.error("error_" + i);

logger.fatal("fatal_" + i);

}

// 如果不sleep,会出现什么情况?怎么解决

Thread.sleep(10000);

}

}

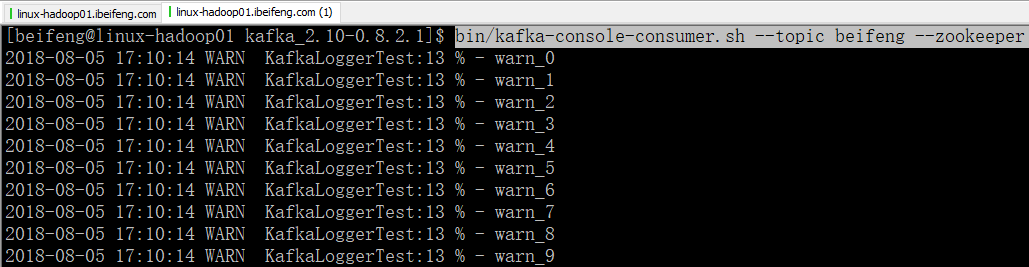

3.开启9092端口的消费者服务

bin/kafka-console-consumer.sh --topic beifeng --zookeeper linux-hadoop01.ibeifeng.com:2181/kafka

4.效果

058 kafka与log4j集成的更多相关文章

- Kafka设计解析(十八)Kafka与Flink集成

转载自 huxihx,原文链接 Kafka与Flink集成 Apache Flink是新一代的分布式流式数据处理框架,它统一的处理引擎既可以处理批数据(batch data)也可以处理流式数据(str ...

- 简单测试flume+kafka+storm的集成

集成 Flume/kafka/storm 是为了收集日志文件而引入的方法,最终将日志转到storm中进行分析.storm的分析方法见后面文章,这里只讨论集成方法. 以下为具体步骤及测试方法: 1.分别 ...

- Kafka与Flink集成

Apache Flink是新一代的分布式流式数据处理框架,它统一的处理引擎既可以处理批数据(batch data)也可以处理流式数据(streaming data).在实际场景中,Flink利用Apa ...

- 基于Flume+LOG4J+Kafka的日志采集架构方案

本文将会介绍如何使用 Flume.log4j.Kafka进行规范的日志采集. Flume 基本概念 Flume是一个完善.强大的日志采集工具,关于它的配置,在网上有很多现成的例子和资料,这里仅做简单说 ...

- Flume+LOG4J+Kafka

基于Flume+LOG4J+Kafka的日志采集架构方案 本文将会介绍如何使用 Flume.log4j.Kafka进行规范的日志采集. Flume 基本概念 Flume是一个完善.强大的日志采集工具, ...

- kafka与Spring的集成

准备工作 kafka版本:kafka_2.10-0.10.1.0 spring版本:spring4.3 配置文件 pom文件配置(也可以直接下载jar包) Kafka和spring集成的支持类库,sp ...

- log4j.xml 报告集成

等级: trace< debug<info<warn<error<fatal trace 追踪 deug: eclipse, Log4j配置 [1]从零开始 a). ...

- flume从log4j收集日志输出到kafka

1. flume安装 (1)下载:wget http://archive.cloudera.com/cdh5/cdh/5/flume-ng-1.6.0-cdh5.7.1.tar.gz (2)解压:ta ...

- flume采集log4j日志到kafka

简单测试项目: 1.新建Java项目结构如下: 测试类FlumeTest代码如下: package com.demo.flume; import org.apache.log4j.Logger; pu ...

随机推荐

- Hystrix系列-5-Hystrix的资源隔离策略

转自:https://blog.csdn.net/liuchuanhong1/article/details/73718794 Hystrix的资源隔离策略有两种,分别为:线程池和信号量. 说到资源隔 ...

- Inspector did not run successfully.

装虚拟机,卡在这个报错1天了, server没有问题,其余所有的agent都不能运行. 这部分没有日志,只有单纯的报错信息,omg,百度.bing一顿骚操作,还是没有解决问题. 因为默认安装jdk1. ...

- C#标准体重判断

- 年底Android面试整理(附答案)

面试,无非都是问上面这些问题(挺多的 - -!),聘请中高级的安卓开发会往深的去问,并且会问一延伸二.以下我先提出几点重点,是面试官基本必问的问题,请一定要去了解! 基础知识 – 四大组件(生命周期, ...

- Confluence 6 使用 WebDAV 客户端来对页面进行操作

下面的部分告诉你如何在不同的系统中来设置原生的 WebDAV 客户端,这个客户端通常显示在你操作系统的文件浏览器中,例如,Windows 的 Windows Explorer 或者 Linux 的 K ...

- bs4

- Android 基础 一 AndroidManifest.xml

一.概述 AndroidManifest.xml是Android应用的入口文件,它描述了package中暴露的组件(activities, services, 等等),他们各自的实现类,各种能被处理的 ...

- bzoj 4011

看了好多篇题解才看懂的题,我实在太菜了... 首先根据一个我不知道的算法,可以证明在没有加入新的边的时候,原图的所有生成树的方案数就是所有点(除1以外)的度之积 那么在新加入这条边之后,我们仍然可以这 ...

- Java手动释放对象

伪代码 public void updateUser(BufferedWriter writer, BufferedReader reader) { List<User> array = ...

- MySQL基于ROW格式的数据恢复

大家都知道MySQL Binlog 有三种格式,分别是Statement.Row.Mixd.Statement记录了用户执行的原始SQL,而Row则是记录了行的修改情况,在MySQL 5.6以上的版本 ...