wordcloud+jieba

Wordcloud各参数含义

font_path : string #字体路径,需要展现什么字体就把该字体路径+后缀名写上,如:font_path = '黑体.ttf'

width : int (default=400) #输出的画布宽度,默认为400像素

height : int (default=200) #输出的画布高度,默认为200像素

prefer_horizontal : float (default=0.90) #词语水平方向排版出现的频率,默认 0.9 (所以词语垂直方向排版出现频率为 0.1 )

mask : nd-array or None (default=None) #如果参数为空,则使用二维遮罩绘制词云。如果 mask 非空,设置的宽高值将被忽略,遮罩形状被 mask 取代。除全白(#FFFFFF)的部分将不会绘制,其余部分会用于绘制词云。如:bg_pic = imread('读取一张图片.png'),背景图片的画布一定要设置为白色(#FFFFFF),然后显示的形状为不是白色的其他颜色。可以用ps工具将自己要显示的形状复制到一个纯白色的画布上再保存,就ok了。

scale : float (default=1) #按照比例进行放大画布,如设置为1.5,则长和宽都是原来画布的1.5倍

min_font_size : int (default=4) #显示的最小的字体大小

font_step : int (default=1) #字体步长,如果步长大于1,会加快运算但是可能导致结果出现较大的误差

max_words : number (default=200) #要显示的词的最大个数

stopwords : set of strings or None #设置需要屏蔽的词,如果为空,则使用内置的STOPWORDS

background_color : color value (default=”black”) #背景颜色,如background_color='white',背景颜色为白色

max_font_size : int or None (default=None) #显示的最大的字体大小

mode : string (default=”RGB”) #当参数为“RGBA”并且background_color不为空时,背景为透明

relative_scaling : float (default=.5) #词频和字体大小的关联性

color_func : callable, default=None #生成新颜色的函数,如果为空,则使用 self.color_func

regexp : string or None (optional) #使用正则表达式分隔输入的文本

collocations : bool, default=True #是否包括两个词的搭配

colormap : string or matplotlib colormap, default=”viridis” #给每个单词随机分配颜色,若指定color_func,则忽略该方法

random_state : int or None #为每个单词返回一个PIL颜色

fit_words(frequencies) #根据词频生成词云

generate(text) #根据文本生成词云

generate_from_frequencies(frequencies[, ...]) #根据词频生成词云

generate_from_text(text) #根据文本生成词云

process_text(text) #将长文本分词并去除屏蔽词(此处指英语,中文分词还是需要自己用别的库先行实现,使用上面的 fit_words(frequencies) )

recolor([random_state, color_func, colormap]) #对现有输出重新着色。重新上色会比重新生成整个词云快很多

to_array() #转化为 numpy array

to_file(filename) #输出到文件

Python(wordcloud+jieba)生成中文词云图

# coding: utf-8

import jieba

from scipy.misc import imread # 这是一个处理图像的函数

from wordcloud import WordCloud, STOPWORDS, ImageColorGenerator

import matplotlib.pyplot as plt back_color = imread('o_002.jpg') # 解析该图片 wc = WordCloud(background_color='white', # 背景颜色

max_words=1000, # 最大词数

mask=back_color, # 以该参数值作图绘制词云,这个参数不为空时,width和height会被忽略

max_font_size=100, # 显示字体的最大值

stopwords=STOPWORDS.add('苟利国'), # 使用内置的屏蔽词,再添加'苟利国'

font_path="C:/Windows/Fonts/STFANGSO.ttf", # 解决显示口字型乱码问题,可进入C:/Windows/Fonts/目录更换字体

random_state=42, # 为每个词返回一个PIL颜色

# width=1000, # 图片的宽

# height=860 #图片的长

)

# WordCloud各含义参数请点击 wordcloud参数 # 添加自己的词库分词,比如添加'金三胖'到jieba词库后,当你处理的文本中含有金三胖这个词,

# 就会直接将'金三胖'当作一个词,而不会得到'金三'或'三胖'这样的词

jieba.add_word('金三胖') # 打开词源的文本文件

text = open('cnword.txt').read() # 该函数的作用就是把屏蔽词去掉,使用这个函数就不用在WordCloud参数中添加stopwords参数了

# 把你需要屏蔽的词全部放入一个stopwords文本文件里即可

def stop_words(texts):

words_list = []

word_generator = jieba.cut(texts, cut_all=False) # 返回的是一个迭代器

with open('stopwords.txt') as f:

str_text = f.read()

unicode_text = unicode(str_text, 'utf-8') # 把str格式转成unicode格式

f.close() # stopwords文本中词的格式是'一词一行'

for word in word_generator:

if word.strip() not in unicode_text:

words_list.append(word)

return ' '.join(words_list) # 注意是空格 text = stop_words(text) wc.generate(text)

# 基于彩色图像生成相应彩色

image_colors = ImageColorGenerator(back_color)

# 显示图片

plt.imshow(wc)

# 关闭坐标轴

plt.axis('off')

# 绘制词云

plt.figure()

plt.imshow(wc.recolor(color_func=image_colors))

plt.axis('off')

# 保存图片

wc.to_file('19th.png')

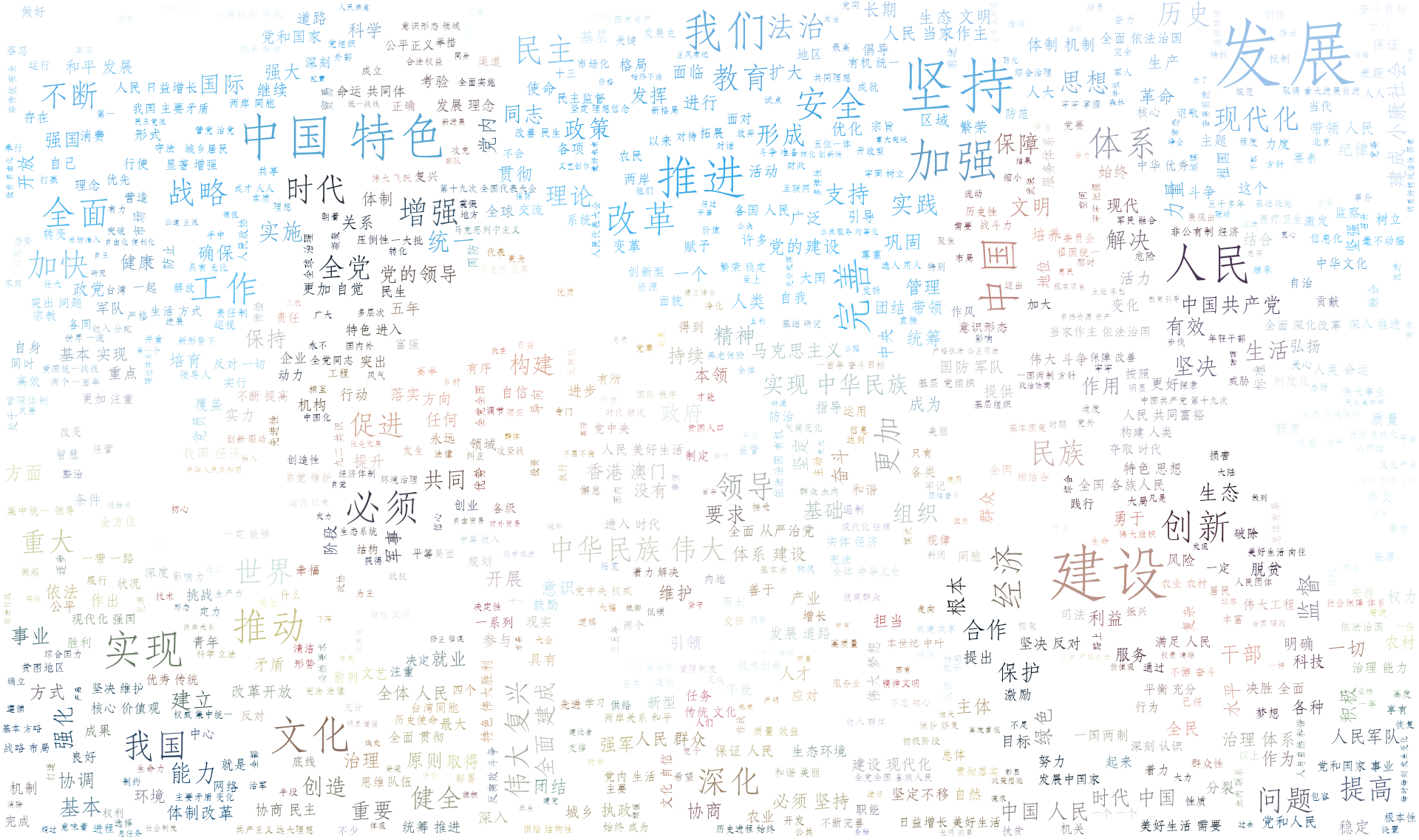

cnword.txt文本中的是十九大习大大讲话内容

stopwords.txt文本中有以下这几个词

社会主义

制度

国家

政治

背景颜色图

生成的词云图,与颜色图对应不是很明显,想明显的话可以使用一些色差大的图

wordcloud+jieba的更多相关文章

- 超详细:Python(wordcloud+jieba)生成中文词云图

# coding: utf-8 import jieba from scipy.misc import imread # 这是一个处理图像的函数 from wordcloud import WordC ...

- python 基于 wordcloud + jieba + matplotlib 生成词云

词云 词云是啥?词云突出一个数据可视化,酷炫.以前以为很复杂,不想python已经有成熟的工具来做词云.而我们要做的就是准备关键词数据,挑一款字体,挑一张模板图片,非常非常无脑.准备好了吗,快跟我一起 ...

- wordcloud + jieba 生成词云

利用jieba库和wordcloud生成中文词云. jieba库:中文分词第三方库 分词原理: 利用中文词库,确定汉字之间的关联概率,关联概率大的生成词组 三种分词模式: 1.精确模式:把文本精确的切 ...

- python的jieba分词

# 官方例程 # encoding=utf-8 import jieba seg_list = jieba.cut("我来到北京清华大学", cut_all=True) print ...

- WordCloud教程(上)

先贴代码: import wordcloud,jieba with open('datas/1.txt') as rt:#,encoding='utf-8' comment_text=rt.read( ...

- Python3 装逼神器---词云(wordcloud)

词云 (Word Cloud)是对文本中出现频率较高的词语给予视觉化展示的图形, 是一种常见的文本挖掘的方法. 实例: 依赖包: # pip3 install wordcloud jieba ...

- Python 词云分析周杰伦《晴天》

一.前言满天星辰的夜晚,他们相遇了...夏天的时候,她慢慢的接近他,关心他,为他付出一切:秋天的时候,两个人终於如愿的在一起,分享一切快乐的时光但终究是快乐时光短暂,因为杰伦必须出国深造,两人面临了要 ...

- python 爬取腾讯微博并生成词云

本文以延参法师的腾讯微博为例进行爬取并分析 ,话不多说 直接附上源代码.其中有比较详细的注释. 需要用到的包有 BeautifulSoup WordCloud jieba # coding:utf-8 ...

- 使用jieba库与wordcloud库第三方库进行词频统计

一.jieba库与wordcloud库的使用 1.jieba库与wordcloud库的介绍 jieba 库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过图结构和动态规划方法找到最 ...

随机推荐

- C实现一个NTP客户端,可以从指定IP的NTP服务器获取时间戳

参考::https://blog.csdn.net/dosthing/article/details/81588219 下面的代码测试通过 头文件 #include <sys/types.h&g ...

- javascript 问题

两个数组比较:a.sort().toString() == b.sort().toString() for循环内有异步方法时,需要闭包 JSON.parse(data)出错时(提示.[nodejs中] ...

- mySQl数据库中不能插入中文的处理办法

1. 修改MySQL安装目录下(C:\Program Files\MySQL\MySQL Server 5.5)的my.ini文件 设置: default-character-set=utf8 cha ...

- Spine输出资源一键入Unity3D工具代码

之前预研过2D骨骼动画编辑工具SPINE,感觉其比cocosStudio及Unity3D自带的骨骼动画编辑器(原生Sprite Tree或Uni2D)要更适合有3DSMax习惯的美术,即Spine更容 ...

- pl/sql 语言设置

1.select * from v$nls_parameters 查询nls的参数,获得数据库服务器端的字符编码 NLS_LANGUAGE NLS_CHARACTERSET 2.修改本地环境变量 NL ...

- SQL 数据库开发一些精典的代码(转自 咏南工作室)

1.按姓氏笔画排序: Select * From TableName Order By CustomerName Collate Chinese_PRC_Stroke_ci_as 2.数据库加密: s ...

- CSharp程序员学Android开发---3.Android内部元素不填充BUG

最近公司组织项目组成员开发一个Android项目的Demo,之前没有人有Andoid方面的开发经验,都是开发C#的. 虽说项目要求并不是很高,但是对于没有这方面经验的人来说,第一步是最困难的. 项目历 ...

- Python:Selenium+Webdriver安装

本人小白一枚,今天在使用selenium+webdriver的时候遇到了一个小问题: WebDriverException: 'chromedriver' executable needs to be ...

- Swagger 导出API

Swagger 导出API 这算是在博客园的第一篇博客吧,之后发的应该也会同步到博客园上. 此前的博客地址: https://blog.mytyiluo.cn Swagger简介 Swagger是一个 ...

- 终于,我们的新产品Fotor Slideshow Maker上线了!!

辛苦了大半年,使用纯网页技术全新打造的首个交互式Slideshow产品终于上线了,现在是 http://slideshow.fotor.com,希望能尽快推出中文版! http://blog.foto ...