虚拟机hadoop集群搭建

hadoop

tar -xvf hadoop-2.7.3.tar.gz

mv hadoop-2.7.3 hadoop

在hadoop根目录创建目录

hadoop/hdfs

hadoop/hdfs/tmp

hadoop/hdfs/name

hadoop/hdfs/data

core-site.xml

修改/etc/hadoop中的配置文件

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/hdfs/tmp</value>

<description>A base for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://sjck-node01:9000</value>

</property>

</configuration>

hdfs-site.xml

创建hdfs文件系统

dfs.replication维护副本数,默认是3个

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/hdfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>sjck-node01:9001</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.namenode.datanode.registration.ip-hostname-check</name>

<value>false</value>

</property>

</configuration>

mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>sjck-node01:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>sjck-node01:19888</value>

</property>

</configuration>

yarn-site.xml

webapp.address是web端口

yarn.resourcemanager.address,port for clients to submit jobs.

arn.resourcemanager.scheduler.address,port for ApplicationMasters to talk to Scheduler to obtain resources.

<property>

<name>yarn.resourcemanager.address</name>

<value>master:18040</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:18030</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:18088</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:18025</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:18141</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

slaves

sjck-node02

sjck-node03

hadoop-env.sh,配置里的变量为集群特有的值

export JAVA_HOME=/usr/local/src/jdk/jdk1.8

export HADOOP_NAMENODE_OPTS="-XX:+UseParallelGC"

yarn-env.sh

export JAVA_HOME=/usr/local/src/jdk/jdk1.8

环境变量

export HADOOP_HOME=/usr/local/hadoop

export PATH="$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH"

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

将目录复制到slaver

scp -r /usr/local/hadoop/ sjck-node02:/usr/local/

scp -r /usr/local/hadoop/ sjck-node03:/usr/local/

启动hadoop的命令都在master上执行,初始化hadoop

hadoop namenode -format

INFO common.Storage: Storage directory /usr/local/hadoop/hdfs/name has been successfully formatted.

master启动

Hadoop守护进程的日志默认写入到 ${HADOOP_HOME}/logs

[root@sjck-node01 sbin]# /usr/local/hadoop/sbin/start-all.sh

This script is Deprecated. Instead use start-dfs.sh and start-yarn.sh

Starting namenodes on [sjck-node01]

sjck-node01: starting namenode, logging to /usr/local/hadoop/logs/hadoop-root-namenode-sjck-node01.out

sjck-node02: starting datanode, logging to /usr/local/hadoop/logs/hadoop-root-datanode-sjck-node02.out

sjck-node03: starting datanode, logging to /usr/local/hadoop/logs/hadoop-root-datanode-sjck-node03.out

Starting secondary namenodes [sjck-node01]

sjck-node01: starting secondarynamenode, logging to /usr/local/hadoop/logs/hadoop-root-secondarynamenode-sjck-node01.out

starting yarn daemons

starting resourcemanager, logging to /usr/local/hadoop/logs/yarn-root-resourcemanager-sjck-node01.out

sjck-node02: starting nodemanager, logging to /usr/local/hadoop/logs/yarn-root-nodemanager-sjck-node02.out

sjck-node03: starting nodemanager, logging to /usr/local/hadoop/logs/yarn-root-nodemanager-sjck-node03.out

master关闭

[root@sjck-node01 sbin]# /usr/local/hadoop/sbin/stop-all.sh

This script is Deprecated. Instead use stop-dfs.sh and stop-yarn.sh

Stopping namenodes on [sjck-node01]

sjck-node01: stopping namenode

sjck-node02: stopping datanode

sjck-node03: stopping datanode

Stopping secondary namenodes [sjck-node01]

sjck-node01: stopping secondarynamenode

stopping yarn daemons

stopping resourcemanager

sjck-node02: stopping nodemanager

sjck-node03: stopping nodemanager

no proxyserver to stop

查看集群状态

Namenode

文件系统的管理节点,维护文件系统的目录结构元数据,还有文件与block对应关系

master是NameNode,也是JobTracker

DataNode

提供真实文件数据,slaver是DataNode,也是TaskTracker

查看master进程状态

[root@sjck-node01 hadoop]# jps

4404 SecondaryNameNode

4215 NameNode

4808 Jps

4555 ResourceManager

查看slaver进程状态

[root@sjck-node02 hadoop]# jps

2752 DataNode

4995 Jps

2839 NodeManager

[root@sjck-node03 hadoop]# jps

3076 DataNode

3163 NodeManager

3260 Jps

查看防火墙状态

service iptables status

关闭防火墙,开机不启动

service iptables stop

chkconfig --del iptables

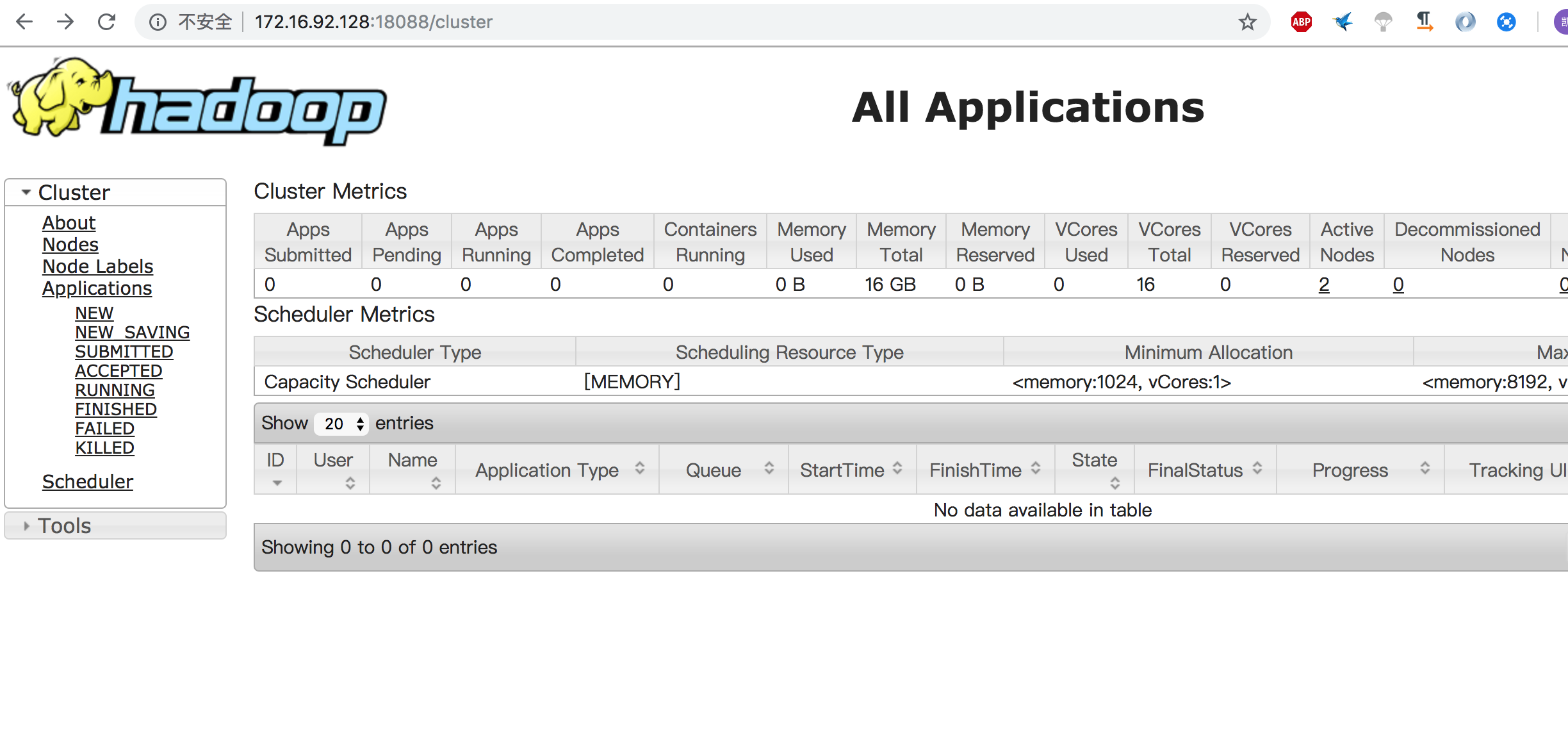

查看集群状态

http://172.16.92.128:18088/cluster

执行测试任务

hadoop jar /usr/local/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar pi 10 10

19/03/20 20:42:30 INFO mapreduce.Job: map 0% reduce 0%

19/03/20 20:42:51 INFO mapreduce.Job: map 20% reduce 0%

19/03/20 20:43:05 INFO mapreduce.Job: map 20% reduce 7%

19/03/20 20:45:43 INFO mapreduce.Job: map 40% reduce 7%

19/03/20 20:45:44 INFO mapreduce.Job: map 50% reduce 7%

19/03/20 20:45:47 INFO mapreduce.Job: map 60% reduce 7%

19/03/20 20:45:48 INFO mapreduce.Job: map 100% reduce 7%

19/03/20 20:45:49 INFO mapreduce.Job: map 100% reduce 33%

19/03/20 20:45:50 INFO mapreduce.Job: map 100% reduce 100%

Job Finished in 218.298 seconds

配置参数详情

[root@sjck-node01 hadoop]# jps

4404 SecondaryNameNode

4215 NameNode

4808 Jps

4555 ResourceManager

虚拟机hadoop集群搭建的更多相关文章

- Hadoop集群搭建(完全分布式版本) VMWARE虚拟机

Hadoop集群搭建(完全分布式版本) VMWARE虚拟机 一.准备工作 三台虚拟机:master.node1.node2 时间同步 ntpdate ntp.aliyun.com 调整时区 cp /u ...

- Hadoop集群搭建安装过程(一)(图文详解---尽情点击!!!)

Hadoop集群搭建(一)(上篇中讲到了Linux虚拟机的安装) 一.安装所需插件(以hadoop2.6.4为例,如果需要可以到官方网站进行下载:http://hadoop.apache.org) h ...

- Linux环境下Hadoop集群搭建

Linux环境下Hadoop集群搭建 前言: 最近来到了武汉大学,在这里开始了我的研究生生涯.昨天通过学长们的耐心培训,了解了Hadoop,Hdfs,Hive,Hbase,MangoDB等等相关的知识 ...

- Hadoop(二) HADOOP集群搭建

一.HADOOP集群搭建 1.集群简介 HADOOP集群具体来说包含两个集群:HDFS集群和YARN集群,两者逻辑上分离,但物理上常在一起 HDFS集群: 负责海量数据的存储,集群中的角色主要有 Na ...

- Hadoop学习之路(四)Hadoop集群搭建和简单应用

概念了解 主从结构:在一个集群中,会有部分节点充当主服务器的角色,其他服务器都是从服务器的角色,当前这种架构模式叫做主从结构. 主从结构分类: 1.一主多从 2.多主多从 Hadoop中的HDFS和Y ...

- 1.Hadoop集群搭建之Linux主机环境准备

Hadoop集群搭建之Linux主机环境 创建虚拟机包含1个主节点master,2个从节点slave1,slave2 虚拟机网络连接模式为host-only(非虚拟机环境可跳过) 集群规划如下表: 主 ...

- 三节点Hadoop集群搭建

1. 基础环境搭建 新建3个CentOS6.5操作系统的虚拟机,命名(可自定)为masternode.slavenode1和slavenode2.该过程参考上一篇博文CentOS6.5安装配置详解 2 ...

- 大数据初级笔记二:Hadoop入门之Hadoop集群搭建

Hadoop集群搭建 把环境全部准备好,包括编程环境. JDK安装 版本要求: 强烈建议使用64位的JDK版本,这样的优势在于JVM的能够访问到的最大内存就不受限制,基于后期可能会学习到Spark技术 ...

- 大数据学习——HADOOP集群搭建

4.1 HADOOP集群搭建 4.1.1集群简介 HADOOP集群具体来说包含两个集群:HDFS集群和YARN集群,两者逻辑上分离,但物理上常在一起 HDFS集群: 负责海量数据的存储,集群中的角色主 ...

随机推荐

- MongoDB - Introduction to MongoDB, Databases and Collections

MongoDB stores BSON documents, i.e. data records, in collections; the collections in databases. Data ...

- XML学习(1)

什么是XML? XML是可拓展标记语言,类似HTML,它的设计宗旨是为了传输数据,而不是像HTML那样显示数据.XML标签没有被预定义,需要用户自定义标签. xml文档必须包含根元素,它是其他所有元素 ...

- Redis实战(一)CentOS 7上搭建redis-3.0.2

1.安装redis wget http://download.redis.io/releases/redis-3.0.2.tar.gz tar zxvf redis-3.0.2.tar.gz cd ...

- linux配置网路 设定主机名 ssh bash命令 通配符

临时配置网络(ip,网关,dns) #ifconfig ens33 192.168.185/24 #ens33网卡名称.192.168.185/24是要配置的ip地址/子网掩码 #vim /etc/r ...

- HDU 1846 Brave Game 巴什博奕

解题报告:Alice和Bob在做一个取石子游戏,有一堆n个石子,然后规定每个人每次最少要去1个石子,最多可以取m个石子,最后一次取完石子的人为胜. 巴什博奕,关键是找到必胜点和必败点,我们可以先列举出 ...

- 线段树(dfs序建树加区间更新和单点查询)

题目链接:https://cn.vjudge.net/contest/66989#problem/J 记录一下这道折磨了我一天的题,.... 具体思路: 具体关系可通过dfs序建树,但是注意,在更新以 ...

- UNIX网络编程 第4章 基本TCP套接字编程

本章的几个函数在很大程度上展示了面向对象与面向过程的不同之处.

- XSS报警机制(前端防火墙:第二篇)

XSS报警机制(前端防火墙:第二篇) 在第一章结尾的时候我就已经说了,这一章将会更详细的介绍前端防火墙的报警机制及代码.在一章出来后,有人会问为什么不直接防御,而是不防御报警呢.很简单,因为防御的话, ...

- rollup&&cube

group by 擴展 rollup&&cube --按job分組計算不同job的匯總工資 SELECT job, SUM (sal) FROM emp GROUP BY ...

- java中并发Queue种类与各自API特点以及使用场景!

一 先说下队列 队列是一种数据结构.它有两个基本操作:在队列尾部加入一个元素,和从队列头部移除一个元素(注意不要弄混队列的头部和尾部) 就是说,队列以一种先进先出的方式管理数据,如果你试图向一个 已经 ...