elk安装与搭建

Elasticsearch安装配置

·下载elasticsearch.tar.gz包,解压压缩包。(此处为单机版es,集群请参考 https://www.cnblogs.com/lazycxy/p/9468074.html)

·创建ES用户和组(创建elsearch用户组及elsearch用户),因为使用root用户执行ES程序,将会出现错误;所以这里需要创建单独的用户去执行ES 文件;命令如下:

命令一:groupadd elsearch

命令二:useradd elsearch -g elsearch

命令三:chown -R elsearch:elsearch elasticsearch-5.6.3 //该命令是更改该文件夹下所属的用户组的权限

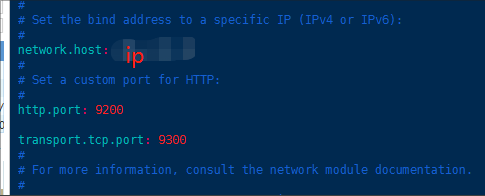

·修改ES的配置文件,使用cd命令进入到config 文件下,执行 vi elasticsearch.yml 命令

命令一:vi elasticsearch.yml

修改如图所示三处配置,保存退出。

·切换到elsearch用户,启动elasticsearch;命令如下:

命令一:su elsearch

命令二:./elasticsearch (执行 ./elasticesrarch -d 是后台运行)

错误一:

此时会提示 vm.max_map_count [65530] is too low 这个值设置的太小,需要修改vm.max_map_count这个变量的值,切换到root用户修改配置sysctl.conf 增加配置值: vm.max_map_count=655360 执行命令 sysctl -p 这样就可以了,然后切到elsearch用户,重新启动ES服务 就可以了

错误二:

代表进程不够用了

解决方案: 切到root 用户:进入到security目录下的limits.conf;执行命令 vim /etc/security/limits.conf 在文件的末尾添加下面的参数值:

* soft nofile 65536

* hard nofile 131072

* soft nproc 2048

* hard nproc 4096

前面的*符号必须带上,然后重新启动服务器即可。执行完成后可以使用命令 ulimit -n 查看进程数

最终切换到elsearch用户,启动es服务即可。

Kibana安装配置

在浏览器中输入ip:port查看是否启动成功,如图所示,单机elasticsearch启动成功

·下载Kibana.tar.gz包,解压压缩包。

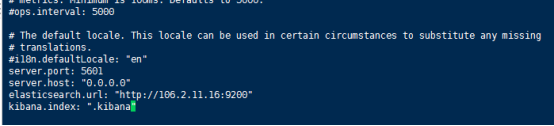

·修改kibana.yml配置文件

vim kibana.yml 编辑配置文件,在最后面加上如下配置就行:

server.port: 5601

server.host: "0.0.0.0"

elasticsearch.url: "http://ip:9200"

//这里ip:port要和es配置文件中填写的一致

kibana.index: ".kibana"

·启动完毕,可以浏览器输入url:服务器外网ip:5601 查看是否成功启动:· 启动服务:cd命令进入bin目录,执行sh kibana & 命令 后台启动kibana

logstash 安装配置

·下载logstash.tar.gz包,解压压缩包。

·进入bin目录,创建配置文件logstash1.conf

cd logstash-6.4.2/bin/进入bin目录

新建文件 vim logstash1.conf ,写入内容(监听tomcat的日志):

input {

file {

path => "tomcat应用目录/logs/*.log" //此处代表监控的日志文件

start_position => beginning

}

}

filter {

}

output {

elasticsearch {

hosts => "ip:9200"

}

}

启动logstash:sh logstash -f logstash1.conf

至此 elk的环境就安装好了,kibana怎么去统计分析日志,将在下一篇文章讲解

elk安装与搭建的更多相关文章

- spring mvc+ELK从头开始搭建日志平台

最近由于之前协助前公司做了点力所能及的事情,居然收到了一份贵重的端午礼物,是给我女儿的一个乐高积木,整个有7大包物件,我花了接近一天的时间一砖一瓦的组织起来,虽然很辛苦但是能够从过程中体验到乐趣.这次 ...

- ELK平台的搭建

ELK是指Elasticsearch + Logstash + Kibaba三个组件的组合.本文讲解一个基于日志文件的ELK平台的搭建过程,有关ELK的原理以及更多其他信息,会在接下来的文章中继续研究 ...

- ELK - MAC环境搭建

ELK - MAC环境搭建 本文旨在记录elasticsearch.logstash.kibana在mac下的安装与启动. 写在前面 ELK的官方文档对与它们的使用方法已经讲的非常清楚了,这里只对相关 ...

- [elk]停电日志离线恢复故障处理-elk环境极速搭建

es数据手动导入 周末停电了两天,发现两天的日志没导入: 原因: 1. elk开启没设启动 2.日志入库时间是当前时间,不是日志本身的time字段 - 导入步骤 1. 先把日志拖下来 2. 事先需要干 ...

- 搭建ELK日志分析平台(上)—— ELK介绍及搭建 Elasticsearch 分布式集群

笔记内容:搭建ELK日志分析平台(上)-- ELK介绍及搭建 Elasticsearch 分布式集群笔记日期:2018-03-02 27.1 ELK介绍 27.2 ELK安装准备工作 27.3 安装e ...

- ELK 安装Beat

章节 ELK 介绍 ELK 安装Elasticsearch ELK 安装Kibana ELK 安装Beat ELK 安装Logstash Beat是数据采集工具,安装在服务器上,将采集到的数据发送给E ...

- ELK扫盲及搭建

1. ELK部署说明 1.1ELK介绍: 1.1.1 ELK是什么? ELK是三个开源软件的缩写,分别表示:ElasticSearch , Logstash, Kibana , 它们都是开源软件,EL ...

- ELK+FileBeat+Log4Net搭建日志系统

ELK+FileBeat+Log4Net搭建日志系统 来源:https://www.zybuluo.com/muyanfeixiang/note/608470 标签(空格分隔): ELK Log4Ne ...

- ELK安装配置及nginx日志分析

一.ELK简介1.组成ELK是Elasticsearch.Logstash.Kibana三个开源软件的组合.在实时数据检索和分析场合,三者通常是配合使用,而且又都先后归于 Elastic.co 公司名 ...

随机推荐

- VUE动态(自动)Loading【绑定到URL】,同页面多个Loading互不冲突

需求来源:当使用React时,使用 umi loading 很方便,页面对http请求发生改变时,也会自动改变loading的相关状态(true/false) 对VUE插件进行找寻,发现没找到合适内容 ...

- Django自带的后台管理系统

1.准备工作: 1-1.创建django项目和应用 1-2.修改settings.py配置文件: #应用配置: INSTALLED_APPS = [ 'django.contrib.admin', ' ...

- python递归-三元表达式-列表生成式-字典生成式-匿名函数-部分内置函数-04

递归 递归: # 函数在调用阶段直接或间接地又调用了自身 应用场景: # 将列表中的数字依次打印出来(循环的层数是你必须要考虑的点) --> l = [1, [2, [3, [4, [5, ...

- 什么是icmp协议?

英文原义:Internet Control Message Protocol 中文释义:(RFC-792)Internet控制消息协议 定义: ICMP协议是一种面向无连接的协议,用于传输出 ...

- C#中的Contains与IndexOf的区别

C#中要判断一个字符串是否包含另一个字符串,常用的两种方法是 str.Contains和str.IndexOf 这两个方法的区别是: Contains是找指定字符串是否包含一个字串,返回值的bo ...

- 如何启用linux的路由转发功能

如何使用iptables的NAT功能把红帽企业版Linux作为一台路由器使用? 方法: 提示: 以下方法只适用于红帽企业版Linux 3 以上. 1.打开包转发功能: echo "1&quo ...

- Apache Ignite 学习笔记(6): Ignite中Entry Processor使用

之前的文章我们其实已经用到了两种不同的方式访问Ignite中的数据.一种方式是第一篇文章中提到通过JDBC客户端用SQL访问数据,在这篇文章中我们也会看到不使用JDBC,如何通过Ignite API用 ...

- python每个文件都需要顶部注释,那今天介绍一个方法,只需要设置一次,下次新建python文件后,注释自动出现在顶部的方法

python每个文件都需要顶部注释,那今天介绍一个方法,只需要设置一次,下次新建python文件后,注释自动出现在顶部的方法 只需要在file -----settings------file and ...

- vue history模式下出现空白页情况

问题描述: vue搭建的项目,路由一直用的hash模式,所以url中都会带有一个“#”号.现在想要去掉“#”,于是使用history模式 { mode: 'history' },代码如下: imp ...

- .NET Core on K8S学习实践系列文章索引(Draft版)

一.关于这个系列 自从去年(2018年)底离开工作了3年的M公司加入X公司之后,开始了ASP.NET Core的实践,包括微服务架构与容器化等等.我们的实践是渐进的,当我们的微服务数量到了一定值时,发 ...