python解析本地HTML文件

Python使用爬虫技术时,每运行一次,本地都会访问一次主机。为避免完成程序前调试时多次访问主机增加主机负荷,我们可以在编写程序前将网页源代码存在本地,调试时访问本地文件即可。现在我来分享一下爬取资料的调试过程。

一、将网页源代码存在本地

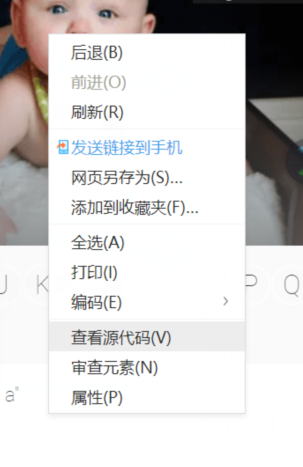

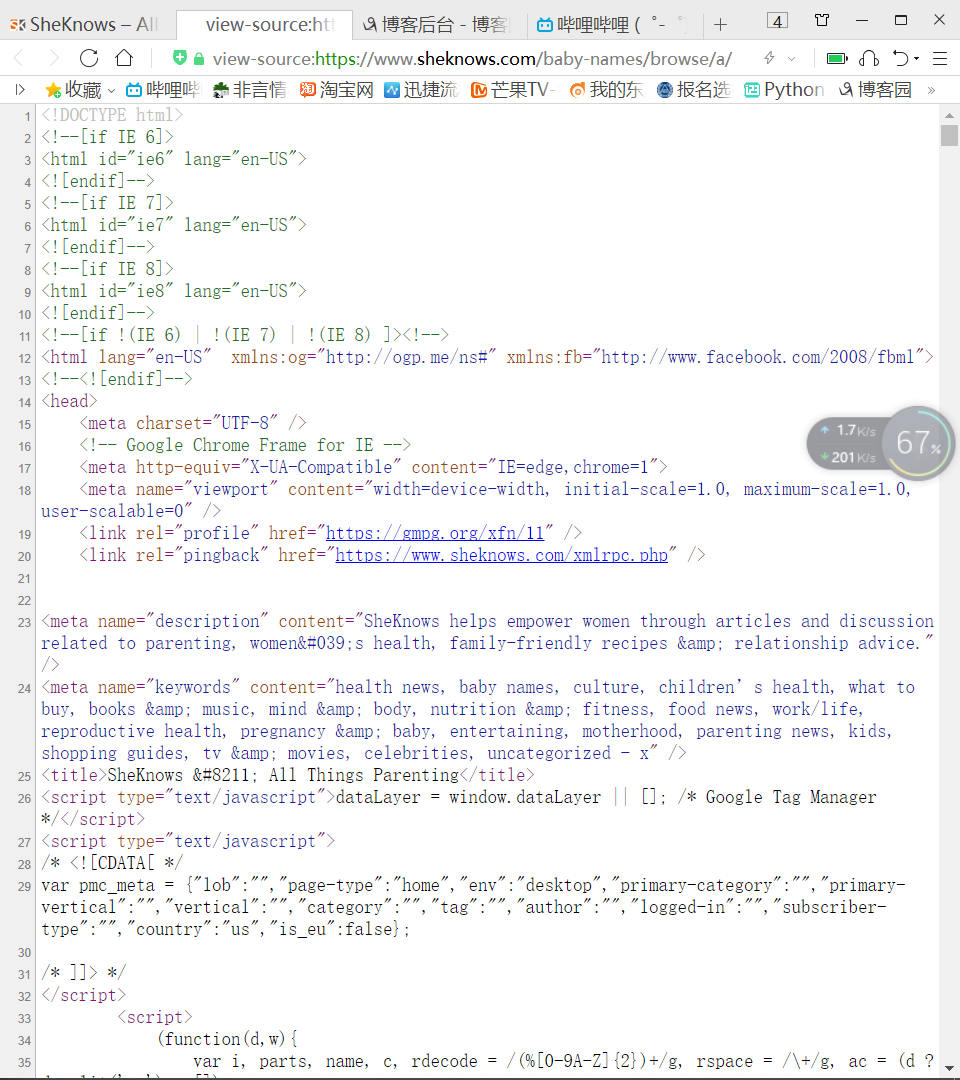

1、打开需要爬取的网页,鼠标右键查看源代码

2、复制源代码,将代码保存至本地项目文件目录下,文件后缀改为.html

二、在Python中打开本地html文件

打开并读取本地文件可使用BeautifulSoup方法直接打开

soup=BeautifulSoup(open('ss.html',encoding='utf-8'),features='html.parser') #features值可为lxml

解析后可以直接使用soup,与请求网页解析后的使用方法一致

三、使用本地文件爬取资料

1、先爬取主页的列表资料,其中同义内容使用“@”符号连接

def draw_base_list(doc):

lilist=soup.find('div',{'class':'babynames-term-articles'}).findAll('article');

#爬取一级参数

for x in lilist:

str1=''

count=0

a='@'

EnName=x.find('a').text;

Mean=x.find('div',{'class':'meaning'}).text;

Sou=x.find('div',{'class','related'}).findAll('a')

Link=x.find('a').get('href');

for x in Sou:

if count!=0:#添加计数器判断是否为第一个,不是则添加@

str1=str1+a

s=str(x) #将x转换为str类型来添加内容

str1=str1+s

count+=1

Source=str1

print(Source);

print(Meaning);

运行后发现Source和Meaning中包含了标签中的内容,我们使用正则表达式re.sub()方法删除str中指定内容。查看源代码可以发现标签内容只有一个链接,可以获取标签内的链接后再指定删除。

首先在for循环内给定一个值获取标签内的链接link=x.get('href'),接着使用sub方法指定删除link。代码如下:

link=x.get('href')

change2=re.sub(link,'',s)

运行后我们发现str中还存在标签名,在for循环中指定多余内容删除:

link=x.get('href')

s=str(x)

change1=re.sub('<a href="','',s)

change2=re.sub(link,'',change1)

change3=re.sub('">','',change2)

change4=re.sub(' Baby Names','',change3)

change5=re.sub('</a>','',change4)

change=re.sub(' ','',change5)

最后就能得到想要的信息。

2、再爬取详细信息

通过def draw_base_list(doc)函数向二级详情函数传递Link参数爬取详细信息,为避免频繁访问主机,我们同样将详情页的源代码保存至本地并解析。

def draw_detail_list():

str1=‘’

meta="boy"

doc=BeautifulSoup(open('nn.html',encoding='utf-8'),features='html.parser')

Des=doc.find('div',{'class':'single-babyname-wrapper'}).findAll('p')

Gen=doc.find('div',{'class':'entry-meta'}).find('a')

#print(Gen)

g=str(Gen)

for i in Gen:

if meta in g:

Gender="boy"

else:

Gender="girl"

#print(Gender)

for x in Des:

#print(x)

if x.find('a')==None: #该标签下有我们不需要的信息,查看源代码找到信息之间的联系,发现不需要的信息中都有链接

c=str(x)

change1=re.sub('<p>','',c) #与一级信息函数一样删除指定内容

change2=re.sub('</p>','',change1)

change3=re.sub('\t','',change2)

change=re.sub('\n','@',change3)

str1=str1+change

#Description=x.text

#print(Description)

Description=str1

#print(Description)

data={ #将数据存进字典中方便将数据保存至csv文件或数据库中

'EnName':EnName,

'CnName':'',

'Gender':Gender,

'Meaning':Meaning,

'Description':Description,

'Source':Source,

'Character':'', #网页中没有的信息数据列为空

'Celebrity':'',

'WishTag':''

}

#print(data)

3、将爬取下来的数据存入csv文件中

def draw_base_list(doc):

......

#爬取一级参数

for x in lilist:

......

for x in Sou:

......

......

draw_detail_list(Link,EnName,Meaning,Source) #将数据传给二级信息函数 def draw_detail_list(url,EnName,Meaning,Source):

......

for i in Gen:

...... for x in Des:

...... data={

......

}

write_dictionary_to_csv(data,'Names') #将字典传给存放数据函数,并给定csv文件名 def write_dictionary_to_csv(dict,filename):

file_name='{}.csv'.format(filename)

with open(file_name, 'a',encoding='utf-8') as f:

file_exists = os.path.isfile(filename)

w =csv.DictWriter(f, dict.keys(),delimiter=',', quotechar='"', lineterminator='\n',quoting=csv.QUOTE_ALL, skipinitialspace=True)

w.writerow(dict)

打开文件后发现没有文件头,为避免重复写入文件头,判断文件是否为空,若为空则写入文件头:

#防止每次循环重复写入列头

if os.path.getsize(file_name)==0 : #通过文件大小判断文件是否为空,为0说明是空文件

w.writeheader()

再次运行后文件头正常写入文件中。

4、访问主机,完成信息爬取

确定代码正确没有错误后就可以将打开本地文件的代码改成访问网页,最后完成数据的爬取。

python解析本地HTML文件的更多相关文章

- Python3+Requests-HTML+Requests-File解析本地html文件

一.说明 解析html文件我喜欢用xpath不喜欢用BeautifulSoup,Requests的作者出了Requests-HTML后一般都用Requests-HTML. 但是Requests-HTM ...

- 开发一个简单的chrome插件-解析本地markdown文件

准备软件环境 1. 软件环境 首先,需要使用到的软件和工具环境如下: 一个最新的chrome浏览器 编辑器vscode 2. 使用的js库 代码高亮库:prismjs https://prismjs. ...

- python基础——python解析yaml类型文件

一.yaml介绍 yaml全称Yet Another Markup Language(另一种标记语言).采用yaml作为配置文件,文件看起来直观.简洁.方便理解.yaml文件可以解析字典.列表和一些基 ...

- Python 读取本地*.txt文件 替换 内容 并保存

# r 以只读的方式打开文件,文件的描述符放在文件的开头# w 打开一个文件只用于写入,如果该文件已经存在会覆盖,如果不存在则创建新文件 #路径path = r"D:\pytho ...

- js 解析本地Excel文件!

通常,一般读取Excel都是由后台来处理,不过如果需求要前台来处理,也是可以的.. 1.需要用到js-xlsx,下载地址:js-xlsx 2.demo: <!DOCTYPE html>&l ...

- 如何解析本地和线上XML文件获取相应的内容

一.使用Dom解析本地XML 1.本地XML文件为:test.xml <?xml version="1.0" encoding="UTF-8"?> ...

- 用Python删除本地目录下某一时间点之前创建的所有文件

因为工作原因,需要定期清理某个文件夹下面创建时间超过1年的所有文件,所以今天集中学习了一下Python对于本地文件及文件夹的操作.网上 这篇文章 简明扼要地整理出最常见的os方法,抄袭如下: os.l ...

- python打开一个本地目录文件路径

os.path.abspath()os 模块为 python 语言标准库中的 os 模块包含普遍的操作系统功能.主要用于操作本地目录文件.path.abspath()方法用于获取当前路径下的文件. 比 ...

- Python解析HDF文件 分类: Python 2015-06-25 00:16 743人阅读 评论(0) 收藏

前段时间因为一个业务的需求需要解析一个HDF格式的文件.在这之前也不知道到底什么是HDF文件.百度百科的解释如下: HDF是用于存储和分发科学数据的一种自我描述.多对象文件格式.HDF是由美国国家超级 ...

随机推荐

- Kubernetes 学习12 kubernetes 存储卷

一.概述 1.我们此前讲过根据应用本身是否需要持久存储数据以及某一次请求和之前的请求是否有联系,可以分为四类应用 a.有状态,要存储 b.有状态,无持久存储 c.无状态,要存储 d.无状态,无持久存储 ...

- bzoj 3829: [Poi2014]FarmCraft 树形dp+贪心

题意: $mhy$ 住在一棵有 $n$ 个点的树的 $1$ 号结点上,每个结点上都有一个妹子. $mhy$ 从自己家出发,去给每一个妹子都送一台电脑,每个妹子拿到电脑后就会开始安装 $zhx$ 牌杀毒 ...

- 【MongoDB】在C#中使用

一.MongoClient类 在2.10.0版本中引入了MongoClient类,同时在其API中也说明了Mongo类会在将来的版本中被MongoClient替换(Note: This class h ...

- Linux安装配置JDK与卸载

最近在Linux系统部署门户,安装Oracle,导入dmp,JDK等等,遇到一大堆问题,解决后特有一番小小成就感,哇哈哈!在这里记录一下遇到问题: 官网下载JDK压缩包( .tar.gz ):http ...

- 创建一个简单tcp服务器需要的流程

1.socket创建一个套接字 2.bind绑定ip和port 3.listen使套接字变为可以被动链接 4.accept等待客户端的链接 5.recv/send接收发送数据

- Java 基础:继承中的执行顺序

1.单独的父类测试 Java中,new一个类的对象,类里面的静态代码块.非静态代码.无参构造方法.有参构造方法.类的一般方法等部分, 它们的执行顺序相对来说比较简单,用程序也很容易验证. 比如新建一个 ...

- dbutils的环境搭建以及使用

DBUtils的简单实现方式 第一步.创建Java工程[此处使用的是maven工程]并导入jar包 <!--导入mysql数据库驱动--> <dependency> <g ...

- cmake和json安装

一.cmake源码安装 官网下载源码:https://cmake.org/download/ 安装: ./bootstrap make make install cmake --version 二.j ...

- UE4虚幻引擎独立游戏制作教程 UE4编程教学 虚幻引擎4

非常好的一套UE4入门教学课程,语言诙谐幽默,并且是中文语音中文语音中文语音 赠送[精通Unreal引擎技术——关卡设计艺术]PDF版 目录 FLV格式,大小5G,中文语音 扫码时备注或说明中留下邮箱 ...

- scrapy 一些坑

scrapy爬虫出现Forbidden by robots.txt # Obey robots.txt rulesROBOTSTXT_OBEY = False scrapy定时执行抓取任务 用cron ...