Kafka在zookeeper中存储结构和查看方式

Zookeeper 主要用来跟踪Kafka 集群中的节点状态, 以及Kafka Topic, message 等等其他信息. 同时, Kafka 依赖于Zookeeper, 没有Zookeeper 是不能运行起来Kafka 的.

- Controller 选举:

- Controller 是一个特殊的Broker, 其负责所有Partition 的leader/follower 关系.

- Zookeeper 负责从Broker 中选举出一个作为Controller, 并确保其唯一性. 同时, 当Controller 宕机时, 选举一个新的.

- 集群 membership:

- 记录集群中都有哪些活跃着的Broker.

- Topic 配置:

- 有哪些Topic, Topic 都有哪些Partition, Replica 存放在哪里, Leader 是谁.

- 配额(0.9.0+):

- 记录每个客户能够读写的数据量.

- ACLs(0.9.0+):

- 记录对Topic 的读写控制.

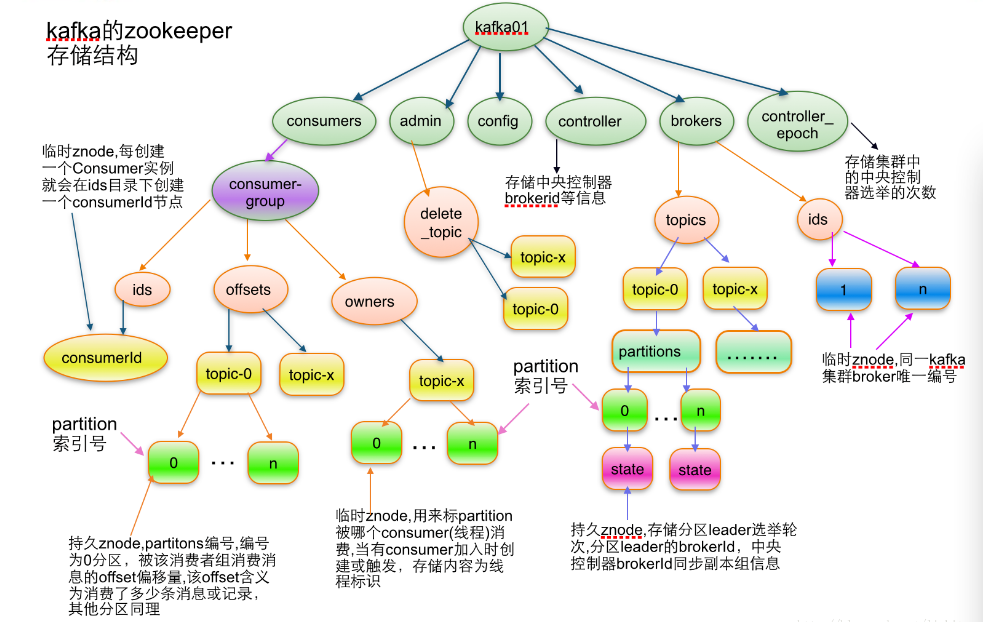

1、kafka的ZooKeeper存储结构

该图片盗自大牛的博客:http://blog.csdn.net/lizhitao/article/details/23744675

在ZK 的监视端, 运行ls / , 可以列出所有的顶级节点, 主要包含以下的节点:

- cluster.

- brokers.

- controller.

- consumer.

- config.

- isr_change_notification.

通过字面意思能够理解其记录的内容. 需要说明的是isr_change_notification 节点. 在Kafka 中, Leader 和Follower 的数据同步遵循的是"最终一致"原则, 也就是数据同步会有延迟, 但保证最终数据的一致性.

isr 是'in-sync' replicas 的缩写, 代表的是与Leader 数据已经通过过的replica, 它会作为重选Leader 时作为判断依据.

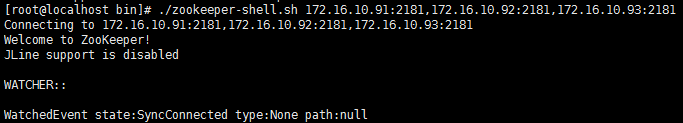

2、连接ZooKeeper

2.1 kafka自带zookeeper

进入kafka的bin目录,执行以下命令:

[root@localhost bin]# ./zookeeper-shell.sh 172.16.10.91:,172.16.10.92:,172.16.10.93:

2.2 独立安装zookeeper

服务端开启的情况下,进入客户端的命令:

{zookeeper目录}/bin/zkCli.sh

3、常用命令

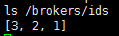

(1)查看数据:ls, ls2

【ls】会显示该节点下的子节点信息

例如:【ls /】:显示zookeeper根目录下的子节点

例如:【ls /brokers/ids】:显示集群中的Broker列表

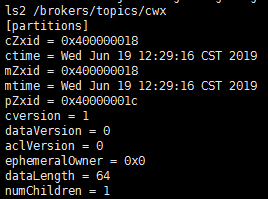

【ls2】命令会显示该节点的子节点信息和属性信息

例如:【ls2 /brokers/topics/cwx】:显示cwx主题的子节点信息和属性信息

(2)获取数据:get

get 命令会显示该节点的节点数据内容和属性信息

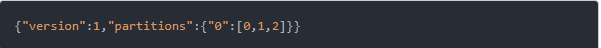

例如:【get /brokers/topics/topic-01】:可以获取topic-01 主题的值

可以看出, 该Topic 只有一个Partition

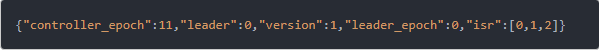

例如:【get /brokers/topics/topic-01/partitions/0/state】:获取Topic Partition 的信息

可以看出, 该Topic 有3个replica, 而且当前状态都是isr(也就是已处于最新状态). 同时, 当前的Leader 是Broker 0.

(3)获取数据:rmr

rmr 命令删除指定路径的节点

例如:【rmr /brokers/topics/test】:删除test主题

4、主要节点信息描述

4.1 topic注册信息

命令:/brokers/topics/[topic]

存储某个topic的partitions所有分配信息

Schema:

{

"version": "版本编号目前固定为数字1",

"partitions": {

"partitionId编号": [

同步副本组brokerId列表

],

"partitionId编号": [

同步副本组brokerId列表

],

.......

}

}

Example:

{

"version": ,

"partitions": {

"": [, ],

"": [, ],

"": [, ],

}

}

4.2 partition状态信息

命令:/brokers/topics/[topic]/partitions/[partitionId]/state

Schema:

{

"controller_epoch": 表示kafka集群中的中央控制器选举次数,

"leader": 表示该partition选举leader的brokerId,

"version": 版本编号默认为1,

"leader_epoch": 该partition leader选举次数,

"isr": [同步副本组brokerId列表]

}

Example:

{

"controller_epoch": ,

"leader": ,

"version": ,

"leader_epoch": ,

"isr": [, ]

}

4.3 Broker注册信息

命令:/brokers/ids/[0...N]

每个broker的配置文件中都需要指定一个数字类型的id(全局不可重复),此节点为临时znode(EPHEMERAL)

Schema:

{

"jmx_port": jmx端口号,

"timestamp": kafka broker初始启动时的时间戳,

"host": 主机名或ip地址,

"version": 版本编号默认为1,

"port": kafka broker的服务端端口号,由server.properties中参数port确定

}

Example:

{

"jmx_port": ,

"timestamp":""

"version": ,

"host": "192.168.1.148",

"port":

}

4.4 Controller epoch

命令:/controller_epoch -> int (epoch)

此值为一个数字,kafka集群中第一个broker第一次启动时为1,以后只要集群中center controller中央控制器所在broker变更或挂掉,就会重新选举新的center controller,每次center controller变更controller_epoch值就会 + 1;

4.5 Controller注册信息

命令:/controller -> int (broker id of the controller)

存储center controller中央控制器所在kafka broker的信息

Schema:

{

"version": 版本编号默认为1,

"brokerid": kafka集群中broker唯一编号,

"timestamp": kafka broker中央控制器变更时的时间戳

}

Example:

{

"version": ,

"brokerid": ,

"timestamp": ""

}

4.6 Consumer offset

命令:/consumers/[groupId]/offsets/[topic]/[partitionId] -> long (offset)

用来跟踪每个consumer目前所消费的partition中最大的offset,此znode为持久节点,可以看出offset跟group_id有关,以表明当消费者组(consumer group)中一个消费者失效,重新触发balance,其他consumer可以继续消费。

4.7 删除topics

命令:/admin/delete_topics

Schema:

{ "fields":

[ {"name": "version", "type": "int", "doc": "version id"},

{"name": "topics",

"type": { "type": "array", "items": "string", "doc": "an array of topics to be deleted"}

} ]

}

例子:

{

"version": ,

"topics": ["foo", "bar"]

}

4.8 Topic配置

命令:/config/topics/[topic_name]

{

"version": ,

"config": {

"config.a": "x",

"config.b": "y",

...

}

}

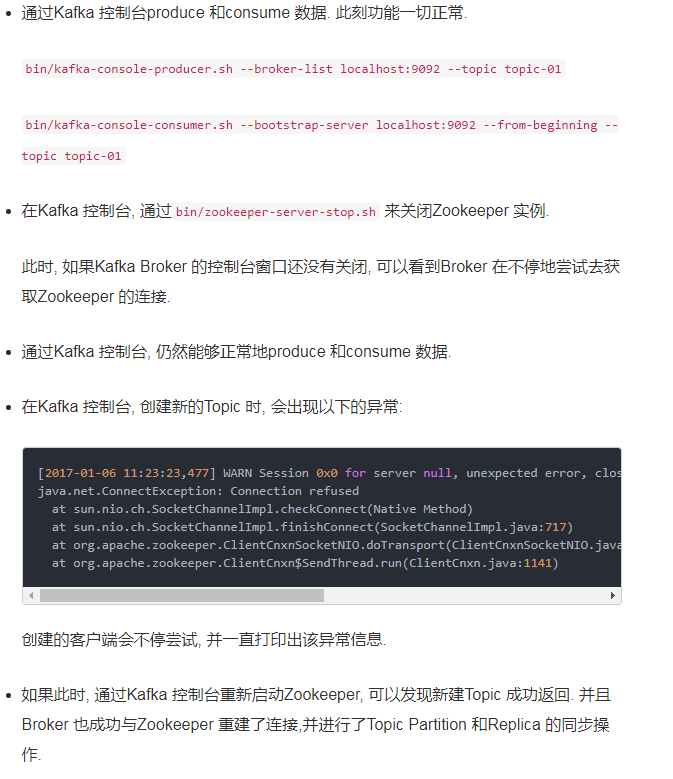

5、关闭Leader

6、关闭Zookeeper

7、特别注意事项

离开了Zookeeper, Kafka 不能对Topic 进行新增操作, 但是仍然可以produce 和consume 消息.

PS: 在运行过程中, 如果先关闭掉了Zookeeper, 然后再去关闭Kafka, 会发现Kafka 后台一直结束不掉, 这是因为Kafka 会被block 在与Zookeeper 的重连过程中. 解决方法是重启Zookeeper , 然后先关闭Kafka 再关闭Zookeeper.

----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

补充参考:

1、命令行工具的一些简单操作如下:

1. 显示根目录下、文件: ls / 使用 ls 命令来查看当前 ZooKeeper 中所包含的内容

2. 显示根目录下、文件: ls2 / 查看当前节点数据并能看到更新次数等数据

3. 创建文件,并设置初始内容: create /zk "test" 创建一个新的 znode节点“ zk ”以及与它关联的字符串

4. 获取文件内容: get /zk 确认 znode 是否包含我们所创建的字符串

5. 修改文件内容: set /zk "zkbak" 对 zk 所关联的字符串进行设置

6. 删除文件: delete /zk 将刚才创建的 znode 删除

7. 退出客户端: quit

8. 帮助命令: help

2、ZooKeeper 常用四字命令:

ZooKeeper 支持某些特定的四字命令字母与其的交互。它们大多是查询命令,用来获取 ZooKeeper 服务的当前状态及相关信息。用户在客户端可以通过 telnet 或 nc 向 ZooKeeper 提交相应的命令

1. 可以通过命令:echo stat|nc 127.0.0.1 2181 来查看哪个节点被选择作为follower或者leader

2. 使用echo ruok|nc 127.0.0.1 2181 测试是否启动了该Server,若回复imok表示已经启动。

3. echo dump| nc 127.0.0.1 2181 ,列出未经处理的会话和临时节点。

4. echo kill | nc 127.0.0.1 2181 ,关掉server

5. echo conf | nc 127.0.0.1 2181 ,输出相关服务配置的详细信息。

6. echo cons | nc 127.0.0.1 2181 ,列出所有连接到服务器的客户端的完全的连接 / 会话的详细信息。

7. echo envi |nc 127.0.0.1 2181 ,输出关于服务环境的详细信息(区别于 conf 命令)。

8. echo reqs | nc 127.0.0.1 2181 ,列出未经处理的请求。

9. echo wchs | nc 127.0.0.1 2181 ,列出服务器 watch 的详细信息。

10. echo wchc | nc 127.0.0.1 2181 ,通过 session 列出服务器 watch 的详细信息,它的输出是一个与 watch 相关的会话的列表。

11. echo wchp | nc 127.0.0.1 2181 ,通过路径列出服务器 watch 的详细信息。它输出一个与 session 相关的路径。

参考:

http://blog.csdn.net/lizhitao/article/details/23744675

Kafka在zookeeper中存储结构和查看方式的更多相关文章

- kafka在zookeeper中存储结构

1.topic注册信息 /brokers/topics/[topic] : 存储某个topic的partitions所有分配信息 Schema: { "version": ...

- apache kafka系列之在zookeeper中存储结构

1.topic注册信息 /brokers/topics/[topic] : 存储某个topic的partitions所有分配信息 Schema: { "version": ...

- kafka笔记-Kafka在zookeeper中的存储结构【转】

参考链接:apache kafka系列之在zookeeper中存储结构 http://blog.csdn.net/lizhitao/article/details/23744675 1.topic注 ...

- Kafka学习之路 (五)Kafka在zookeeper中的存储

一.Kafka在zookeeper中存储结构图 二.分析 2.1 topic注册信息 /brokers/topics/[topic] : 存储某个topic的partitions所有分配信息 [zk: ...

- Kafka(四)Kafka在zookeeper中的存储

一 Kafka在zookeeper中存储结构图 二 分析 2.1 topic注册信息 /brokers/topics/[topic] : 存储某个topic的partitions所有分配信息 [zk: ...

- 使用kafka bin目录中的zookeeper-shell.sh来查看kafka在zookeeper中的配置

cd kafka_2.11-0.10.2.1\bin\windowsecho ls /brokers/ids | zookeeper-shell.bat localhost:2181 使用kafka ...

- kafka在zookeeper中的存储结构

参考site:http://kafka.apache.org/documentation.html#impl_zookeeper 1.zookeeper客户端相关命令 在确保zookeeper服务启动 ...

- Kafka+SparkStreaming+Zookeeper(ZK存储Offset,解决checkpoint问题)

创建一个topic ./kafka-topics.sh --create --zookeeper 192.168.1.244:2181,192.168.1.245:2181,192.168.1.246 ...

- kafka之zookeeper 节点

1.zookeeper 节点 kafka 在 zookeeper 中的存储结构如下图所示:

随机推荐

- 虚拟机网络设置(NAT模式)

虚拟机网络设置(NAT模式) linux 1. 设置虚拟机网络 1.1. NAT子网设置 1.2. 网卡配置文件设置 1.3. 重启网络服务 1.4. 配置端口转发 2. 配置网络共享 预期想要搭建本 ...

- mysql考生号后三位对出密号

select mihao,substring(t1.kaohao, -3) from t_zhaosheng_zhiyuan as t1 where substring(t1.kaohao, -3) ...

- Flume架构以及应用介绍(转)

在具体介绍本文内容之前,先给大家看一下Hadoop业务的整体开发流程: 从Hadoop的业务开发流程图中可以看出,在大数据的业务处理过程中,对于数据的采集是十分重要的一步,也是不可避免的一步,从而引出 ...

- 微信小程序——<scroll-view>滚动到最底部

最近在做个直播间,有个这样的需要,就是进入到页面,<scroll-view>需要滚动到最底部,并且发送消息之后自动的滚动到底部. 开始想着计算里面内容的高度,然后通过设置 scroll-t ...

- MySQL 内连接、外连接、左连接、右连接、全连接……太多了

用两个表(a_table.b_table),关联字段a_table.a_id和b_table.b_id来演示一下MySQL的内连接.外连接( 左(外)连接.右(外)连接.全(外)连接). 主题:内连接 ...

- canvas做动画

一.绘制图片 ①加载图片 <!DOCTYPE html> <html lang="en"> <head> <meta charset=&q ...

- tensorflow手写数字识别(有注释)

import tensorflow as tf import numpy as np # const = tf.constant(2.0, name='const') # b = tf.placeho ...

- string拼接时去掉最后一个逗号

str.replace(str.length() - 1, str.length(), "");

- 安卓入门教程(十四)-菜单,ActionBar,对话框

已经发表个人公众号 菜单类型 选项菜单(OptionMenu) 子菜单(SubMenu) 上下文菜单(ContextMenu) 方法: public boolean onCreateOptionsMe ...

- php在Linux下的相对路径问题

如图所示,我在 /root/phpcode/ 下面有两个php文件. a.php 与 b.php,我用 a.php 去 require b.php ,然后 b.php 输出 1. 现在我在 /root ...