scrapy处理post请求的传参和日志等级

一.Scrapy的日志等级

- 在使用scrapy crawl spiderFileName运行程序时,在终端里打印输出的就是scrapy的日志信息。

- 日志信息的种类:

ERROR : 一般错误 WARNING : 警告 INFO : 一般的信息 DEBUG : 调试信息

- 设置日志信息指定输出:

在settings.py配置文件中,加入

LOG_LEVEL = ‘指定日志信息种类’即可。

LOG_FILE = 'log.txt'则表示将日志信息写入到指定文件中进行存储。

二.请求传参

- 在某些情况下,我们爬取的数据不在同一个页面中,例如,我们爬取一个电影网站,电影的名称,评分在一级页面,而要爬取的其他电影详情在其二级子页面中。这时我们就需要用到请求传参。

处理post请求的参数:

创建项目:

代码:

import scrapy class PostSpider(scrapy.Spider):

name = 'post'

# allowed_domains = ['www.xxx.com']

start_urls = ['https://fanyi.baidu.com/sug'] def start_requests(self):

data = {

'kw':'dog'

}

for url in self.start_urls:

yield scrapy.FormRequest(url=url,formdata=data,callback=self.parse) def parse(self, response):

print(response.text)

settings.py

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36'

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

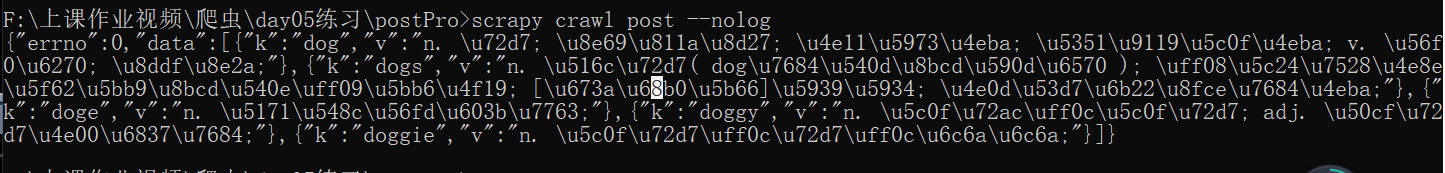

查看请求的数据:

案例二:

# -*- coding: utf-8 -*-

import scrapy

from moviePro.items import MovieproItem class MovieSpider(scrapy.Spider):

name = 'movie'

# allowed_domains = ['www.xxx.com']

start_urls = ['https://www.4567tv.tv/frim/index1.html']

#解析详情页中的数据

def parse_detail(self,response):

#response.meta返回接收到的meta字典

item = response.meta['item']

actor = response.xpath('/html/body/div[1]/div/div/div/div[2]/p[3]/a/text()').extract_first()

item['actor'] = actor yield item def parse(self, response):

li_list = response.xpath('//li[@class="col-md-6 col-sm-4 col-xs-3"]')

for li in li_list:

item = MovieproItem()

name = li.xpath('./div/a/@title').extract_first()

detail_url = 'https://www.4567tv.tv'+li.xpath('./div/a/@href').extract_first()

item['name'] = name

#meta参数:请求传参.meta字典就会传递给回调函数的response参数

yield scrapy.Request(url=detail_url,callback=self.parse_detail,meta={'item':item})

settings.py

LOG_LEVEL = "ERROE"

LOG_FILE = './log.txt' #输出日志

items.py

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html import scrapy class MoveproItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

name = scrapy.Field()

actor = scrapy.Field()

scrapy处理post请求的传参和日志等级的更多相关文章

- SpringBoot 2.x (2):请求和传参

其实请求和传参这些知识属于SpringMVC 不过这也属于必须掌握的知识,巩固基础吧 GET请求: 以第一篇文章自动的方式创建SpringBoot项目: 然后新建Controller: package ...

- vue 使用 axios 时 post 请求方法传参无法发送至后台

axios 时 post 请求方法传参无法发送至后台报错如下 Response to preflight request doesn't pass access control check: No ' ...

- http请求与传参

这并不算是文章,暂时只做粗略地记录,以免忘记,因此会显得杂乱无章,随便抓了几个包和对postman截图,日后有空再完善 1.get方式 只有一种方式,那就是在url后面跟参数 2.post方式 1)表 ...

- vue axios传参报错的解决方法

今天有人问同一套后台系统为什么jquery可以正常使用,axios却报错呢,下面总结如下: 总的来说是jquery和axios传参类型不同,那为什么jquery和axios请求时传参类型不同? 1)j ...

- SpringMVC前后端分离交互传参详细教程

温故而知新,本文为一时兴起写出,如有错误还请指正 本文后台基于SpringBoot2.5.6编写,前端基于Vue2 + axios和微信小程序JS版分别编写进行联调测试,用于理解前后端分离式开发的交互 ...

- 13.scrapy框架的日志等级和请求传参

今日概要 日志等级 请求传参 如何提高scrapy的爬取效率 今日详情 一.Scrapy的日志等级 - 在使用scrapy crawl spiderFileName运行程序时,在终端里打印输出的就是s ...

- scrapy框架的日志等级和请求传参

日志等级 请求传参 如何提高scrapy的爬取效率 一.Scrapy的日志等级 - 在使用scrapy crawl spiderFileName运行程序时,在终端里打印输出的就是scrapy的日志信息 ...

- scrapy框架之日志等级和请求传参-cookie-代理

一.Scrapy的日志等级 - 在使用scrapy crawl spiderFileName运行程序时,在终端里打印输出的就是scrapy的日志信息. - 日志信息的种类: ERROR : 一般错误 ...

- Scrapy的日志等级和请求传参

日志等级 日志信息: 使用命令:scrapy crawl 爬虫文件 运行程序时,在终端输出的就是日志信息: 日志信息的种类: ERROR:一般错误: WARNING:警告: INFO:一般的信息: ...

随机推荐

- vim字体设置

经过多方试验,在win下设置vim的大小终于成功了,备份如下, 现在把gvim7.1更改字体的方法记录如下,一段时间后,可能会失效,对他人造成困扰吧?!^_^ 在_vimrc中写:set guif ...

- 阶段3 1.Mybatis_01.Mybatis课程介绍及环境搭建_02.三层架构和ssm框架的对应关系

- 【Linux 应用编程】进程管理 - 进程间通信IPC之管道 pipe 和 FIFO

IPC(InterProcess Communication,进程间通信)是进程中的重要概念.Linux 进程之间常用的通信方式有: 文件:简单,低效,需要代码控制同步 管道:使用简单,默认阻塞 匿名 ...

- node-webkit-updater——NW.js自动更新

NW.js自动更新三种方案: 1)node-webkit-updater(推荐) 2)nwjs-autoupdater 3)nw-autoupdater NW.js自动更新三种方案:[http://d ...

- VBA计算器的全部实现

我们将加入 除零逻辑 和 对话框提示. 后面 就很简单了~~~ 提供效果图跟 代码 代码示例 Sub 矩形1_Click() ' ' 矩形1_Click Macro ' 代码编辑 Dim number ...

- [LeetCode] 1092. Shortest Common Supersequence

LeetCode刷题记录 传送门 Description Given two strings str1 and str2, return the shortest string that has bo ...

- Java实验3与第五周总结

1.已知字符串:"this is a test of java".按要求执行以下操作:(要求源代码.结果截图.) •统计该字符串中字母s出现的次数. •统计该字符串中子串" ...

- mysql 恢复数据时中文乱码

mysql恢复数据时中文乱码,解决办法. 用source命令导入mysql数据库怎么设置中文编码 1.导出数据时指定编码在导出mysql sql执行文件的时候,指定一下编码格式: mysqldump ...

- Luogu P5444 [APIO2019]奇怪装置

题目 这种题目看上去就是有循环节的对吧. 在考场上,一个可行的方式是打表. 现在我们手推一下这个循环节. 记函数\(f(t)=(((t+\lfloor\frac tB\rfloor)\%A),(t\% ...

- Luogu P1315 [NOIP2012]观光公交

题目 每次把加速器用在可以是答案减少最多的地方就即可.(这不是废话吗?) 具体而言,我们处理出: \(sum_i\)到\(i\)为止下车人数之和. \(t_i\)在\(i\)最晚的上车的人的上车时间. ...