EM算法及其推广

概述

EM算法是一种迭代算法,用于含有隐变量(hidden variable)的概率模型参数的极大似然估计,或极大后验概率估计。

EM算法的每次迭代由两步组成:E步,求期望(expectation);M步,求极大( maximization ),所以这一算法称为期望极大算法(expectation maximization algorithm),简称EM算法。

EM算法的引入

一般地,用Y表示观测随机变量的数据,Z表示隐随机变量的数据。Y和Z连在一起称为完全数据( complete-data ),观测数据Y又称为不完全数据(incomplete-data)。

假设给定观测数据Y,其概率分布是P(Y | theta),其中theta是需要估计的模型参数,那么不完全数据Y的似然函数是P(Y | theta),对数似然函数L(theta)=logP(Y | theta);假设Y和Z的联合概率分布是P(Y, Z),那么完全数据的对数似然函数是log P(Y, Z | theta)。

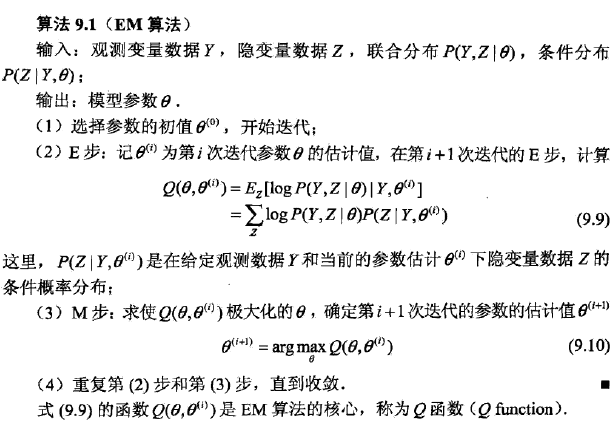

1、EM算法定义

2、Q函数定义

完全数据的对数似然函数log P(Y, Z | theta)关于在给定观测数据Y和当前参数theta(i)下对未观测数据Z的条件概率分布P(Z | Y,theta(i))的期望称为Q函数,即

3、EM算法说明

步骤(1) 参数的初值可以任意选择。但需注意EM算法对初值是敏感的。

步骤(2) E步求Q(theta, theta(i))。Q函数式中Z是未观测数据,Y是观测数据。注意,Q(theta, theta(i))的第1个变量theta表示要极大化的参数,第2个变量theta(i)表示参数的当前估计值。每次迭代实际在求Q函数及其极大。

步骤(3) M步求Q(theta, theta(i))的极大化,得到theta(i+1),完成一次迭代theta(i)更新至theta(i+1)。后面将证明每次迭代使似然函数增大或达到局部极值。

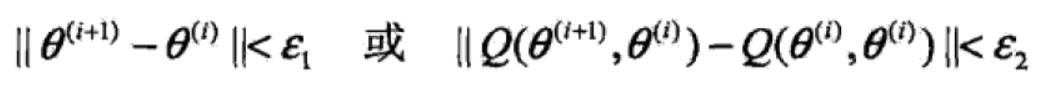

步骤(4) 给出停止迭代的条件,一般是对较小的正数,若满足 则停止迭代.

则停止迭代.

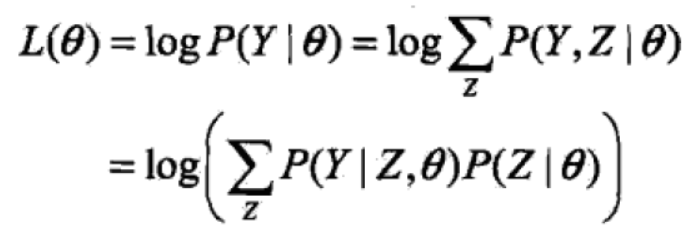

4、EM算法导出

通过近似求解观测数据的对数似然函数的极大化问题来导出EM算法,由此可以清楚地看出EM算法的作用。面对一个含有隐变量的概率模型,目标是极大化观测数据(不完全数据)Y关于参数theta的对数似然函数,即极大化:

这一极大化的主要困难是式中有未观测数据并有包含和(或积分)的对数。

(1)每次迭代需要满足:新估计值 theta能使L(theta)增加,并逐步达到极大值。i次迭代前后的差值为:

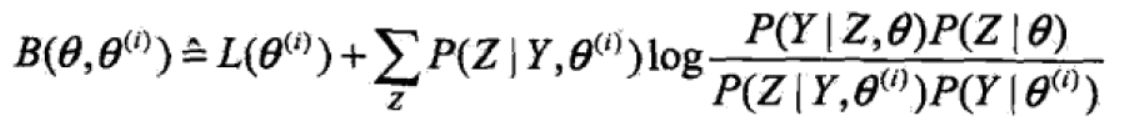

(2)利用jensen不等式可以得出下界:

令

则 且有

且有

(3)选择theta(i+1)使B极大:

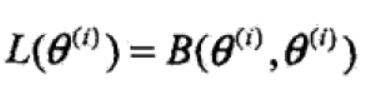

EM算法是通过不断求解下界的极大化逼近求解对数似然函数极大化的算法,简单图示如下:

(有其他的推导方式,见博客http://www.cnblogs.com/bigmoyan/p/4550375.html还有https://www.cnblogs.com/pinard/p/6912636.html)

5、EM算法在非监督学习中的应用

训练数据只有输入没有对应的输出(X,?),从这样的数据学习模型称为非监督学习问题。EM算法可以用于生成模型的非监督学习,生成模型由联合概率分布P(X, Y)表示,可以认为非监督学习训练数据是联合概率分布产生的数据。X为观测数据,Y为未观测数据。

EM算法的收敛性

定理9.1 设P(Y | theta)为观测数据的似然函数,theta(i) (i=1, 2,...)为EM算法得到的参数估计序列,P(Y | theta(i) )(i=1, 2,...))为对应的似然函数序列,则P(Y | theta(i) )是单调递增的,即

定理9.2 设P(Y | theta)为观测数据的似然函数,theta(i) (i=1, 2,...)为EM算法得到的参数估计序列,L(theta(i))=P(Y | theta(i) )(i=1, 2,...))为对应的似然函数序列,

(1)如果P(Y | theta)有上界,则L(theta(i))收敛到某一值L*;

(2)在函数Q与L满足一定条件下,由EM算法得到的参数估计序列theta(i)的收敛值theta*是L(theta)的稳定点。

EM算法的收敛性包含关于对数似然函数序列L的收敛性和关于参数估计序列theta的收敛性两层意思,前者并不蕴涵后者。

此外,定理只能保证参数估计序列收敛到对数似然函数序列的稳定点,不能保证收敛到极大值点。所以在应用中,初值的选择变得非常重要,常用的办法是选取几个不同的初值进行迭代,然后对得到的各个估计值加以比较,从中选择最好的。

EM算法在高斯混合模型学习中的应用

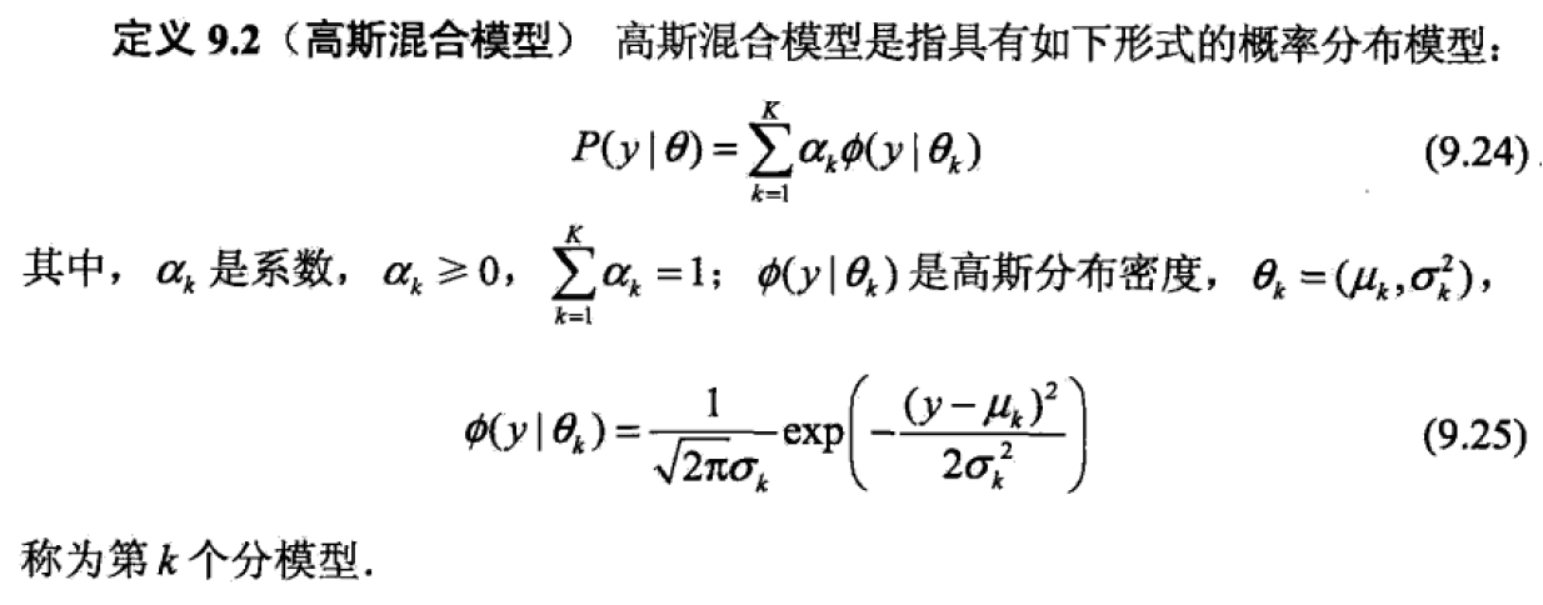

1、高斯混合模型

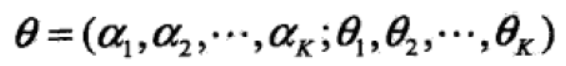

2、推导

假设观测数据由高斯混合模型生成, ,

,

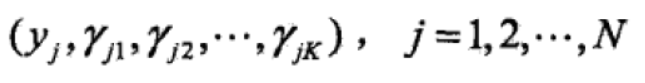

(1)明确隐变量。写出完全数据的对数似然函数

完全数据的似然函数为:

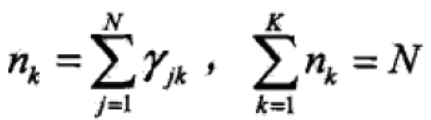

其中,

其中,

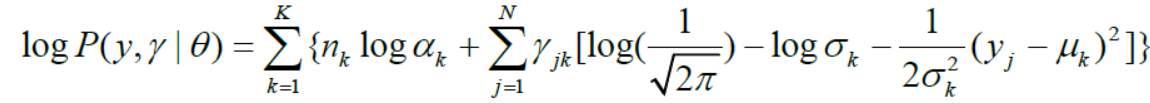

对数似然函数为:

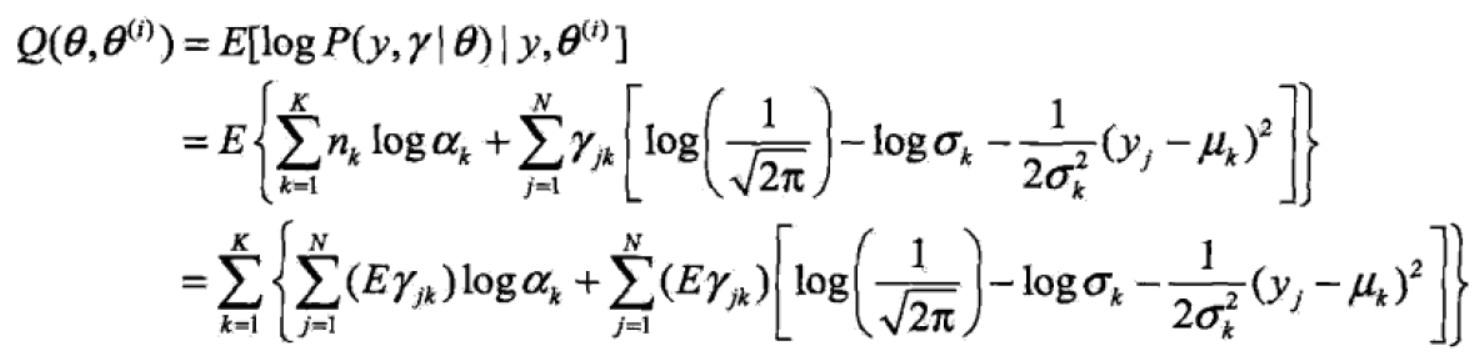

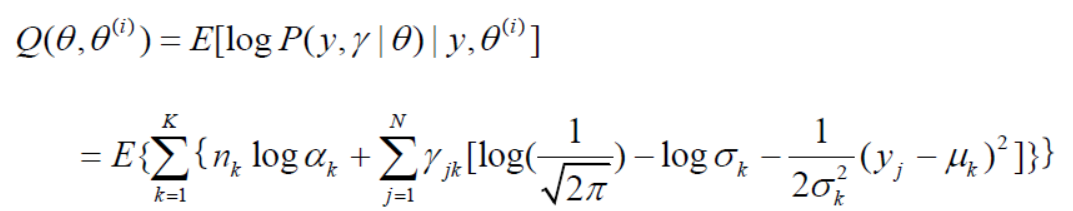

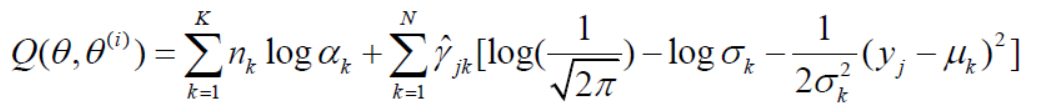

(2)EM算法的E步:确定Q函数

注意:第二行改错:

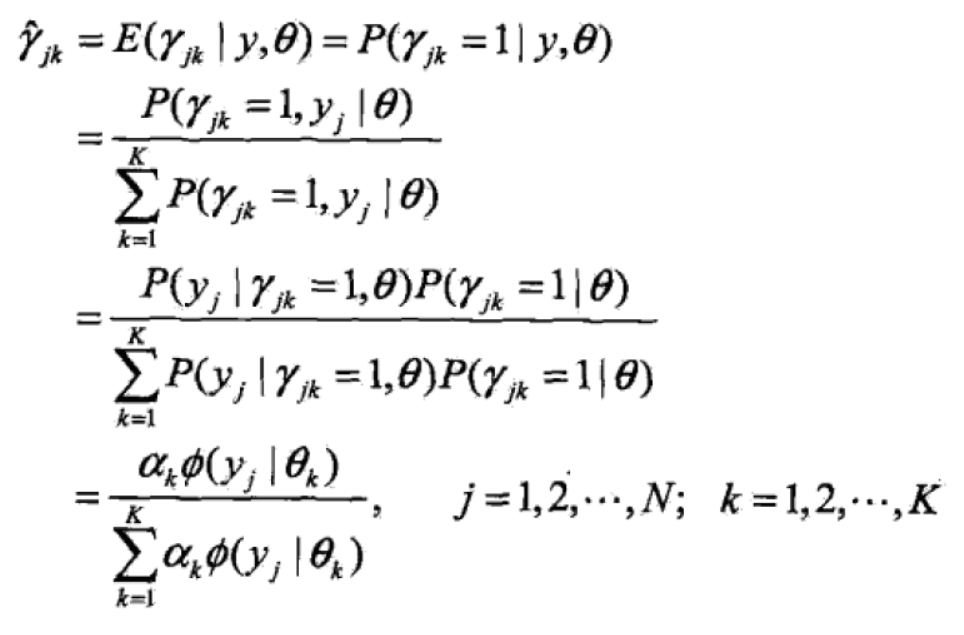

式中的那个期望计算如下:

这个期望是在当前模型参数下第j个观测数据来自第k个分模型的概率,称为分模型k对观测数据yj的响应度。

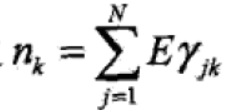

将 和

和 代回原式得:

代回原式得:

(3)确定EM算法的M步

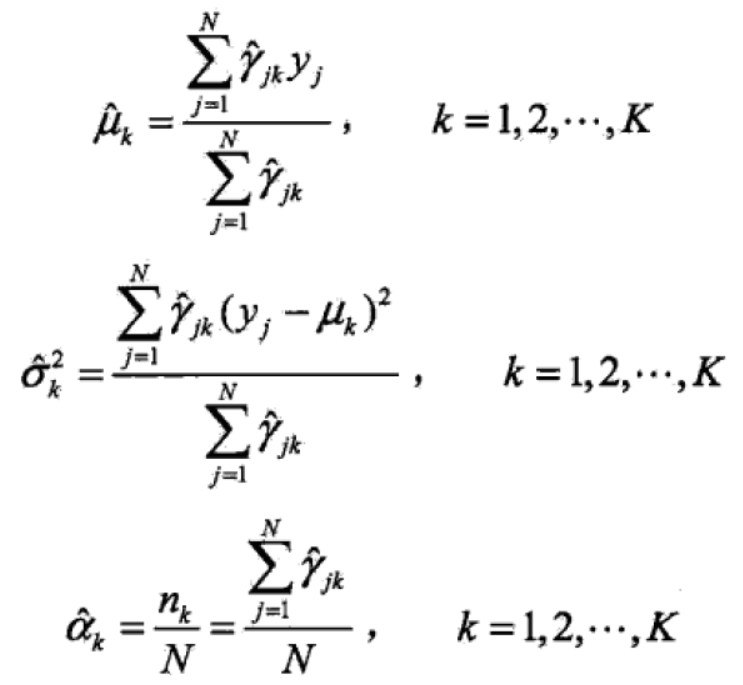

迭代的M步是求函数Q对theta的极大值,即求新一轮迭代的模型参数:

3、高斯混合模型参数估计的EM算法

EM算法的推广

EM算法还可以解释为F函数(F function)的极大-极大算法(maximization-maximization algorithm),基于这个解释有若干变形与推广,如广义期望极大(generalized expectation maximization, GEM)算法。

。。。不好意思,还没看懂,我后续会补。

EM算法及其推广的更多相关文章

- 《统计学习方法》笔记九 EM算法及其推广

本系列笔记内容参考来源为李航<统计学习方法> EM算法是一种迭代算法,用于含有隐变量的概率模型参数的极大似然估计或极大后验概率估计.迭代由 (1)E步:求期望 (2)M步:求极大 组成,称 ...

- EM算法及其推广的要点

1.EM算法是含有隐变量的变量的概率模型极大似然估计或极大后验概率估计的迭代算法,含有隐变量的概率模型的数据表示为$P(Y,Z|\theta)$.这里,$Y$是观测变量的数据,$Z$是隐变量的数据,$ ...

- 高斯混合模型参数估计的EM算法

# coding:utf-8 import numpy as np def qq(y,alpha,mu,sigma,K,gama):#计算Q函数 gsum=[] n=len(y) for k in r ...

- 含隐变量模型求解——EM算法

1 EM算法的引入1.1 EM算法1.2 EM算法的导出2 EM算法的收敛性3EM算法在高斯混合模型的应用3.1 高斯混合模型Gaussian misture model3.2 GMM中参数估计的EM ...

- 机器学习——EM算法

1 数学基础 在实际中,最小化的函数有几个极值,所以最优化算法得出的极值不确实是否为全局的极值,对于一些特殊的函数,凸函数与凹函数,任何局部极值也是全局极致,因此如果目标函数是凸的或凹的,那么优化算法 ...

- 学习笔记——EM算法

EM算法是一种迭代算法,用于含有隐变量(hidden variable)的概率模型参数的极大似然估计,或极大后验概率估计.EM算法的每次迭代由两步组成:E步,求期望(expectation):M步,求 ...

- 斯坦福大学机器学习,EM算法求解高斯混合模型

斯坦福大学机器学习,EM算法求解高斯混合模型.一种高斯混合模型算法的改进方法---将聚类算法与传统高斯混合模型结合起来的建模方法, 并同时提出的运用距离加权的矢量量化方法获取初始值,并采用衡量相似度的 ...

- 机器学习笔记(十)EM算法及实践(以混合高斯模型(GMM)为例来次完整的EM)

今天要来讨论的是EM算法.第一眼看到EM我就想到了我大枫哥,EM Master,千里马.RUA!!!不知道看这个博客的人有没有懂这个梗的. 好的,言归正传.今天要讲的EM算法,全称是Expectati ...

- EM算法及其应用(一)

EM算法及其应用(一) EM算法及其应用(二): K-means 与 高斯混合模型 EM算法是期望最大化 (Expectation Maximization) 算法的简称,用于含有隐变量的情况下,概率 ...

随机推荐

- 【介绍+安装】Nginx的介绍和安装详解

== 介绍和安装 == Nginx是一个自由.开源.高性能及轻量级的HTTP服务器及反转代理服务器, 其性能与IMAP/POP3代理服务器相当.Nginx以其高性能.稳定.功能丰富.配置简单及占用系统 ...

- mysql日志详解

日志分类: 一.错误日志. 1.在配置文件中的配置是:log-error="DESKTOP-igoodful.err",查看参数的键值对:show variables like ' ...

- Perl的变量及语境(一)

Perl语言中的大部分语句表达式后都紧接一个分号,分隔不同的Perl语句. perl解释器能一次完成编译和运行这两个动作. perl通过一对反引号"``"来表示运行外部命令. 也可 ...

- js valueOf()函数用于返回指定对象的原始值

valueOf()函数用于返回指定对象的原始值. 该方法属于Object对象,由于所有的对象都"继承"了Object的对象实例,因此几乎所有的实例对象都可以使用该方法. 对象 返回 ...

- python3.4学习笔记(十一) 列表、数组实例

python3.4学习笔记(十一) 列表.数组实例 #python列表,数组类型要相同,python不需要指定数据类型,可以把各种类型打包进去#python列表可以包含整数,浮点数,字符串,对象#创建 ...

- C# Http方式下载文件到本地类改进版

在上文基础上增加了远程文件是否存在和本地文件是否存在的判断. 类代码: using System; using System.Collections.Generic; using System.Lin ...

- linux系统启动顺序及init模式

磁盘的第一个扇区(512bytes)主要记录了两个重要信息: 主引导分区MBR:master boot record,安装引导加载程序的地方,446bytes 分区表:partition table: ...

- EF 一个实体对象不能由多个 IEntityChangeTracker 实例引用 解决办法

在DAL层中,建立工厂类 namespace DAL { public static class SysDbContextFactory { /// <summary> /// 从Http ...

- Android Socket 知识点汇总

版权声明:这篇博客资料来源 https://blog.csdn.net/carson_ho/article/details/53366856 , 未经授权,严禁转发! 一.网络基础 1.1 计算机网络 ...

- 20145101《Java程序设计》第二周学习总结

20145101 <Java程序设计>第2周学习总结 教材学习内容总结 在第三章的学习中,我学到了很多新知识点,了解到Java语言中的类型及其变量主要类型为:整数,还有char型,bool ...