大话Spark(2)-Spark on Yarn运行模式

Spark On Yarn 有两种运行模式:

- Yarn - Cluster

- Yarn - Client

他们的主要区别是:

Cluster: Spark的Driver在App Master主进程内运行, 该进程由集群上的YARN管理, 客户端可以在启动App Master后退出.

Client: Driver在提交作业的Client中运行, App Master仅用于从YARN请求资源.

这里以Client为例介绍:

Yarn-Client运行模式

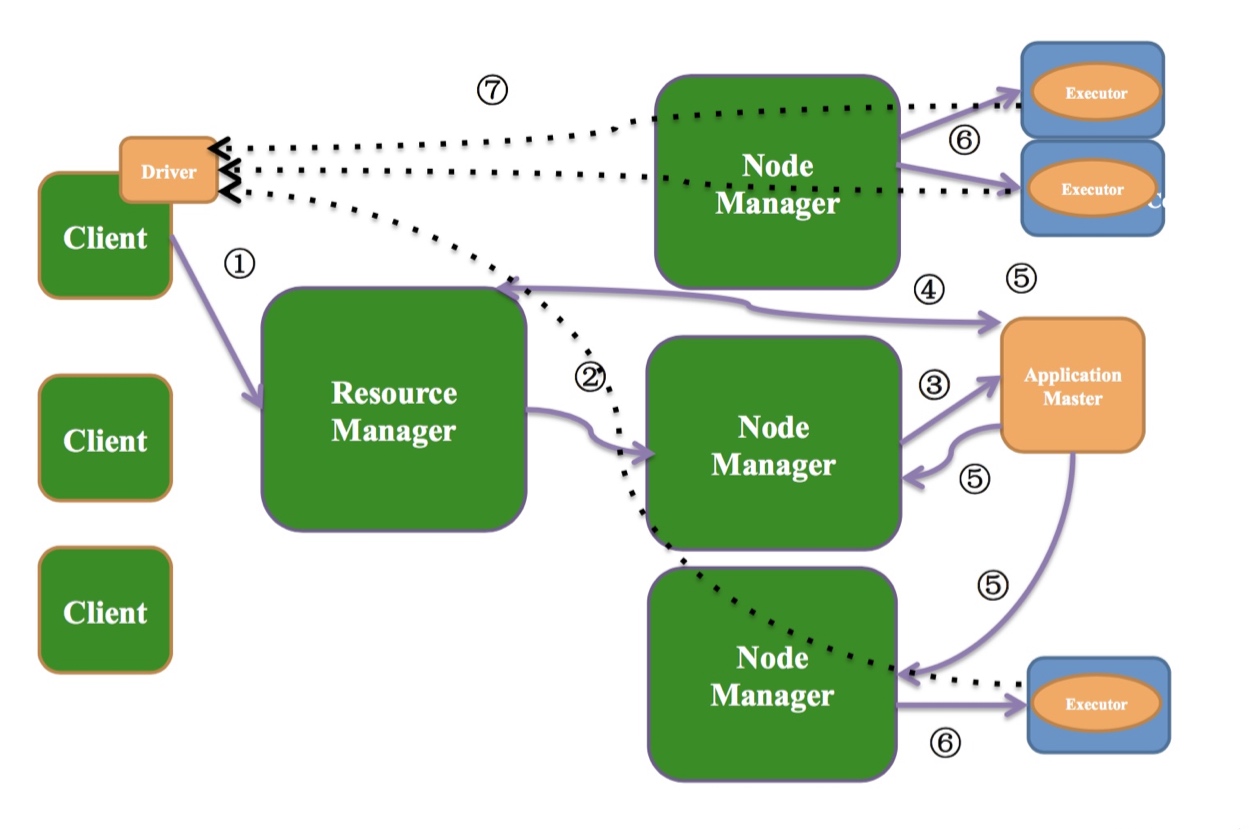

如上图:

Yarn-Client模式中,Driver运行在客户端(提交Spark程序的机器, 代码中Main方法运行的机器).

作业提交过程

- Client端提交作业到ResourceManager

(连接到ResourceManager, 获取queue,resource等信息,upload app jar,设置运行环境和container上下文) - ResourceManager找一个NodeManager

- NodeManager启动ApplicationMaster(在运行的时候指定占用多少资源)

- ApplicationMaster启动之后跟ResourceManager通信,为Executor申请资源.

- ApplicationMaster申请资源之后跟NodeManager通信

- 启动Executor

- Exector启动之后会跟Driver通信领取任务.

每个Spark程序由1个Driver和多个Executor构成.

Executor个数, 内存, cpu多少由用户控制(默认1g内存 1个cpu 2个executor)

WorkCount--逻辑查询计划--物理查询计划

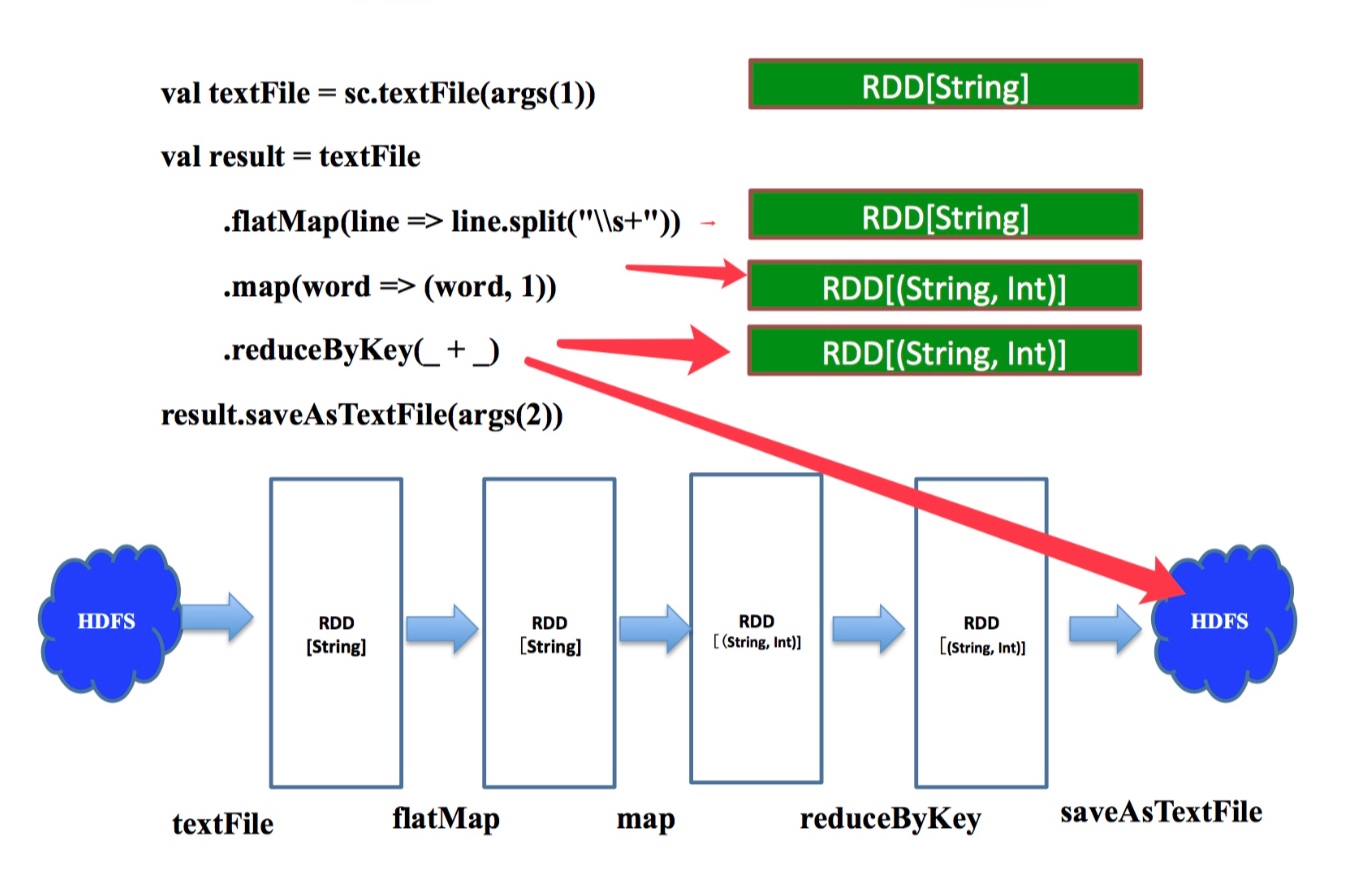

逻辑查询计划

上图右侧绿框代表每一步算子计算之后的结果

sc.textFile取hdfs路径生成rddtextFile.flatMap把rdd中的一行数据按照\s+(匹配任何空白字符,包括空格、制表符、换页符等等)拆成多行work=>(work, 1)把每条数据x 转换成(x, 1)这样key-value对的元组.reduceByKey(_ + _)按照每个key聚合,取value的总和(每个单词出现的次数)saveAsTextFile这是一个action操作,把最终结果写到hdfs

上图的下半部分是workcount作业的逻辑查询计划.

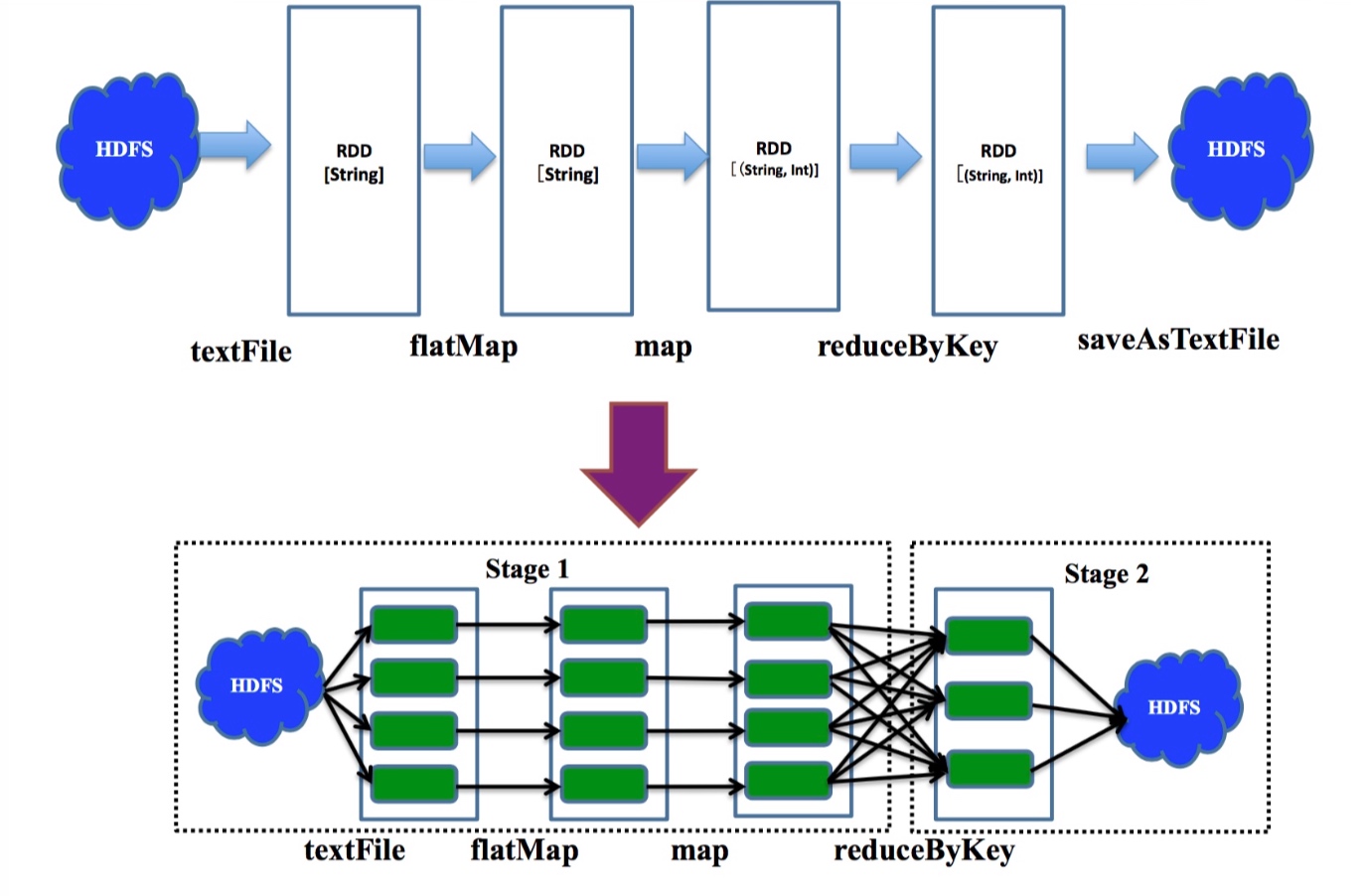

物理查询计划

上图上半部分展示了各级算子值键的依赖关系(逻辑查询计划)

下半部分的每个绿块代表一个partition的数据,多个partition值键并行计算, 遇到会产生shuffle的reduceByKey操作时划分stage.

窄依赖:

指父RDD的每个分区只被子RDD的一个分区所使用,子RDD分区通常对应常数个父RDD分区

宽依赖:

是指父RDD的每个分区都可能被多个子RDD分区所使用,子RDD分区通常对应所有的父RDD分区

stage内部是窄依赖,stage间是宽依赖.

大话Spark(2)-Spark on Yarn运行模式的更多相关文章

- Flink 集群运行原理兼部署及Yarn运行模式深入剖析

1 Flink的前世今生(生态很重要) 原文:https://blog.csdn.net/shenshouniu/article/details/84439459 很多人可能都是在 2015 年才听到 ...

- 六、yarn运行模式

简介 spark的yarn运行模式根据Driver在集群中的位置分成两种: 1)yarn-client 客户端模式 2)yarn-cluster 集群模式 yarn模式和standalone模式不同, ...

- spark on mesos 两种运行模式

spark on mesos 有粗粒度(coarse-grained)和细粒度(fine-grained)两种运行模式,细粒度模式在spark2.0后开始弃用. 细粒度模式 优点 spark默认运行的 ...

- Spark on YARN运行模式(图文详解)

不多说,直接上干货! 请移步 Spark on YARN简介与运行wordcount(master.slave1和slave2)(博主推荐) Spark on YARN模式的安装(spark-1.6. ...

- 【Hadoop】YARN 原理、MR本地&YARN运行模式

1.基本概念 2.YARN.MR交互流程 3.源码解读

- 理解Spark运行模式(一)(Yarn Client)

Spark运行模式有Local,STANDALONE,YARN,MESOS,KUBERNETES这5种,其中最为常见的是YARN运行模式,它又可分为Client模式和Cluster模式.这里以Spar ...

- Spark On Yarn搭建及各运行模式说明

之前记录Yarn:Hadoop2.0之YARN组件,这次使用Docker搭建Spark On Yarn 一.各运行模式 1.单机模式 该模式被称为Local[N]模式,是用单机的多个线程来模拟Spa ...

- Spark运行模式与Standalone模式部署

上节中简单的介绍了Spark的一些概念还有Spark生态圈的一些情况,这里主要是介绍Spark运行模式与Spark Standalone模式的部署: Spark运行模式 在Spark中存在着多种运行模 ...

- Spark基本工作流程及YARN cluster模式原理(读书笔记)

Spark基本工作流程及YARN cluster模式原理 转载请注明出处:http://www.cnblogs.com/BYRans/ Spark基本工作流程 相关术语解释 Spark应用程序相关的几 ...

随机推荐

- @@cursor_rows变量解析

刚刚看了@@curosr_rows这个全局变量,发现这个变量挺有意思.要懂得这个变量的意义,基本上牵扯到cursor一些比较容易忽视的内容. @@cursor_rows是用来记录当前游标的数量,也就从 ...

- [转]前端网络(性能)监测工具berserkJS

berserkJS 是基于 Qt (C++跨平台库)开发的前端网络(性能)监测工具. 它的核心功能是通过内置 webkit 收集由页面实际网络请求相关数据. 偏重于页面上线前检测与评估. 页面性能分析 ...

- Java 的 Tuple 元组数据类型

元组类型,即 Tuple 常在脚本语言中出现,例如 Scala 的 ("Unmi", "china@qq.com", "blahbla"). ...

- STL string大小写 转换

std::string data = "This is a sample string."; // convert string to upper case std::for_ea ...

- Could not open JPA EntityManager for transaction; nested exception is javax.persistence.PersistenceException: org.hibernate.exception.SQLGrammarException: Cannot open connection

Could not open JPA EntityManager for transaction; nested exception is javax.persistence.PersistenceE ...

- k8s 基础 pod操作

创建hell world pod #vim hello-world-pod.yaml apiVersion: v1 kind: Pod metadata: name: hello-world spec ...

- 并发设计模式和锁优化以及jdk8并发新特性

1 设计模式 (1) 单例模式 保证一个类只能一个对象实现.正常的单例模式分为懒汉式和饿汉式,饿汉式就是把单例声明称static a=new A(),系统第一次调用的时候生成(包括调用该类的其他静态资 ...

- [poj3281]Dining(最大流+拆点)

题目大意:有$n$头牛,$f$种食物和$d$种饮料,每种食物或饮料只能供一头牛享用,且每头牛只享用一种食物和一种饮料.每头牛都有自己喜欢的食物种类列表和饮料种类列表,问最多能使几头牛同时享用到自己喜欢 ...

- cocos2dx v3.x lua绑定分析

打算新项目转到cocos2dx v3上了,下载代码浏览过后发现改动真是非常大,结构性调整很多. 比如tolua绑定这一块,就几乎全翻新了. 胶水代码的生成,改成了全自动式的,通过clang来分析c++ ...

- MyBatis入门基础

转自http://www.cnblogs.com/selene/p/4604605.html 话不多说,先看看原始的JDBC程序代码,看看这样的代码存在什么样子的问题. package com.uti ...