Flink1.9.2源码编译和使用

欢迎访问我的GitHub

https://github.com/zq2599/blog_demos

内容:所有原创文章分类汇总及配套源码,涉及Java、Docker、Kubernetes、DevOPS等;

为什么要编译flink源码

用于学习,在IDEA上开发的flink job,能直接在IDEA运行,如果运行时依赖的flink框架是我们自己编译构建的,就做到了从业务到框架都可以修改源码并验证,起到了很好的学习和动手实践效果;

环境信息

- 电脑:2019版13寸MacBook Pro,2.3 GHz 四核Intel Core i5,8 GB 2133 MHz LPDDR3

- 操作系统:macOS Catalina 10.15.3

- JDK:1.8.0_211

- Maven:3.6.0

- IDEA:2018.3.5 (Ultimate Edition)

关于正版IDEA

如何免费使用正版IDEA,可以参考《免费申请和使用IntelliJ IDEA商业版License指南》

全文概览

今天的实战由以下内容组成:

- 开发一个最简单的flink任务,在IDEA上以local模式运行;

- 下载flink1.9.2源码;

- 修改flink1.9.2源码,并且编译构建;

- 设置,让步骤1中的flink任务用上刚刚编译的flink1.9.2框架;

- 再次运行flink任务,验证修改后的flink框架是否生效;

IDEA上运行flink job工程

- 在IDEA上创建flink job的maven工程并运行,请参考《IDEA上运行Flink任务》

- 假设您已按上面的步骤在IDEA建好了flink job工程;

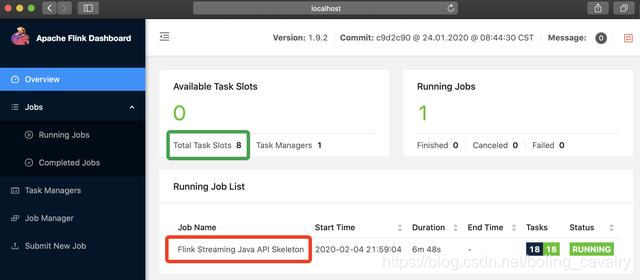

- 运行起来,在浏览器打开flink页面,如下图,绿框中显示一共有8个Task Slot:

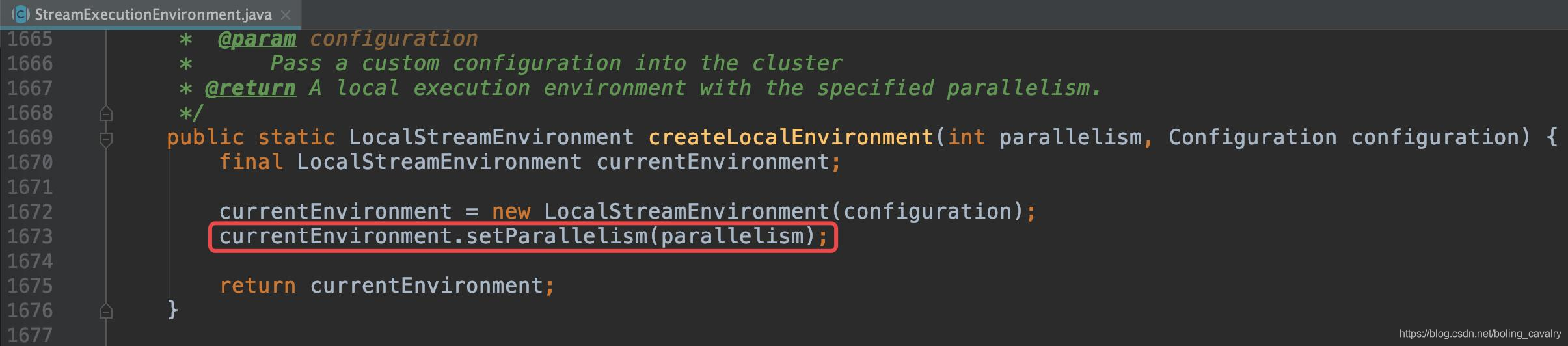

- 之所以会有8个Task Slot,和下图红框中的代码有关,这是段flink框架源码(StreamExecutionEnvironment.java),入参parallelism是CPU核数,我这里是开了超线程的四核i5处理器,所以parallelism等于8:

- 今天的目标就是修改上图红框中的源码,然后在网页上看是不是生效了(Task Slot数量从8改成5);

准备工作

- maven中央仓库地址建议用阿里云的,否则会经常遇到jar下载超时错误,地址:http://192.168.50.43:8081/repository/aliyun-proxy/

- flink1.9.2源码的maven工程依赖了一个中央仓库没有的jar,GAV是io.confluent:kafka-schema-registry-client:3.3.1,您需要下载下来在本地仓库做mvn install操作,下载地址:http://packages.confluent.io/maven/io/confluent/kafka-schema-registry-client/3.3.1/kafka-schema-registry-client-3.3.1.jar

- 上述准备工作都需要您在本地maven上操作,但是如果您的条件允许,还是强烈推荐在内网搭建maven私服nexus3,参考:《群晖DS218+做maven私服(nexus3)》、《Ubuntu部署和体验Nexus3》、《Nexus3常用功能备忘》

下载flink1.9.2源码

flink1.9.2源码的下载地址:http://ftp.jaist.ac.jp/pub/apache/flink/flink-1.9.2/flink-1.9.2-src.tgz

修改和编译构建

- 将下载好的flink-1.9.2-src.tgz解压,得到文件夹flink-1.9.2

- 打开这个文件:flink-1.9.2/flink-streaming-java/src/main/java/org/apache/flink/streaming/api/environment/StreamExecutionEnvironment.java

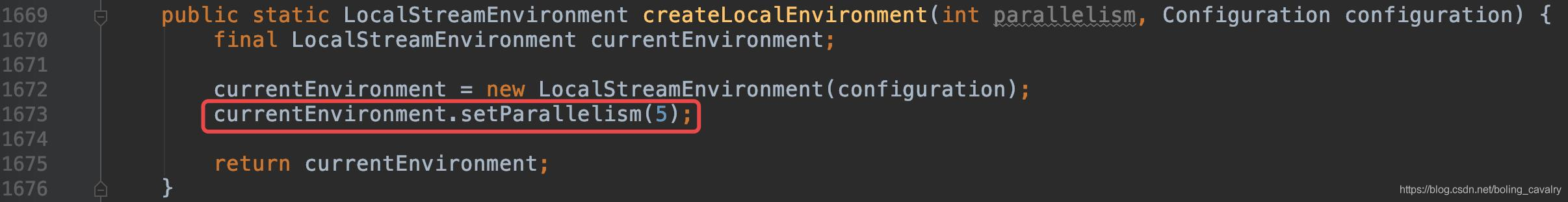

- 如下图红框,找到createLocalEnvironment方法,把setParallelism的入参改成一个固定的数字(每个Task Slot都要分配内存,所以这个数字请不要改得太大,否则启动flink就会报错了,我这里改成了5):

- 在文件夹flink-1.9.2下,执行编译构建的命令:mvn clean install -DskipTests -Dfast

- 经历漫长等待后提示构建成功:

- 确认这个文件已生成,稍后就要用到:flink-1.9.2/flink-dist/target/flink-dist_2.11-1.9.2.jar

设置

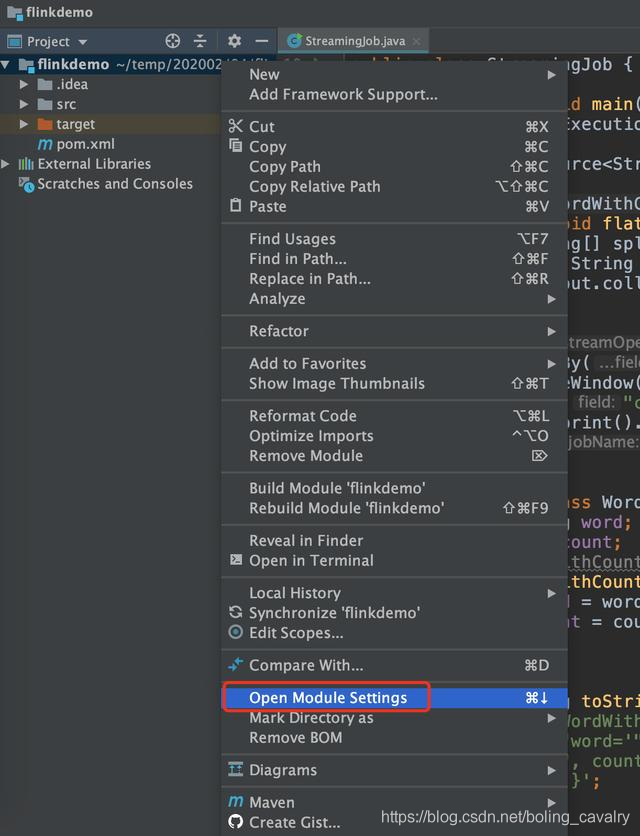

- 为了用上刚刚构建出来的flink框架jar,要做些设置,打开之前运行的flink job应用,在项目上点击右键,点击菜单Open Module Settings,如下图:

- 接下来要做三个和jar有关的操作,注意每一步都很重要:

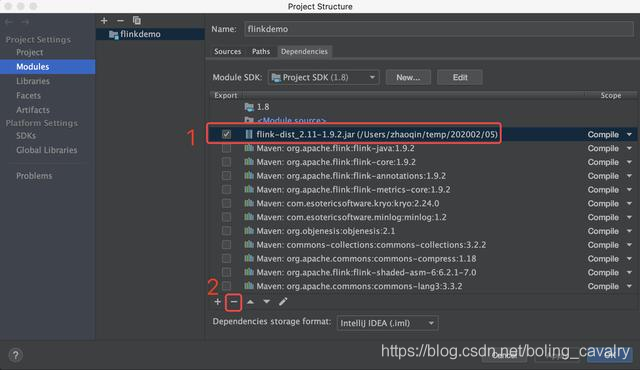

- 下图红框1中的flink-dist_2.11-1.9.2.jar文件,是《IDEA上运行Flink任务》一文中添加的,目的是提供网页服务,现在将其删除,操作如下图红框所示:

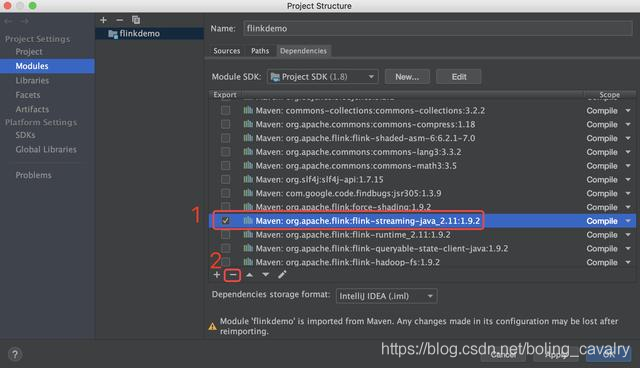

- 下图红框1中的maven依赖:org.apache.flink:flink-streaming-java_2.11:1.9.2,也请删除,操作如下图红框所示:

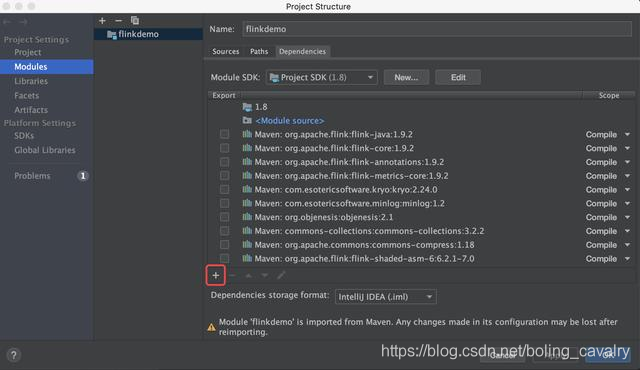

- 点击下图红框中的加号:

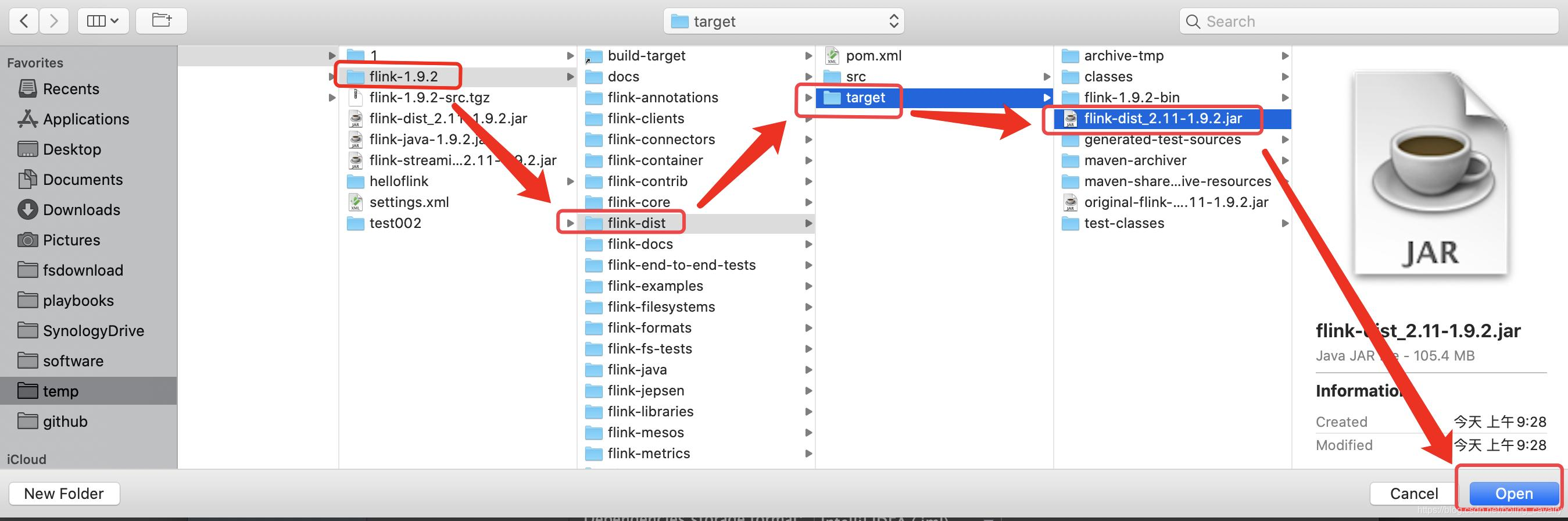

- 在弹出的窗口选中刚才构建好的文件flink-1.9.2/flink-dist/target/flink-dist_2.11-1.9.2.jar:

- 记得点击右下角的OK按钮保存,修改完毕,接下来验证咱们修改的flink框架源码是否生效了

验证

- 当前flink job工程来自《IDEA上运行Flink任务》一文,StreamingJob的工作是读取本机18081端口的数据,所以我们要把18081端口的服务启动起来,不然StreamingJob运行时是连不上端口的,打开一个控制台,执行命令:nc -l 18081

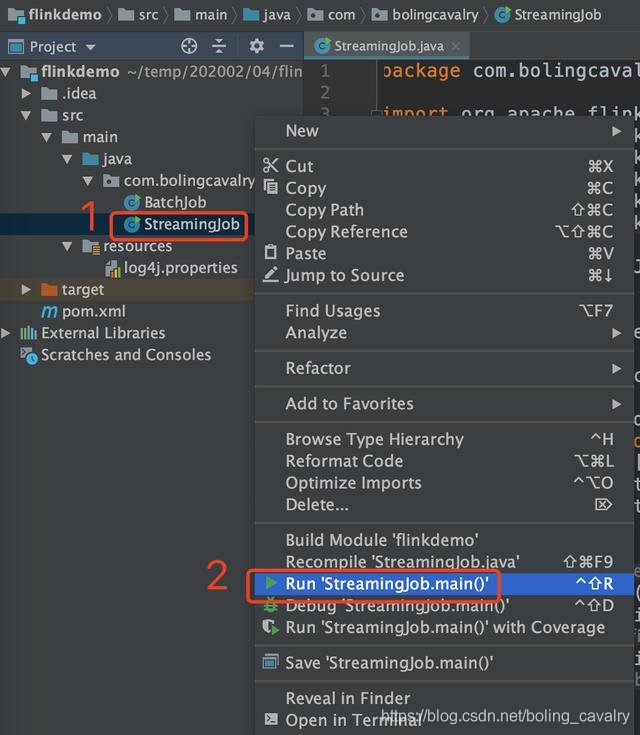

- 现在可以将StreamingJob运行起来,如下图,右键点击StreamingJob,选择Run 'StreamingJob.main()':即可启动flink任务:

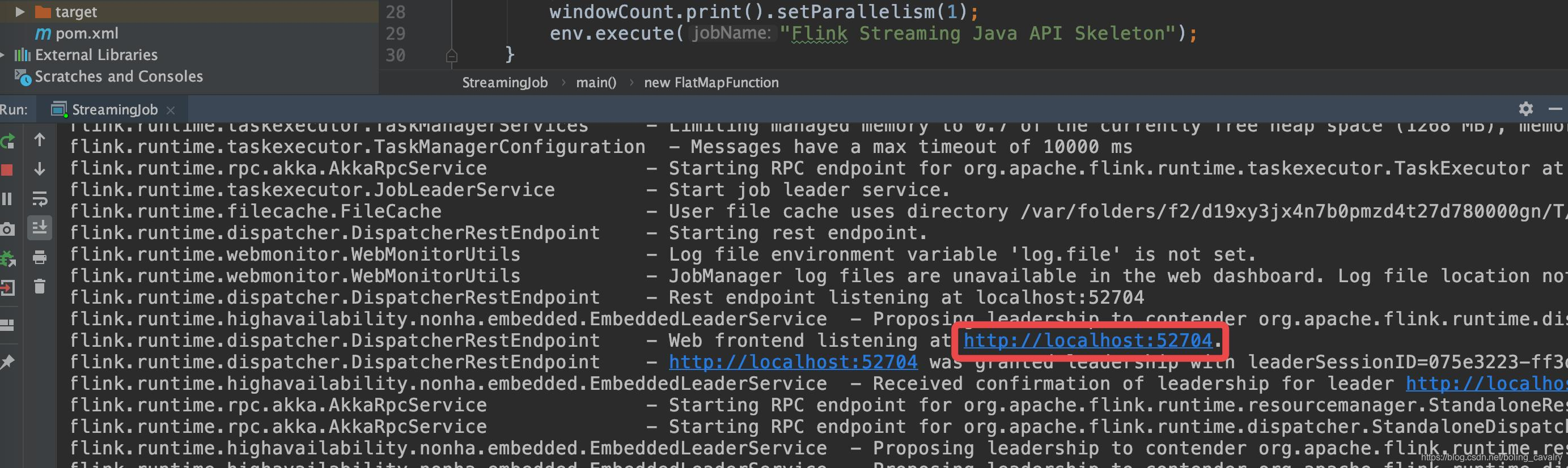

- 在IDEA的控制台搜索关键字localhost,如下图红框,可以查到flink网页的端口,我这里是52704:

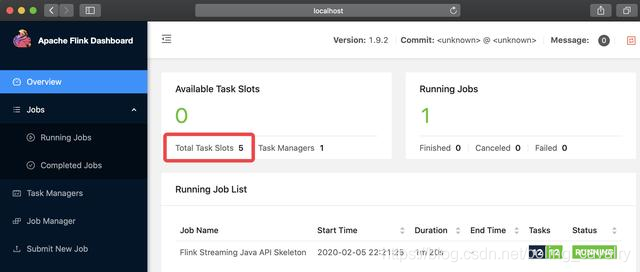

- 浏览器访问http://localhost:52704,如下图红框,Total Task Slots数量是5,我们修改的flink1.9.2的源码生效了:

- 至此,Flink1.9.2的源码从修改到编译构建,再到验证都已经完成了,如果您也在学习flink,希望本文能给您一些参考,一起来动手实战吧;

欢迎关注公众号:程序员欣宸

微信搜索「程序员欣宸」,我是欣宸,期待与您一同畅游Java世界...

https://github.com/zq2599/blog_demos

Flink1.9.2源码编译和使用的更多相关文章

- Android 5.0源码编译问题

如果是自己通过repo和git直接从google官网上download的源码,请忽略这个问题,但是由于google在国内被限制登录,通过这一种方法不是每个人都能download下来源码,通常的做法就是 ...

- Android stdio Apktool源码编译

Android Apktool源码编译 标签(空格分隔): Android Apktool 源码编译 需求 习惯NetBeans调试smali需要用Apktool反编译apk,需要用-d的参数才能生成 ...

- SSH/SSL 源码编译安装简易操作说明

环境:CentOS 6.7 安全加固需求,由于某盟扫描系统主机有SSL系列漏洞,客户要求必须修复: 解决方案:将SSH/SSL升级到最新版本,删除SSL旧版本(实测不删除旧版本某盟扫描无法通过). 当 ...

- Hadoop源码编译过程

一. 为什么要编译Hadoop源码 Hadoop是使用Java语言开发的,但是有一些需求和操作并不适合使用java,所以就引入了本地库(Native Libraries)的概念,通 ...

- World Wind .NET源码编译问题处理

World Wind .NET源码编译问题处理 下载了World_Wind_1.4.0_Source源码(http://worldwindcentral.com/wiki/NASA_World_W ...

- 源码编译安装 MySQL 5.5.x 实践

1.安装cmakeMySQL从5.5版本开始,通过./configure进行编译配置方式已经被取消,取而代之的是cmake工具.因此,我们首先要在系统中源码编译安装cmake工具. # wget ht ...

- Linux 安装node.js ---- 源码编译的方式

一 : 普通用户: 安装前准备环境: 1.检查Linux 版本 命令: cat /etc/redhat-release 2.检查 gcc.gcc-c++ 是否安装过 命令: rpm -q gcc rp ...

- 烂泥:mysql5.5数据库cmake源码编译安装

本文由秀依林枫提供友情赞助,首发于烂泥行天下. 以前也写过一篇有关mysql5.0源码编译的文章,该文章为<烂泥:mysql5.0数据库源码编译安装>.但是MySQL自5.5版本以后,就开 ...

- Centos7.X 源码编译安装subversion svn1.8.x

说明:SVN(subversion)的运行方式有两种:一种是基于Apache的http.https网页访问形式:还有一种是基于svnserve的独立服务器模式.SVN的数据存储方式也有两种:一种是在B ...

随机推荐

- 面经手册 · 第12篇《面试官,ThreadLocal 你要这么问,我就挂了!》

作者:小傅哥 博客:https://bugstack.cn 沉淀.分享.成长,让自己和他人都能有所收获! 一.前言 说到底,你真的会造火箭吗? 常说面试造火箭,入职拧螺丝.但你真的有造火箭的本事吗,大 ...

- BUUCTF[归纳]sql注入相关题目

这是我自己对于sql注入的部分ctf题型的归纳,均来自buuctf的平台环境. [0CTF 2016]piapiapia 我尝试了几种payload,发现有两种情况. 第一种:Invalid user ...

- axios之post提交

axios官网地址:https://github.com/axios/axios post提交到后台需要做相对应的处理 使用URLSearchParams可以让post 数据提交到后台 对应gitHu ...

- 转载:tensorflow slim模块用法

https://www.cnblogs.com/hellcat/p/8058092.html

- 手把手教你springboot中导出数据到excel中

手把手教你springboot中导出数据到excel中 问题来源: 前一段时间公司的项目有个导出数据的需求,要求能够实现全部导出也可以多选批量导出(虽然不是我负责的,我自己研究了研究),我们的项目是x ...

- springboot实现防重复提交和防重复点击

背景 同一条数据被用户点击了多次,导致数据冗余,需要防止弱网络等环境下的重复点击 目标 通过在指定的接口处添加注解,实现根据指定的接口参数来防重复点击 说明 这里的重复点击是指在指定的时间段内多次点击 ...

- java学习网站汇总

1.https://blog.csdn.net/qq_35571554/article/details/82759668 B+树原理漫画讲解2.https://blog.csdn.net/moakun ...

- 机器学习可解释性系列 - 是什么&为什么&怎么做

机器学习可解释性分析 可解释性通常是指使用人类可以理解的方式,基于当前的业务,针对模型的结果进行总结分析: 一般来说,计算机通常无法解释它自身的预测结果,此时就需要一定的人工参与来完成可解释性工作: ...

- python-代数式括号有效性检验

思路: 利用栈实现代数式中括号有效行的的检验: 代码: class mychain(object): #利用链表建立栈,链表为父类 length=0 def __init__(self,value=N ...

- Python3——字典

Python 字典(Dictionary) 字典是另一种可变容器模型,且可存储任意类型对象. 字典的每个键值(key=>value)对用冒号(:)分割,每个对之间用逗号(,)分割,整个字典包括在 ...