TorchV的RAG实践分享(三):解析llama_index的数据存储结构和召回策略过程

1.前言

LlamaIndex是一个基于LLM的数据处理框架,在RAG领域非常流行,简单的几行代码就能实现本地的文件的对话功能,对开发者提供了极致的封装,开箱即用。

本文以官方提供的最简单的代理示例为例,分析LlamaIndex在数据解析、向量Embedding、数据存储及召回的整个源码过程。

通过学习框架的源码也能让开发者们在实际的企业大模型应用开发中,对RAG有一个更清晰的了解和认知。

本次选用的技术组件:

- llm:OpenAI

- Embedding:OpenAI

- VectorDB:ElasticSearch

官方代码示例如下:

# 1.构建向量数据库存储对象实例

vector_store = ElasticsearchStore(

index_name="my_index",

es_url="http://localhost:9200",

)

storage_context = StorageContext.from_defaults(vector_store=vector_store)

# 加载本地的数据集

documents = SimpleDirectoryReader('data').load_data()

# 构建索引

index = VectorStoreIndex.from_documents(documents,storage_context=storage_context)

# 服务对象,构建query引擎

service_context = ServiceContext.from_defaults(llm=OpenAI())

query_engine = index.as_query_engine(service_context=service_context)

# 问问题

resp=query_engine.query("住院起付线多少钱?")

# 响应答案

print(resp)2.处理过程

2.1 数据处理过程

在数据处理的过程中,主要包含几个核心的步骤:

- 初始化向量存储引擎,目前向量数据库类型非常多,笔者本机跑了一个es的docker镜像,这里就选择es了

- 读取数据,数据格式包括:PDF、WORD、TXT等等文本数据

- 在数据读取完成后,会对文档内容进行分割,然后Embedding(调用embedding模型)存储入库

2.1.1 处理加载不同的文件类型(构建Document)

SimpleDirectoryReader是llamaindex提供的一个基于文件夹的读取器类,会根据文件夹中的文件扩展后缀类型自动加载数据

主要支持的文件数据类型如下:

DEFAULT_FILE_READER_CLS: Dict[str, Type[BaseReader]] = {

".hwp": HWPReader,

".pdf": PDFReader,

".docx": DocxReader,

".pptx": PptxReader,

".ppt": PptxReader,

".pptm": PptxReader,

".jpg": ImageReader,

".png": ImageReader,

".jpeg": ImageReader,

".mp3": VideoAudioReader,

".mp4": VideoAudioReader,

".csv": PandasCSVReader,

".epub": EpubReader,

".md": MarkdownReader,

".mbox": MboxReader,

".ipynb": IPYNBReader,

}

class SimpleDirectoryReader(BaseReader):

"""Simple directory reader.

Load files from file directory.

Automatically select the best file reader given file extensions.

Args:

input_dir (str): Path to the directory.

input_files (List): List of file paths to read

(Optional; overrides input_dir, exclude)

exclude (List): glob of python file paths to exclude (Optional)

exclude_hidden (bool): Whether to exclude hidden files (dotfiles).

encoding (str): Encoding of the files.

Default is utf-8.

errors (str): how encoding and decoding errors are to be handled,

see https://docs.python.org/3/library/functions.html#open

recursive (bool): Whether to recursively search in subdirectories.

False by default.

filename_as_id (bool): Whether to use the filename as the document id.

False by default.

required_exts (Optional[List[str]]): List of required extensions.

Default is None.

file_extractor (Optional[Dict[str, BaseReader]]): A mapping of file

extension to a BaseReader class that specifies how to convert that file

to text. If not specified, use default from DEFAULT_FILE_READER_CLS.

num_files_limit (Optional[int]): Maximum number of files to read.

Default is None.

file_metadata (Optional[Callable[str, Dict]]): A function that takes

in a filename and returns a Dict of metadata for the Document.

Default is None.

"""

supported_suffix = list(DEFAULT_FILE_READER_CLS.keys())

//....总共支持了16个文件数据类型,整理到表格如下:

| 文件类型 | 依赖组件 | 说明 |

|---|---|---|

| hwp | olefile | |

| pypdf | ||

| docx | docx2txt | |

| pptx、pptm、ppt | python-pptx、transformers、torch | 用到一些模型,对数据进行理解、提取 |

| jpg、png、jpeg、 | sentencepiece、transformers、torch | 用到一些模型,对数据进行理解、提取 |

| mp3、mp4 | whisper | 用到一些模型,对数据进行理解、提取 |

| csv | pandas | |

| epub | EbookLib、html2text | |

| md | 无 | 本地流直接open,读取文本 |

| mbox | bs4、mailbox | |

| ipynb | nbconvert |

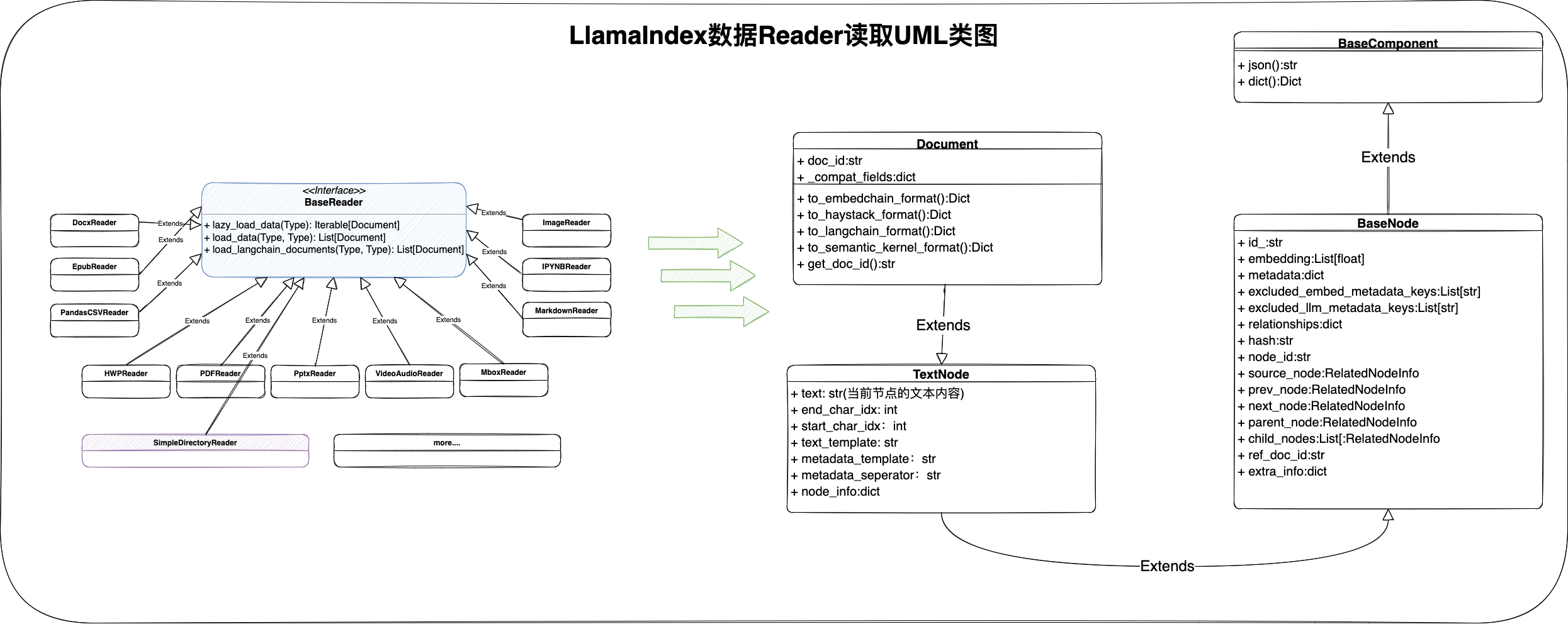

整个Reader类的UML类图设计如下:

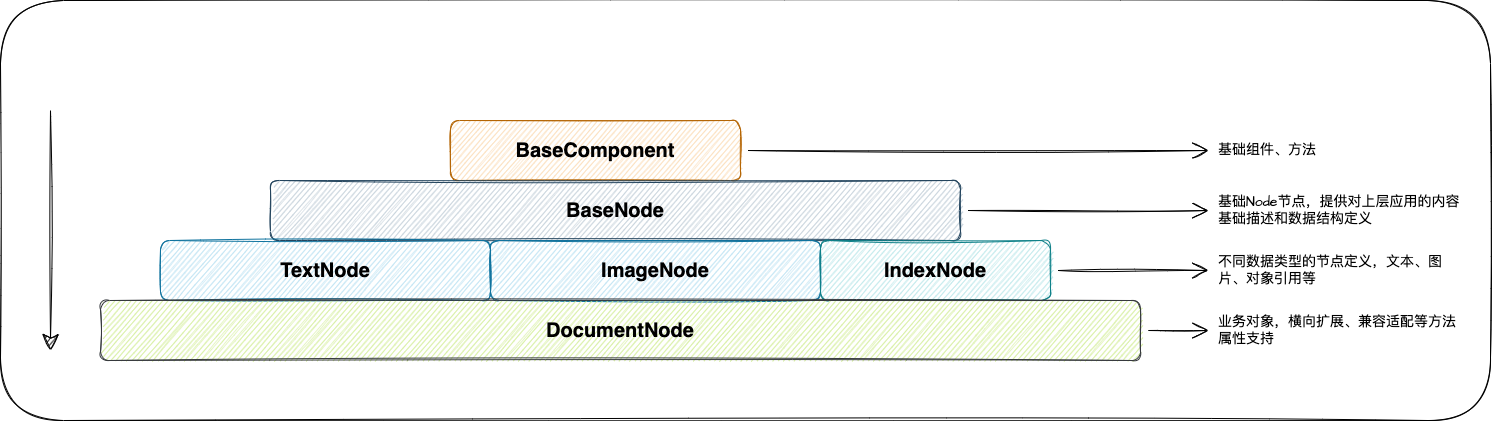

所有文件数据类型的Reader,通过load_data方法,最终得到该文档的Document对象集合,Document类是LlamaIndex框架的处理文档的核心类对象,从该类的结构设计来看,我们可以总结一下:

- 核心字段:id(文档唯一id)、text(文本内容)、embedding(向量float浮点型集合)、metadata(元数据)

- BaseNode提供了一个树结构的设计,对于一篇文档而言,从多级标题划分来看,树结构能更好的描述一篇文档的基础结构

- Document提供了一些外部应用框架适配的方法,比如:LangChain、EmbedChain等等

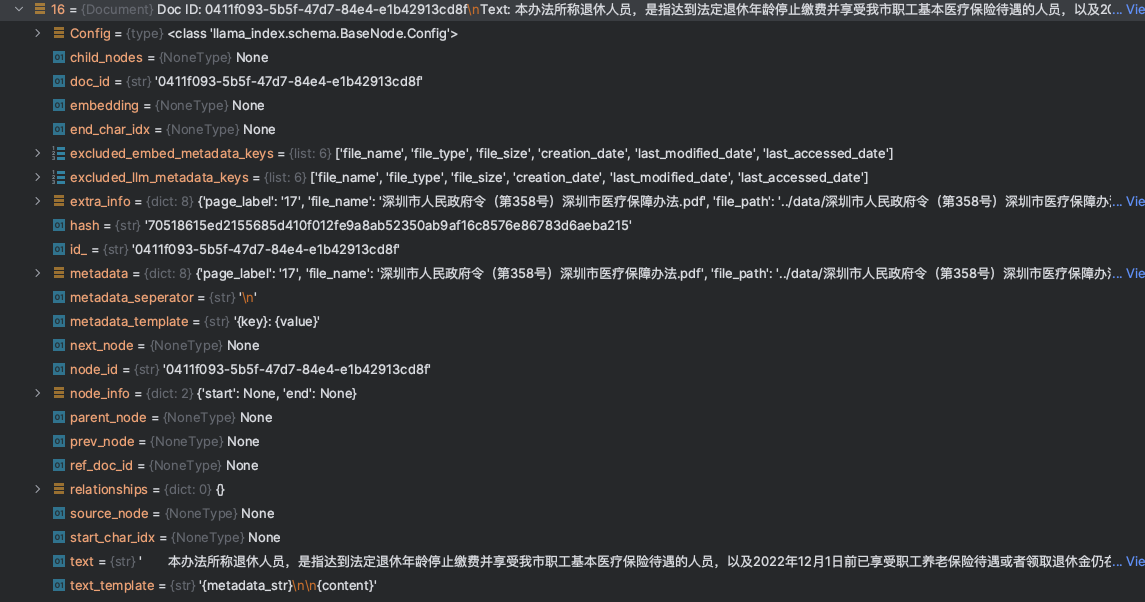

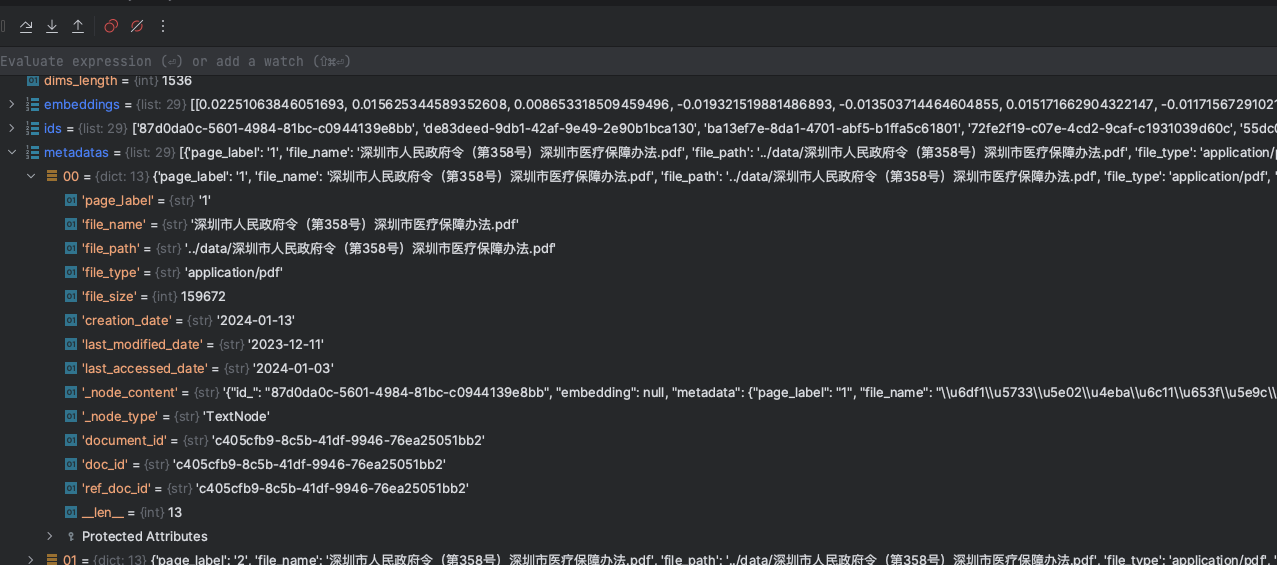

最终构建完成所有的Document信息后,我们可以看到下面一个结构信息

本示例程序,使用的是一个PDF文件,由于我们并未指定分割等策略,LlamaIndex对于PDF文件是以Page为单位,进行切割,最终将所有的Document对象存储进入向量数据库

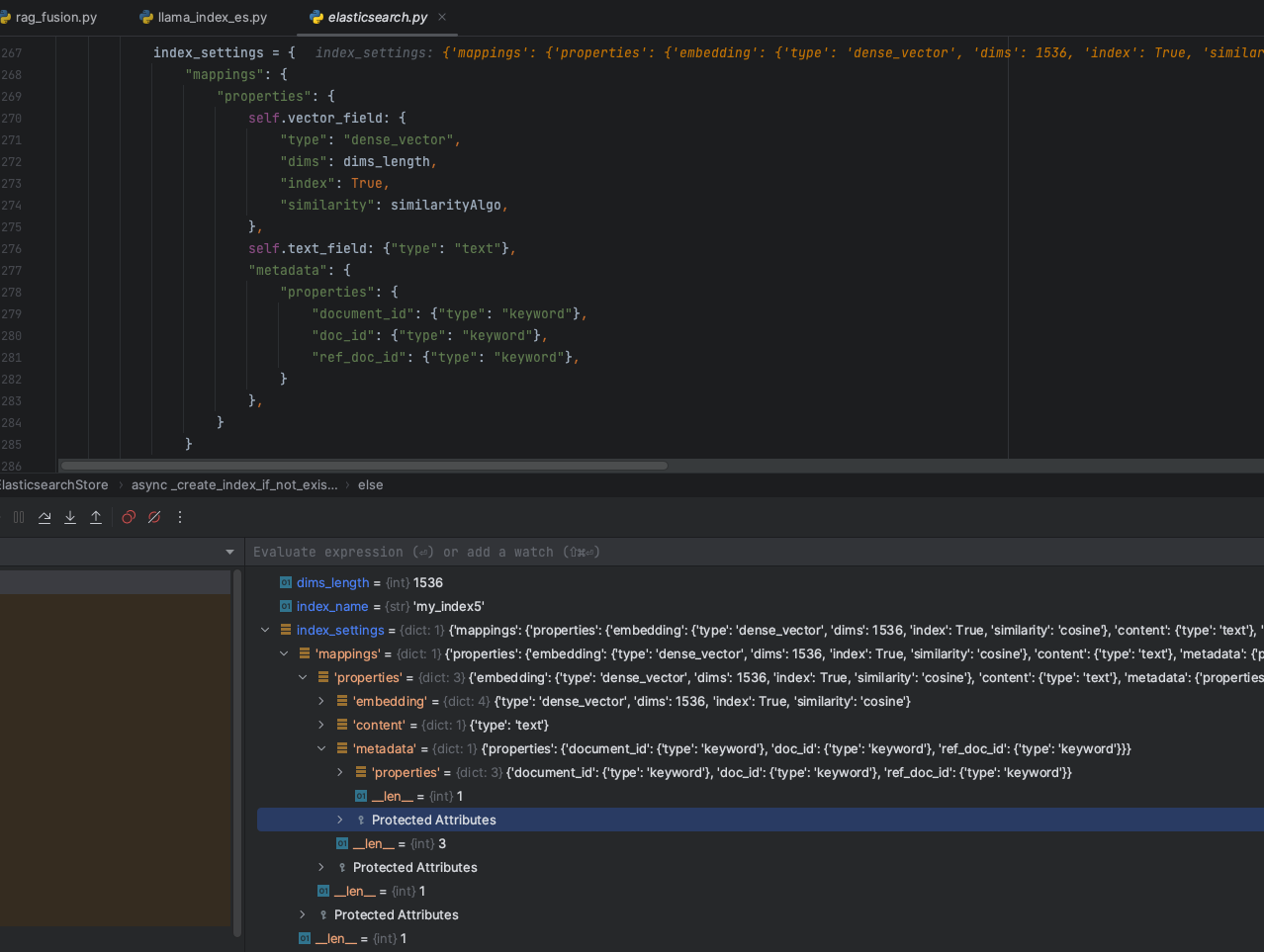

2.1.2 构建向量数据库索引(Index)

当本地数据集处理完成,得到一个Document集合的时候,此时,这需要构建向量数据库的索引,主要是包含几个过程:

- 调用不同的向量数据库中间件,构建集合索引,对于ES来说,则是创建Index

- 调用Embedding模型(基于OpenAI提供的

text-embedding-ada-002模型),将Document对象集合中的text文本,进行向量化处理并赋值 - 将

Document集合的对象值(text、embedding、metadata)存储进入向量数据库

在LlamaIndex创建ES的向量索引结构中,初始情况下,核心字段也是前面我们提到的Document类中的几个核心字段(id、embedding、content、metadata),如下图:

但是在Document对象遍历结束后,在数据存储阶段,考虑到元数据的信息,LlamaIndex会扩充metadata元数据的字段,如下图:

元数据信息会将文档的信息提取出来,包括页码、文件大小、文件名称、创建日期等等信息

最终在本地数据集的情况下,LlamaIndex创建的ES数据索引结构最终就会变成下面这种结构形式:

{

"mappings": {

"properties": {

"content": {

"type": "text"

},

"embedding": {

"type": "dense_vector",

"dims": 1536,

"index": true,

"similarity": "cosine"

},

"metadata": {

"properties": {

"_node_content": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"_node_type": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"creation_date": {

"type": "date"

},

"doc_id": {

"type": "keyword"

},

"document_id": {

"type": "keyword"

},

"file_name": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"file_path": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"file_size": {

"type": "long"

},

"file_type": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"last_accessed_date": {

"type": "date"

},

"last_modified_date": {

"type": "date"

},

"page_label": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"ref_doc_id": {

"type": "keyword"

}

}

}

}

}

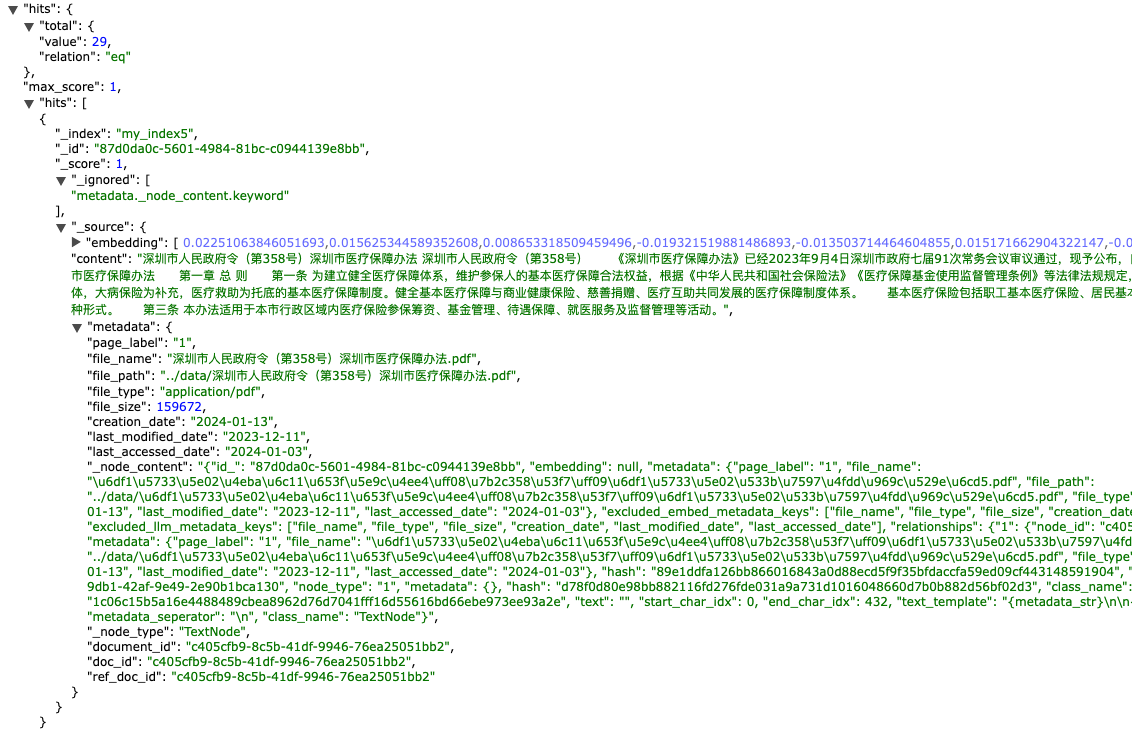

}数据Index定义完成,Document对象存储进入向量数据库,此时,我们的数据集结构如下:

2.2 问答获取答案

在获取答案的过程中,主要包含几个核心的步骤:

- 构建用户查询Query,对query进行Embedding处理,召回Topk的相似片段内容。

- 组装Prompt工程内容,发送大模型获取答案

2.2.1 召回查询获取TopK

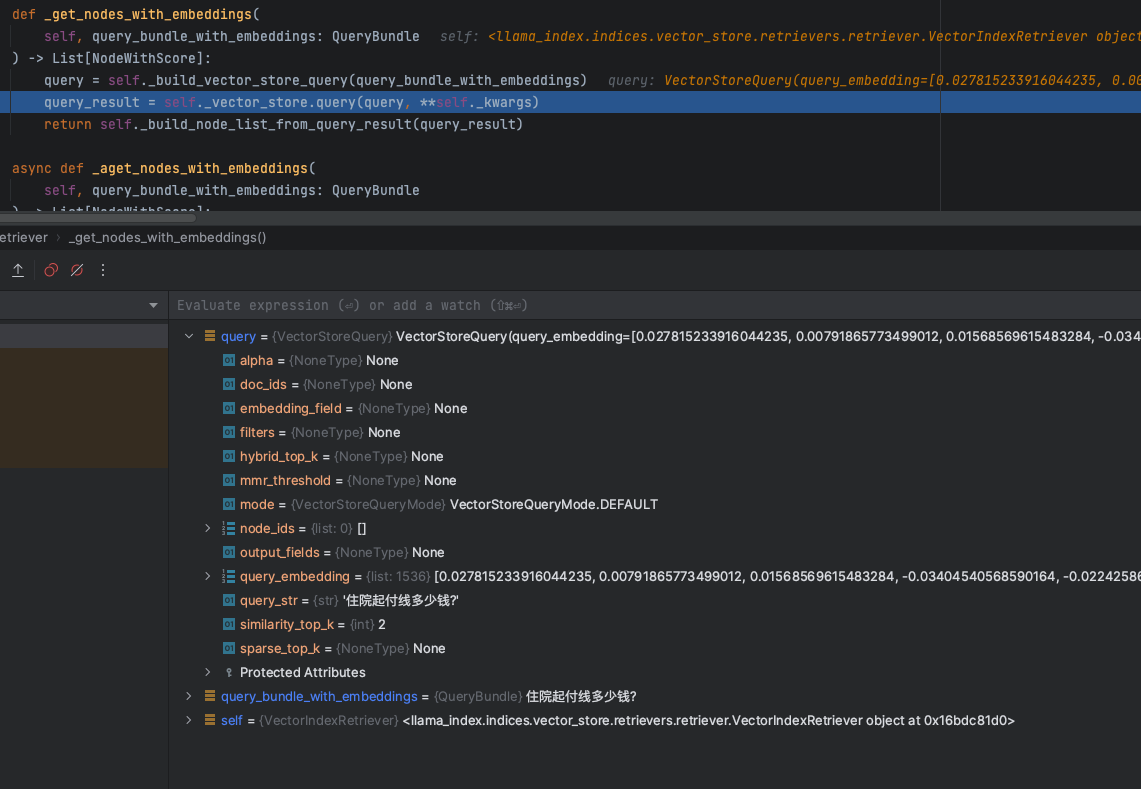

首先,在RAG的查询阶段,不管是使用那个向量数据库,根据数据库的类型,将用户的query语句进行Embedding后,再构建数据库的查询条件,如下图:

这里面会包含几个核心的参数:

- embedding:knn查询的浮点型向量数组值

- top_k:根据knn相似度查询获取得到的topk值数量,在这个例子中,LlamaIndex默认值是2

- filters:过滤条件

- alpha:语义&关键词混合检索的权重,0代表bm25算法检索,1则代表knn

VectorStoreQuery类结构定义如下:

@dataclass

class VectorStoreQuery:

"""Vector store query."""

# knn搜索的查询Embedding浮点型数组

query_embedding: Optional[List[float]] = None

# knn搜索的top k取值

similarity_top_k: int = 1

doc_ids: Optional[List[str]] = None

node_ids: Optional[List[str]] = None

query_str: Optional[str] = None

output_fields: Optional[List[str]] = None

embedding_field: Optional[str] = None

mode: VectorStoreQueryMode = VectorStoreQueryMode.DEFAULT

# NOTE: only for hybrid search (0 for bm25, 1 for vector search)

alpha: Optional[float] = None

# metadata filters

filters: Optional[MetadataFilters] = None

# only for mmr

mmr_threshold: Optional[float] = None

# NOTE: currently only used by postgres hybrid search

sparse_top_k: Optional[int] = None

# NOTE: return top k results from hybrid search. similarity_top_k is used for dense search top k

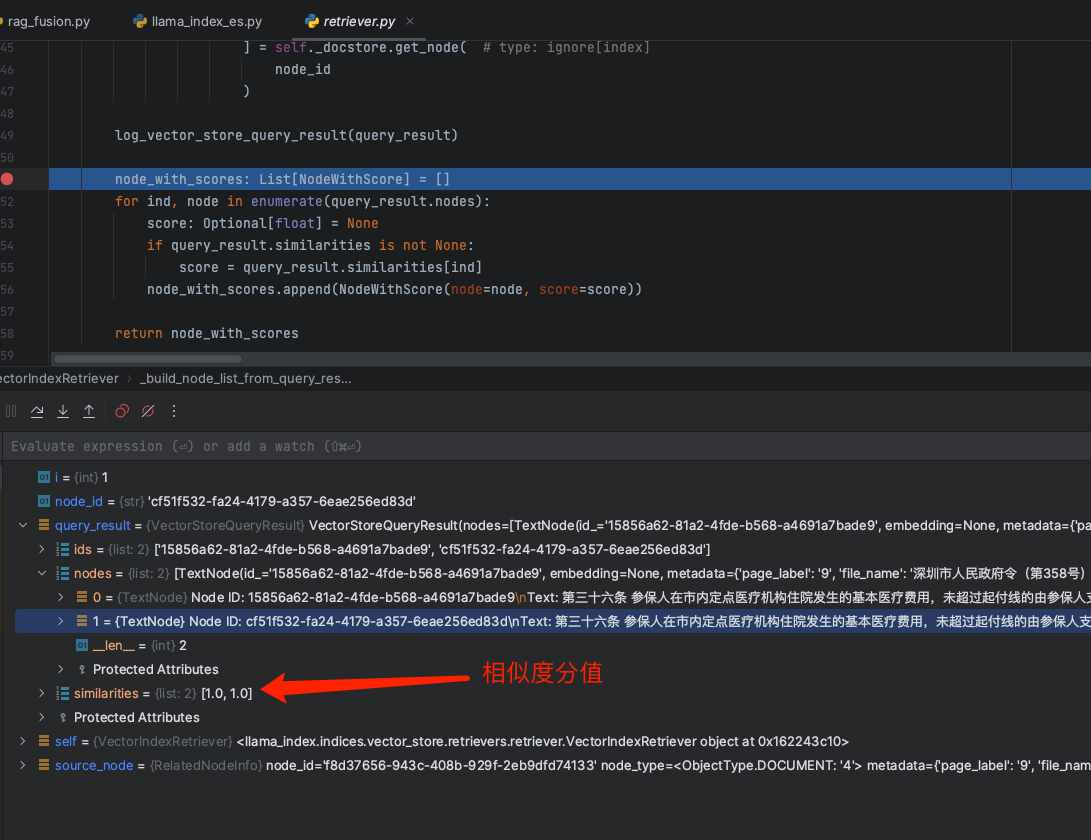

hybrid_top_k: Optional[int] = None根据query的条件,会从向量数据库中召回获取得到topk的TextNode数组,如下:

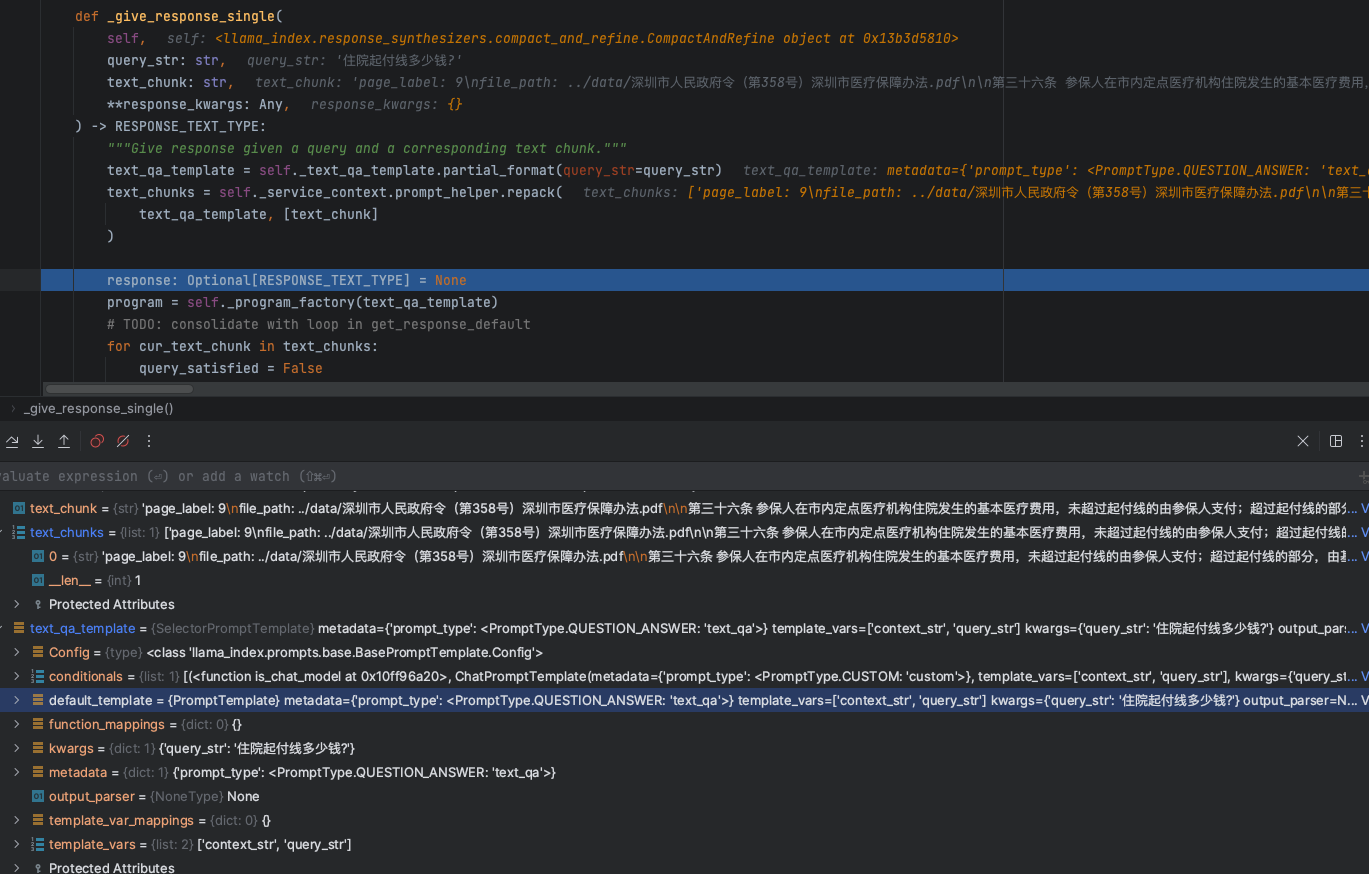

2.2.2 构建Prompt发送大模型获取答案

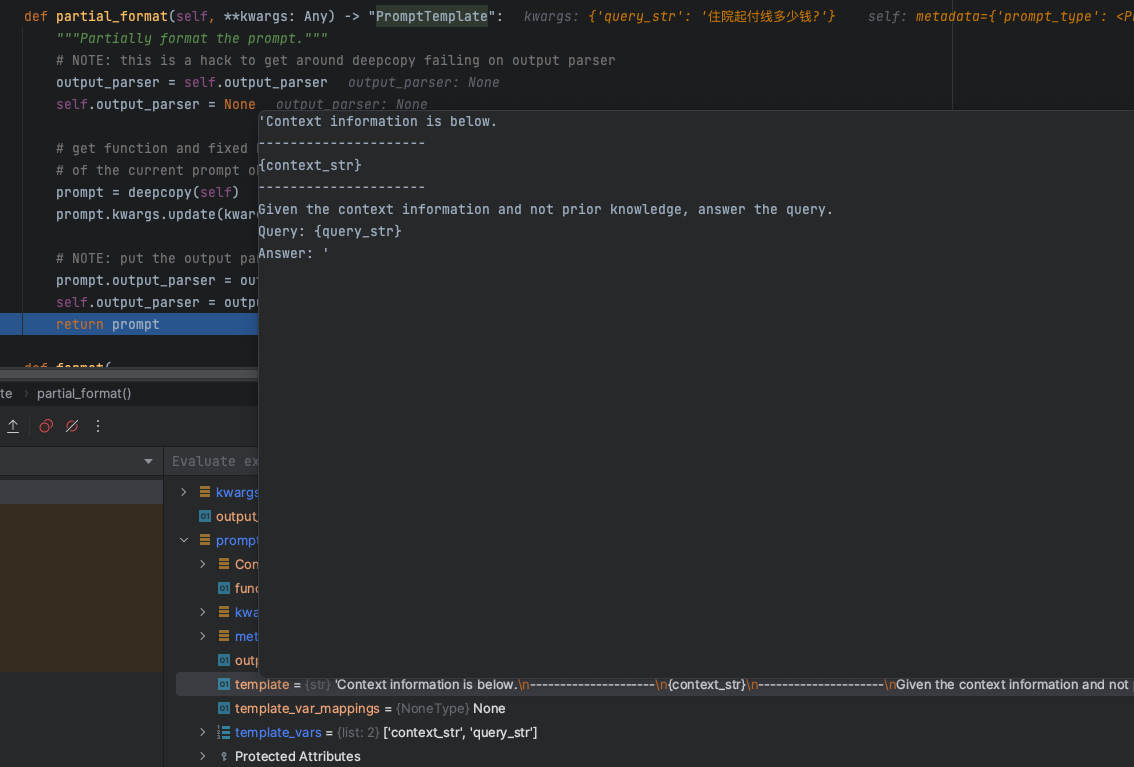

最终召回到引用文档内容后,剩下的就是构建整个大模型对话的Prompt工程,来看看LlamaIndex的基础Prompt是如何构建的

partial_format方法获取得到一个基础的Prompt模版信息,内容如下:

'Context information is below.

---------------------

{context_str}

---------------------

Given the context information and not prior knowledge, answer the query.

Query: {query_str}

Answer: '这里有两个核心的参数:

context_str: 从向量数据库召回查询的知识库引用文本数据上下文信息,从模版的设定也是告诉大模型基于知识信息进行回答query_str:用户提问的问题

而最终的context_str信息,我们可以看到,如下图:

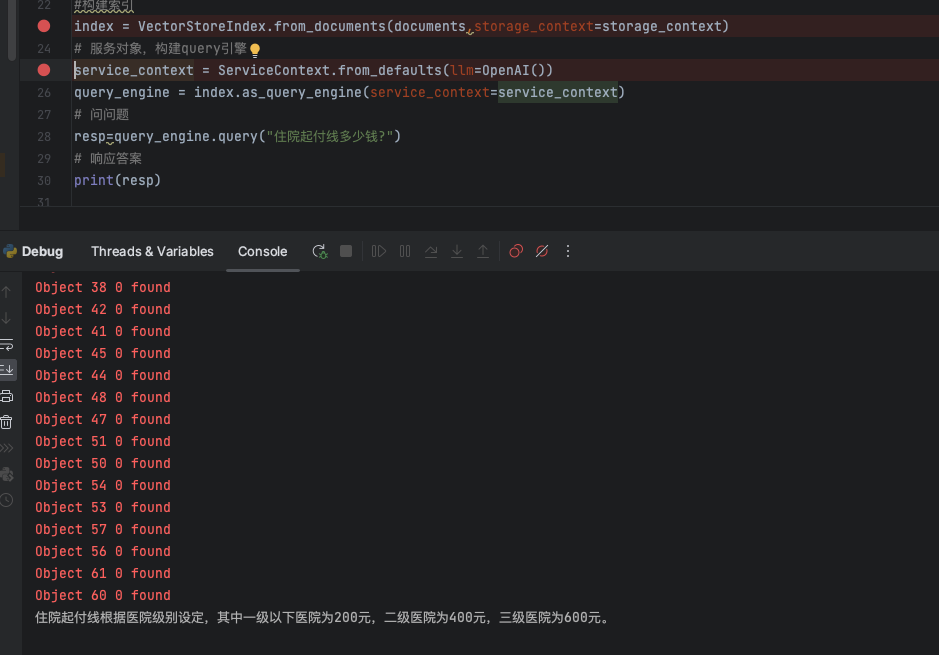

我们的问题是:住院起付线多少钱?

从最终knn检索召回的文档片段来看,精准的找到了知识库的引用内容,此时,交给大模型进行回答,获取我们想要的答案结果。

3.总结

好了,本文从LlamaIndex给我们提供的基础的示例程序,基于Basic RAG的基础架构来分析数据的处理、召回响应等过程,我们可以看到LlamaIndex框架给了我们一个很好的处理流程,从这里我们可以总结如下:

- 对于基础的RAG架构,有一个很好的认知,让开发者知道RAG是一个怎样的处理过程

- 底层的向量数据库存储结构设计和中间程序的结构设计,能够给做RAG应用的开发人员一些启发,流行的RAG框架在数据结构设计上是如何做的,这对于企业开发人员来说,架构&数据结构设计是有很重要的参考意义。

TorchV的RAG实践分享(三):解析llama_index的数据存储结构和召回策略过程的更多相关文章

- 百度APP移动端网络深度优化实践分享(三):移动端弱网优化篇

本文由百度技术团队“蔡锐”原创发表于“百度App技术”公众号,原题为<百度App网络深度优化系列<三>弱网优化>,感谢原作者的无私分享. 一.前言 网络优化解决的核心问题有三个 ...

- MQTT协议-MQTT协议解析(MQTT数据包结构)

协议就是通信双方的一个约定,即,表示第1位传输的什么.第2位传输的什么…….在MQTT协议中,一个MQTT数据包由:固定头(Fixed header). 可变头(Variable header). 消 ...

- python爬虫知识点三--解析豆瓣top250数据

一.利用cookie访问import requests headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKi ...

- tensorFlow入门实践(三)实现lenet5(代码结构优化)

这两周我学习了北京大学曹建老师的TensorFlow笔记课程,认为老师讲的很不错的,很适合于想要在短期内上手完成一个相关项目的同学,课程在b站和MOOC平台都可以找到. 在卷积神经网络一节,课程以le ...

- ABAP分享三 批量上传数据到内表简单示例

tYPE-POOLS: truxs. DATA: BEGIN OF build, name(10) TYPE c, age(3) TYPE c, sex(2) TYPE c, sp ...

- 百度APP移动端网络深度优化实践分享(一):DNS优化篇

本文由百度技术团队“蔡锐”原创发表于“百度App技术”公众号,原题为<百度App网络深度优化系列<一>DNS优化>,感谢原作者的无私分享. 一.前言 网络优化是客户端几大技术方 ...

- 百度APP移动端网络深度优化实践分享(二):网络连接优化篇

本文由百度技术团队“蔡锐”原创发表于“百度App技术”公众号,原题为<百度App网络深度优化系列<二>连接优化>,感谢原作者的无私分享. 一.前言 在<百度APP移动端网 ...

- 解析数据存储MySQL

为了适应不同项目对不同感兴趣属性的解析存储,数据存储结构采用纵向的属性列表方式,即一个url页面多个属性存储多条记录方式,并且按照text,html, data,num几大典型类型分别对应存储. 创建 ...

- WebSocket原理与实践(三)--解析数据帧

WebSocket原理与实践(三)--解析数据帧 1-1 理解数据帧的含义: 在WebSocket协议中,数据是通过帧序列来传输的.为了数据安全原因,客户端必须掩码(mask)它发送到服务器的所有 ...

- AlexeyAB DarkNet YOLOv3框架解析与应用实践(三)

AlexeyAB DarkNet YOLOv3框架解析与应用实践(三) ImageNet分类 您可以使用Darknet为1000级ImageNet挑战赛分类图像.如果你还没有安装Darknet,你应该 ...

随机推荐

- ARM 中SP,LR,PC寄存器的作用

ARM中所有寄存器都是32位的.这里以cortex-a7内核的MX6ULL处理器为例,按照功能可以分为两类:运行需要寄存器(程序正常运行所需要的,比如变量暂存,pc制作等,总共43个),系统管理控制寄 ...

- Linux 中hdparm命令参数说明

hdparm命令提供了一个命令行的接口用于读取和设置IDE或SCSI硬盘参数. 语法 hdparm(选项)(参数) 选项 -a:设定读取文件时,预先存入块区的分区数,若不加上选项,则显示目前的设定: ...

- STM32 printf 方法重定向到串口UART

在嵌入式系统中调试代码是很麻烦的一件事, 如果能方便地输出调试信息(与调试者交互), 能使极大加快问题排查的过程. 串口在嵌入式领域是一个比较重要的通讯接口. 因为没有显示设备, 在单片机的程序里调用 ...

- 解决iso方式安装win10找不到固态硬盘!!!

问题说明 朋友的一台联想小新笔记本需要安装win10,我给弄了个iso启动U盘,但是在选择安装盘时找不到笔记本的固态硬盘... 问题原因 联想的锅! 以联想为例,出厂系统的BIOS内,SATA Con ...

- 初级算法 - C++反转链表

顾名思义, 就是将链表的所有结点反转. 解释见:[剑指offer]反转链表,C++实现(链表) 代码: #include <iostream> struct NodeList { int ...

- 【Android逆向】frida 破解 滚动的天空

1. apk 安装到手机中 2. 玩十次之后,会提示 充值 3. adb shell dumpsys window | grep mCurrentFocus 查看一些当前activity是哪一个 是 ...

- django中的一些装饰器用法

1.require_http_methods() 1.要求视图只接受特定的请求方法 2.该装饰器允许传递多个请求方法参数,以列表的形式,请求方法名要大写 from django.views.decor ...

- ASP.NET Core 微信支付(二)【 发布到服务器上签名加密时报错:系统找不到指定的文件 APIV3】

参考资料 .Net微信支付退款操作"系统找不到指定的文件" 错误现象 微信支付(API v3)的统一下单接口和订单查询接口在本地调试成功,可以使用,但是发布到服务器上之后调用接口就 ...

- 【会员题】253. 会议室 II

会议室II 给定一个会议时间安排的数组,每个会议时间都会包括开始和结束的时间s1,e1,s2,e2]..](si<ei) ,为避免会议冲突,同时要考虑充分 利用会议室资源,请你计算至少需要多少间 ...

- 在矩池云使用ChatGLM-6B & ChatGLM2-6B

ChatGLM-6B 和 ChatGLM2-6B都是基于 General Language Model (GLM) 架构的对话语言模型,是清华大学 KEG 实验室和智谱 AI 公司于 2023 年共同 ...