SpringBoot系列(四)使用spring-kafka实现生产者消费者demo代码

一、引入spring-kafka的maven依赖

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

<version>2.5.4.RELEASE</version>

</dependency>方式一、创建springboot-web项目,自动引入(本文以此为例创建)

- 打开IDEA-File-New-Project,选择Spring Initializr初始化方式,Next,Next

- 选中Web中的Spring Web依赖,点击添加

- 选中Messaging中的Spring for Apache Kafka依赖,点击添加

- 创建项目

方式二、创建maven项目,手动引入

- 打开IDEA-File-New-Project,选择Maven初始化方式

- 添加如下依赖到pom.xml文件

- 经过创建启动类,构造Web环境后,剩余操作跟方式一类似。

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.5.5</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

</dependency>

</dependencies>二、生产者demo代码

step1:application.properties配置文件中,只开producer的配置,将consumer的配置注释

server.port=8080

#kafka

spring.kafka.bootstrap-servers=0.0.0.0:9092

#kafka producer

spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.value-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.acks=all

spring.kafka.producer.retries=0

#kafka consumer

#spring.kafka.consumer.group-id=group_id

#spring.kafka.consumer.enable-auto-commit=true

#spring.kafka.consumer.auto-commit-interval=5000

#spring.kafka.consumer.key-deserializer=org.apache.kafka.common.serialization.StringDeserializer

#spring.kafka.consumer.value-deserializer=org.apache.kafka.common.serialization.StringDeserializerstep2:spring会自动加载这些配置,初始化生产者,其使用方式如下:

直接调用方式

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

/**

* kafka 生产者样例代码

* @author cavan

*/

@RestController

@RequestMapping("/kafka")

public class KafkaController {

private static final Logger LOGGER = LoggerFactory.getLogger(KafkaController.class);

private static final String TOPIC = "topic-test";

@Autowired

private KafkaTemplate<String, String> kafkaTemplate;

@PostMapping(value = "/publish")

public String sendMessageTokafkaTopic(@RequestParam("message") String message) {

LOGGER.info(String.format("------ Producing message ------ %s", message));

kafkaTemplate.send(TOPIC, message);

return "ok";

}

}封装后调用

封装代码

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.stereotype.Service;

/**

* kafka producer

*

* @author cavan

*/

@Service

public class Producer {

private static final Logger LOGGER = LoggerFactory.getLogger(Producer.class);

@Autowired

private KafkaTemplate<String, String> kafkaTemplate;

public void sendMessage(String topic, String message) {

LOGGER.info(String.format("Producing message is: %s", message));

kafkaTemplate.send(topic, message);

}

}调用代码

import com.example.demo.kafka.Producer;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

/**

* kafka send message

*

* @author cavan

*/

@RestController

@RequestMapping("/kafka")

public class KafkaController {

private static final Logger LOGGER = LoggerFactory.getLogger(KafkaController.class);

private static final String TOPIC = "topic-test";

@Autowired

private Producer producer;

@PostMapping(value = "/producer")

public String sendMessageTokafka(@RequestParam("message") String message) {

LOGGER.info(String.format("------ Producing message ------ %s", message));

producer.sendMessage(TOPIC, message);

return "ok";

}

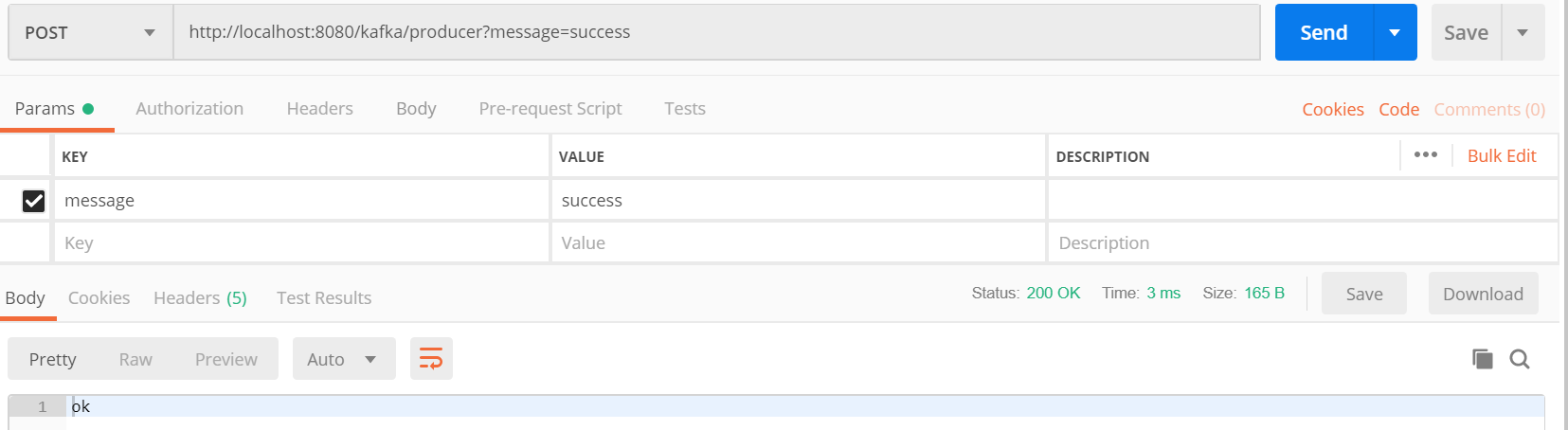

}postman调用接口测试

生产者日志:

2021-10-08 19:26:50.205 INFO 20836 --- [nio-8080-exec-2] c.e.demo.controller.KafkaController : ------ Producing message ------ success

三、消费者demo代码

step1:application.properties配置文件中,增加consumer的配置

server.port=8080

#kafka

spring.kafka.bootstrap-servers=0.0.0.0:9092

#kafka producer

spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.value-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.acks=all

spring.kafka.producer.retries=0

#kafka consumer

spring.kafka.consumer.group-id=group_id

spring.kafka.consumer.enable-auto-commit=true

spring.kafka.consumer.auto-commit-interval=5000

spring.kafka.consumer.key-deserializer=org.apache.kafka.common.serialization.StringDeserializer

spring.kafka.consumer.value-deserializer=org.apache.kafka.common.serialization.StringDeserializerstep2:spring会自动加载这些配置,初始化消费者,其使用方式如下:

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.stereotype.Service;

/**

* kafka consumer demo

*

* @author cavan

*/

@Service

public class Consumer {

private static final Logger LOGGER = LoggerFactory.getLogger(Consumer.class);

@KafkaListener(id = "test", topics = "topic-test")

public void listen(ConsumerRecord<?, ?> record) {

LOGGER.info(

"topic ={},partition={},offset={},customer={},value={}",

record.topic(),

record.partition(),

record.offset(),

record.key(),

record.value());

}

}消费成功日志:

2021-10-08 19:55:23.004 INFO 11340 --- [nio-8080-exec-2] o.a.kafka.common.utils.AppInfoParser : Kafka version: 2.7.1

2021-10-08 19:55:23.004 INFO 11340 --- [nio-8080-exec-2] o.a.kafka.common.utils.AppInfoParser : Kafka commitId: 61dbce85d0d41457

2021-10-08 19:55:23.004 INFO 11340 --- [nio-8080-exec-2] o.a.kafka.common.utils.AppInfoParser : Kafka startTimeMs: 1633694123004

2021-10-08 19:55:23.117 INFO 11340 --- [ad | producer-1] org.apache.kafka.clients.Metadata : [Producer clientId=producer-1] Cluster ID: Lx7DFjG5SYuOLlJKtz2NCQ

2021-10-08 19:55:23.236 INFO 11340 --- [ test-0-C-1] com.example.demo.kafka.Consumer : topic =topic-test,partition=0,offset=31,customer=null,value=success

SpringBoot系列(四)使用spring-kafka实现生产者消费者demo代码的更多相关文章

- Linux 进程间通信(包含一个经典的生产者消费者实例代码)

前言:编写多进程程序时,有时不可避免的需要在多个进程之间传递数据,我们知道,进程的用户的地址空间是独立,父进程中对数据的修改并不会反映到子进程中,但内核是共享的,大多数进程间通信方式都是在内核中建立一 ...

- Java 学习笔记 使用并发包ReentrantLock简化生产者消费者模式代码

说明 ReentrantLock是java官方的一个线程锁类,ReentarntLock实现了Lock的接口 我们只需要使用这个,就可以不用使用synchronized同步关键字以及对应的notify ...

- 生产者消费者demo

using System; using System.Collections.Generic; using System.Threading; namespace 生产者消费者 { class Pro ...

- springboot系列四、配置模板引擎、配置热部署

一.配置模板引擎 在之前所见到的信息显示发现都是以 Rest 风格进行显示,但是很明显在实际的开发之中,所有数据的显示最终都应该交由页面完成,但是这个页面并不是*.jsp 页面,而是普通的*.html ...

- SpringBoot系列四:SpringBoot开发(改变环境属性、读取资源文件、Bean 配置、模版渲染、profile 配置)

声明:本文来源于MLDN培训视频的课堂笔记,写在这里只是为了方便查阅. 1.概念 SpringBoot 开发深入 2.具体内容 在之前已经基本上了解了整个 SpringBoot 运行机制,但是也需要清 ...

- Spring系列(四):Spring AOP详解和实现方式(xml配置和注解配置)

参考文章:http://www.cnblogs.com/hongwz/p/5764917.html 一.什么是AOP AOP(Aspect Oriented Programming),即面向切面编程, ...

- springboot系列四:springboot整合mybatis jsp

一.用IDEA 创建maven项目 项目目录结构 1.添加pom jar依赖 <?xml version="1.0" encoding="UTF-8"?& ...

- 基于Kafka的生产者消费者消息处理本地调试

(尊重劳动成果,转载请注明出处:http://blog.csdn.net/qq_25827845/article/details/68174111冷血之心的博客) Kafka下载地址:http://d ...

- java kafka 生产者消费者demo

一.修改kafka server.porperties的ip是你本机的ip listeners=PLAINTEXT://192.168.111.130:9092 二.生产者的例子 import o ...

- [b0029] python 归纳 (十四)_队列Queue实现生产者消费者

# -*- coding: UTF-8 -*- """ 多线程的生产者,消费者 使用队列Queue """ import Queue imp ...

随机推荐

- FasterViT:英伟达提出分层注意力,构造高吞吐CNN-ViT混合网络 | ICLR 2024

论文设计了新的CNN-ViT混合神经网络FasterViT,重点关注计算机视觉应用的图像吞吐能力.FasterViT结合CNN的局部特征学习的特性和ViT的全局建模特性,引入分层注意力(HAT)方法在 ...

- 谢老师2024春 - Day2:期望DP

Day2:期望DP A - CF148D Bag of mice 设 \(dp_{i,j}\) 表示还剩下 \(i\) 只白鼠,\(j\) 只黑鼠 A 的胜率. 大家都没有拿到白鼠,那么 B 赢, ...

- KubeDL 加入 CNCF Sandbox,加速 AI 产业云原生化

简介: 2021 年 6 月 23 日,云原生计算基金会(CNCF)宣布通过全球 TOC 投票接纳 KubeDL 成为 CNCF Sandbox 项目.KubeDL 是阿里开源的基于 Kuberne ...

- [FAQ] Solidity 并发执行 ? 重入攻击 ?

Solidity 实现的合约中,函数操作都是原子操作,旷工本地执行,取得共识后发布到区块链上. 实际发布到区块链上的不存在并发,全节点同步状态到本地. Solidity 中有三种方式进行转账,addr ...

- UWP WinRT 使用系统自带的分词库对字符串文本进行分词

本文将和大家介绍在 UWP 应用,或其他能接入 WinRT 的应用里,使用系统自带的分词库,对中文.英文等等自然语言的字符串文本进行分词 开始之前需要说明的是,现在不仅仅 UWP 应用,其他的 UI ...

- WPF 已知问题 dotnet 6 设置 InvariantGlobalization 之后将丢失默认绑定转换导致 XAML 抛出异常

在设置了 InvariantGlobalization 为 true 之后,将会发现原本能正常工作的 XAML 可能就会抛出异常.本文将告诉大家此问题的原因 这是有开发者在 WPF 仓库上给我报告的 ...

- 2018-2-13-win10-uwp-从StorageFile获取文件大小

title author date CreateTime categories win10 uwp 从StorageFile获取文件大小 lindexi 2018-2-13 17:23:3 +0800 ...

- K8s应用---配置管理中心configmap和Secret(13)

一.Configmap概述 1.1 什么是configmap Configmap 是 k8s 中的资源对象,用于保存非机密性的配置的,数据可以用 key/value 键值对的形式保存,也可通过文件的形 ...

- vue+vant+js实现购物车原理小demo(基础版)

电商毕业设计里的一个购物车demo,拿vue+vant需要写的核心计算代码只有12行.效果图: main.js: Vue.use(Stepper); .vue文件 <template> & ...

- Gradle8.4构建SpringBoot多模块项目

Gradle8.4构建SpringBoot多模块项目 一.基本 1.版本 这个版本是Jdk8最后一个SpringBoot版本 软件 版本 Gradle 8.4 SpringBoot 2.7.15 JD ...