基于 KubeVela 的机器学习实践

简介:本文主要介绍如何使用 KubeVela 的 AI 插件,来帮助工程师更便捷地完成模型训练及模型服务。

作者:KubeVela 社区

在机器学习浪潮迸发的当下,AI 工程师除了需要训练、调试自己的模型之外,还需要将模型进行部署上线,从而验证模型的效果(当然,有的时候,这部分工作由 AI 系统工程师来完成)。这一部分工作对于 AI 工程师们来说是繁琐、且消耗额外精力的。

而在云原生时代,我们的模型训练和模型服务也通常在云上进行。这样做不仅提高了可扩展性,还能够提升资源的利用率。这对于需要消耗大量计算资源的机器学习场景来说,是十分有效的。

但是 AI 工程师要想使用云原生的能力通常比较困难。随着时间的推移,云原生的概念已经越来越复杂。想要在云原生之上部署一个简单的模型服务,可能对于 AI 工程师来说,需要额外学习数种概念:比如 Deployment、Service、Ingress 等。

而 KubeVela 作为一个简单、易用、且高可扩展的云原生应用管理工具,能让开发人员方便快捷地在 Kubernetes 上定义与交付应用,无需了解任何底层云原生基础设施相关的细节。KubeVela 拥有着丰富的可扩展性,其 AI 插件提供了模型训练、模型服务、A/B 测试等功能,覆盖了 AI 工程师的基本需求,能够帮助 AI 工程师快速在云原生环境中进行模型训练和模型服务。

本文主要介绍如何使用 KubeVela 的 AI 插件,来帮助工程师更便捷地完成模型训练及模型服务。

KubeVela AI 插件

KubeVela AI 插件分为模型训练和模型服务两个插件,模型训练插件基于 KubeFlow 的 training-operator,能够支持如 TensorFlow、PyTorch、MXNet 等不同框架的分布式模型训练。而模型服务插件基于 Seldon Core,可以便捷地使用模型启动模型服务,同时也支持流量分发,A/B 测试等高级功能。

通过 KubeVela AI 插件,可以大大简化模型训练任务的部署以及模型服务的部署,同时,可以将模型训练、模型服务等过程与 KubeVela 本身的工作流、多集群等功能相结合,从而完成生产可用的服务部署。

注:你可以在 KubeVela Samples[1] 中找到所有的源码和 YAML 文件。如果你想使用在这个例子中预训练的模型,文件夹中的 style-model.yaml 和 color-model.yaml 会将模型复制到 PVC 中。

模型训练

首先启动模型训练和模型服务的两个插件。

vela addon enable model-training

vela addon enable model-serving

模型训练中包含 model-training 和 jupyter-notebook 两个组件类型, 模型服务中包含 model-serving 这个组件类型。可以通过 vela show 命令来查看这三个组件中的具体参数。

你也可以选择查阅 KubeVela AI 插件文档[2], 来获取更多信息。

vela show model-training

vela show jupyter-notebook

vela show model-serving

我们来训练一个简单的使用 TensorFlow 框架的模型,这个模型的效果是能够将灰色的图片变成彩色的。部署如下 YAML 文件:

注:模型训练的源码来源于:emilwallner/Coloring-greyscale-images[3]

apiVersion: core.oam.dev/v1beta1

kind: Application

metadata:

name: training-serving

namespace: default

spec:

components:

# 训练模型

- name: demo-training

type: model-training

properties:

# 训练模型的镜像

image: fogdong/train-color:v1

# 模型训练的框架

framework: tensorflow

# 声明存储,将模型持久化。此处会使用集群内的默认 storage class 来创建 PVC

storage:

- name: "my-pvc"

mountPath: "/model"

此时, KubeVela 将拉起一个 TFJob 进行模型训练。

仅仅是训练模型很难看出效果,我们修改一下这个 YAML 文件,将模型服务放到模型训练的步骤之后。同时,因为模型服务会直接启动模型,而模型的输入输出不太直观(ndarray 或者 Tensor),因此,我们再部署一个测试服务来调用服务,并将结果转换成图像。

部署如下 YAML 文件:

apiVersion: core.oam.dev/v1beta1

kind: Application

metadata:

name: training-serving

namespace: default

spec:

components:

# 训练模型

- name: demo-training

type: model-training

properties:

image: fogdong/train-color:v1

framework: tensorflow

storage:

- name: "my-pvc"

mountPath: "/model" # 启动模型服务

- name: demo-serving

type: model-serving

# 模型服务会在模型训练完成后启动

dependsOn:

- demo-training

properties:

# 启动模型服务使用的协议,可以不填,默认使用 seldon 自身的协议

protocol: tensorflow

predictors:

- name: model

# 模型服务的副本数

replicas: 1

graph:

# 模型名

name: my-model

# 模型框架

implementation: tensorflow

# 模型地址,上一步会将训练完的模型保存到 my-pvc 这个 pvc 当中,所以通过 pvc://my-pvc 指定模型的地址

modelUri: pvc://my-pvc # 测试模型服务

- name: demo-rest-serving

type: webservice

# 测试服务会在模型训练完成后启动

dependsOn:

- demo-serving

properties:

image: fogdong/color-serving:v1

# 使用 LoadBalancer 暴露对外地址,方便调用

exposeType: LoadBalancer

env:

- name: URL

# 模型服务的地址

value: http://ambassador.vela-system.svc.cluster.local/seldon/default/demo-serving/v1/models/my-model:predict

ports:

# 测试服务的端口

- port: 3333

expose: true

部署之后,通过 vela ls 来查看应用的状态:

$ vela ls training-serving demo-training model-training running healthy Job Succeeded 2022-03-02 17:26:40 +0800 CST

├─ demo-serving model-serving running healthy Available 2022-03-02 17:26:40 +0800 CST

└─ demo-rest-serving webservice running healthy Ready:1/1 2022-03-02 17:26:40 +0800 CST

可以看到,应用已经正常启动。通过 vela status <app-name> --endpoint 来查看应用的服务地址。

$ vela status training-serving --endpoint +---------+-----------------------------------+---------------------------------------------------+

| CLUSTER | REF(KIND/NAMESPACE/NAME) | ENDPOINT |

+---------+-----------------------------------+---------------------------------------------------+

| | Service/default/demo-rest-serving | tcp://47.251.10.177:3333 |

| | Service/vela-system/ambassador | http://47.251.36.228/seldon/default/demo-serving |

| | Service/vela-system/ambassador | https://47.251.36.228/seldon/default/demo-serving |

+---------+-----------------------------------+---------------------------------------------------+

该应用有三个服务地址,第一个是我们的测试服务的地址,第二个和第三都是原生模型的地址。我们可以调用测试服务来查看模型的效果:测试服务会读取图像的内容,并将其转成 Tensor 并请求模型服务,最后将模型服务返回的 Tensor 转成图像返回。

我们选择一张黑白的女性图片作为输入:

请求后,可以看到,输出了一张彩色图片:

模型服务:灰度测试

除了直接启动模型服务,我们还可以在一个模型服务中使用多个版本的模型,并对其分配不同的流量以进行灰度测试。

部署如下 YAML,可以看到,v1 版本的模型和 v2 版本的模型都设置为了 50% 的流量。同样,我们在模型服务后面部署一个测试服务:

apiVersion: core.oam.dev/v1beta1

kind: Application

metadata:

name: color-serving

namespace: default

spec:

components:

- name: color-model-serving

type: model-serving

properties:

protocol: tensorflow

predictors:

- name: model1

replicas: 1

# v1 版本的模型流量为 50

traffic: 50

graph:

name: my-model

implementation: tensorflow

# 模型地址,在 color-model 这个 pvc 中 /model/v1 路径下存放了我们的 v1 版本模型,所以通过 pvc://color-model/model/v1 指定模型的地址

modelUri: pvc://color-model/model/v1

- name: model2

replicas: 1

# v2 版本的模型流量为 50

traffic: 50

graph:

name: my-model

implementation: tensorflow

# 模型地址,在 color-model 这个 pvc 中 /model/v2 路径下存放了我们的 v2 版本模型,所以通过 pvc://color-model/model/v2 指定模型的地址

modelUri: pvc://color-model/model/v2

- name: color-rest-serving

type: webservice

dependsOn:

- color-model-serving

properties:

image: fogdong/color-serving:v1

exposeType: LoadBalancer

env:

- name: URL

value: http://ambassador.vela-system.svc.cluster.local/seldon/default/color-model-serving/v1/models/my-model:predict

ports:

- port: 3333

expose: true

当模型部署完成后,通过 vela status <app-name> --endpoint 查看模型服务的地址:

$ vela status color-serving --endpoint +---------+------------------------------------+----------------------------------------------------------+

| CLUSTER | REF(KIND/NAMESPACE/NAME) | ENDPOINT |

+---------+------------------------------------+----------------------------------------------------------+

| | Service/vela-system/ambassador | http://47.251.36.228/seldon/default/color-model-serving |

| | Service/vela-system/ambassador | https://47.251.36.228/seldon/default/color-model-serving |

| | Service/default/color-rest-serving | tcp://47.89.194.94:3333 |

+---------+------------------------------------+----------------------------------------------------------+

使用一张黑白的城市图片请求模型:

可以看到,第一次请求的结果如下。虽然天空和地面都被渲染成彩色了,但是城市本身还是黑白的:

再次请求,可以看到,这次请求的结果中,天空、地面和城市都被渲染成了彩色:

通过对不同版本的模型进行流量分发,可以帮助我们更好地对模型结果进行判断。

模型服务:A/B 测试

同样一张黑白的图片,我们既可以通过模型将其变成彩色的,也可以通过上传另一张风格图片,对原图进行风格迁移。

对于用户来说,究竟是彩色的图片好还是不同风格的图片更胜一筹?我们可以通过进行 A/B 测试,来探索这个问题。

部署如下 YAML,通过设置 customRouting,将 Header 中带有 style: transfer 的请求,转发到风格迁移的模型。同时,使这个风格迁移的模型与彩色化的模型共用一个地址。

注:风格迁移的模型来源于 TensorFlow Hub[4]

apiVersion: core.oam.dev/v1beta1

kind: Application

metadata:

name: color-style-ab-serving

namespace: default

spec:

components:

- name: color-ab-serving

type: model-serving

properties:

protocol: tensorflow

predictors:

- name: model1

replicas: 1

graph:

name: my-model

implementation: tensorflow

modelUri: pvc://color-model/model/v2

- name: style-ab-serving

type: model-serving

properties:

protocol: tensorflow

# 风格迁移的模型需要的时间较长,设置超时时间使请求不会被超时

timeout: "10000"

customRouting:

# 指定自定义 Header

header: "style: transfer"

# 指定自定义路由

serviceName: "color-ab-serving"

predictors:

- name: model2

replicas: 1

graph:

name: my-model

implementation: tensorflow

modelUri: pvc://style-model/model

- name: ab-rest-serving

type: webservice

dependsOn:

- color-ab-serving

- style-ab-serving

properties:

image: fogdong/style-serving:v1

exposeType: LoadBalancer

env:

- name: URL

value: http://ambassador.vela-system.svc.cluster.local/seldon/default/color-ab-serving/v1/models/my-model:predict

ports:

- port: 3333

expose: true

部署成功后,通过 vela status <app-name> --endpoint 查看模型服务的地址:

$ vela status color-style-ab-serving --endpoint +---------+---------------------------------+-------------------------------------------------------+

| CLUSTER | REF(KIND/NAMESPACE/NAME) | ENDPOINT |

+---------+---------------------------------+-------------------------------------------------------+

| | Service/vela-system/ambassador | http://47.251.36.228/seldon/default/color-ab-serving |

| | Service/vela-system/ambassador | https://47.251.36.228/seldon/default/color-ab-serving |

| | Service/vela-system/ambassador | http://47.251.36.228/seldon/default/style-ab-serving |

| | Service/vela-system/ambassador | https://47.251.36.228/seldon/default/style-ab-serving |

| | Service/default/ab-rest-serving | tcp://47.251.5.97:3333 |

+---------+---------------------------------+-------------------------------------------------------+

这个应用中,两个服务各自有两个地址,但是第二个 style-ab-serving 的模型服务地址是无效的,因为这个模型服务已经被指向了 color-ab-serving 的地址中。同样,我们通过请求测试服务来查看模型效果。

首先,在不加 header 的情况下,图像会从黑白变为彩色:

我们添加一个海浪的图片作为风格渲染:

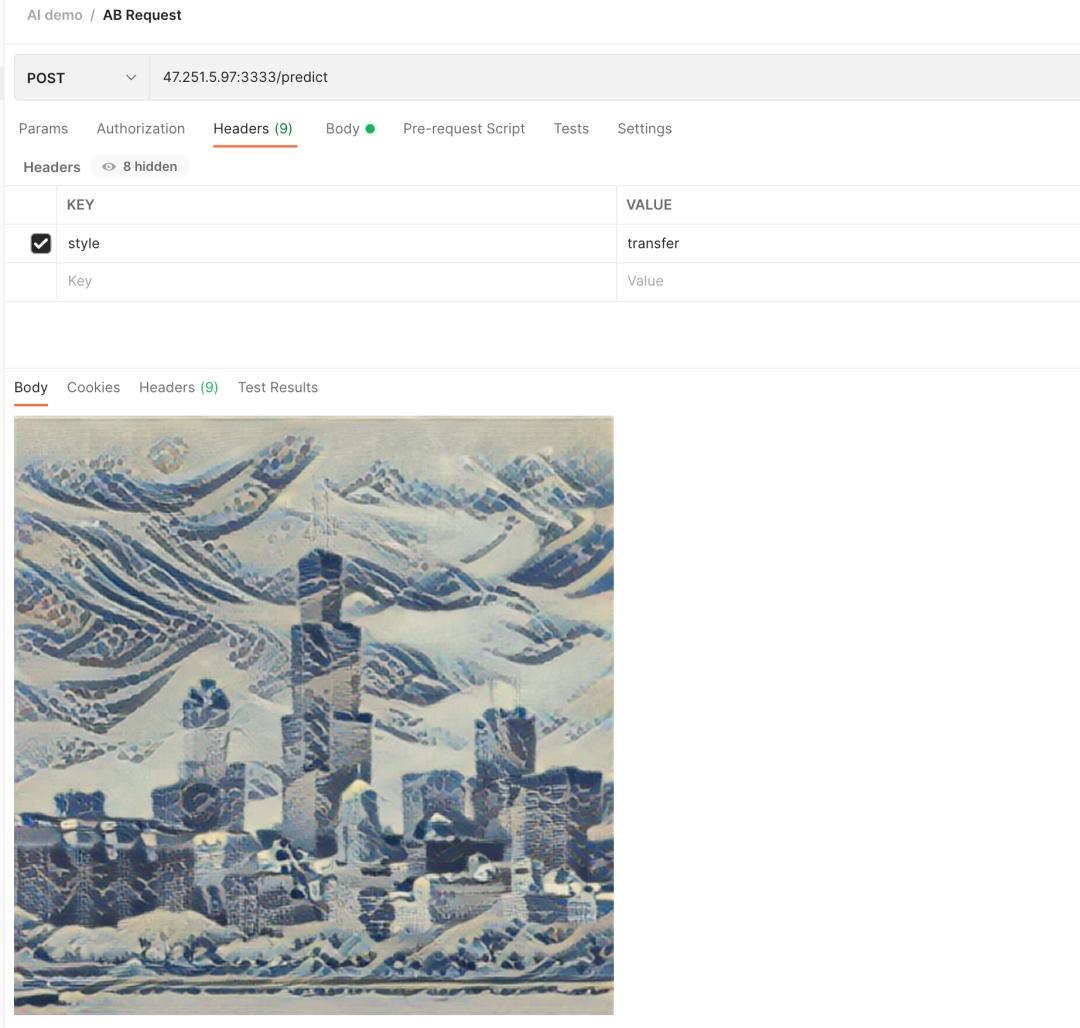

我们为本次请求加上 style: transfer 的 Header,可以看到,城市变成了海浪风格:

我们还可以使用一张水墨画的图片作为风格渲染:

可以看到,这次城市变成了水墨画风格:

总结

通过 KubeVela 的 AI 插件,可以帮助你更便捷地进行模型训练与模型服务。

除此之外,通过与 KubeVela 的结合,我们还能将测试完效果的模型通过 KubeVela 的多环境功能,下发到不同的环境中,从而实现模型的灵活部署。

相关链接

[1] KubeVela Samples

samples/11.Machine_Learning_Demo at master · oam-dev/samples · GitHub

[2] KubeVela AI 插件文档

[3] emilwallner/Coloring-greyscale-images

https://github.com/emilwallner/Coloring-greyscale-images

[4]TensorFlow Hub

https://tfhub.dev/google/magenta/arbitrary-image-stylization-v1-256/2

本文为阿里云原创内容,未经允许不得转载。

基于 KubeVela 的机器学习实践的更多相关文章

- Python机器学习实践与Kaggle实战(转)

https://mlnote.wordpress.com/2015/12/16/python%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E5%AE%9E%E8%B7%B5 ...

- Python机器学习实践指南pdf (中文版带书签)、原书代码、数据集

Python机器学习实践指南 目 录 第1章Python机器学习的生态系统 1 1.1 数据科学/机器学习的工作 流程 2 1.1.1 获取 2 1.1.2 检查和探索 2 1.1.3 清理和准备 3 ...

- 基于Python的机器学习实战:KNN

1.KNN原理: 存在一个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一个数据与所属分类的对应关系.输入没有标签的新数据后,将新数据的每个特征与样本集中数据对应 ...

- Spark学习之基于MLlib的机器学习

Spark学习之基于MLlib的机器学习 1. 机器学习算法尝试根据训练数据(training data)使得表示算法行为的数学目标最大化,并以此来进行预测或作出决定. 2. MLlib完成文本分类任 ...

- 机器学习实践:《Python机器学习实践指南》中文PDF+英文PDF+代码

机器学习是近年来渐趋热门的一个领域,同时Python 语言经过一段时间的发展也已逐渐成为主流的编程语言之一.<Python机器学习实践指南>结合了机器学习和Python 语言两个热门的领域 ...

- 资源|《美团机器学习实践》PDF+思维导图

今天再给大家推荐一本由美团算法团队出版的<美团机器学习实践>,下载链接见文末. 美团算法团队由数百名优秀算法工程师组成,负责构建美团这个生活服务互联网大平台的"大脑", ...

- 《百面机器学习算法工程师带你去面试》高清PDF及epub+《美团机器学习实践》PDF及思维导图

http://blog.sina.com.cn/s/blog_ecd882db0102yuek.html <百面机器学习算法工程师带你去面试>高清PDF及epub+<美团机器学习实践 ...

- 招商银行 KubeVela 离线部署实践

招商银行云平台开发团队自 2021 年开始接触 KubeVela,并探索 KubeVela 在招商银行云平台的落地实践,借此提升云原生应用交付与管理能力.同时因为金融保险行业的特殊性,网络安全管控措施 ...

- 基于 GraphQL 的 BFF 实践

随着软件工程的发展,系统架构越来越复杂,分层越来越多,分工也越来越细化.我们知道,互联网是离用户最近的行业,前端页面可以说无时无刻不在变化.前端本质上还是用户交互和数据展示,页面的高频变化意味着对数据 ...

- 机器学习实践之K-近邻算法实践学习

关于本文说明,本人原博客地址位于http://blog.csdn.net/qq_37608890,本文来自笔者于2017年12月04日 22:54:26所撰写内容(http://blog.csdn.n ...

随机推荐

- Spring boot返回时间与MySql数据库中不相同问题及解决方法

最近做项目测试的发现,访问Url返回的时间与数据库中的不相同,环境是Spring boot+MyBatis+Mysql(阿里云服务器),经过一番折腾,得到了解决 问题描述 我是直接使用IDEA的数据库 ...

- HMAC算法:数据传输的保护神

HMAC算法起源: HMAC(Hash-based Message Authentication Code)算法是由Mihir Bellare.Ran Canetti和Hugo Krawczyk于19 ...

- 引领汽车营销新趋势,3DCAT实时云渲染助力汽车三维可视化

当前,汽车产业发展正从电动化的上半场,向智能化的下半场迈进.除了车机技术体验的智能化之外,观车体验的智能化也不容忽视. 这是因为,随着数字化.智能化.个性化的趋势,消费者对汽车的需求和期待也越来越高, ...

- Linux快速入门(一)Linux基础知识

我的环境:Ubuntu(后面涉及到的Linux均为Debian系列) Linux不同发行版的包管理方式 (1)Redhat系列:Redhat系列的包管理方式采用的是基于RPM包的YUM包管理方式 (2 ...

- RSA算法揭秘:加密世界的守护者

RSA算法起源: RSA算法是由Ron Rivest.Adi Shamir和Leonard Adleman在1977年共同提出的.它是一种非对称加密算法,基于两个大素数的乘积难以分解的数论问题.RSA ...

- 使用Channel传递数据

上次我们使用了事件异步传递数据,这次我们使用Channel在一个线程通信传递数据 直接上代码 public static class ChannelSample { private static re ...

- 记录--整会promise这8个高级用法

这里给大家分享我在网上总结出来的一些知识,希望对大家有所帮助 发现很多人还只会promise常规用法 在js项目中,promise的使用应该是必不可少的,但我发现在同事和面试者中,很多中级或以上的前端 ...

- KingbaseES V8R6集群运维案例之---securecmdd工具usePAM配置

案例说明: 默认在部署securecmdd工具后,在配置文件securecmdd_config中配置参数usePAM=yes,在有的系统主机环境,会导致securecmd客户端连接失败. 适用版本: ...

- KingbaseES file_dw 介绍

file_dw简介 file_fdw模块提供外部数据包装器file_fdw, 它能被用来访问服务器的文件系统中的数据文件,或者在服务器上执行程序并读取它们的输出. 数据文件或程序输出必须是能够被C ...

- Python爬取腾讯视频电影名称和链接(一)

1 import requests 2 import json 3 from bs4 import BeautifulSoup #网页解析获取数据 4 import sys 5 import re 6 ...