python3 爬虫---爬取豆瓣电影TOP250

第一次爬取的网站就是豆瓣电影 Top 250,网址是:https://movie.douban.com/top250?start=0&filter=

分析网址'?'符号后的参数,第一个参数'start=0',这个代表页数,‘=0’时代表第一页,‘=25’代表第二页。。。以此类推

一、分析网页:

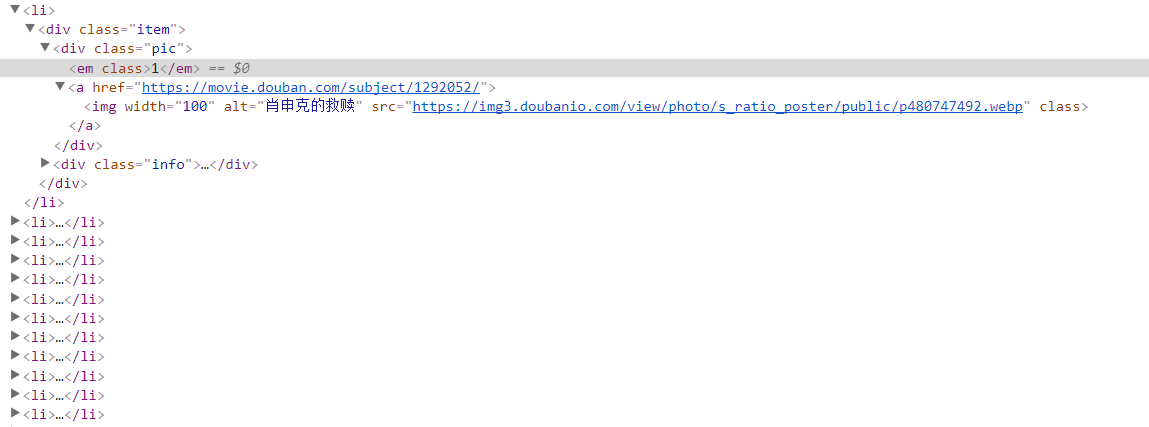

明确要爬取的元素 :排名、名字、导演、评语、评分,在这里利用Chrome浏览器,查看元素的所在位置

每一部电影信息都在<li></li>当中

爬取元素的所在位置

分析完要爬取的元素,开始准备爬取的工作

二、爬取部分:

工具:

Python3

requests

BeautifulSoup

1、获取每一部电影的信息

def get_html(web_url): # 爬虫获取网页没啥好说的

header = {

"User-Agent":"Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US) AppleWebKit/534.16 (KHTML, like Gecko) Chrome/10.0.648.133 Safari/534.16"}

html = requests.get(url=web_url, headers=header).text#不加text返回的是response,加了返回的是字符串

Soup = BeautifulSoup(html, "lxml")

data = Soup.find("ol").find_all("li") # 还是有一点要说,就是返回的信息最好只有你需要的那部分,所以这里进行了筛选

return data

requests.get()函数,会根据参数中url的链接,返回response对象

.text会将response对象转换成str类型

find_all()函数,会将html文本中的ol标签下的每一个li标签中的内容筛选出来

2、筛选出信息,保存进文本

def get_info(all_move):

f = open("F:\\Pythontest1\\douban.txt", "a") for info in all_move:

# 排名

nums = info.find('em')

num = nums.get_text() # 名字

names = info.find("span") # 名字比较简单 直接获取第一个span就是

name = names.get_text() # 导演

charactors = info.find("p") # 这段信息中有太多非法符号你需要替换掉

charactor = charactors.get_text().replace(" ", "").replace("\n", "") # 使信息排列规律

charactor = charactor.replace("\xa0", "").replace("\xee", "").replace("\xf6", "").replace("\u0161", "").replace(

"\xf4", "").replace("\xfb", "").replace("\u2027", "").replace("\xe5", "") # 评语

remarks = info.find_all("span", {"class": "inq"})

if remarks: # 这个判断是因为有的电影没有评语,你需要做判断

remark = remarks[0].get_text().replace("\u22ef", "")

else:

remark = "此影片没有评价"

print(remarks) # 评分

scores = info.find_all("span", {"class": "rating_num"})

score = scores[0].get_text() f.write(num + '、')

f.write(name + "\n")

f.write(charactor + "\n")

f.write(remark + "\n")

f.write(score)

f.write("\n\n") f.close() # 记得关闭文件

注意爬取元素的时候,会有非法符号(因为这些符号的存在,会影响你写入文本中),所以需要将符号用replace函数替换

其余的部分就不做解释了~~

3、全部代码

from bs4 import BeautifulSoup

import requests

import os def get_html(web_url): # 爬虫获取网页没啥好说的

header = {

"User-Agent":"Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US) AppleWebKit/534.16 (KHTML, like Gecko) Chrome/10.0.648.133 Safari/534.16"}

html = requests.get(url=web_url, headers=header).text#不加text返回的是response,加了返回的是字符串

Soup = BeautifulSoup(html, "lxml")

data = Soup.find("ol").find_all("li") # 还是有一点要说,就是返回的信息最好只有你需要的那部分,所以这里进行了筛选

return data def get_info(all_move):

f = open("F:\\Pythontest1\\douban.txt", "a") for info in all_move:

# 排名

nums = info.find('em')

num = nums.get_text() # 名字

names = info.find("span") # 名字比较简单 直接获取第一个span就是

name = names.get_text() # 导演

charactors = info.find("p") # 这段信息中有太多非法符号你需要替换掉

charactor = charactors.get_text().replace(" ", "").replace("\n", "") # 使信息排列规律

charactor = charactor.replace("\xa0", "").replace("\xee", "").replace("\xf6", "").replace("\u0161", "").replace(

"\xf4", "").replace("\xfb", "").replace("\u2027", "").replace("\xe5", "") # 评语

remarks = info.find_all("span", {"class": "inq"})

if remarks: # 这个判断是因为有的电影没有评语,你需要做判断

remark = remarks[0].get_text().replace("\u22ef", "")

else:

remark = "此影片没有评价"

print(remarks) # 评分

scores = info.find_all("span", {"class": "rating_num"})

score = scores[0].get_text() f.write(num + '、')

f.write(name + "\n")

f.write(charactor + "\n")

f.write(remark + "\n")

f.write(score)

f.write("\n\n") f.close() # 记得关闭文件 if __name__ == "__main__":

if os.path.exists("F:\\Pythontest1") == False: # 两个if来判断是否文件路径存在 新建文件夹 删除文件

os.mkdir("F:\\Pythontest1")

if os.path.exists("F:\\Pythontest1\\douban.txt") == True:

os.remove("F:\\Pythontest1\\douban.txt") page = 0 # 初始化页数,TOP一共有250部 每页25部

while page <= 225:

web_url = "https://movie.douban.com/top250?start=%s&filter=" % page

all_move = get_html(web_url) # 返回每一页的网页

get_info(all_move) # 匹配对应信息存入本地

page += 25

python3 爬虫---爬取豆瓣电影TOP250的更多相关文章

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

- [151116 记录] 使用Python3.5爬取豆瓣电影Top250

这一段时间,一直在折腾Python爬虫.已有的文件记录显示,折腾爬虫大概个把月了吧.但是断断续续,一会儿鼓捣python.一会学习sql儿.一会调试OpenCV,结果什么都没学好.前几天,终于耐下心来 ...

- Python爬虫-爬取豆瓣电影Top250

#!usr/bin/env python3 # -*- coding:utf-8-*- import requests from bs4 import BeautifulSoup import re ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- 一起学爬虫——通过爬取豆瓣电影top250学习requests库的使用

学习一门技术最快的方式是做项目,在做项目的过程中对相关的技术查漏补缺. 本文通过爬取豆瓣top250电影学习python requests的使用. 1.准备工作 在pycharm中安装request库 ...

- Python爬虫入门:爬取豆瓣电影TOP250

一个很简单的爬虫. 从这里学习的,解释的挺好的:https://xlzd.me/2015/12/16/python-crawler-03 分享写这个代码用到了的学习的链接: BeautifulSoup ...

- urllib+BeautifulSoup无登录模式爬取豆瓣电影Top250

对于简单的爬虫任务,尤其对于初学者,urllib+BeautifulSoup足以满足大部分的任务. 1.urllib是Python3自带的库,不需要安装,但是BeautifulSoup却是需要安装的. ...

- python爬虫 Scrapy2-- 爬取豆瓣电影TOP250

sklearn实战-乳腺癌细胞数据挖掘(博主亲自录制视频) https://study.163.com/course/introduction.htm?courseId=1005269003& ...

- Scrapy中用xpath/css爬取豆瓣电影Top250:解决403HTTP status code is not handled or not allowed

好吧,我又开始折腾豆瓣电影top250了,只是想试试各种方法,看看哪一种的方法效率是最好的,一直进行到这一步才知道 scrapy的强大,尤其是和selector结合之后,速度飞起.... 下面我就采用 ...

随机推荐

- git使用教程之git分支

1 分支简介 让我们来看一个简单的分支新建与分支合并的例子,实际工作中你可能会用到类似的工作流. 你将经历如下步骤: 开发某个网站. 为实现某个新的需求,创建一个分支. 在这个分支上开展工作. 正在此 ...

- 百度Echarts导入

<!DOCTYPE html> <html> <head lang="en"> <meta charset="UTF-8&quo ...

- Django----中间件详解

Django中间件 在http请求 到达视图函数之前 和视图函数return之后,django会根据自己的规则在合适的时机执行中间件中相应的方法. 中间件的执行流程 1.执行完所有的request ...

- spring boot跨域设置

定义 跨域是指从一个域名的网页去请求另一个域名的资源 跨域背景 限制原因 如果一个网页可以随意地访问另外一个网站的资源,那么就有可能在客户完全不知情的情况下出现安全问题 为什么要跨域 公司内部有多个不 ...

- C# 使用正则表达式去掉字符串中的数字

/// <summary>/// 去掉字符串中的数字/// </summary>/// <param name="key"></param ...

- C#自动实现Dll(OCX)控件注册的两种方法

尽管MS为我们提供了丰富的.net framework库,我们的程序C#开发带来了极大的便利,但是有时候,一些特定功能的控件库还是需要由第三方提供或是自己编写.当需要用到Dll引用的时候,我们通常会通 ...

- C# 读写文本文件乱码解决方案

在使用C#对文本文件读取的时候,如果其中包含了中文,经常会出现乱码.一般解决是在StreamReader加一个编码,我使用的是Encoding.UTF8,一般情况下使用这个参数就可以.但是,在这次我使 ...

- java环境变量和tomcat环境变量配置

一.JAVA环境变量的配置1.首先下载JDK JDK可以在Oracle(甲骨文)公司的官方网站http://www.oracle.com下载2.安装完成后查看JDK安装路径一般是C:\Program ...

- SHA1 安全哈希算法(Secure Hash Algorithm)

安全哈希算法(Secure Hash Algorithm)主要适用于数字签名标准 (Digital Signature Standard DSS)里面定义的数字签名算法(Digital Signatu ...

- JavaScript学习笔记(七)——函数的定义与调用

在学习廖雪峰前辈的JavaScript教程中,遇到了一些需要注意的点,因此作为学习笔记列出来,提醒自己注意! 如果大家有需要,欢迎访问前辈的博客https://www.liaoxuefeng.com/ ...