spark load data from mysql

spark load data from mysql

code first

本机通过spark-shell.cmd启动一个spark进程

SparkSession spark = SparkSession.builder().appName("Simple Application").master("local[2]").getOrCreate();

Map<String, String> map = new HashMap<>();

map.put("url","jdbc:mysql:xxx");

map.put("user", "user");

map.put("password", "pass");

String tableName = "table";

map.put("dbtable", tableName);

map.put("driver", "com.mysql.jdbc.Driver");

String lowerBound = 1 + ""; //低界限

String upperBound = 10000 + ""; //高界限

map.put("fetchsize", "100000"); //实例和mysql服务端单次拉取行数,拉取后才能执行rs.next()

map.put("numPartitions", "50"); //50个分区区间,将以范围[lowerBound,upperBound]划分成50个分区,每个分区执行一次查询

map.put("partitionColumn", "id"); //分区条件列

System.out.println("tableName:" + tableName + ", lowerBound:"+lowerBound+", upperBound:"+upperBound);

map.put("lowerBound", lowerBound);

map.put("upperBound", upperBound);

Dataset dataset = spark.read().format("jdbc").options(map).load(); //transform操作

dataset.registerTempTable("tmp__");

Dataset<Row> ds = spark.sql("select * from tmp__"); //transform操作

ds.cache().show(); //action,触发sql真正执行

执行到show时,任务开始真正执行,此时,我们单机debug,来跟踪partitionColumn的最终实现方式

debug类

org.apache.spark.sql.execution.datasources.jdbc.JDBCRelation.buildScan

此时parts为size=50的分区列表

override def buildScan(requiredColumns: Array[String], filters: Array[Filter]): RDD[Row] = {

// Rely on a type erasure hack to pass RDD[InternalRow] back as RDD[Row]

JDBCRDD.scanTable(

sparkSession.sparkContext,

schema,

requiredColumns,

filters,

parts,

jdbcOptions).asInstanceOf[RDD[Row]]

}

单个分区内的whereClause值

whereCluase="id < 21 or id is null"

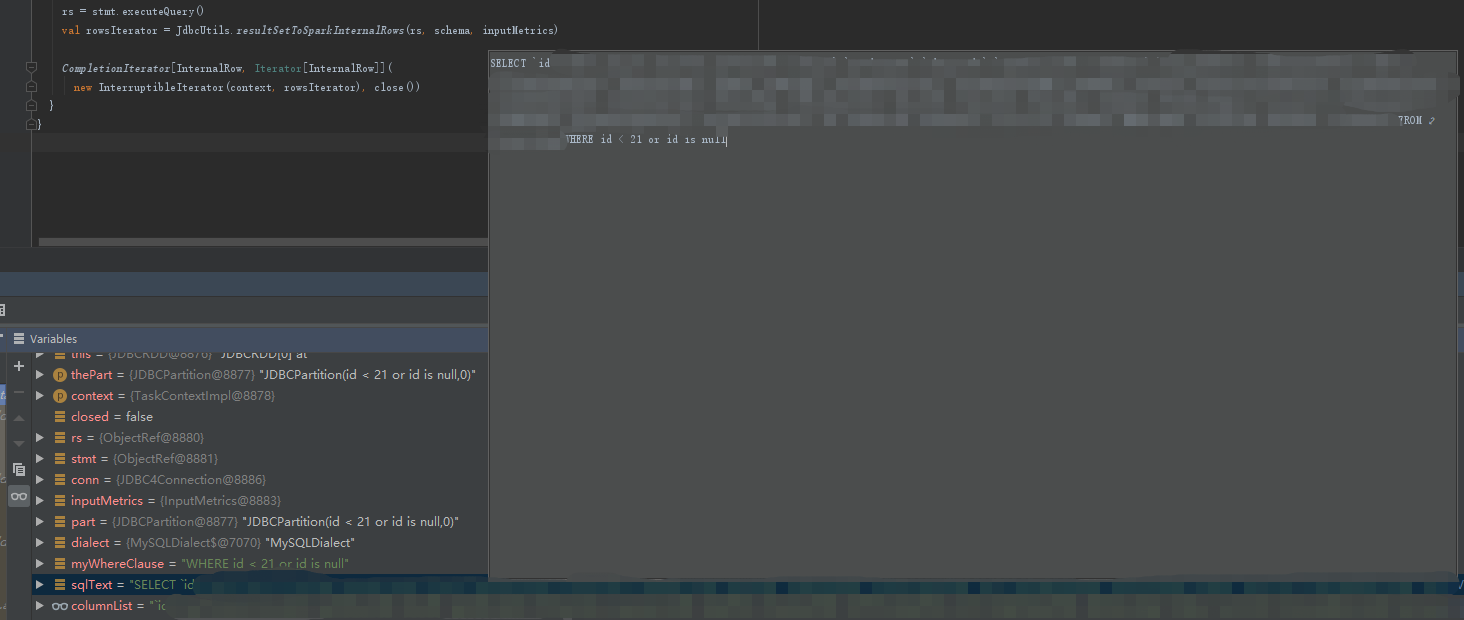

继续往下断点,到单个part的执行逻辑,此时代码应该是在Executor中的某个task线程中

org.apache.spark.sql.execution.datasources.jdbc.JDBCRDD.compute

val myWhereClause = getWhereClause(part)

val sqlText = s"SELECT $columnList FROM ${options.table} $myWhereClause"

stmt = conn.prepareStatement(sqlText,

ResultSet.TYPE_FORWARD_ONLY, ResultSet.CONCUR_READ_ONLY)

stmt.setFetchSize(options.fetchSize)

rs = stmt.executeQuery()

val rowsIterator = JdbcUtils.resultSetToSparkInternalRows(rs, schema, inputMetrics)

CompletionIterator[InternalRow, Iterator[InternalRow]](

new InterruptibleIterator(context, rowsIterator), close())

此时

myWhereClause=WHERE id < 21 or id is null

最终的sql语句

sqlText=SELECT id,xx FROM tablea WHERE id < 21 or id is null

所有part都会经过compute

Executor执行完任务后,将信息发送回Driver

Executor: Finished task 7.0 in stage 2.0 (TID 12). 1836 bytes result sent to driver

总结

- numPartitions、partitionColumn、lowerBound、upperBound结合后,spark将生成很多个parts,每个part对应一个查询whereClause,最终查询数据将分成numPartitions个任务来拉取数据,因此,partitionColumn必须是索引列,否则,效率将大大降低

- 自动获取table schema,程序会执行类型select * from tablea where 1=0 来获取字段及类型

- lowerBound,upperBound仅用来生成parts区间,最终生成的sql中,不会使用它们来作为数据范围的最小或最大值

spark load data from mysql的更多相关文章

- 使用MySQL的SELECT INTO OUTFILE ,Load data file,Mysql 大量数据快速导入导出

使用MySQL的SELECT INTO OUTFILE .Load data file LOAD DATA INFILE语句从一个文本文件中以很高的速度读入一个表中.当用户一前一后地使用SELECT ...

- mysql导入数据load data infile用法整理

有时候我们需要将大量数据批量写入数据库,直接使用程序语言和Sql写入往往很耗时间,其中有一种方案就是使用MySql Load data infile导入文件的形式导入数据,这样可大大缩短数据导入时间. ...

- MySQL 之 LOAD DATA INFILE 快速导入数据

SELECT INTO OUTFILE > help select; Name: 'SELECT' Description: Syntax: SELECT [ALL | DISTINCT | D ...

- Mybatis拦截器 mysql load data local 内存流处理

Mybatis 拦截器不做解释了,用过的基本都知道,这里用load data local主要是应对大批量数据的处理,提高性能,也支持事务回滚,且不影响其他的DML操作,当然这个操作不要涉及到当前所lo ...

- mysql load data 乱码的问题

新学mysql在用load data导入txt文档时发现导入的内容,select 之后是乱码,先后把表,数据库的字符集类型修改为utf8,但还是一样,最后在 http://bbs.chinaunix. ...

- mysql load data infile的使用 和 SELECT into outfile备份数据库数据

LOAD DATA [LOW_PRIORITY | CONCURRENT] [LOCAL] INFILE 'file_name.txt' [REPLACE | IGNORE] INTO TABLE t ...

- 快速的mysql导入导出数据(load data和outfile)

1.load data: ***实际应用:把日志生成的xls文件load到MySQL中: mysql_cmd = "iconv -c -f utf-8 -t gbk ./data/al_ve ...

- [MySQL]load data local infile向MySQL数据库中导入数据时,无法导入和字段不分离问题。

利用load data将文件中的数据导入数据库表中的时候,遇到了两个问题. 首先是load data命令无法执行的问题: 命令行下输入load data local infile "path ...

- mysql导入数据load data infile用法

mysql导入数据load data infile用法 基本语法: load data [low_priority] [local] infile 'file_name txt' [replace | ...

随机推荐

- 相同宿主机下的dcoker之间通信

相同宿主机下的dcoker之间通信 docker docker的本质是进程,隔离的资源包括:网卡.回环设备.路由表和 iptables 规则,这些要素构成了一个进程(docker)发起和响应网络请求的 ...

- java中的几种基础排序

import java.util.Random;import java.util.Arrays; public class Puppy { public static void main(St ...

- python3 连接数据库~

~目前记录的是针对python3写的数据库连接,不适用于pyhon2.python3如果想要与数据库进行连接,则需要先下载对应各数据库的插件包,然后导入包.python3的插件下载地址:https:/ ...

- Paxos 协议

可用性与一致性 为了向用户提供更好的服务体验,现代软件架构越来越注重系统的可用性availability. 正是在这种趋势的驱动下,微服务与容器化技术才能在今天大行其道. 而高可用架构的前提是冗余: ...

- Java知识系统回顾整理01基础07类和对象01引用

一.引用的定义 引用的概念,如果一个变量的类型是 类类型,而非基本类型,那么该变量又叫做引用. 二.引用和指向 new Hero(); 代表创建了一个Hero对象 但是也仅仅是创建了一个对象,没有办法 ...

- 101 01 Android 零基础入门 02 Java面向对象 03 综合案例(学生信息管理) 02 案例分析及实现 05 通过方法实现学生类与专业类关联——方案二

101 01 Android 零基础入门 02 Java面向对象 03 综合案例(学生信息管理) 02 案例分析及实现 05 通过方法实现学生类与专业类关联--方案二 本文知识点:通过方法实现学生类与 ...

- Recursive sequence (矩阵快速幂)2016ACM/ICPC亚洲区沈阳站

题目 Farmer John likes to play mathematics games with his N cows. Recently, they are attracted by recu ...

- Thinkphp中D方法和M方法的区别

两者共同点都是实例化模型的,而两者不同点呢?一起来看一下: $User = D('User');括号中的参数User,对应的模型类文件的 \Home\Model\UserModel.class.php ...

- Oracle数据库中的大对象(LOB)数据类型介绍

一.LOB数据类型的介绍 大对象(LOB)数据类型允许我们保存和操作非结构化和半结构化数据,如文档.图形图像.视频片段.声音文件和XML文件等.DMBS_LOB 包被设计用于操作 LOB 数据类型.从 ...

- 最新最最最简单的Snagit傻瓜式破解教程(带下载地址)

最新最最最简单的Snagit傻瓜式破解教程(带下载地址) 下载地址 直接滑至文章底部下载 软件介绍 一个非常著名的优秀屏幕.文本和视频捕获.编辑与转换软件.可以捕获Windows屏幕.DOS屏幕:RM ...