pinpoint部署管理

本次pinpoint安装使用了docker环境安装,需要预先docker运行环境

1.安装docker环境

2.获取pinpoint-docker,安装命令

git clone https://github.com/naver/pinpoint-docker.git

git checkout {tag}

cd pinpoint-docker

docker-compose pull && docker-compose up -d ##若docker-compose不存在,就要安装

[docker-compose安装]

#curl -L https://get.daocloud.io/docker/compose/releases/download/1.22.0/docker-compose-`uname -s`-`uname -m` > /usr/local/bin/docker-compose

#chmod +x /usr/local/bin/docker-compose

链接https://github.com/naver/pinpoint-docker/blob/1.8.4/docker-compose.yml

version: "3.6" services:

pinpoint-hbase:

build:

context: ./pinpoint-hbase/

dockerfile: Dockerfile

args:

- PINPOINT_VERSION=${PINPOINT_VERSION} container_name: "${PINPOINT_HBASE_NAME}"

image: "pinpointdocker/pinpoint-hbase:${PINPOINT_VERSION}"

networks:

- pinpoint volumes:

- /home/pinpoint/hbase

- /home/pinpoint/zookeeper

expose:

# zookeeper

- "2181"

# HBase Master API port

- "60000"

# HBase Master Web UI

- "16010"

# Regionserver API port

- "60020"

# HBase Regionserver web UI

- "16030"

ports:

- "${EXTERNAL_HBASE_PORT:-2181}:2181"

- "60000:60000"

- "16010:16010"

- "60020:60020"

- "16030:16030"

restart: always pinpoint-mysql:

build:

context: ./pinpoint-mysql/

dockerfile: Dockerfile

args:

- PINPOINT_VERSION=${PINPOINT_VERSION} container_name: pinpoint-mysql

restart: always

image: "pinpointdocker/pinpoint-mysql:${PINPOINT_VERSION}"

hostname: pinpoint-mysql

ports:

- "13306:3306"

environment:

- MYSQL_ROOT_PASSWORD=${MYSQL_ROOT_PASSWORD}

- MYSQL_USER=${MYSQL_USER}

- MYSQL_PASSWORD=${MYSQL_PASSWORD}

- MYSQL_DATABASE=${MYSQL_DATABASE} volumes:

- mysql_data:/var/lib/mysql

networks:

- pinpoint pinpoint-web:

build:

context: ./pinpoint-web/

dockerfile: Dockerfile

args:

- PINPOINT_VERSION=${PINPOINT_VERSION} container_name: "${PINPOINT_WEB_NAME}"

image: "pinpointdocker/pinpoint-web:${PINPOINT_VERSION}" depends_on:

- pinpoint-hbase

- pinpoint-mysql

restart: always

expose:

- "8080"

- "9997"

ports:

- "9997:9997"

- "${WEB_PAGE_PORT:-8080}:8080"

environment:

- CLUSTER_ENABLE=${CLUSTER_ENABLE}

- CLUSTER_ZOOKEEPER_ADDRESS=${CLUSTER_ZOOKEEPER_ADDRESS}

- ADMIN_PASSWORD=${ADMIN_PASSWORD}

- ANALYTICS=${ANALYTICS}

- HBASE_HOST=${HBASE_HOST}

- HBASE_PORT=${HBASE_PORT}

- DEBUG_LEVEL=${WEB_DEBUG_LEVEL}

- CONFIG_SHOW_APPLICATIONSTAT=${CONFIG_SHOW_APPLICATIONSTAT}

- BATCH_ENABLE=${BATCH_ENABLE}

- BATCH_SERVER_IP=${BATCH_SERVER_IP}

- BATCH_FLINK_SERVER=${BATCH_FLINK_SERVER}

- JDBC_DRIVER=${JDBC_DRIVER}

- JDBC_URL=${JDBC_URL}

- JDBC_USERNAME=${JDBC_USERNAME}

- JDBC_PASSWORD=${JDBC_PASSWORD}

- MAIL_HOST=${MAIL_HOST}

- MAIL_PORT=${MAIL_PORT}

- MAIL_USERNAME=${MAIL_USERNAME}

- MAIL_PASSWORD=${MAIL_PASSWORD}

- MAIL_PROPERTIES_MAIL_TRANSPORT_PROTOCOL=${MAIL_PROPERTIES_MAIL_TRANSPORT_PROTOCOL}

- MAIL_PROPERTIES_MAIL_SMTP_AUTH=${MAIL_PROPERTIES_MAIL_SMTP_AUTH}

- MAIL_PROPERTIES_MAIL_SMTP_PORT=${MAIL_PROPERTIES_MAIL_SMTP_PORT}

- MAIL_PROPERTIES_MAIL_SMTP_FROM=${MAIL_PROPERTIES_MAIL_SMTP_FROM}

- MAIL_PROPERTIES_MAIL_STARTTLS_ENABLE=${MAIL_PROPERTIES_MAIL_STARTTLS_ENABLE}

- MAIL_PROPERTIES_MAIL_STARTTLS_REQUIRED=${MAIL_PROPERTIES_MAIL_STARTTLS_REQUIRED}

- MAIL_PROPERTIES_MAIL_DEBUG=${MAIL_PROPERTIES_MAIL_DEBUG}

links:

- "pinpoint-mysql:pinpoint-mysql"

networks:

- pinpoint pinpoint-collector:

build:

context: ./pinpoint-collector/

dockerfile: Dockerfile

args:

- PINPOINT_VERSION=${PINPOINT_VERSION} container_name: "${PINPOINT_COLLECTOR_NAME}"

image: "pinpointdocker/pinpoint-collector:${PINPOINT_VERSION}" depends_on:

- pinpoint-hbase

restart: always

expose:

- "9994"

- "9995"

- "9996"

ports:

- "${COLLECTOR_RECEIVER_BASE_PORT:-9994}:9994"

- "${COLLECTOR_RECEIVER_STAT_UDP_PORT:-9995}:9995/tcp"

- "${COLLECTOR_RECEIVER_SPAN_UDP_PORT:-9996}:9996/tcp"

- "${COLLECTOR_RECEIVER_STAT_UDP_PORT:-9995}:9995/udp"

- "${COLLECTOR_RECEIVER_SPAN_UDP_PORT:-9996}:9996/udp"

networks:

- pinpoint

environment:

- CLUSTER_ENABLE=${CLUSTER_ENABLE}

- CLUSTER_ZOOKEEPER_ADDRESS=${CLUSTER_ZOOKEEPER_ADDRESS}

- HBASE_HOST=${HBASE_HOST}

- HBASE_PORT=${HBASE_PORT}

- FLINK_CLUSTER_ENABLE=${FLINK_CLUSTER_ENABLE}

- FLINK_CLUSTER_ZOOKEEPER_ADDRESS=${FLINK_CLUSTER_ZOOKEEPER_ADDRESS}

- DEBUG_LEVEL=${COLLECTOR_DEBUG_LEVEL} pinpoint-quickstart:

build:

context: ./pinpoint-quickstart/

dockerfile: Dockerfile container_name: "pinpoint-quickstart"

image: "pinpointdocker/pinpoint-quickstart"

ports:

- "${APP_PORT:-8080}:8080"

volumes:

- data-volume:/pinpoint-agent

environment:

JAVA_OPTS: "-javaagent:/pinpoint-agent/pinpoint-bootstrap-${PINPOINT_VERSION}.jar -Dpinpoint.agentId=${AGENT_ID} -Dpinpoint.applicationName=${APP_NAME}"

networks:

- pinpoint

depends_on:

- pinpoint-agent pinpoint-agent:

build:

context: ./pinpoint-agent/

dockerfile: Dockerfile

args:

- PINPOINT_VERSION=${PINPOINT_VERSION} container_name: "${PINPOINT_AGENT_NAME}"

image: "pinpointdocker/pinpoint-agent:${PINPOINT_VERSION}" restart: unless-stopped networks:

- pinpoint

volumes:

- data-volume:/pinpoint-agent

environment:

- COLLECTOR_IP=${COLLECTOR_IP}

- COLLECTOR_TCP_PORT=${COLLECTOR_TCP_PORT}

- COLLECTOR_STAT_PORT=${COLLECTOR_STAT_PORT}

- COLLECTOR_SPAN_PORT=${COLLECTOR_SPAN_PORT}

- PROFILER_SAMPLING_RATE=${PROFILER_SAMPLING_RATE}

- DEBUG_LEVEL=${AGENT_DEBUG_LEVEL}

depends_on:

- pinpoint-collector #zookeepers

zoo1:

image: zookeeper:3.4

restart: always

hostname: zoo1

environment:

ZOO_MY_ID: 1

ZOO_SERVERS: server.1=0.0.0.0:2888:3888 server.2=zoo2:2888:3888 server.3=zoo3:2888:3888

networks:

- pinpoint zoo2:

image: zookeeper:3.4

restart: always

hostname: zoo2

environment:

ZOO_MY_ID: 2

ZOO_SERVERS: server.1=zoo1:2888:3888 server.2=0.0.0.0:2888:3888 server.3=zoo3:2888:3888

networks:

- pinpoint zoo3:

image: zookeeper:3.4

restart: always

hostname: zoo3

environment:

ZOO_MY_ID: 3

ZOO_SERVERS: server.1=zoo1:2888:3888 server.2=zoo2:2888:3888 server.3=0.0.0.0:2888:3888

networks:

- pinpoint ##flink

jobmanager:

container_name: "${PINPOINT_FLINK_NAME}-jobmanager"

image: flink:1.3.1

expose:

- "6123"

ports:

- "${FLINK_WEB_PORT:-8081}:8081"

command: jobmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=jobmanager

networks:

- pinpoint taskmanager:

container_name: "${PINPOINT_FLINK_NAME}-taskmanager"

image: flink:1.3.1

expose:

- "6121"

- "6122"

- "19994"

ports:

- "6121:6121"

- "6122:6122"

- "19994:19994"

depends_on:

- jobmanager

command: taskmanager

links:

- "jobmanager:jobmanager"

environment:

- JOB_MANAGER_RPC_ADDRESS=jobmanager

networks:

- pinpoint volumes:

data-volume:

mysql_data: networks:

pinpoint:

driver: bridge

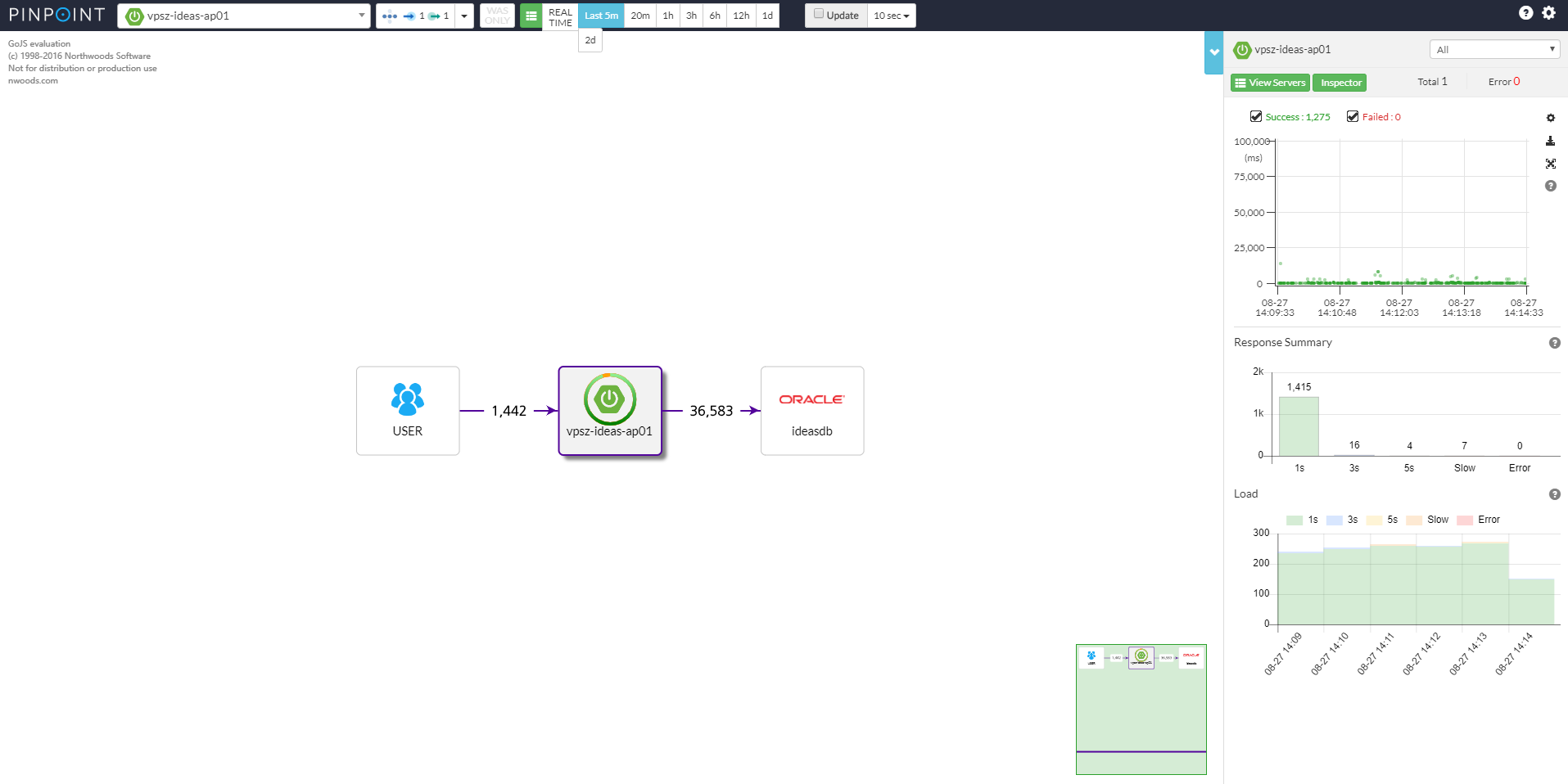

3.界面

5.Agent客户端安装

(1) 客户端下载:

(2) 配置修改: 修改pinpoint.conf里面的profiler.collector.ip=x.x.x.x (IP地址为collector 机器的主机名或 IP)

(3) java环境启动如下命令

## java -javaagent:/home/g1701789/ap_server/pinpoint-agent-1.5.2/pinpoint-bootstrap-1.5.2.jar -Dpinpoint.agentId=ideas-prod-1 -Dpinpoint.appcationName=vpsz-ideas-ap01 -jar ideas-private.jar

-javaagent: 指定Agent包所在绝对路径

-Dpinpoint.agentId: 自定义名称

-Dpinpoint.appcationName: 一般主机名称

-jar: 业务环境的java所在绝对路径

pinpoint部署管理的更多相关文章

- OpenStack安装部署管理中常见问题解决方法

一.网络问题-network 更多网络原理机制可以参考<OpenStack云平台的网络模式及其工作机制>. 1.1.控制节点与网络控制器区别 OpenStack平台中有两种类型的物理节点, ...

- Solr7 安装部署 管理界面介绍

Solr7 安装部署 管理界面介绍 本章重点介绍CentOS 安装部署Solr7 ,Solr的管理界面介绍,添加核心Core配置,Dataimport导入数据,Documents 在线维护索引,Que ...

- 2017.2.28 activiti实战--第五章--用户与组及部署管理(三)部署流程及资源读取

学习资料:<Activiti实战> 第五章 用户与组及部署管理(三)部署流程及资源读取 内容概览:如何利用API读取已经部署的资源,比如读取流程定义的XML文件,或流程对应的图片文件. 以 ...

- 2017.2.28 activiti实战--第五章--用户与组及部署管理(二)部署流程资源

学习资料:<Activiti实战> 第五章 用户与组及部署管理(二)部署流程资源 内容概览:讲解流程资源的读取与部署. 5.2 部署流程资源 5.2.1 流程资源 流程资源常用的有以下几种 ...

- 2017.2.20 activiti实战--第五章--用户与组及部署管理(一)用户与组

学习资料:<Activiti实战> 第五章 用户与组及部署管理(一)用户与组 内容概览:讲解activiti中内置的一套用户.组的关系,以及如何通过API添加.删除.查询. 5.1 用户与 ...

- TriAquae 是一款由国产的基于Python开发的开源批量部署管理工具

怀着鸡动的心情跟大家介绍一款国产开源运维软件TriAquae,轻松帮你搞定大部分运维工作!TriAquae 是一款由国产的基于Python开发的开源批量部署管理工具,可以允许用户通过一台控制端管理上千 ...

- mtools 是由MongoDB 官方工程师实现的一套工具集,可以很快速的日志查询分析、统计功能,此外还支持本地集群部署管理.

mtools 是由MongoDB 官方工程师实现的一套工具集,可以很快速的日志查询分析.统计功能,此外还支持本地集群部署管理 https://www.cnblogs.com/littleatp/p/9 ...

- Node线上部署管理器PM2

PM2是一个带有负载均衡功能的Node应用的进程管理器.PM2可以利用服务器上的所有CPU,并保证进程永远都活着,0秒的重载,部署管理多个Node项目.PM2是Node线上部署完美的管理工具. PM2 ...

- pinpoint部署

pinpoint是一个分析大型分布式系统的平台,提供解决方案来处理海量跟踪数据,主要面向基于tomcat的Java 应用. pinpoint使用HBASE储存数据. 下面介绍pinpoint部署及应用 ...

随机推荐

- Python单向链表的实现

链表由一系列不必在内存中相连的结构构成,这些对象按线性顺序排序.每个结构含有表元素和指向后继元素的指针.最后一个单元的指针指向NULL.为了方便链表的删除与插入操作,可以为链表添加一个表头. 删除操作 ...

- springcloud学习入门

Springcloud入门学习笔记 1. 项目初始化配置 1. 1. 新建maven工程 使用idea创建maven项目 1. 2. 在parent项目pom中导入以下依赖 <parent> ...

- CentOS7 系统安全的设置

一.禁止root远程直接登录 # 创建普通用户,并设置密码 useradd bluceli #新建账户 passwd bluceli #设置密码 # 不允许root远程直接登录 vim /etc/ss ...

- OpenCV计算机视觉学习(4)——图像平滑处理(均值滤波,高斯滤波,中值滤波,双边滤波)

如果需要处理的原图及代码,请移步小编的GitHub地址 传送门:请点击我 如果点击有误:https://github.com/LeBron-Jian/ComputerVisionPractice &q ...

- 发布MeteoInfo 2.3

主要的更新如下: Using SVG icons in GUI. Update netCDF java library to 5.3.3. Update FlatLaf to 0.40. Update ...

- C++虚函数与多继承

虚函数 C++用虚函数实现运行时多态,虚函数的实现是由两个部分组成的,虚函数指针与虚函数表. 虚函数指针(vptr)是指向虚函数表的指针,在一个被实例化的对象中,它总是被存放在该对象的地址首位.而虚函 ...

- scp远程上传

scp -P 22 /Users/mac/Downloads/VBoxGuestAdditions_5.2.12.iso root@192.168.1.210:/usr/local/src s ...

- swoole 协程介绍

协程的执行顺序: 1 2 3 4 5 6 7 8 9 go(function () { echo "hello go1 \n"; }); echo "hell ...

- Activiti的流程实例【ProcessInstance】与执行实例【Execution】

最近,我在做流程引擎Activiti相关的东西,刚开始时的一个知识点困扰了我许久,那就是Activiti的ProcessInstance与Execution的区别,这是一个Activiti的难点,能够 ...

- Java安全之Commons Collections2分析

Java安全之Commons Collections2分析 首发:Java安全之Commons Collections2分析 0x00 前言 前面分析了CC1的利用链,但是发现在CC1的利用链中是有版 ...