Hadoop概念学习系列之Java调用Shell命令和脚本,致力于hadoop/spark集群(三十六)

前言

说明的是,本博文,是在以下的博文基础上,立足于它们,致力于我的大数据领域!

http://kongcodecenter.iteye.com/blog/1231177

http://blog.csdn.net/u010376788/article/details/51337312

http://blog.csdn.net/arkblue/article/details/7897396

第一种:普通做法

首先,编号写WordCount.scala程序。

然后,打成jar包,命名为WC.jar。比如,我这里,是导出到windows桌面。

其次,上传到linux的桌面,再移动到hdfs的/目录。

最后,在spark安装目录的bin下,执行

spark-submit \

> --class cn.spark.study.core.WordCount \

> --master local[1] \

> /home/spark/Desktop/WC.jar \

> hdfs://SparkSingleNode:9000/spark.txt \

> hdfs://SparkSingleNode:9000/WCout

第二种:高级做法

有时候我们在Linux中运行Java程序时,需要调用一些Shell命令和脚本。而Runtime.getRuntime().exec()方法给我们提供了这个功能,而且Runtime.getRuntime()给我们提供了以下几种exec()方法:

不多说,直接进入。

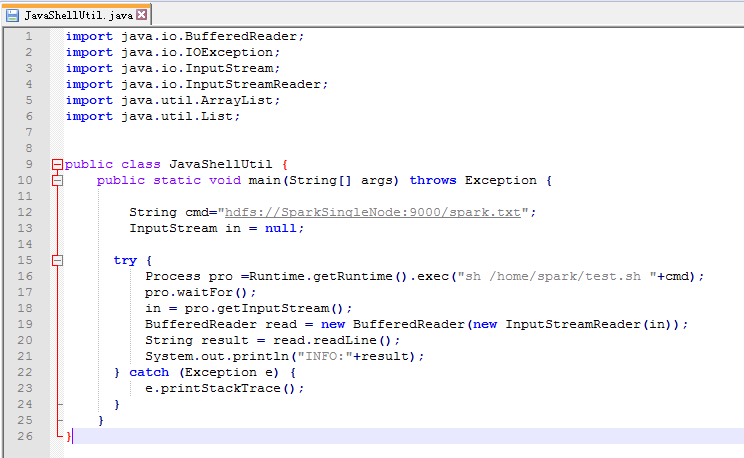

步骤一: 为了规范起见,命名为JavaShellUtil.java。在本地里写好

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.util.ArrayList;

import java.util.List;

public class JavaShellUtil {

public static void main(String[] args) throws Exception {

String cmd="hdfs://SparkSingleNode:9000/spark.txt";

InputStream in = null;

try {

Process pro =Runtime.getRuntime().exec("sh /home/spark/test.sh "+cmd);

pro.waitFor();

in = pro.getInputStream();

BufferedReader read = new BufferedReader(new InputStreamReader(in));

String result = read.readLine();

System.out.println("INFO:"+result);

} catch (Exception e) {

e.printStackTrace();

}

}

}

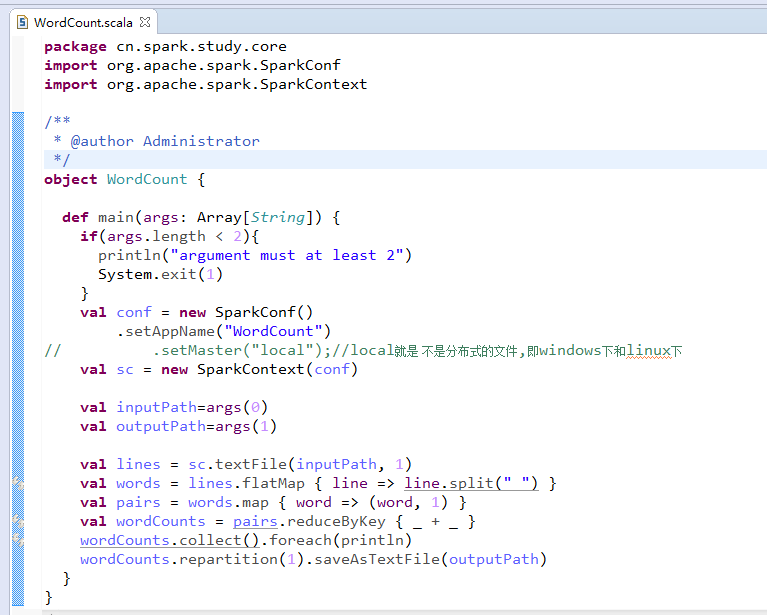

package cn.spark.study.core

import org.apache.spark.SparkConf

import org.apache.spark.SparkContext

/**

* @author Administrator

*/

object WordCount {

def main(args: Array[String]) {

if(args.length < 2){

println("argument must at least 2")

System.exit(1)

}

val conf = new SparkConf()

.setAppName("WordCount")

// .setMaster("local");//local就是 不是分布式的文件,即windows下和linux下

val sc = new SparkContext(conf)

val inputPath=args(0)

val outputPath=args(1)

val lines = sc.textFile(inputPath, 1)

val words = lines.flatMap { line => line.split(" ") }

val pairs = words.map { word => (word, 1) }

val wordCounts = pairs.reduceByKey { _ + _ }

wordCounts.collect().foreach(println)

wordCounts.repartition(1).saveAsTextFile(outputPath)

}

}

步骤二:编写好test.sh脚本

spark@SparkSingleNode:~$ cat test.sh

#!/bin/sh

/usr/local/spark/spark-1.5.2-bin-hadoop2.6/bin/spark-submit \

--class cn.spark.study.core.WordCount \

--master local[1] \

/home/spark/Desktop/WC.jar \

$1 hdfs://SparkSingleNode:9000/WCout

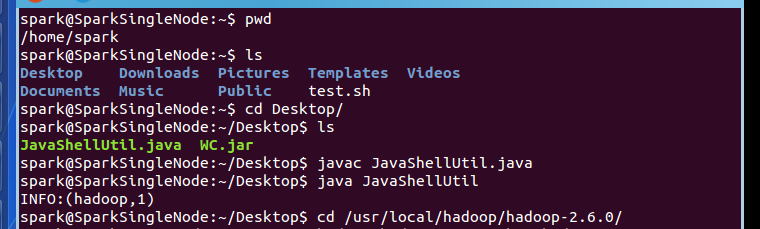

步骤三:上传JavaShellUtil.java,和打包好的WC.jar

spark@SparkSingleNode:~$ pwd

/home/spark

spark@SparkSingleNode:~$ ls

Desktop Downloads Pictures Templates Videos

Documents Music Public test.sh

spark@SparkSingleNode:~$ cd Desktop/

spark@SparkSingleNode:~/Desktop$ ls

JavaShellUtil.java WC.jar

spark@SparkSingleNode:~/Desktop$ javac JavaShellUtil.java

spark@SparkSingleNode:~/Desktop$ java JavaShellUtil

INFO:(hadoop,1)

spark@SparkSingleNode:~/Desktop$ cd /usr/local/hadoop/hadoop-2.6.0/

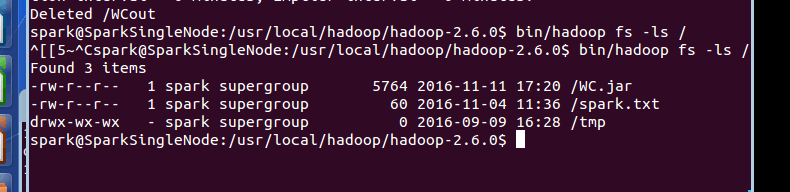

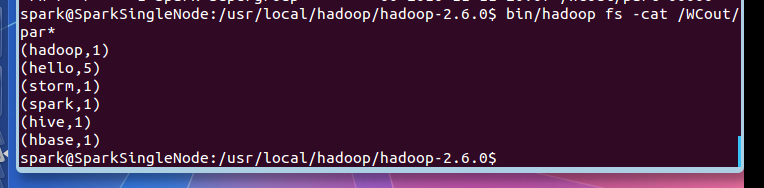

步骤四:查看输出结果

spark@SparkSingleNode:/usr/local/hadoop/hadoop-2.6.0$ bin/hadoop fs -cat /WCout/par*

(hadoop,1)

(hello,5)

(storm,1)

(spark,1)

(hive,1)

(hbase,1)

spark@SparkSingleNode:/usr/local/hadoop/hadoop-2.6.0$

成功!

关于

Shell 传递参数

见

http://www.runoob.com/linux/linux-shell-passing-arguments.html

最后说的是,不局限于此,可以穿插在以后我们生产业务里的。作为调用它即可,非常实用!

Hadoop概念学习系列之Java调用Shell命令和脚本,致力于hadoop/spark集群(三十六)的更多相关文章

- java基础/java调用shell命令和脚本

一.项目需求: 从某一机构获取证书,证书机构提供小工具,执行.sh脚本即可启动服务,本地调用该服务即可获取证书. 问题:linux服务器启动该服务,不能关闭.一旦关闭,服务即停止. 解决方案:java ...

- java调用shell命令及脚本

shell脚本在处理文本及管理操作系统时强大且简单,将shell脚本结合到应用程序中则是一种快速实现的不错途径本文介绍使用java代码调用并执行shell 我在 -/bin/ 目录下写了jbossLo ...

- shell 脚本实战笔记(10)--spark集群脚本片段念念碎

前言: 通过对spark集群脚本的研读, 对一些重要的shell脚本技巧, 做下笔记. *). 取当前脚本的目录 sbin=`dirname "$0"` sbin=`cd &quo ...

- Java 调用 Shell 命令

近日项目中有这样一个需求:系统中的外币资金调度完成以后,要将调度信息生成一个Txt文件,然后将这个Txt文件发送到另外一个系统(Kondor)中.生成文件自然使用OutputStreamWirter了 ...

- Hadoop Hive概念学习系列之hive里的扩展接口(CLI、Beeline、JDBC)(十六)

<Spark最佳实战 陈欢>写的这本书,关于此知识点,非常好,在94页. hive里的扩展接口,主要包括CLI(控制命令行接口).Beeline和JDBC等方式访问Hive. CLI和B ...

- java 调用shell命令

原文:http://kongcodecenter.iteye.com/blog/1231177 Java通过SSH2协议执行远程Shell脚本(ganymed-ssh2-build210.jar) ...

- java 执行shell命令遇到的坑

正常来说java调用shell命令就是用 String[] cmdAry = new String[]{"/bin/bash","-c",cmd} Runtim ...

- Hadoop概念学习系列之Hadoop新手学习指导之入门需知(二十)

不多说,直接上干货! 零基础学习hadoop,没有想象的那么困难,也没有想象的那么容易.从一开始什么都不懂,到能够搭建集群,开发.整个过程,只要有Linux基础,虚拟机化和java基础,其实hadoo ...

- [转载]JAVA调用Shell脚本

FROM:http://blog.csdn.net/jj12345jj198999/article/details/11891701 在实际项目中,JAVA有时候需要调用C写出来的东西,除了JNI以外 ...

随机推荐

- 1px的实现方法

1.用伪元素实现 .border_1px_top{ position:relative;} .border_1px_top:before{ content: ""; positio ...

- 洛谷P2568 GCD(线性筛法)

题目链接:传送门 题目: 题目描述 给定整数N,求1<=x,y<=N且Gcd(x,y)为素数的数对(x,y)有多少对. 输入输出格式 输入格式: 一个整数N 输出格式: 答案 输入输出样例 ...

- PWA需要的技术

1 Manifest https://developer.mozilla.org/zh-CN/docs/Web/Manifest 2 Service Work ...

- n!的质因子分解

其中k为任意质因子,因为a的数值不确定,所有k的值可以任意选择. 以下代码用于求出m!: #include<bits/stdc++.h> LL getpow(LL n,LL k) { LL ...

- PDO数据库引擎

PDO概述1.PDO是一种数据库访问抽象层,你不必使用以前的 mysqli_xx 之类只能访问 mysql数据库.使用PDO可以连接mysql.msssql.oracle等等,而不必重写代码.2.PD ...

- Redis 当成数据库在使用和可靠的分布式锁,Redlock 真的可行么?

怎样做可靠的分布式锁,Redlock 真的可行么? https://martin.kleppmann.com/2016/02/08/how-to-do-distributed-locking.html ...

- NET Core MVC中创建PDF

使用Rotativa在ASP.NET Core MVC中创建PDF 在本文中,我们将学习如何使用Rotativa.AspNetCore工具从ASP.NET Core中的视图创建PDF.如果您使用ASP ...

- (2)Django入门

web框架:把一个请求拆成几部分,每部分做相同的事 python中常用的框架 1.Django:大而全的框架 2.flask:微框架又叫轻量级的框架 3.Tornado:高性能框架 pycharm创建 ...

- 【java编程】String拼接效率探究

转载:https://maimai.cn/article/detail?fid=1139790318&efid=0-ey6pWIySdmkx82QO-OSw 字符串,是Java中最常用的一个数 ...

- 【shell编程】之基础知识-基本运算符

Shell 和其他编程语言一样,支持多种运算符,包括: 算数运算符 关系运算符 布尔运算符 字符串运算符 文件测试运算符 原生bash不支持简单的数学运算,但是可以通过其他命令来实现,例如 awk 和 ...