大型分布式爬虫准备 scrapy + request

而我避免这些问题的方式,控制台清除所有定时

var id = setInterval(function() {}, 0);

while (id--) clearInterval(id);

$(articleSelector).css('height', 'initial')

$(articleSelector).removeClass('lock')

$('#locker').css('display', 'none')

python 运行 js 脚本

pip install PyExecJS

eleme.js

function getParam(){

return 'hello world!'

}

xxx.py

import execjs

import os

os.environ["EXECJS_RUNTIME"] = "PhantomJS"

node = execjs.get()

file = 'eleme.js'

ctx = node.compile(open(file).read())

js_encode = 'getParam()'

params = ctx.eval(js_encode)

print(params)

python 包管理

virtualenv virtualwrapper pipenv pyenv --》 conda

步骤

1. pipenv shell

2. pip install scrapy

3. scrapy shell # 可以做 简单调试

3. scrapy startproject videospider # 生成 基本骨架

4. scrapy genspider jobbole www.jobbole.com

5. 取巧 构造一个 main.py 用来在 IDE 里调试

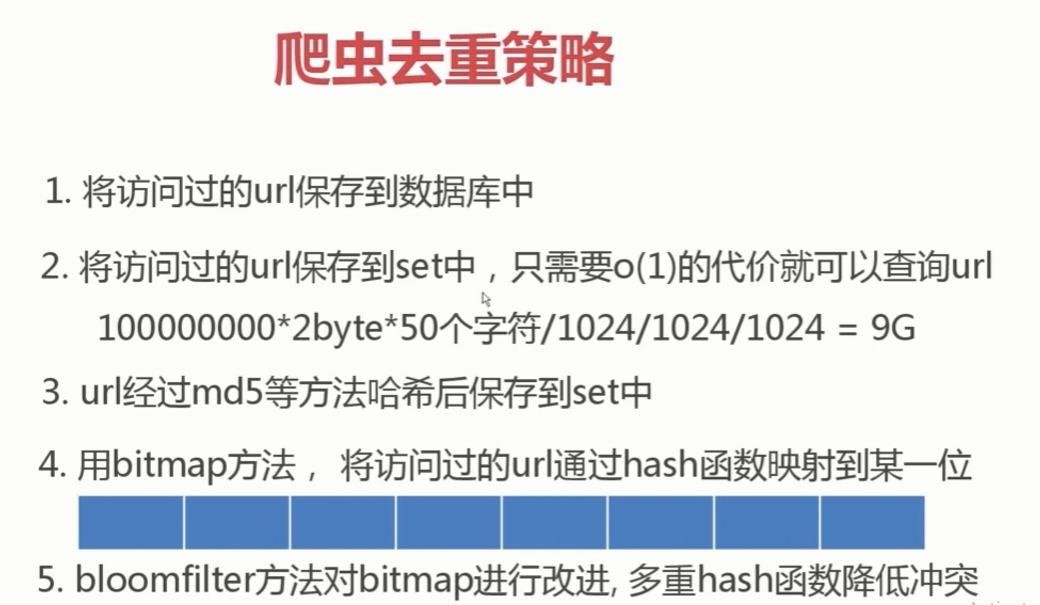

爬虫中 url 去重

set 去重 是 非常占用内存的

md5 信息摘要 算法 之后会省很多, 但是仍然不如 bitmap 方式

bitmap 会 很容易 造成 hash 冲突

bloom filter 这一种 可以通过 hash 函数 减少 hash 冲突

简而言之 言而简之 urls --> set(urls) --> set(md5(url) s) --> bitmap( xxx ) --> bloom filter( multi_hash_func ( xxx ))

下面这个教程要看评论再说。。。坑哭了

https://blog.csdn.net/chenvast/article/details/79103288

爬取 cnblog 文章 练手

# 使用 pipenv 管理环境

mkdir spiders

cd spiders

pipenv install

pip install scrapy -i http://pypi.douban.com/simple --trusted-host pypi.douban.com

# 利用 模板生成 项目基本样子 类似于 springboot

scrapy startproject ArticleSpider

# 爬取 二级域名下的 文章

cd xxx\ArticleSpider\ArticleSpider\spiders\

scrapy genspider cnblog news.cnblogs.com

# 修改 settings.py 中 的 爬虫配置 ROBOTSTXT_OBEY 为 False

ROBOTSTXT_OBEY = False

# 打开 编辑自动生成的 spider/cnblog.py

# -*- coding: utf-8 -*-

import scrapy

import re

from ArticleSpider.items import ArticleItem

from ArticleSpider.utils.utils import get_md5

from scrapy.http import Request

from urllib import parse

class CnblogSpider(scrapy.Spider):

name = 'cnblog'

allowed_domains = ['news.cnblogs.com']

start_urls = ['http://news.cnblogs.com/']

def parse(self, response):

news_selector_list = response.xpath('//div[@id="news_list"]/div[@class="news_block"]')

for news_selector in news_selector_list:

content = news_selector.xpath('div[@class="content"]')

anchor = content.xpath('h2/a')

article_url = anchor.xpath('@href').extract()[0]

article_title = anchor.xpath("text()").extract()[0]

article_front_image_url = content.xpath('div[@class="entry_summary"]/a/@href').extract()[0]

footer = content.xpath('div[@class="entry_footer"]')

article_author = footer.xpath('a/text()').extract()[0]

matched = re.match('评论\((\d+)\)', footer.xpath('span[@class="comment"]/a/text()').extract()[0])

article_comments = matched.group(1) if matched else 0

article_view = footer.xpath('span[@class="view"]').extract()[0]

article_tag = footer.xpath('span[@class="tag"]').extract()[0]

article_item = ArticleItem()

article_item['article_url'] = article_url

article_item['article_title'] = article_title

article_item['article_front_image_url'] = article_front_image_url

article_item['article_author'] = article_author

article_item['article_comments'] = article_comments

article_item['article_view'] = article_view

article_item['article_tag'] = article_tag

article_item['article_id'] = get_md5(article_url)

yield Request(url=parse.urljoin(response.url ,article_url),meta={"item":article_item}, callback=self.parse_detail)

pass

def parse_detail(self, response):

pass

# 有些时候 我们可以使用 Itemloader 来让我们的代码变得更友好

item_loadder = ItemLoader(item=ArticleItem(), response=response)

item_loadder.add_xpath(field_name="article_url", xpath="//div[@id='news_list']/div[@class='news_block']/div[@class='content']/h2/a/@href")

.

.

.

next_urls_selector = response.xpath('//*[@id="sideleft"]/div[5]/a[11]')

总结 对付反爬

访问 500 一般是 UA 没设置

cookie 携带

token

salt

sign

ctrl + shift + f 很好用 在查找 js 调用时候

cookies 池

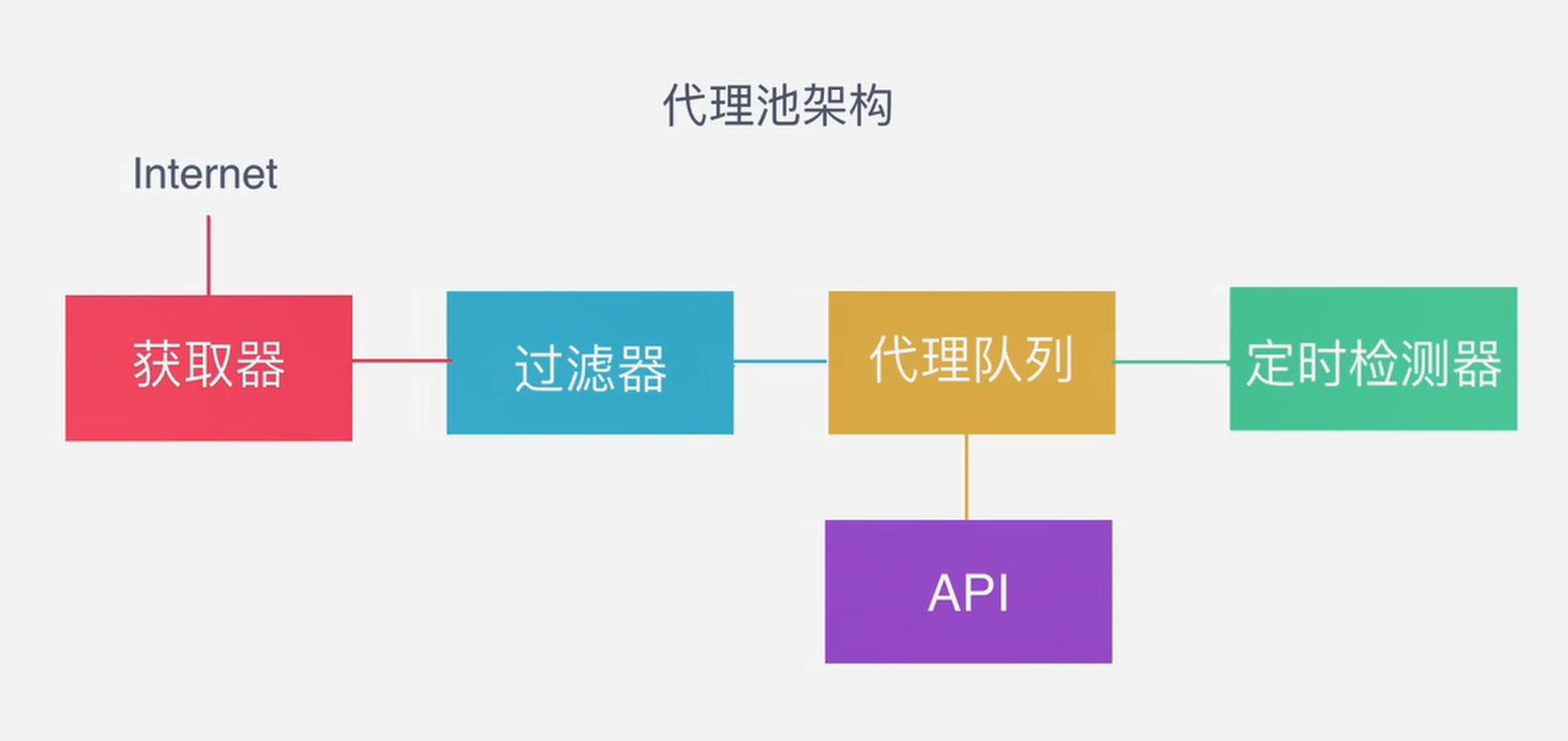

ip 代理 池

pip3 install faker

https://cmder.net/

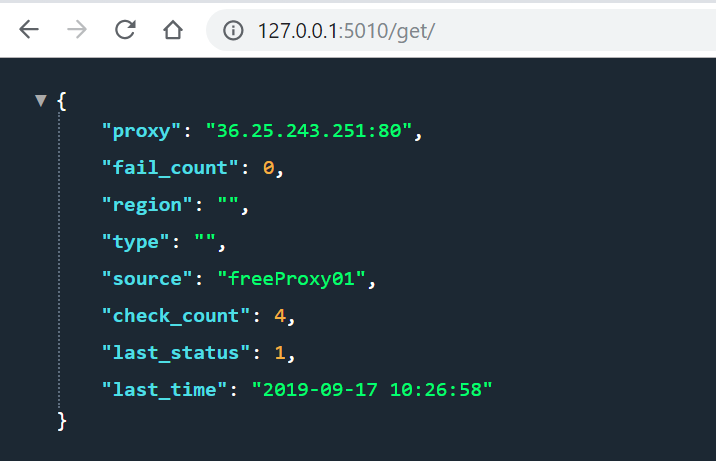

搭建自己的 ip 代理池

mongo db 安装使用

# 创建 ipproxy 数据库 如果没有就创建

use ipproxy;

### 插入数据

db.ipproxy.insert({"ip_port":"192.168.0.18:5678"})

# 删除 数据库

db.dropDatabase()

# 删除集合

db.collection.drop()

# 查询集合

db.ipproxy.find().pretty()

db.createCollection("mycol", { capped : true, autoIndexId : true, size :

6142800, max : 10000 } )

db.ipproxy.drop()

大型分布式爬虫准备 scrapy + request的更多相关文章

- scrapy 分布式爬虫- RedisSpider

爬去当当书籍信息 多台机器同时爬取,共用一个redis记录 scrapy_redis 带爬取的request对象储存在redis中,每台机器读取request对象并删除记录,经行爬取.实现分布式爬虫 ...

- scrapy分布式爬虫scrapy_redis二篇

=============================================================== Scrapy-Redis分布式爬虫框架 ================ ...

- scrapy分布式爬虫scrapy_redis一篇

分布式爬虫原理 首先我们来看一下scrapy的单机架构: 可以看到,scrapy单机模式,通过一个scrapy引擎通过一个调度器,将Requests队列中的request请求发给下载器,进行页 ...

- 第三百七十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索结果分页

第三百七十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索结果分页 逻辑处理函数 计算搜索耗时 在开始搜索前:start_time ...

- 第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能

第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能 Django实现搜索功能 1.在Django配置搜索结果页的路由映 ...

- 第三百六十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索的自动补全功能

第三百六十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—用Django实现搜索的自动补全功能 elasticsearch(搜索引擎)提供了自动补全接口 官方说明:https://www.e ...

- 第三百五十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—将bloomfilter(布隆过滤器)集成到scrapy-redis中

第三百五十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—将bloomfilter(布隆过滤器)集成到scrapy-redis中,判断URL是否重复 布隆过滤器(Bloom Filter)详 ...

- 第三百五十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—利用开源的scrapy-redis编写分布式爬虫代码

第三百五十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—利用开源的scrapy-redis编写分布式爬虫代码 scrapy-redis是一个可以scrapy结合redis搭建分布式爬虫的开 ...

- 第三百五十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy信号详解

第三百五十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy信号详解 信号一般使用信号分发器dispatcher.connect(),来设置信号,和信号触发函数,当捕获到信号时执行 ...

随机推荐

- PHP 封装POD 类

使用POD的过程 //1.造DSN:驱动名:dbname=数据库名;host=服务器地址 $dsn = "mysql:dbname=mydb;host=localhost"; // ...

- Cortex-M3 异常中断向量表

[Cortex-M3异常与中断] 支持10个系统异常和最多240个外部中断: 支持3个固定的高优先级和多达256级的可编程优先级,支持128级抢占: #0~15在Cortex-M3中定义,IRQ#0~ ...

- Python面向对象进阶和socket网络编程

写在前面 为什么坚持?想一想当初: 一.面向对象进阶 - 1.反射补充 - 通过字符串去操作一个对象的属性,称之为反射: - 示例1: class Chinese: def __init__(self ...

- kubernetes学习:CKA考试认证(二)

1. 它题的意思是 在 development 名称空间里面 找到名为 baz的 service 然后通过这个service的selector 找出 对应的pod . 要用 kubectl des ...

- Field in required a single bean, but 2 were found:

我在其他类注入的时候出现以下错误 @Autowired NodeAgentService nodeAgentService; 异常 Description: Field mibService in c ...

- Android开发 互相调用模式之导出Aar包、扩展MainActivity、Java主导

现在官方推荐使用这种方式 在讲导出Aar之前,先讲一下怎么设置图标,先把原xml中图标设置这句话复制过来 刚刚复制过来的时候这句话是红色报错的,这个时候我们把原res下的mipmap复制过来,也可以自 ...

- Linux 中账户管理

账户管理涉及到三个文件: 1./etc/passwd yy@ubuntu:~$ head -n 3 /etc/passwdroot:x:0:0:root:/root:/bin/bashdaemon:x ...

- cp 命令

cp - copy files and directories 用法: cp [OPTION] source dest DESCRIPTION Copy SOURCE to DEST, or mult ...

- [Python3] 035 函数式编程 高阶函数

目录 函数式编程 之 高阶函数 1. 引子 2. 系统提供的高阶函数 3. functools 包提供的 reduce 4. 排序 函数式编程 之 高阶函数 把函数作为参数使用的函数,叫高阶函数 1. ...

- 查找担保圈-step4-提取s1中担保圈路径中的成员

USE [test] GO /****** Object: StoredProcedure [dbo].[p02_get_group_member] Script Date: 2019/7/8 14: ...