deep_learning_Function_softmax_cross_entropy_with_logits

【TensorFlow】tf.nn.softmax_cross_entropy_with_logits的用法

在计算loss的时候,最常见的一句话就是tf.nn.softmax_cross_entropy_with_logits,那么它到底是怎么做的呢?

首先明确一点,loss是代价值,也就是我们要最小化的值

tf.nn.softmax_cross_entropy_with_logits(logits, labels, name=None)

除去name参数用以指定该操作的name,与方法有关的一共两个参数:

第一个参数logits:就是神经网络最后一层的输出,如果有batch的话,它的大小就是[batchsize,num_classes],单样本的话,大小就是num_classes

第二个参数labels:实际的标签,大小同上

具体的执行流程大概分为两步:

第一步是先对网络最后一层的输出做一个softmax,这一步通常是求取输出属于某一类的概率,对于单样本而言,输出就是一个num_classes

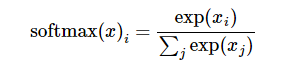

softmax的公式是:

至于为什么是用的这个公式?这里不介绍了,涉及到比较多的理论证明

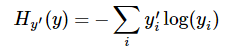

第二步是softmax的输出向量[Y1,Y2,Y3...]和样本的实际标签做一个交叉熵,公式如下:

其中 指代实际的标签中第i个的值(用mnist数据举例,如果是3,那么标签是[0,0,0,1,0,0,0,0,0,0],除了第4个值为1,其他全为0)

指代实际的标签中第i个的值(用mnist数据举例,如果是3,那么标签是[0,0,0,1,0,0,0,0,0,0],除了第4个值为1,其他全为0)

就是

就是softmax的输出向量[Y1,Y2,Y3...]

显而易见,预测

越准确,结果的值越小(别忘了前面还有负号),最后求一个平均,得到我们想要的loss

注意!!!这个函数的返回值并不是一个数,而是一个向量,如果要求交叉熵,我们要再做一步tf.reduce_sum操作,就是对向量里面所有元素求和,最后才得到 ,如果求loss,则要做一步

,如果求loss,则要做一步tf.reduce_mean操作,对向量求均值!

理论讲完了,上代码

- import tensorflow as tf

- #our NN's output

- logits=tf.constant([[1.0,2.0,3.0],[1.0,2.0,3.0],[1.0,2.0,3.0]])

- #step1:do softmax

- y=tf.nn.softmax(logits)

- #true label

- y_=tf.constant([[0.0,0.0,1.0],[0.0,0.0,1.0],[0.0,0.0,1.0]])

- #step2:do cross_entropy

- cross_entropy = -tf.reduce_sum(y_*tf.log(y))

- #do cross_entropy just one step

- cross_entropy2=tf.reduce_sum(tf.nn.softmax_cross_entropy_with_logits(logits, y_))#dont forget tf.reduce_sum()!!

- with tf.Session() as sess:

- softmax=sess.run(y)

- c_e = sess.run(cross_entropy)

- c_e2 = sess.run(cross_entropy2)

- print("step1:softmax result=")

- print(softmax)

- print("step2:cross_entropy result=")

- print(c_e)

- print("Function(softmax_cross_entropy_with_logits) result=")

- print(c_e2)

输出结果是:

- step1:softmax result=

- [[ 0.09003057 0.24472848 0.66524094]

- [ 0.09003057 0.24472848 0.66524094]

- [ 0.09003057 0.24472848 0.66524094]]

- step2:cross_entropy result=

- 1.22282

- Function(softmax_cross_entropy_with_logits) result=

- 1.2228

最后大家可以试试e^1/(e^1+e^2+e^3)是不是0.09003057,发现确实一样!!这也证明了我们的输出是符合公式逻辑的

deep_learning_Function_softmax_cross_entropy_with_logits的更多相关文章

随机推荐

- [Err] ORA-00942: table or view does not exist

[Err] ORA-00942: table or view does not exist 当前用户加表明 例如:SCOTT."replyInfo"

- 美化Eclipse-背景

为了美化Eclipse,请登录主题网站http://www.eclipsecolorthemes.org/ 下载EPF配置文件(截图如下),并导入eclispe即可. 导入方法: (1)从File菜单 ...

- cmake生成Makefile时指定c/c++编译器

cmake .. -DCMAKE_CXX_COMPILER:FILEPATH=/usr/local/bin/g++ -DCMAKE_C_COMPILER:FILEPATH=/usr/local/bin ...

- 7NiuYun云存储UploadPicture

1.七牛云云存储图片,上传.下载.源代码地址:ssh (git@gitee.com:516877626/QiNiuYunUploadpicture.git) .https(https://gitee. ...

- 走进异步编程的世界 - 在 GUI 中执行异步操作

转载:https://www.cnblogs.com/liqingwen/p/5877042.html 走进异步编程的世界 - 在 GUI 中执行异步操作 [博主]反骨仔 [原文地址]http://w ...

- WPF子线程更新UI(Dispatcher.BeginInvoke)

在做WPF开发时,如果直接在子线程里更新UI会报错—–“调用线程无法访问此对象,因为另一个线程拥有该对象.”,这是因为WPF禁止在非UI线程里直接更新UI界面. 解决方案: 在子线程里调用D ...

- 06 vue router(一)

一.vue route是什么? Vue Router是vue.js官方的路由管理器.主要有以下几种功能 1.路由和视图表的配置.(已明白) 2.模块化和基于组件的路由配置.(已明白) 3.路由参数.查 ...

- spring boot密码管理

1.引入依赖 <dependency> <groupId>com.github.ulisesbocchio</groupId> <artifactId> ...

- 用fiddler来学http协议:为什么会有“response body is encoded click to decode”

使用fiddler查看服务器返回的响应包的时候,我们常常会看到“response body is encoded click to decode”这样一个提示,只有点击它才能让响应包的主体内容从乱码变 ...

- 【HANA系列】【第七篇】SAP HANA XS使用Data Services查询CDS实体【一】

公众号:SAP Technical 本文作者:matinal 原文出处:http://www.cnblogs.com/SAPmatinal/ 原文链接:[HANA系列][第七篇]SAP HANA XS ...