hdfs、yarn集成ranger

一、安装hdfs插件

从源码安装ranger的服务器上拷贝hdfs的插件到你需要安装的地方

1、解压安装

# tar zxvf ranger-2.1.0-hdfs-plugin.tar.gz -C /data1/hadoop

2、修改插件配置文件,如下

# cd /data1/hadoop/ranger-2.1.0-SNAPSHOT-hdfs-plugin/

修改install.properties文件

主要修改以下几个参数:

POLICY_MGR_URL= http://192.168.4.50:6080 #policy地址,也就是ranger-admin地址

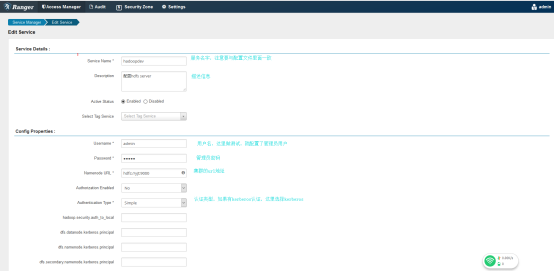

REPOSITORY_NAME=hadoopdev #服务名字,在ranger-admin前台创建的时候,需要与这个参数值一样。

XAAUDIT.SOLR.ENABLE=true #开启审计日志

XAAUDIT.SOLR.URL=http://192.168.4.50:6083/solr/ranger_audits #solr地址

CUSTOM_USER=hduser #定义插件用户,我猜这个值是启动集群的用户

CUSTOM_GROUP=hduser

3、修改hdfs配置文件

# vim hdfs-site.xml

添加如下配置:

<property>

<name>dfs.namenode.inode.attributes.provider.class</name>

<value>org.apache.ranger.authorization.hadoop.RangerHdfsAuthorizer</value>

</property>

<property>

<name>dfs.permissions</name>

<value>true</value>

</property>

<property>

<name>dfs.permissions.ContentSummary.subAccess</name>

<value>true</value>

</property>

4、启动插件

# sudo ./enable-hdfs-plugin.sh (需要root权限)

二、安装yarn插件

1、解压安装

# tar zxvf ranger-2.0.0-yarn-plugin.tar.gz -C /data1/hadoop

2、修改配置文件install.properties

修改如下属性:

POLICY_MGR_URL=http://192.168.4.50:6080

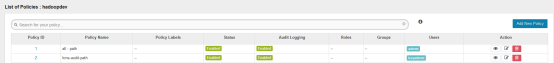

REPOSITORY_NAME=yarndev

XAAUDIT.SOLR.ENABLE=true

XAAUDIT.SOLR.URL=http://192.168.4.50:6083/solr/ranger_audits

CUSTOM_USER=hduser

CUSTOM_GROUP=hduser

3、修改yarn-site.xml配置文件

添加如下属性:

<property>

<name>yarn.acl.enable</name>

<value>true</value>

</property>

<property>

<name>yarn.authorization-provider</name>

<value>org.apache.ranger.authorization.yarn.authorizer.RangerYarnAuthorizer</value>

</property>

4、启动yarn插件

# ./enable-yarn-plugin.sh

# 重启集群

三、前台配置

1、hdfs配置

(1) 登录:http/192.168.4.50:6080

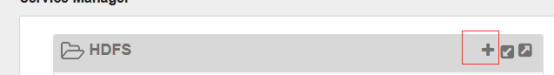

(1) 添加服务

点击加号添加服务

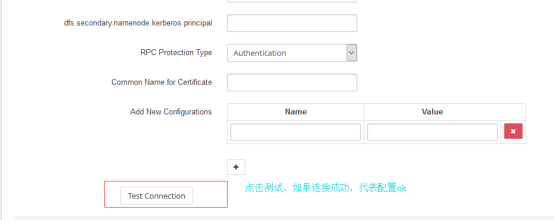

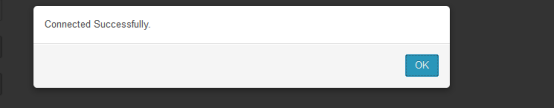

点击测试

配置完了不要忘记点击保存。

配置完在前台界面如下:

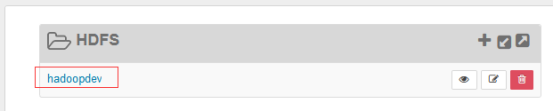

(1) 配置策略

点击hadoopdev进行策略的配置

默认已经有两个策略,这里点击右上角进行策略的添加

保存。

(1) 测试yjt这个用户是否还有对/out1这个目录有权限。

分析:

从上述可以看到,对于这个目录只要没有对用户或者组加决绝的ACL,正常是可以读取的,但是上述我们对yjt这个用户对/out1这个目录进行了策略控制(拒绝访问)的限制,可以看到,目前这个用户对于该目录没有权限读取了,说明配置成功。

2、yarn配置

(1) 添加服务

配置完可以进行测试连接,看配置是否ok

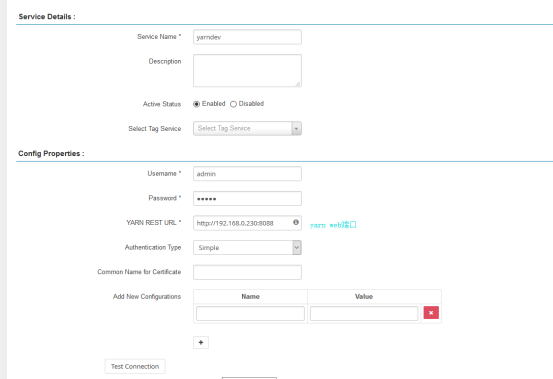

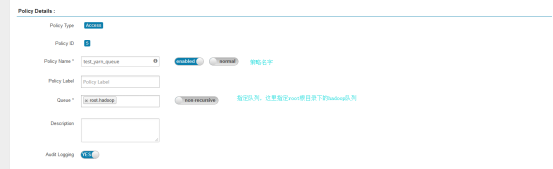

(1) 添加策略

对yarn的限制,主要是对于用户对队列的访问,以及任务提交限制

添加权限控制

(1) 测试yjt这个用户是否可以提交任务

从上可以看出,yjt这个用户,不允许提交任务到hadoop队列。

hdfs、yarn集成ranger的更多相关文章

- 2.安装hdfs yarn

下载hadoop压缩包设置hadoop环境变量设置hdfs环境变量设置yarn环境变量设置mapreduce环境变量修改hadoop配置设置core-site.xml设置hdfs-site.xml设置 ...

- Hue联合(hdfs yarn hive) 后续......................

1.启动hdfs,yarn start-all.sh 2.启动hive $ bin/hive $ bin/hive --service metastore & $ bin/hive --ser ...

- hdfs、yarn集成kerberos

1.kdc创建principal 1.1.创建认证用户 登陆到kdc服务器,使用root或者可以使用root权限的普通用户操作: # kadmin.local -q “addprinc -randke ...

- Hadoop HDFS, YARN ,MAPREDUCE,MAPREDUCE ON YARN

HDFS 系统架构图 NameNode 是主节点,存储文件的元数据,如文件名,文件目录结构,文件属性(生成时间,副本数,文件权限),以及每个文件的块列表和块所在的DataNode等.NameNode将 ...

- hadoop/hdfs/yarn 详细命令搬运

转载自文章 http://www.cnblogs.com/davidwang456/p/5074108.html 安装完hadoop后,在hadoop的bin目录下有一系列命令: container- ...

- centos7 hdfs yarn spark 搭建笔记

1.搭建3台虚拟机 2.建立账户及信任关系 3.安装java wget jdk-xxx rpm -i jdk-xxx 4.添加环境变量(全部) export JAVA_HOME=/usr/java/j ...

- Hadoop源代码点滴-系统结构(HDFS+YARN)

Hadoop建立起HDFS和YARN两个字系统,前者是文件系统,管数据存储:后者是计算框架,管数据处理. 如果只有HDFS而没有YARN,那么Hadoop集群可以被用作容错哦的文件服务器,别的就没有什 ...

- hadoop集群的各部分一般都会使用到多个端口,有些是daemon之间进行交互之用,有些是用于RPC访问以及HTTP访问。而随着hadoop周边组件的增多,完全记不住哪个端口对应哪个应用,特收集记录如此,以便查询。这里包含我们使用到的组件:HDFS, YARN, Hbase, Hive, ZooKeeper:

组件 节点 默认端口 配置 用途说明 HDFS DataNode 50010 dfs.datanode.address datanode服务端口,用于数据传输 HDFS DataNode 50075 ...

- kerberos系列之hdfs&yarn认证配置

一.安装hadoop 1.解压安装包重命名安装目录 [root@cluster2_host1 data]# tar -zxvf hadoop-2.7.1.tar.gz -C /usr/local/ [ ...

随机推荐

- springboot 接口参数校验

前言 在开发接口的时候,参数校验是必不可少的.参数的类型,长度等规则,在开发初期都应该由产品经理或者技术负责人等来约定.如果不对入参做校验,很有可能会因为一些不合法的参数而导致系统出现异常. 上一篇文 ...

- SOFT-NMS (二) (non maximum suppression,非极大值抑制)

import numpy as np boxes = np.array([[200, 200, 400, 400], [220, 220, 420, 420], [200, 240, 400, 440 ...

- Mybatis中使用association进行关联的几种方式

这里以一对一单向关联为例.对使用或不使用association的配置进行举例. 实体类: @Data @ToString @NoArgsConstructor public class IdCard ...

- 换个语言学一下 Golang (6)——数组,切片和字典

在上面的章节里面,我们讲过Go内置的基本数据类型.现在我们来看一下Go内置的高级数据类型,数组,切片和字典. 数组(Array) 数组是一个具有相同数据类型的元素组成的固定长度的有序集合.比如下面的例 ...

- 连续子数组的最大乘积及连续子数组的最大和(Java)

1. 子数组的最大和 输入一个整形数组,数组里有正数也有负数.数组中连续的一个或多个整数组成一个子数组,每个子数组都有一个和.求所有子数组的和的最大值.例如数组:arr[]={1, 2, 3, -2, ...

- 图片Image转换为base64编码的方法

1.FileReader 通过XMLHttpRequest请求图片Blob数据格式,然后利用FileReader转换为dataURL function toDataURL(url, callback) ...

- MySQL数据库之互联网常用分库分表方案

一.数据库瓶颈 不管是IO瓶颈,还是CPU瓶颈,最终都会导致数据库的活跃连接数增加,进而逼近甚至达到数据库可承载活跃连接数的阈值.在业务Service来看就是,可用数据库连接少甚至无连接可用.接下来就 ...

- EXPORT_SYMBOL

EXPORT_SYMBOL只出现在2.6内核中,在2.4内核默认的非static函数和变量都会自动导入到kernel 空间 作用 EXPORT_SYMBOL标签内定义的函数或者符号对全部内核代码公开, ...

- 笔谈kxmovie开源播放器库的使用

开源播放器项目 kxmovie(https://github.com/kolyvan/kxmovie),现在仍然是很多刚开始接触播放器开发的程序员的参照范本.以下是我操作kxmovie项目的过程: ( ...

- Hive使用过程中踩过的坑

hive启动时错误1 Cannot execute statement:impossible to write to binary long since BINLOG_FORMAT = STATEME ...