4-5 Scrapy知识补充

FormRequest

FormRequest类是专门用来处理HTML表单的,同时对隐藏的表单处理也很方便。适合用来完成登录操作。

类原型:class scrapy.http.FormRequest(url[, formdata, ...])其构造参数formdata可以是字典形式,也可以是(key, value)元组形式。代表需提交的表单数据。

return FormRequest(url="http://www.example.com/post/action",formdata={'name': 'John Doe', 'age': '27'},callback=self.after_login)

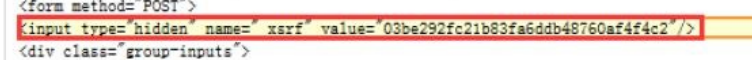

通常网站通过<inputtype=“hidden”>实现对某些表单字段(如数据或是登录界面中的认证令牌等)的预填充,如前知乎的 _xsrf参数。FormRequest类提供了一个类方法from_response。可以处理这种隐藏的表单。

注意html知识补充:所有需要登陆的表单字段都会在html中的form标签中找到,其中需要输入的在form标签的后辈节点input标签中,然后输出的name和value会在input标签中的name属性和value属性中找到。from_response正式利用此到form标签中的后辈节点寻找input标签然后将其name属性为key和value属性为value收集在一起构造(key, value)作为添加进入formdata的值。

from_response(response[, formname=None, formnumber=0, formdata=None, formxpath=None, clickdata=None])

参数说明:

response:一个包含HTML表单的响应页面。

formname(string):如果不为None,表单中的name属性将会被设定为这个值。

formnumber(int):当响应页面中包含多个HTML表单时,本参数用来指定使用第几个表单,第一个表单数字为0。

formdata(dict):本参数用来填充表单中属性的值。如果其中一个属性的值在响应页面中已经被预填充,但formdata中也指定了这个属性的值,将会把预填充的值覆盖掉。

formxpath(string):如果页面中有多个HTML表单,可以用xpath表达式定位页面中的表单,第一个被匹配的将会被操作。

用from_response方法来实现登录功能,示例如下:

import scrapy

class LoginSpider(scrapy.Spider):

name = 'example.com'

start_urls = ['http://www.example.com/users/login.php']

def parse(self, response):

return scrapy.FormRequest.from_response(response,formdata={'username': 'john', 'password': 'secret'},callback=self.after_login)

def after_login(self, response):

# check login succeed before going on

if "authentication failed" in response.body:

self.logger.error("Login failed")

return

BrowserCooCookieJarkiesMiddleware

源码分析:

首先构造方法中有个 self.jars = defaultdict(CookieJar) 这涉及到defaultdict()的使用。

defaultdict()方法和字典的用法大同小异,最大的区别是当defaultdict()可以接受一个函数或者是类作为参数,然后如果只指定defaultdict的一个键,那么该键的值会被默认的参数(如果是函数则为函数返回值,如果为类则为最基础类)填充。看实例:

from collections import defaultdict

a = defaultdict(list)

b = a['frank']

print(b) 输出结果:

[]

因为defaultdict参数为list,则当指定一个键frank的时候,就会设置该frank的值为一个最基础的列表,即[], 将其值赋给b所以b为[] 甚至可以不指定值给b,直接指定一个键,然后该defaultdict就会变成{'frank': []}

的形式。

from collections import defaultdict

a = defaultdict(list)

a['frank']

print(a) 输出结果:

defaultdict(<class 'list'>, {'frank': []})

回到BrowserCookiesMiddleware类,中构造方法,self.jars = defaultdict(CookieJar) 意思即为类的jars变量创建一个CookieJar对象。 回到CookieJar源码,可以看到该类有一个重要的方法,set_cookie(),该防范出入一个cookie对象作为参数,然后将其添加到CookieJar中。于是根据以上我们可以自己设置自己的 BrowserCooCookieJarkiesMiddleware 来为Request设置cookie

import browsercookie

from scrapy.downloadermiddlewares.cookies import CookiesMiddleware

class MyCookie(CookiesMiddleware):

def __init__(self, debug=False):

super().__init__(debug)

self.load_browser_cookies()

def load_browser_cookies(self):

# 加载Chrome 浏览器中的Cookie

jar = self.jars['chrome']

chrome_cookiejar = browsercookie.chrome()

for cookie in chrome_cookiejar:

jar.set_cookie(cookie)

分析:

- self.load_browser_cookies方法加载浏览器Cookie 。

- 在load_browser_cookies方法中,使用self.jars['chrome']和self.jars['firefox']从默认字典中获得两个CookieJar对象。

- 然后调用browsercookie的chrome和firefox方法,分别获取两个浏览器中的Cookie,将它们填入各自的CookieJar对象中。

Scrapy & bloomfilter

scrapy 自带的去重方案是set()与hashlib.sha1()完成的。源码如下:

def __init__(self, path=None, debug=False):

self.file = None

self.fingerprints = set()

self.logdupes = True

self.debug = debug

self.logger = logging.getLogger(__name__)

if path:

self.file = open(os.path.join(path, 'requests.seen'), 'a+')

self.file.seek(0)

self.fingerprints.update(x.rstrip() for x in self.file)

request_fingerprint方法实现过滤的,将Request指纹添加到set()中。部分源码如下:

def request_fingerprint(request, include_headers=None):

if include_headers:

include_headers = tuple(to_bytes(h.lower())

for h in sorted(include_headers))

cache = _fingerprint_cache.setdefault(request, {})

if include_headers not in cache:

fp = hashlib.sha1()

fp.update(to_bytes(request.method))

fp.update(to_bytes(canonicalize_url(request.url)))

fp.update(request.body or b'')

if include_headers:

for hdr in include_headers:

if hdr in request.headers:

fp.update(hdr)

for v in request.headers.getlist(hdr):

fp.update(v)

cache[include_headers] = fp.hexdigest()

return cache[include_headers]

去重指纹为sha1(method+url+body+header)

4-5 Scrapy知识补充的更多相关文章

- scrapy知识补充--scrapy shell 及Spider

什么是scrapy shell? Scrapy终端是一个交互终端,我们可以在未启动spider的情况下尝试及调试代码,也可以用来测试xpath或css表达是,来查看他们的工作方式,方便爬取页面中的数据 ...

- Redis基础知识补充及持久化、备份介绍(二)--技术流ken

Redis知识补充 在上一篇博客<Redis基础认识及常用命令使用(一)--技术流ken>中已经介绍了redis的一些基础知识,以及常用命令的使用,本篇博客将补充一些基础知识以及redis ...

- CRM中QueryDict和模型表知识补充

CRM中QueryDict和模型表知识补充 1.QueryDict的用法 request.GET的用法:1.在页面上输入:http://127.0.0.1:8000/index/print(reque ...

- Android知识补充(Android学习笔记)

Android知识补充 ●国际化 所谓的国际化,就是指软件在开发时就应该具备支持多种语言和地区的功能,也就是说开发的软件能同时应对不同国家和地区的用户访问,并针对不同国家和地区的用户,提供相应的.符合 ...

- (C/C++学习笔记) 二十四. 知识补充

二十四. 知识补充 ● 子类调用父类构造函数 ※ 为什么子类要调用父类的构造函数? 因为子类继承父类,会继承到父类中的数据,所以子类在进行对象初始化时,先调用父类的构造函数,这就是子类的实例化过程. ...

- SQL语句之 知识补充

SQL语句之 知识补充 一.存储过程 运用SQL语句,写出一个像函数的模块,这就是存储过程. 需求: 编写存储过程,查询所有员工 -- 创建存储过程(必须要指定结束符号) -- 定义结束符号 DELI ...

- Python学习---django知识补充之CBV

Django知识补充之CBV Django: url --> def函数 FBV[function based view] 用函数和URL进行匹配 url --> ...

- 34、Scrapy 知识总结

Scrapy 知识总结 1.安装 pip install wheel pip install https://download.lfd.uci.edu/pythonlibs/q5gtlas ...

- Redis基础知识补充及持久化、备份介绍

Redis知识补充 在上一篇博客<Redis基础认识及常用命令使用(一)–技术流ken>中已经介绍了redis的一些基础知识,以及常用命令的使用,本篇博客将补充一些基础知识以及redis持 ...

随机推荐

- springcloud学习之路: (三) springcloud集成Zuul网关

网关就是做一下过滤或拦截操作 让我们的服务更加安全 用户访问我们服务的时候就要先通过网关 然后再由网关转发到我们的微服务 1. 新建一个网关服务Module 2. 依然选择springboot工程 3 ...

- Windows | Ubuntu 16.04/18.04 安装Pycharm并永久破解以及安装配置Anaconda3

Ubuntu 18.04下 1.安装python 2._版本,输入 sudo apt install python 命令行输入 python或python3会打开对应的版本. 输入 exit()或C ...

- CMakeLists.txt编写常用命令

目录 1. 设置cmake最小版本 2. 设置项目名称 3. 设置编译目标类型 4. 指定编译包含的源文件 1. 明确指明包含的源文件 2. 搜索指定目录的所有的cpp文件 3. 自定义搜索规则 4. ...

- 链接(url)中不能有汉字,遇到汉字,需要使用quote转换之后使用

from urllib.parse import quotename=quote("翻译")print(name)

- 201871010121-王方-《面向对象程序设计java》第十六周实验总结

项目 内容 这个作业属于哪个课程 https://www.cnblogs.com/nwnu-daizh 这个作业的要求在哪里 https://www.cnblogs.com/nwnu-daizh/p/ ...

- LeetCode 145. Binary Tree Postorder Traversal二叉树的后序遍历 (C++)

题目: Given a binary tree, return the postorder traversal of its nodes' values. Example: Input: [1,nul ...

- 点云深度学习的3D场景理解

转载请注明本文链接: https://www.cnblogs.com/Libo-Master/p/9759130.html PointNet: Deep Learning on Point Sets ...

- leetcode209. 长度最小的子数组

双指针滑动窗口解法,时间复杂度O(N). 滑动窗口,想象一下,在一个坐标上存在两个指针begin 和i ,begin 代表滑窗的左边框,i代表滑窗的右边框.两者通过分别向右滑动,前者能使窗口之间的和减 ...

- Python进阶-VII 内置函数

一.内置函数引入 我们已经了解的有; print() input() range() next() dir() str() int() list() set() tuple() dict() he ...

- ABP 不包裹返回的数据

告诉abp不包裹返回的数据,返回的数据是什么 就是什么 不用再多包裹一次了. 用在 如:别人需要你提供接口 且给你指定了返回的数据结构. 源码: