[基础]斯坦福cs231n课程视频笔记(二) 神经网络的介绍

Introduction to Neural Networks

BP

梯度反向传播BackPropagation,是神经网络中的重要算法,主要思想是:

计算网络的输出与期望输出之间的误差

将误差从网络的输出层回传,沿着网络逐层传递,传递的是损失值相对当前层里参数的梯度

当每一层都接收到该层的参数梯度时,沿着梯度方向更新参数

用更新后的网络参数来计算新的输出,再重新计算误差,误差梯度回传,循环上述过程直到参数收敛

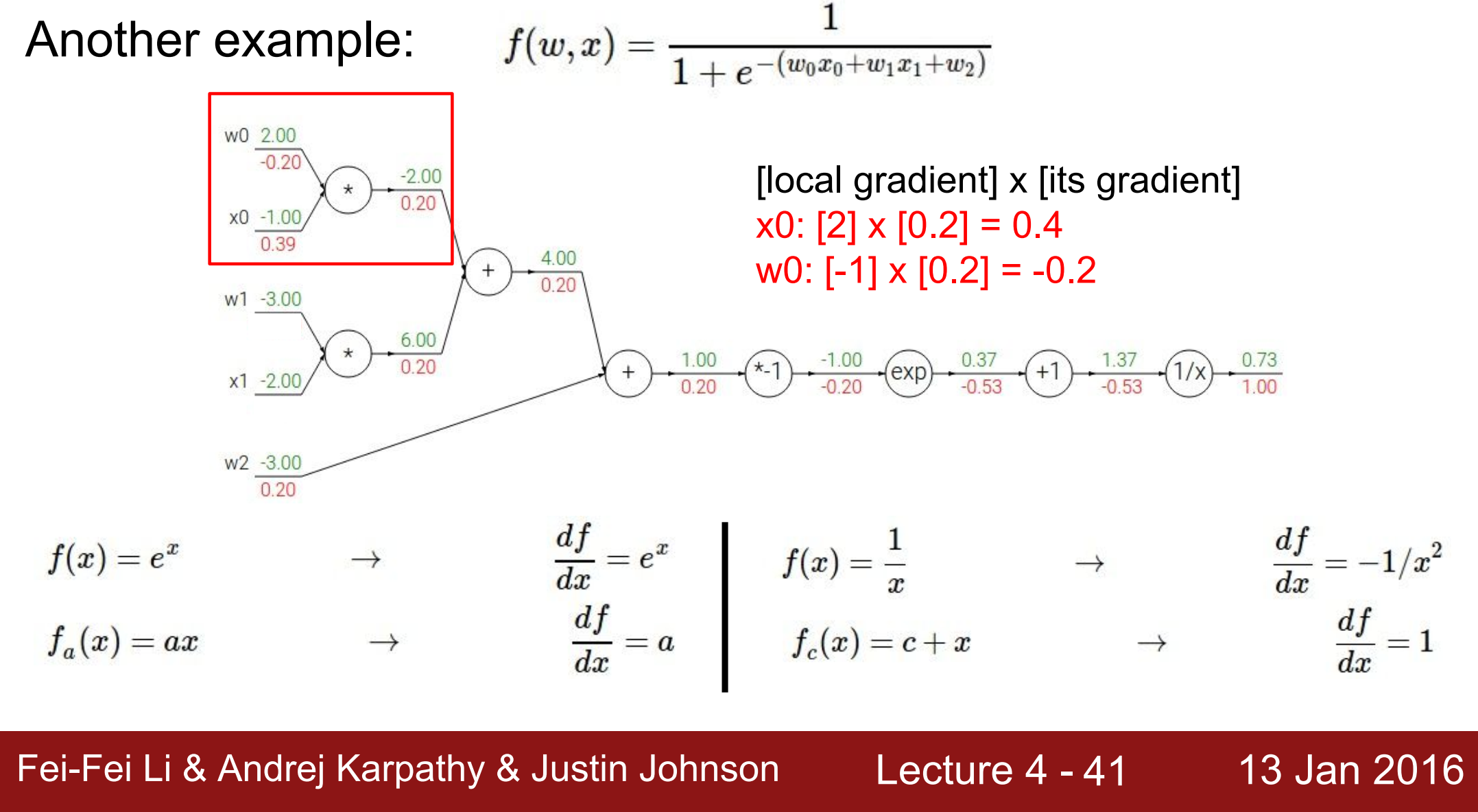

结合计算图来理解:

computation graph 计算图

任何函数都可以拆成计算图的形式

绿色的部分,是每个计算节点的输入值和输出值,即forward pass

红色的部分,是网络最终输出对于每个节点的梯度= local gradient * 前一个节点的梯度,即backward pass

- 最终输出的节点

\[\frac{\partial f}{\partial f} = 1 \] - 对前一个节点的梯度:记 $f = \frac{1}{z} $ (z为中间变量的名称),

\[ \frac{\partial f}{\partial z} = \frac{\partial f}{\partial f} * \frac{\partial f}{\partial z} = 1 * \frac{-1}{1.37^2} =-0.53 \] - 对倒数第二个节点的梯度:记 $z = h+1 $,

\[ \frac{\partial f}{\partial h} = \frac{\partial f}{\partial z} * \frac{\partial z}{\partial h} = -0.53*1 =-0.53 \] - 对倒数第三个节点的梯度:记 \(h = e^m\) ,

\[ \frac{\partial f}{\partial m} = \frac{\partial f}{\partial h} * \frac{\partial h}{\partial m} = -0.53*e^{-1} =-0.20 \]

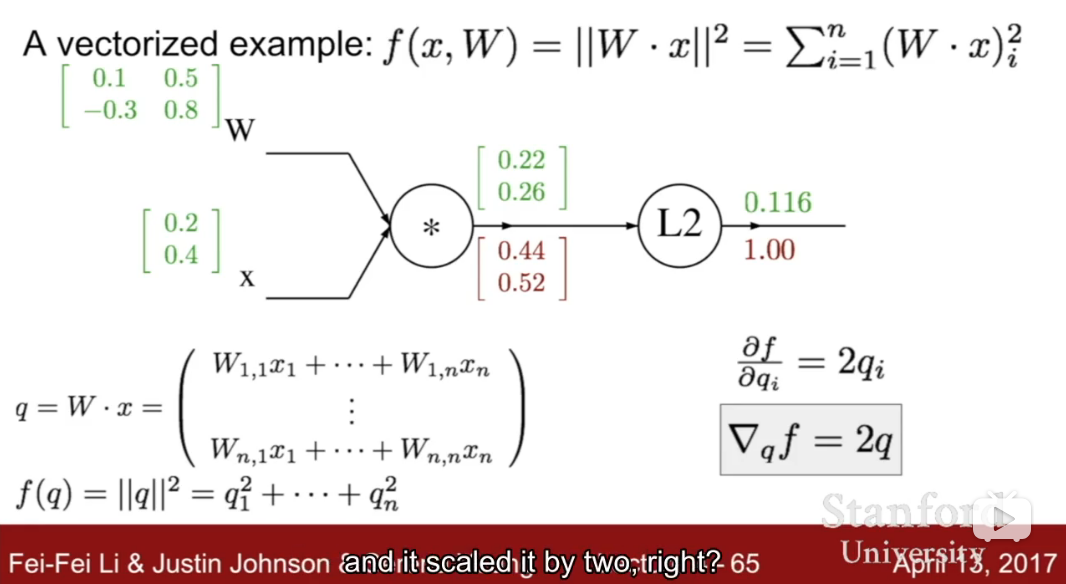

将一维推广到多维,现在假设W是 2 * 2,x是 2 维向量

【注意】

在全连接网络Fully Connected Network中,做反向传播时,误差对偏置bias的求导,需要对所有样本求和,这是因为loss就是对所有样本求和的结果,简单推理如下:

\[

shape \ of\ x:(N,D),\ shape\ of\ w:(D,), \ shape \ of \ b:(D,) \\

loss = \sum_{i=1}^N L_i \ , loss \ is \ a \ constant \\

d\ scores = \frac{d\ loss}{d\ scores} \ , shape \ is\ (N,D) \\

scores = wx + b \\

d\ b_j = \frac{d\ loss_j}{d\ b_j} = \frac{d\ loss}{d\ scores} * \frac{d\ scores}{d\ b} =\sum_i^N d\ scores_{ij} \\

<=> d\ b_j = \frac{d\ scores_{1j}+d\ scores_{2j}+...}{d\ b_j} \\ (d\ loss_j = \sum_i^N L_{ij} )

\]

Nerual Network

neural network are a class of functions where we have simpler functions that are stacked on top of each other with non-linear functions in-between.. and we stacked them in a hierarchical way in order to make up a more complex non-linear function

可以看做是线性函数的叠加,同时线性函数层之间还夹杂着非线性层,来使网络具有非线性

- 如果单纯全是线性层的话,网络的代表能力会比较差 即难以表示复杂的变化:想象一下 多个线性函数的叠加在一起得到的也是线性函数 而线性函数的表达能力比较差 比如二维坐标系x-y下的线性函数只是一条直线,当特征产生一些变化 输出必须随之变化

网络中不同线性函数层是在提取不同层次的特征,网络中较低的层提取低层的语义特征,越高层提取到的特征越抽象。比如:

- 网络有两层线性函数层,对于输入图像,第一层的特征(or templates)有专门检测左侧人脸的滤波器,和检测右侧人脸的滤波器;而第二层特征是对第一层提取出来的特征做weighted sum 可以理解为第二层的特征有专门检测人脸的滤波器

- 如果输入图像是左侧人脸,那么经过第一层特征提取之后,检测左侧人脸滤波器得到的结果(score)比检测右侧人脸滤波器得到的结果高,然后输入到第二层,经过第二层的特征提取之后,在检测人脸的滤波器得到的结果(score)比在检测车的滤波器得到的结果高,第二层的输出即为网络的输出。

- 如果输入图像是正面人脸,那么经过第一层,左侧人脸滤波器得到的结果可能大致等于右侧人脸滤波器的结果,而经过第二层之后,得到的输出仍然也是人脸的可能性高于车辆。

Convolutional Neural Network

参见之前的博文

[基础]斯坦福cs231n课程视频笔记(二) 神经网络的介绍的更多相关文章

- [基础]斯坦福cs231n课程视频笔记(三) 训练神经网络

目录 training Neural Network Activation function sigmoid ReLU Preprocessing Batch Normalization 权重初始化 ...

- [基础]斯坦福cs231n课程视频笔记(一) 图片分类之使用线性分类器

线性分类器的基本模型: f = Wx Loss Function and Optimization 1. LossFunction 衡量在当前的模型(参数矩阵W)的效果好坏 Multiclass SV ...

- 转:深度学习斯坦福cs231n 课程笔记

http://blog.csdn.net/dinosoft/article/details/51813615 前言 对于深度学习,新手我推荐先看UFLDL,不做assignment的话,一两个晚上就可 ...

- 神经网络系列学习笔记(二)——神经网络之DNN学习笔记

一.单层感知机(perceptron) 拥有输入层.输出层和一个隐含层.输入的特征向量通过隐含层变换到达输出层,在输出层得到分类结果: 缺点:无法模拟稍复杂一些的函数(例如简单的异或计算). 解决办法 ...

- Linux入门视频笔记二(Shell)

一.Shell脚本编程基础 1.简单地理解是脚本就是一堆的Linux命令或其他命令,把他们写到一起,打包成一个文件就是脚本,Shell脚本一般以.sh后缀结尾 2.sh text.sh:运行text. ...

- javass 视频笔记二 (关键字,标示符,常量变量,运算符和if-else)

1,java的关键字和标识符2,java的基本数据类型3,变量和常量4,java的运算符5,if-else if - else表达式1,java的关键字和标识符 1.1,所有关键字都要小写 ...

- 《分布式Java应用之基础与实践》读书笔记二

远程调用方式就是尽可能地使系统间的通信和系统内一样,让使用者感觉调用远程同调用本地一样,但其实没没有办法做到完全透明,例如由于远程调用带来的网络问题.超时问题.序列化/反序列化问题.调式复杂的问题等. ...

- 斯坦福机器学习课程 Exercise 习题二

Exercise 2: Linear Regression 话说LaTex用起来好爽 Matlab代码 迭代并且画出拟合曲线 Linear regression 公式如下 hθ(x)=θTx=∑i=0 ...

- CS231n课程笔记翻译9:卷积神经网络笔记

译者注:本文翻译自斯坦福CS231n课程笔记ConvNet notes,由课程教师Andrej Karpathy授权进行翻译.本篇教程由杜客和猴子翻译完成,堃堃和李艺颖进行校对修改. 原文如下 内容列 ...

随机推荐

- 201871010111-刘佳华《面向对象程序设计(java)》第七周学习总结

201871010111-刘佳华<面向对象程序设计(java)>第七周学习总结 实验时间 2019-10-11 1.实验目的与要求 1) 掌握四种访问权限修饰符的使用特点: (1)进一步理 ...

- 面向对象程序设计(JAVA) 第8周学习指导及要求

2019面向对象程序设计(Java)第8周学习指导及要求 (2019.10.18-2019.10.21) 学习目标 掌握接口定义方法: 掌握实现接口类的定义要求: 掌握实现了接口类的使用要求: 理解 ...

- web-综合题2

地址 http://cms.nuptzj.cn/ 0x01 很有意思的一题综合题,确实包含的内容比较多 打开页面 把能打开的都打开,能看的都看一下 几个重点的信息 一段hash e045e454c1 ...

- 矩阵快速幂之Kiki & Little Kiki 2

题意是:给出一串01串,每一秒,每个位置得灯会根据左边那个灯得状态进行改变,(第一个得左边为最后一个)如果左边为1,那么自己就会改变状态,左边为0则不用,问n秒改01串的状态 ///// 首先,我们发 ...

- ORM对象关系映射:

django配置orm: django使用mysql数据库: 首先cmd创建库 settings配置mysql数据库: DATABASES = { 'default': { 'ENGINE': 'dj ...

- angular 运行报错

angular 运行时报错ERROR in node_modules/rxjs/internal/types.d.ts(81,44): error TS1005: ';' expected. node ...

- [东西]neverOpen

一.介绍 用于完成一项光荣而伟大的使命. 二.更新日志 当前版本:V5.0 - 20191107 --------------------------------------------------- ...

- ORB-SLAM2 地图保存

一.简介 在ORB-SLAM2的System.h文件中,有这样一句话:// TODO: Save/Load functions,让读者自己实现地图的保存与加载功能.其实在应用过程中很多场合同样需要先保 ...

- [LOJ 6288]猫咪[CF 700E]Cool Slogans

[LOJ 6288]猫咪[CF 700E]Cool Slogans 题意 给定一个字符串 \(T\), 求一个最大的 \(K\) 使得存在 \(S_1,S_2,\dots,S_k\) 满足 \(S_1 ...

- OpenDaylight开发hello-world项目之开发工具安装

OpenDaylight开发hello-world项目之开发环境搭建 OpenDaylight开发hello-world项目之开发工具安装 OpenDaylight开发hello-world项目之代码 ...