【翻译】Flink Table Api & SQL —— Overview

本文翻译自官网:https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/

一直没有用 flink 的 table 或 sql api,最近开始要使用这部分功能了,先把官网对应的文档翻译一遍,方便自己慢慢查看

-----------------------------------------------

Apache Flink 具有两个关联 API-Table API 和 SQL - 用于统一流和批处理。Table API 是用 于 Scala 和Java 的语言集成查询 API,它允许以非常直观的方式组合来自关系运算符(例如选择,过滤和联接)的查询。Flink 的 SQL 基于实现 SQL 标准的 Apache Calcite。无论输入是批处理输入(DataSet)还是流输入(DataStream),在两个接口中指定的查询都具有相同的语义并指定相同的结果。

Table API 和 SQL 接口与 Flink 的 DataStream 和 DataSet API 紧密集成在一起。您可以轻松地在所有 API 和基于 API 的库之间切换。例如,您可以使用 CEP 库从 DataStream 中提取模式,然后再使用 Table API 分析模式,或者您可以在预处理程序上运行 Gelly 图算法之前,使用 SQL 查询、扫描、过滤和聚合批处理表数据。

请注意,Table API和SQL尚未完成功能,正在积极开发中。[Table API,SQL]和[stream,batch]输入的每种组合都不支持所有操作。

依赖结构

从 Flink 1.9 开始,Flink 提供了两种不同的计划程序实现来评估 Table&SQL API 程序:Blink planner 和Flink 1.9之前可用的 old planner。planner 负责将关系运算符转换为可执行的、优化的 Flink 作业。两种 planner 带有不同的优化规则和运行时类。它们在支持的功能方面也可能有所不同。

注意对于生产用例,建议使用Flink 1.9之前的 old planner。

所有 Table API 和 SQL 组件都捆绑在 flink-table 或 flink-table-blink Maven 组件中。

以下依赖关系与大多数项目有关:

flink-table-common:用于通过自定义功能,格式等扩展表生态系统的通用模块。flink-table-api-java:适用于使用 Java 编程语言的纯表程序的 Table&SQL API(处于开发初期,不建议使用!)。flink-table-api-scala:使用 Scala 编程语言的纯表程序的 Table&SQL API(处于开发初期,不建议使用!)。flink-table-api-java-bridge:使用 Java 编程语言支持带有 DataStream / DataSet API 的 Table&SQL API。flink-table-api-scala-bridge:使用 Scala 编程语言支持带有 DataStream / DataSet API 的 Table&SQL API。flink-table-planner:表程序 planner 和运行时。这是1.9版本之前Flink的唯一 planner 。现在仍然是推荐的。flink-table-planner-blink:新的 Blink planner 。flink-table-runtime-blink:新的 Blink runtime。flink-table-uber:将上述 API 模块以及 old planner 打包到大多数 Table&SQL API 用例的分发中。默认情况下,超级 JAR 文件flink-table-*.jar位于 Flink版本的目录 /lib 中。flink-table-uber-blink:将上述API模块以及特定于Blink的模块打包到大多数Table&SQL API用例的分发中。默认情况下,uber JAR 文件flink-table-blink-*.jar位于/libFlink版本的目录中。

有关如何在表程序中的新旧 planner 之间进行切换的更多信息,请参见通用API页面。

表程序依赖性

根据目标编程语言,您需要将Java或Scala API添加到项目中,以便使用Table API和SQL定义管道:

<!-- Either... -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-api-java-bridge_2.11</artifactId>

<version>1.9.0</version>

<scope>provided</scope>

</dependency>

<!-- or... -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-api-scala-bridge_2.11</artifactId>

<version>1.9.0</version>

<scope>provided</scope>

</dependency>

此外,如果要在IDE中本地运行Table API和SQL程序,则必须添加以下一组模块之一,具体取决于要使用的 planner :

<!-- Either... (for the old planner that was available before Flink 1.9) -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-planner_2.11</artifactId>

<version>1.9.0</version>

<scope>provided</scope>

</dependency>

<!-- or.. (for the new Blink planner) -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-planner-blink_2.11</artifactId>

<version>1.9.0</version>

<scope>provided</scope>

</dependency>

在内部,表生态系统的一部分在Scala中实现。因此,请确保为批处理和流应用程序都添加以下依赖项:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_2.11</artifactId>

<version>1.9.0</version>

<scope>provided</scope>

</dependency>

扩展依赖

如果要实现与Kafka或一组用户定义的函数进行交互的自定义格式,则以下依赖关系就足够了,并且可以用于SQL Client的JAR文件:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-common</artifactId>

<version>1.9.0</version>

<scope>provided</scope>

</dependency>

当前,该模块包括以下扩展点:

SerializationSchemaFactoryDeserializationSchemaFactoryScalarFunctionTableFunctionAggregateFunction

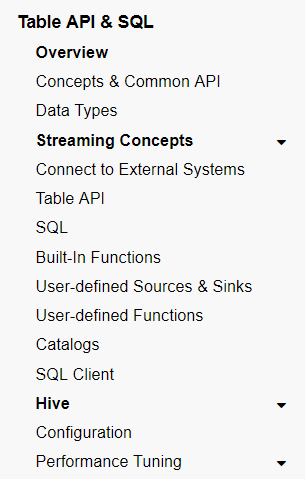

接下来要去哪里?

- 概念和通用API:表API和SQL的共享概念和API。

- 数据类型:列出预定义的数据类型及其属性。

- 流概念:Table API或SQL的流特定文档,例如时间属性的配置和更新结果的处理。

- 连接到外部系统:可用的连接器和格式,用于向外部系统读取和写入数据。

- Table API:Table API支持的操作和API。

- SQL:SQL支持的操作和语法。

- 内置函数:Table API和SQL支持的函数。

- SQL客户端:使用Flink SQL并在没有编程知识的情况下将表程序提交给集群。

欢迎关注Flink菜鸟公众号,会不定期更新Flink(开发技术)相关的推文

【翻译】Flink Table Api & SQL —— Overview的更多相关文章

- Flink Table Api & SQL 翻译目录

Flink 官网 Table Api & SQL 相关文档的翻译终于完成,这里整理一个安装官网目录顺序一样的目录 [翻译]Flink Table Api & SQL —— Overv ...

- 【翻译】Flink Table Api & SQL — 流概念

本文翻译自官网:Streaming Concepts https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/st ...

- 【翻译】Flink Table Api & SQL — 性能调优 — 流式聚合

本文翻译自官网:Streaming Aggregation https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table ...

- 【翻译】Flink Table Api & SQL — 配置

本文翻译自官网:Configuration https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/config.h ...

- 【翻译】Flink Table Api & SQL — Hive —— 在 scala shell 中使用 Hive 连接器

本文翻译自官网:Use Hive connector in scala shell https://ci.apache.org/projects/flink/flink-docs-release-1 ...

- 【翻译】Flink Table Api & SQL — Hive —— Hive 函数

本文翻译自官网:Hive Functions https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/hive/h ...

- 【翻译】Flink Table Api & SQL — SQL客户端Beta 版

本文翻译自官网:SQL Client Beta https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/sqlCl ...

- 【翻译】Flink Table Api & SQL — Hive —— 读写 Hive 表

本文翻译自官网:Reading & Writing Hive Tables https://ci.apache.org/projects/flink/flink-docs-release-1 ...

- 【翻译】Flink Table Api & SQL —— 概念与通用API

本文翻译自官网:https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/common.html Flink Tabl ...

随机推荐

- swagger2 注解说明

整体说明 用于controller类上 注解 说明 @Api 协议集描述 方法上 注解 说明 @ApiOperation - @ApiImplicitParams 方法上 @ApiImplicitPa ...

- 账户(/etc/passwd、/etc/shadow)与组(/etc/group、/etc/gshadow)文件解析

1. 账户信息文件 账户信息被保存在 /etc/passwd 文件中,通过命令 cat /etc/passwd 查看文件内容如下: [root@192 ~]# cat /etc/passwdroot: ...

- Django REST framework —— 权限组件源码分析

在上一篇文章中我们已经分析了认证组件源码,我们再来看看权限组件的源码,权限组件相对容易,因为只需要返回True 和False即可 代码 class ShoppingCarView(ViewSetMix ...

- 前端性能----页面渲染(DOM)

CSS会阻塞渲染树的构建,不阻塞DOM构建,但是在CSSOM构建完成之前,页面不会开始渲染(一片空白),CSSOM构建完成后,页面将会显示出内容. DOM(Document Object Model) ...

- 性能:Receiver层面

创建多个接收器 多个端口启动多个receiver在其他Executor,接收多个端口数据,在吞吐量上提高其性能.代码上: import org.apache.spark.storage.Storage ...

- (转)接口测试工具Postman使用实践

一.接口定义 软件不同部分之间的交互接口.通常就是所谓的API――应用程序编程接口,其表现的形式是源代码. —— [ 百度百科 ]我们常说的接口一般指两种:(1)API:应用程序编程接口.程序间的接口 ...

- 讨论---MySQL数据库中null、''、' '区别

今天在写代码的时候,遇到了一个关于MySQL数据库的问题,发现在表中插入‘’数据的时候插入不进去.发现这张表中的数据没有数据的时候,默认显示的null,当时自己又重复的额试了几次,但是始终没有成功,从 ...

- 51nod1463 找朋友

[传送门] 写的时候一直没有想到离线解法,反而想到两个比较有趣的解法.一是分块,$f[i][j]$表示第$i$块块首元素到第$j$个元素之间满足条件的最大值(即对$B_l + B_r \in K$的$ ...

- LeetCode 428. Serialize and Deserialize N-ary Tree

原题链接在这里:https://leetcode.com/problems/serialize-and-deserialize-n-ary-tree/ 题目: Serialization is the ...

- [RN] React Native 实现 类似QQ 登陆页面

[RN] React Native 实现 类似QQ 登陆页面 一.主页index.js 项目目录下index.js /** * @format */ import {AppRegistry} from ...