33、shuffle性能优化

一、shuffle性能优化

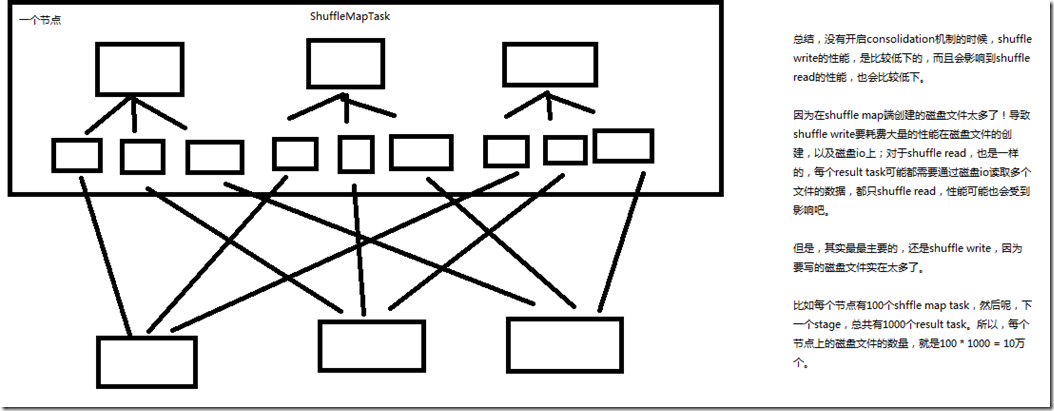

1、没有开启consolidation机制的性能低下的原理剖析

2、开启consolidation机制之后对磁盘io性能的提升的原理

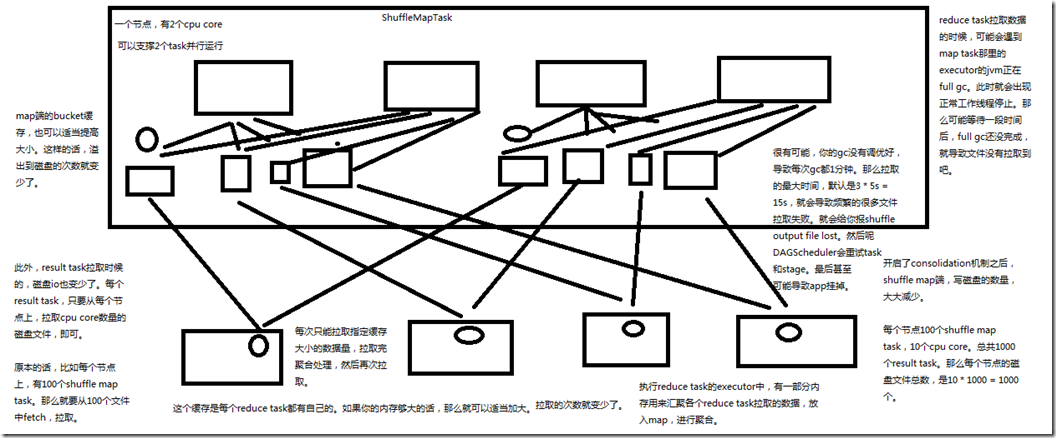

spark.shuffle.consolidateFiles:是否开启shuffle block file的合并,默认为false; 总结,开启了consolidation机制之后,shuffle map端,写磁盘的数量,大大减少; 比如节点100个shuffle map task ,10个cpu core,总共1000个result task,那么每个节点的磁盘文件总数,是10 * 1000 = 1万个; 此外,result task拉取的时候,磁盘io也变少了,每个result task,只要从每个节点上,拉取cpu core数量的磁盘文件即可; 比如,每个节点上,有100个shuffle map task,那么就要从100个文件中fetch,拉取,现在只需要从10个文件中fetch,拉取; map端的bucket缓存,也可以适当提高大小,这样,溢出到磁盘的次数就变少了; spark.shuffle.file.buffer:map task的写磁盘缓存,默认32k; 每次只能拉取指定缓存大小的数据量,拉取完聚合处理,然后再次拉取,这个缓存是每个reduce task都有自己的,如果内存够大的话,那么可以适当加大,

那么拉取的次数就变少了,spark.reducer.maxSizeInFlight:reduce task的拉取缓存,默认48m; 执行reduce task的executor中,有一部分内存用来汇聚各个reduce task 拉取的数据,放入map,进行聚合,spark.shuffle.memoryFraction:用于reduce端聚合的内存比例,

默认0.2,超过比例就会溢出到磁盘上; reduce task 拉取数据的时候,可能会遇到map task哪里的executor的jvm正在full gc,此时就会出现正常工作线程停止,那么可能等待一段时间后,full gc还没完成,

就导致文件没有拉取到,spark.shuffle.io.maxRetries:拉取失败的最大重试次数,默认3次; 很有可能,gc没有调优好,导致每次gc都1分钟,那么拉取的最大时间,默认是3 * 5 = 15s,就会导致频繁的很多文件拉取失败,就会给你报shuffle output file lost,

然后,DAGScheduler会重试task和stage,最后甚至可能导致Application挂掉,spark.shuffle.io.retryWait:拉取失败的重试间隔,默认5s;

3、调优参数总结

new SparkConf().set("spark.shuffle.consolidateFiles", "true")

spark.shuffle.consolidateFiles:是否开启shuffle block file的合并,默认为false

spark.reducer.maxSizeInFlight:reduce task的拉取缓存,默认48m

spark.shuffle.file.buffer:map task的写磁盘缓存,默认32k

spark.shuffle.io.maxRetries:拉取失败的最大重试次数,默认3次

spark.shuffle.io.retryWait:拉取失败的重试间隔,默认5s

spark.shuffle.memoryFraction:用于reduce端聚合的内存比例,默认0.2,超过比例就会溢出到磁盘上

33、shuffle性能优化的更多相关文章

- Spark记录-Spark性能优化(开发、资源、数据、shuffle)

开发调优篇 原则一:避免创建重复的RDD 通常来说,我们在开发一个Spark作业时,首先是基于某个数据源(比如Hive表或HDFS文件)创建一个初始的RDD:接着对这个RDD执行某个算子操作,然后得到 ...

- Spark性能优化(1)——序列化、内存、并行度、数据存储格式、Shuffle

序列化 背景: 在以下过程中,需要对数据进行序列化: shuffling data时需要通过网络传输数据 RDD序列化到磁盘时 性能优化点: Spark默认的序列化类型是Java序列化.Java序列化 ...

- Spark性能优化——和shuffle搏斗

Spark的性能分析和调优很有意思,今天再写一篇.主要话题是shuffle,当然也牵涉一些其他代码上的小把戏. 以前写过一篇文章,比较了几种不同场景的性能优化,包括portal的性能优化,web se ...

- Spark性能优化指南-高级篇(spark shuffle)

Spark性能优化指南-高级篇(spark shuffle) 非常好的讲解

- 《Spark大数据处理:技术、应用与性能优化 》

基本信息 作者: 高彦杰 丛书名:大数据技术丛书 出版社:机械工业出版社 ISBN:9787111483861 上架时间:2014-11-5 出版日期:2014 年11月 开本:16开 页码:255 ...

- 《Spark大数据处理:技术、应用与性能优化》【PDF】 下载

内容简介 <Spark大数据处理:技术.应用与性能优化>根据最新技术版本,系统.全面.详细讲解Spark的各项功能使用.原理机制.技术细节.应用方法.性能优化,以及BDAS生态系统的相关技 ...

- 《Spark大数据处理:技术、应用与性能优化》【PDF】

内容简介 <Spark大数据处理:技术.应用与性能优化>根据最新技术版本,系统.全面.详细讲解Spark的各项功能使用.原理机制.技术细节.应用方法.性能优化,以及BDAS生态系统的相关技 ...

- 【大数据】Spark性能优化和故障处理

第一章 Spark 性能调优 1.1 常规性能调优 1.1.1 常规性能调优一:最优资源配置 Spark性能调优的第一步,就是为任务分配更多的资源,在一定范围内,增加资源的分配与性能的提升是成正比的, ...

- spark 性能优化 数据倾斜 故障排除

版本:V2.0 第一章 Spark 性能调优 1.1 常规性能调优 1.1.1 常规性能调优一:最优资源配置 Spark性能调优的第一步,就是为任务分配更多的资源,在一定范围 ...

随机推荐

- 原子类 Atomic

@Testpublic void testAtomicBoolean() { AtomicBoolean atomicBoolean = new AtomicBoolean(); boolean b ...

- Oracle.EntityFrameworkCore使用时报错:ORA-00933:SQL命令未正确结束

如果你在使用 Oracle.EntityFrameworkCore 在执行一些分页查询或者其他数据操作时,遇到“ORA-00933:SQL命令未正确结束”, 请先检查你的DbContext中UseOr ...

- "超时时间已到。在操作完成之前超时"的解决思路

错误往往是数据库操作超时引起 1.检查数据库访问连接字符串启用连接池,若是,适当增大超时时间 2.ADO sqlcommand相应调整超时时长 3.关键在于优化数据库操作,优化压缩执行时间

- mybatis generator对于同一个表生成多次代码的问题

原文:https://blog.csdn.net/jiangjun0130/article/details/83055336 现象: mybatis generator是一个持久层代码自动生成工具,能 ...

- selenium用法详解以chrome为例

selenium 是一套完整的web应用程序测试系统,包含了测试的录制(selenium IDE),编写及运行(Selenium Remote Control)和测试的并行处理(Selenium Gr ...

- 【openshift】在Openshift上通过yaml部署应用

在Openshift上通过yaml部署应用 1.通过直接执行yaml 通过如下命令直接执行 oc create -f nginx.yml nginx.yml apiVersion: v1 items: ...

- The server quit without updating PID file

[root@fjgh ~]# service mysqld start Starting MySQL... ERROR! The server quit without updating PID fi ...

- 转 Python3 ssl模块不可用的问题

编译安装完Python3之后,使用pip来安装python库,发现了如下报错: $ pip install numpy pip is configured with locations tha ...

- Spring Boot 笔记 (1) - Maven、基本配置、Profile的使用

一. Spring Boot 简介 开箱即用的一站式 Java EE 解决方案 Spring 技术栈的大整合 核心问题 暂时无法回答 Spring Boot 和 SOA 有什么区别? Spring B ...

- Python_文件相关操作

1.open(filePath,type)方法:打开文件 filePath:文件路径 type:操作文件的方式(r:读取,w:覆盖写入,a:追加写入) 2.strip()方法:去除读取到的每行内容后的 ...