TensorFlow实战学习笔记(14)------VGGNet

一、VGGNet:5段卷积【每段有2~3个卷积层+最大池化层】【每段过滤器个数:64-128-256-512-512】

每段的2~3个卷积层串联在一起的作用:

2个3×3的卷积层串联的效果相当于一个5×5的卷积层,即一个像素会跟周围5×5的像素产生关联。【28*28的输入经过一次5*5得到24*24,s=1,p=0,(28-5)/1 + 1 = 24。而28*28经过2个3*3也可以得到24*24.】

3个3×3的卷积层串联的效果相当于一个7×7的卷积层,

- 好处一:3个3×3的卷积层串联拥有的餐数量比1个7×7的参数量少。只是后者的:(3×3×3)/ (7 × 7) = 55 %。

- 好处二:3个3×3的卷积层拥有比1个7×7的卷积层更多的线性变换(如,前者可以使用三次Relu函数,后者只有一次),使得CNN对特征的学习能力更强。

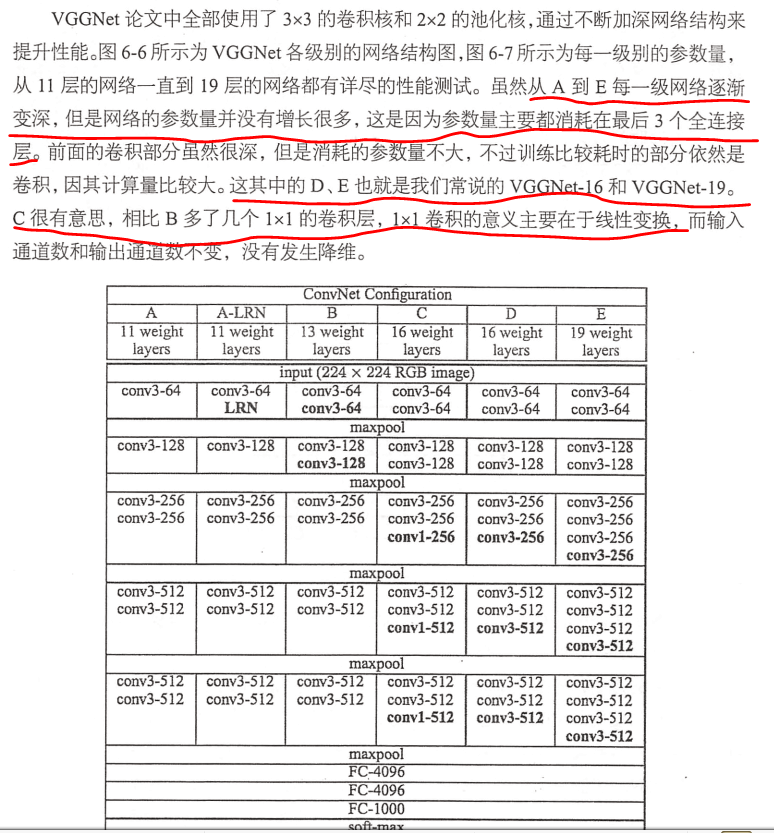

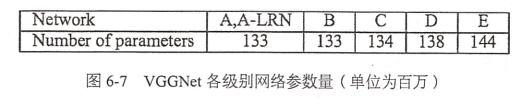

VGG探索了卷积神经网络的深度与其性能之间的关系,反复堆叠3×3的小型卷积核和2×2的最大池化层,构筑了16~19层深度的卷积神经网络。

二、VGG训练的技巧:

- 先训练级别A的简单网络,再复用A网络的权重来初始化后面的几个复杂模型,这样训练收敛的速度更快。

- 在预测时,VGG采用Multi-Scale的方法,将图像scale到一个尺寸Q,并将图片输入卷积网络计算。然后在最后一个卷积层使用滑窗的方式进行分类预测,将不同窗口的分类结果平均,再将不同尺寸Q的结果平均得到最后结果。提高数据利用率和预测准确率

- 采用了Multi-scale做数据增强,防止过拟合

三、代码:

#加载模块

from datetime import datetime

import math

import time

import tensorflow as tf #定义函数:卷积层、池化层、全连接层

#conv_op用来创建卷积层

def conv_op(input_op , name ,kh , kw , n_out, dh ,dw , p):

n_in = input_op.get_shape()[-1].value

with tf.name_scope(name) as scope:

w = tf.get_variable(scope+'w',shape = [kh,kw,n_in,n_out], dtype = tf.float32 ,

initializer=tf.contrib.layers.xavier_initializer_conv2d())

conv = tf.nn.conv2d(input_op,w,strides = [1,dh,dw,1],padding = 'SAME')

b = tf.Variable(tf.constant(0.0,shape = [n_out] , dtype = tf.float32),trainable = True , name = 'b')

z = tf.nn.bias_add(conv,b)

activation = tf.nn.relu(z,name = scope)

p+=[w,b]

return activation #用来创建全连接层

def fc_op(input_op,name,n_out,p):

n_in = input_op.get_shape()[-1].value

with tf.name_scope(name) as scope:

w = tf.get_variable(scope+'w',shape = [n_in,n_out],dtype = tf.float32,

initializer= tf.contrib.layers.xavier_initializer())

b = tf.Variable(tf.constant(0.1,shape = [n_out],dtype = tf.float32),name = 'b')

activation = tf.nn.relu_layer(input_op,w,b,name = scope)

p += [w,b]

return activation #用来创建池化层

def mpool_op(input_op,name,kh,kw,dh,dw):

return tf.nn.max_pool(input_op,ksize = [1,kh,kw,1],strides = [1,dh,dw,1],padding = 'SAME',name = name) #建立VGG模型

def inference_op(input_op,keep_prob): p=[] conv1_1=conv_op(input_op,name="conv1_1",kh=3,kw=3,n_out=64,dh=1,dw=1,p=p) conv1_2=conv_op(conv1_1,name="conv1_2",kh=3,kw=3,n_out=64,dh=1,dw=1,p=p) pool1=mpool_op(conv1_2,name="pool1",kh=2,kw=2,dw=2,dh=2) conv2_1=conv_op(pool1,name="conv2_1",kh=3,kw=3,n_out=128,dh=1,dw=1,p=p) conv2_2=conv_op(conv2_1,name="conv2_2",kh=3,kw=3,n_out=128,dh=1,dw=1,p=p) pool2=mpool_op(conv2_2,name="pool2",kh=2,kw=2,dw=2,dh=2) conv3_1=conv_op(pool2,name="conv3_1",kh=3,kw=3,n_out=256,dh=1,dw=1,p=p) conv3_2=conv_op(conv3_1,name="conv3_2",kh=3,kw=3,n_out=256,dh=1,dw=1,p=p) conv3_3=conv_op(conv3_2,name="conv3_3",kh=3,kw=3,n_out=256,dh=1,dw=1,p=p) pool3=mpool_op(conv3_3,name="pool3",kh=2,kw=2,dw=2,dh=2) conv4_1=conv_op(pool3,name="conv4_1",kh=3,kw=3,n_out=512,dh=1,dw=1,p=p) conv4_2=conv_op(conv4_1,name="conv4_2",kh=3,kw=3,n_out=512,dh=1,dw=1,p=p) conv4_3=conv_op(conv4_2,name="conv4_3",kh=3,kw=3,n_out=512,dh=1,dw=1,p=p) pool4=mpool_op(conv4_3,name="pool4",kh=2,kw=2,dw=2,dh=2) conv5_1=conv_op(pool4,name="conv5_1",kh=3,kw=3,n_out=512,dh=1,dw=1,p=p) conv5_2=conv_op(conv5_1,name="conv5_2",kh=3,kw=3,n_out=512,dh=1,dw=1,p=p) conv5_3=conv_op(conv5_2,name="conv5_3",kh=3,kw=3,n_out=512,dh=1,dw=1,p=p) pool5=mpool_op(conv5_3,name="pool5",kh=2,kw=2,dw=2,dh=2) shp=pool5.get_shape() flattened_shape=shp[1].value*shp[2].value*shp[3].value resh1=tf.reshape(pool5,[-1,flattened_shape],name="resh1") fc6=fc_op(resh1,name="fc6",n_out=4096,p=p) fc6_drop=tf.nn.dropout(fc6,keep_prob,name="fc6_drop") fc7=fc_op(fc6_drop,name="fc7",n_out=4096,p=p) fc7_drop=tf.nn.dropout(fc7,keep_prob,name="fc7_drop") fc8=fc_op(fc7_drop,name="fc8",n_out=1000,p=p) softmax=tf.nn.softmax(fc8) predictions=tf.argmax(softmax,1) return predictions,softmax,fc8,p #时间差

def time_tensorflow_run(session,target,feed,info_string): num_steps_burn_in=10 total_duration=0.0 total_duration_squared=0.0 for i in range(num_batches+num_steps_burn_in): start_time=time.time() _=session.run(target,feed_dict=feed) duration=time.time()-start_time if i>=num_steps_burn_in: if not i%10: print('%s:step %d,duration=%.3f' % (datetime.now(),i-num_steps_burn_in,duration)) total_duration+=duration total_duration_squared+=duration*duration mn=total_duration/num_batches vr=total_duration_squared/num_batches-mn*mn sd=math.sqrt(vr) print('%s:%s across %d steps,%.3f +/- %.3f sec / batch' % (datetime.now(),info_string,num_batches,mn,sd)) #预测

def run_benchmark(): with tf.Graph().as_default(): image_size=224 images=tf.Variable(tf.random_normal([batch_size,image_size,image_size,3],dtype=tf.float32,stddev=1e-1)) keep_prob=tf.placeholder(tf.float32) predictions,softmax,fc8,p=inference_op(images,keep_prob) init=tf.global_variables_initializer() sess=tf.Session() sess.run(init) time_tensorflow_run(sess,predictions,{keep_prob:1.0},"Forward") objective=tf.nn.l2_loss(fc8) grad=tf.gradients(objective,p) time_tensorflow_run(sess,grad,{keep_prob:0.5},"Forward-backward") #训练

batch_size=32 num_batches=100 run_benchmark()

TensorFlow实战学习笔记(14)------VGGNet的更多相关文章

- Ext.Net学习笔记14:Ext.Net GridPanel Grouping用法

Ext.Net学习笔记14:Ext.Net GridPanel Grouping用法 Ext.Net GridPanel可以进行Group操作,例如: 如何启用Grouping功能呢?只需要在Grid ...

- SQL反模式学习笔记14 关于Null值的使用

目标:辨别并使用Null值 反模式:将Null值作为普通的值,反之亦然 1.在表达式中使用Null: Null值与空字符串是不一样的,Null值参与任何的加.减.乘.除等其他运算,结果都是Null: ...

- golang学习笔记14 golang substring 截取字符串

golang学习笔记14 golang substring 截取字符串golang 没有java那样的substring函数,但支持直接根据 index 截取字符串mystr := "hel ...

- mybatis学习笔记(14)-查询缓存之中的一个级缓存

mybatis学习笔记(14)-查询缓存之中的一个级缓存 标签: mybatis mybatis学习笔记14-查询缓存之中的一个级缓存 查询缓存 一级缓存 一级缓存工作原理 一级缓存測试 一级缓存应用 ...

- Python3+Selenium3+webdriver学习笔记14(等待判断 鼠标事件 )

!/usr/bin/env python -*- coding:utf-8 -*-'''Selenium3+webdriver学习笔记14(等待判断 鼠标事件 )'''from selenium im ...

- 并发编程学习笔记(14)----ThreadPoolExecutor(线程池)的使用及原理

1. 概述 1.1 什么是线程池 与jdbc连接池类似,在创建线程池或销毁线程时,会消耗大量的系统资源,因此在java中提出了线程池的概念,预先创建好固定数量的线程,当有任务需要线程去执行时,不用再去 ...

- 【转】 C#学习笔记14——Trace、Debug和TraceSource的使用以及日志设计

[转] C#学习笔记14——Trace.Debug和TraceSource的使用以及日志设计 Trace.Debug和TraceSource的使用以及日志设计 .NET Framework 命名空 ...

- [C++学习笔记14]动态创建对象(定义静态方法实现在map查找具体类名对应的创建函数,并返回函数指针,map真是一个万能类)good

[C++学习笔记14]动态创建对象 C#/Java中的反射机制 动态获取类型信息(方法与属性) 动态创建对象 动态调用对象的方法 动态操作对象的属性 前提:需要给每个类添加元数据 动态创建对象 实 ...

- Redis in Action : Redis 实战学习笔记

1 1 1 Redis in Action : Redis 实战学习笔记 1 http://redis.io/ https://github.com/antirez/redis https://ww ...

随机推荐

- 格式化LInux后开机进入grub怎么办

问题:格式化Linux系统盘之后,重启进入grub 1.grub 引导进入windows系统 进入grub grub>rootnoverify (hd0,1) [可以使用Tab键( 比如 roo ...

- WebApplicationContext初始化(转)

ApplicationContext是Spring的核心,Context我们通常解释为上下文环境,我想用“容器”来表述它更容易理解一些,ApplicationContext则是“应用的容器”了:在We ...

- POJ 2029

二维树状数组可解此题 #include <iostream> #include <cstdio> #include <cstring> #include <a ...

- HDU 2912

直线关于球的多次反射,求最后一次反射点 #include <iostream> #include <cstdio> #include <cstring> #incl ...

- wpf Textbox 点击选中全部文本

用法:依赖属性 SelectTextOnFocus.Active = True public class SelectTextOnFocus : DependencyObject { public s ...

- 高可用技术工具包 High Availability Toolkit

HighAvailabilityToolkit High Availability Toolkit includes several solutions by which achieving arch ...

- linux下图片转换工具[【转】

本文转载自:https://linux.cn/article-8014-1.html 计算机术语中,批处理指的是用一个非交互式的程序来执行一序列的任务的方法.这篇教程里,我们会使用 Linux 命令行 ...

- bzoj5277: [Usaco2018 Open]Out of Sorts

被tkj大爷艹爆了5555整套模拟赛都是神仙思路题 那么这题题解 还有一个神仙做法,zory巨神在考场上找规律AC,自己都不会证..我证明了一下(然而这货还是不认可自己的做法) 按照分割点的思路,我们 ...

- 【撸码caffe 二】 blob.hpp

Blob类是caffe中对处理和传递的实际数据的封装,是caffe中基本的数据存储单元,包括前向传播中的图像数据,反向传播中的梯度数据以及网络层间的中间数据变量(包括权值,偏置等),训练模型的参数等等 ...

- angular2 使用swiper

欢迎加入前端交流群交流知识&&获取视频资料:749539640 第一步: npm install swiper --save 第二步:下载swiper ts支持(http://micr ...