李宏毅 Gradient Descent Demo 代码讲解

何为梯度下降,直白点就是,链式求导法则,不断更新变量值。

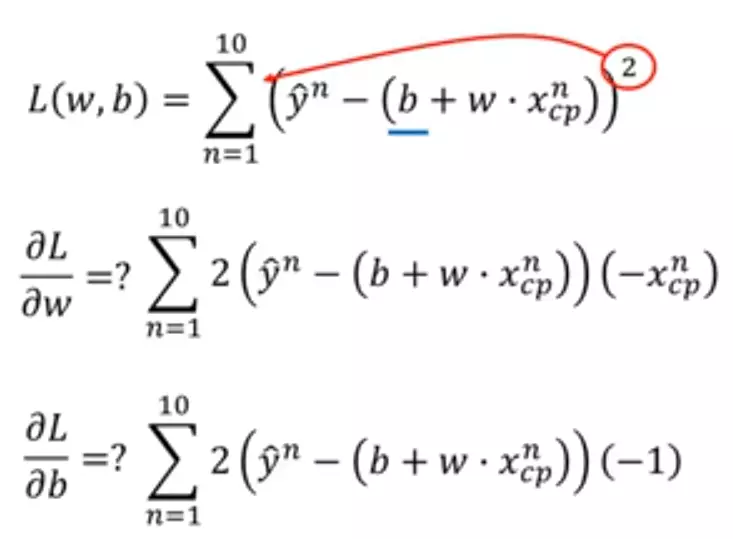

Loss函数

python代码如下

import numpy as np

import matplotlib.pyplot as plt # y_data = b + w * x_data

x_data = [338., 333., 328., 207., 226., 25., 179., 60., 208., 606.] # 10 个数

y_data = [640., 633., 619., 393., 428., 27., 193., 66., 226., 1591.] # 10 个数 x = np.arange(-200, -100, 1) # bias

y = np.arange(-5, 5, 0.1) # weight

z = np.zeros((len(x), len(y))) # zeros函数表示输出的数组为 100行 100列 #X, Y = np.meshgrid(x, y) 个人感觉这句话没用。。。 for i in range(len(x)):

for j in range(len(y)):

b = x[i]

w = y[j]

z[j][i] = 0

for n in range(len(x_data)):

# z[j][i]为 b=x[i] 及 w=y[j] 时,对应的 Loss Function 的大小

z[j][i] = z[j][i] + (y_data[n] - b - w * x_data[n]) ** 2

z[j][i] = z[j][i] / len(x_data) # 求 loss function 均值 # y_data = b + w * x_data

b = -120 # initial b

w = -4 # initial w

lr = 0.0000001 # learning rate

iteration = 100000 # 迭代运行次数 # store initial values for plotting

b_history = [b]

w_history = [w] # iterations

for i in range(iteration): # 在 100000 次迭代下,看最后结果

b_grad = 0.0 # 对 b_grad 重新赋值为0

w_grad = 0.0 # 对 w_grad 重新赋值为0

for n in range(len(x_data)):

# 此处应该注意的是,求导的是Loss函数,因此对应的变量是w、b,是看w、b在各自的轴上的移动

b_grad = b_grad + 2.0 * (y_data[n] - b - w * x_data[n]) * ( - 1.0)

w_grad = w_grad + 2.0 * (y_data[n] - b - w * x_data[n]) * ( - x_data[n]) # update parameters

b = b - lr * b_grad

w = w - lr * w_grad # store parameters for plotting

b_history.append(b)

w_history.append(w) # plot the figure

plt.contourf(x, y, z, 50, alpha = 0.5, cmap = plt.get_cmap('jet'))

plt.plot([-188.4], [2.67], 'x', ms = 12, markeredgewidth = 3, color = 'orange')

plt.plot(b_history, w_history, 'o-', ms = 3, lw = 1.5, color = 'black')

plt.xlim(-200, -100)

plt.ylim(-5, 5)

plt.xlabel(r'$b$', fontsize=16)

plt.ylabel(r'$w$', fontsize=16)

plt.show()

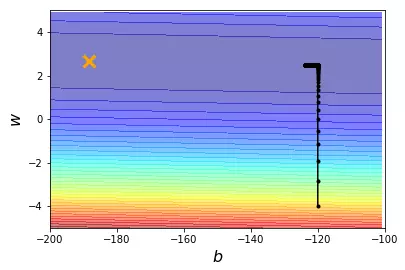

当learning rate 即 lr = 0.0000001时

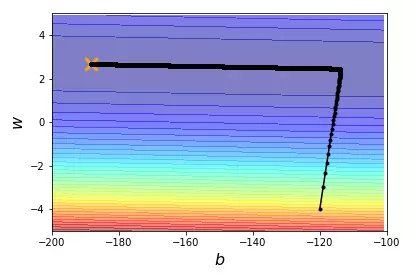

当learning rate 即 lr = 0.000001时

learning rate 即 lr = 0.00001时

可以看到效果不是很好 所以改变learning rate

import numpy as np

import matplotlib.pyplot as plt # y_data = b + w * x_data

x_data = [338., 333., 328., 207., 226., 25., 179., 60., 208., 606.] # 10 个数

y_data = [640., 633., 619., 393., 428., 27., 193., 66., 226., 1591.] # 10 个数 x = np.arange(-200, -100, 1) # bias

y = np.arange(-5, 5, 0.1) # weight

z = np.zeros((len(x), len(y))) # zeros函数表示输出的数组为 100 行 100 列 # X, Y = np.meshgrid(x, y) for i in range(len(x)):

for j in range(len(y)):

b = x[i]

w = y[j]

z[j][i] = 0

for n in range(len(x_data)):

# z[j][i]为 b=x[i] 及 w=y[j] 时,对应的 Loss Function 的大小

z[j][i] = z[j][i] + (y_data[n] - b - w * x_data[n]) ** 2

z[j][i] = z[j][i] / len(x_data) # 求 loss function 均值 # ydata = b + w * xdata

b = -120 # initial b

w = -4 # initial w

lr = 1 # learning rate

iteration = 100000 # 迭代运行次数 # store initial values for plotting

b_history = [b]

w_history = [w] # 个性化 w 和 b 的 learning rate

lr_b = 0

lr_w = 0 # iterations

for i in range(iteration): # 在 100000 次迭代下,看最后结果

b_grad = 0.0 # 对 b_grad 重新赋值为0

w_grad = 0.0 # 对 w_grad 重新赋值为0

for n in range(len(x_data)):

# 此处应该注意的是,求导的是L函数,因此对应的变量是w、b,是看w、b在各自的轴上的移动

b_grad = b_grad + 2.0 * (y_data[n] - b - w * x_data[n]) * (- 1.0)

w_grad = w_grad + 2.0 * (y_data[n] - b - w * x_data[n]) * (- x_data[n]) lr_b = lr_b + b_grad ** 2

lr_w = lr_w + w_grad ** 2 # update parameters

b = b - lr / np.sqrt(lr_b) * b_grad

w = w - lr / np.sqrt(lr_w) * w_grad # store parameters for plotting

b_history.append(b)

w_history.append(w) # plot the figure

plt.contourf(x, y, z, 50, alpha=0.5, cmap=plt.get_cmap('jet'))

plt.plot([-188.4], [2.67], 'x', ms=12, markeredgewidth=3, color='orange')

plt.plot(b_history, w_history, 'o-', ms=3, lw=1.5, color='black')

plt.xlim(-200, -100)

plt.ylim(-5, 5)

plt.xlabel(r'$b$', fontsize=16)

plt.ylabel(r'$w$', fontsize=16)

plt.show()

结果展示

一些说明:

np.array np.asarray的区别

array和asarry都可以将结构数据转换为ndarray类型

但是主要的区别在于当数据源是ndarray时,array仍会copy出一个副本,占用新的内存,但asarray不会。

np.meshgrid的作用

生成网格点坐标矩阵

李宏毅 Gradient Descent Demo 代码讲解的更多相关文章

- 几种梯度下降方法对比(Batch gradient descent、Mini-batch gradient descent 和 stochastic gradient descent)

https://blog.csdn.net/u012328159/article/details/80252012 我们在训练神经网络模型时,最常用的就是梯度下降,这篇博客主要介绍下几种梯度下降的变种 ...

- 李宏毅机器学习笔记2:Gradient Descent(附带详细的原理推导过程)

李宏毅老师的机器学习课程和吴恩达老师的机器学习课程都是都是ML和DL非常好的入门资料,在YouTube.网易云课堂.B站都能观看到相应的课程视频,接下来这一系列的博客我都将记录老师上课的笔记以及自己对 ...

- 李宏毅机器学习课程---4、Gradient Descent (如何优化 )

李宏毅机器学习课程---4.Gradient Descent (如何优化) 一.总结 一句话总结: 调整learning rates:Tuning your learning rates 随机Grad ...

- Logistic Regression Using Gradient Descent -- Binary Classification 代码实现

1. 原理 Cost function Theta 2. Python # -*- coding:utf8 -*- import numpy as np import matplotlib.pyplo ...

- Linear Regression Using Gradient Descent 代码实现

参考吴恩达<机器学习>, 进行 Octave, Python(Numpy), C++(Eigen) 的原理实现, 同时用 scikit-learn, TensorFlow, dlib 进行 ...

- 【笔记】机器学习 - 李宏毅 - 4 - Gradient Descent

梯度下降 Gradient Descent 梯度下降是一种迭代法(与最小二乘法不同),目标是解决最优化问题:\({\theta}^* = arg min_{\theta} L({\theta})\), ...

- 【论文翻译】An overiview of gradient descent optimization algorithms

这篇论文最早是一篇2016年1月16日发表在Sebastian Ruder的博客.本文主要工作是对这篇论文与李宏毅课程相关的核心部分进行翻译. 论文全文翻译: An overview of gradi ...

- 梯度下降算法实现原理(Gradient Descent)

概述 梯度下降法(Gradient Descent)是一个算法,但不是像多元线性回归那样是一个具体做回归任务的算法,而是一个非常通用的优化算法来帮助一些机器学习算法求解出最优解的,所谓的通用就是很 ...

- 梯度下降(Gradient Descent)小结

在求解机器学习算法的模型参数,即无约束优化问题时,梯度下降(Gradient Descent)是最常采用的方法之一,另一种常用的方法是最小二乘法.这里就对梯度下降法做一个完整的总结. 1. 梯度 在微 ...

随机推荐

- Lighting Techinology of the Last Of Us (2013 SIGGRAPH)

Lighting Techinology of the Last Of Us(2013 SIGGRAPH) or "Old Lightmaps - New Tricks" 原作:M ...

- Qt5 使用lambda

c11新特性中加入了lambda表达式,所以Qt 也支持 需在.pro文件中加入 CONFIG += c++11 m_timer = new QTimer(); m_timer->start() ...

- 2、docker安装:内核要求、docker三要素、安装、helloworld、底层原理

1.前提说明 1.CentOS Docker 安装 Docker支持以下的CentOS版本: CentOS 7 (64-bit) CentOS 6.5 (64-bit) 或更高的版本 2.前提条件:内 ...

- 【Android-布局复用】 多个界面复用一个布局文件(二)

多个界面复用一个布局界面 ,如何找到复用布局文件中的控件的id? 举个栗子: 1. layout_common.xml 复用的布局文件,如何找到button 的id? <?xml versio ...

- 创建一个新的laravel

//创建laravelcomposer create-project laravel/laravel shop 安装好 Laravel 之后的下一步是设置你的应用密钥为随机字符串.如果你通过 comp ...

- SQL Server的GO语句

https://www.cnblogs.com/cbattle/p/8784537.html go语句经常加在create.exec.drop等前面.

- luogu 3698 [CQOI2017]小Q的棋盘 树形dp

Code: #include <bits/stdc++.h> #define N 107 #define setIO(s) freopen(s".in","r ...

- 洛谷 P2832 行路难

题面 这个最短路有点special,会有疲劳度的加成效应,这个时候应该怎么办呢? 难就难在,如果走一条路比另一条路长,但是用的边少,那么这条路并不一定就更差. 我们要是能解决这个问题,就可以做出本题. ...

- plotly绘图

import plotly.plotly as plt import plotly.offline as pltoff from plotly.graph_objs import * # 生成折线图 ...

- vue-element-admin登录逻辑,以及动态添加路由,显示侧边栏

这段时间在研究element-admin,感觉这个库有许多值得学习的地方,我学习这个库的方法是,先看它的路由,顺着路由,摸清它的逻辑,有点像顺藤摸瓜. 这个库分的模块非常清晰,适合多人合作开发项目,但 ...