【爬虫案例】用Python爬大麦网任意城市的近期演出活动!

一、爬取目标

大家好,我是@马哥python说 ,一枚10年程序猿。

今天分享一期python爬虫案例,爬取目标是大麦网近期演出活动:- 大麦搜索

二、展示爬取结果

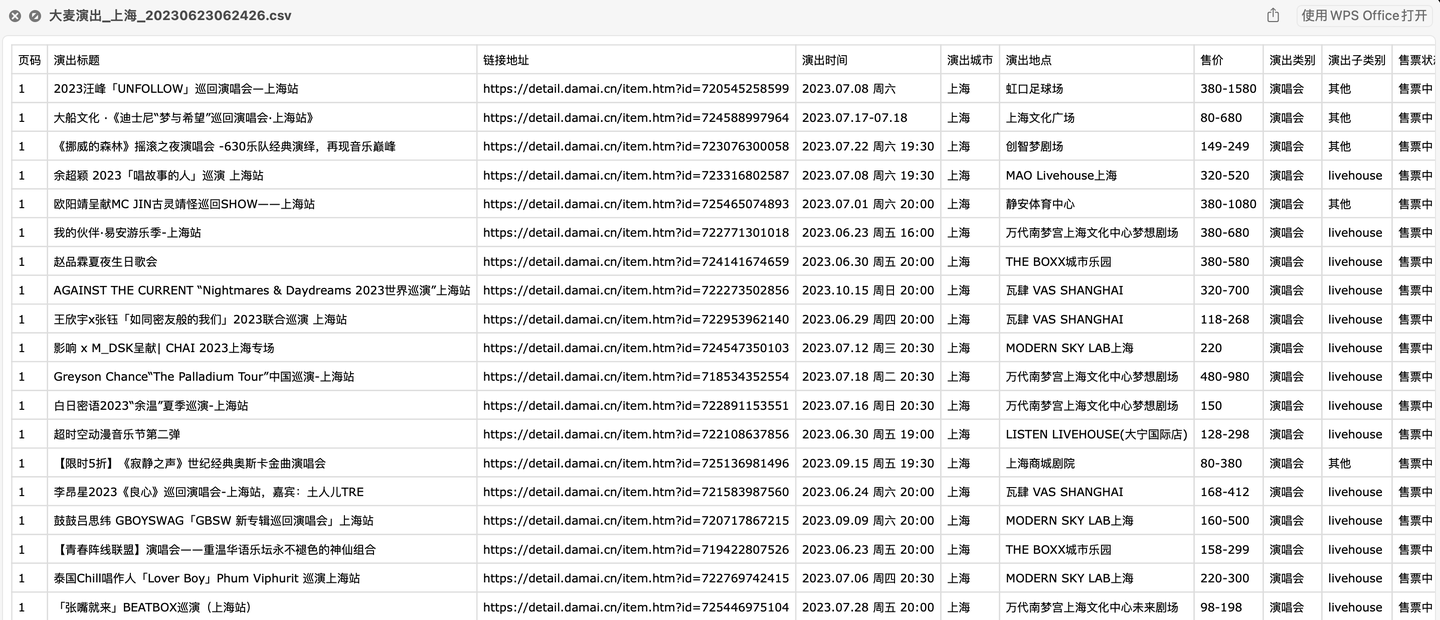

爬取结果截图:

含10个字段:

页码,演出标题,链接地址,演出时间,演出城市,演出地点,售价,演出类别,演出子类别,售票状态。

演示视频:【Python爬虫演示】爬取大麦网任意城市的近期演出!

以上。

三、讲解代码

首先,导入需要用到的库:

import pandas as pd

import requests

import os

import datetime

from time import sleep

import random

定义一个请求头:

# 设置请求头信息

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36 Edge/16.16299',

'Cookie': '换成自己的cookie',

'X-Xsrf-Token': '7d065ac9-b924-4c14-869a-ab599b571244',

'Accept': 'application/json, text/plain, */*',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'en-US,en;q=0.9,zh;q=0.8,zh-CN;q=0.7',

'Bx-V': '2.5.0',

'Referer': 'https://search.damai.cn/search.htm?spm=a2oeg.home.category.ditem_0.591b23e1HxE6Vj&ctl=%E6%BC%94%E5%94%B1%E4%BC%9A&order=1&cty=%E6%88%90%E9%83%BD',

'Sec-Ch-Ua': '"Not.A/Brand";v="8", "Chromium";v="114", "Google Chrome";v="114"',

'Sec-Ch-Ua-Mobile': '?0',

'Sec-Ch-Ua-Platform': "macOS",

'Sec-Fetch-Dest': 'empty',

'Sec-Fetch-Mode': 'cors',

'Sec-Fetch-Site': 'same-origin',

}

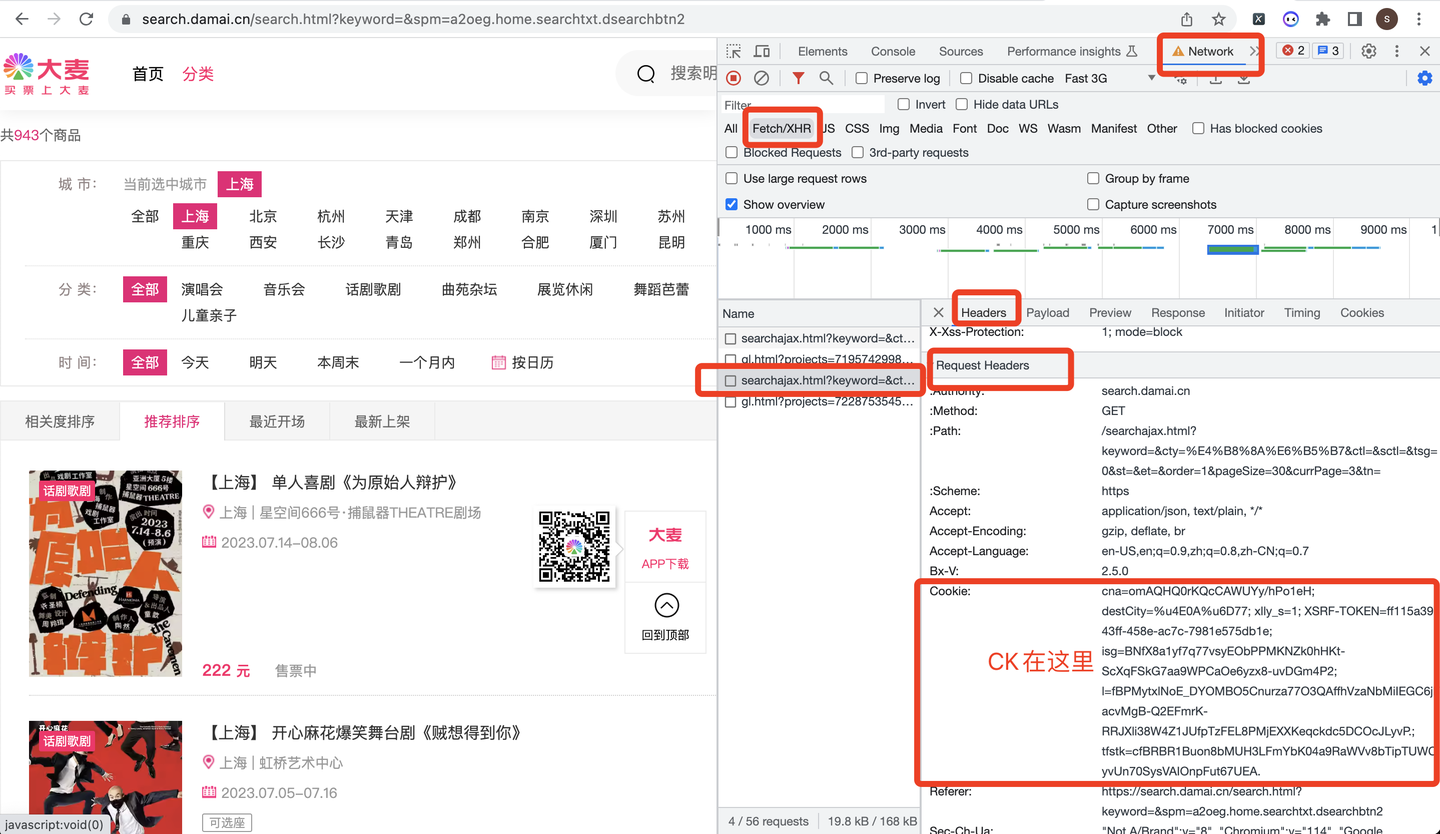

其中,cookie的获取方式如下:

定义请求地址url:

# 请求地址

url = 'https://search.damai.cn/searchajax.html'

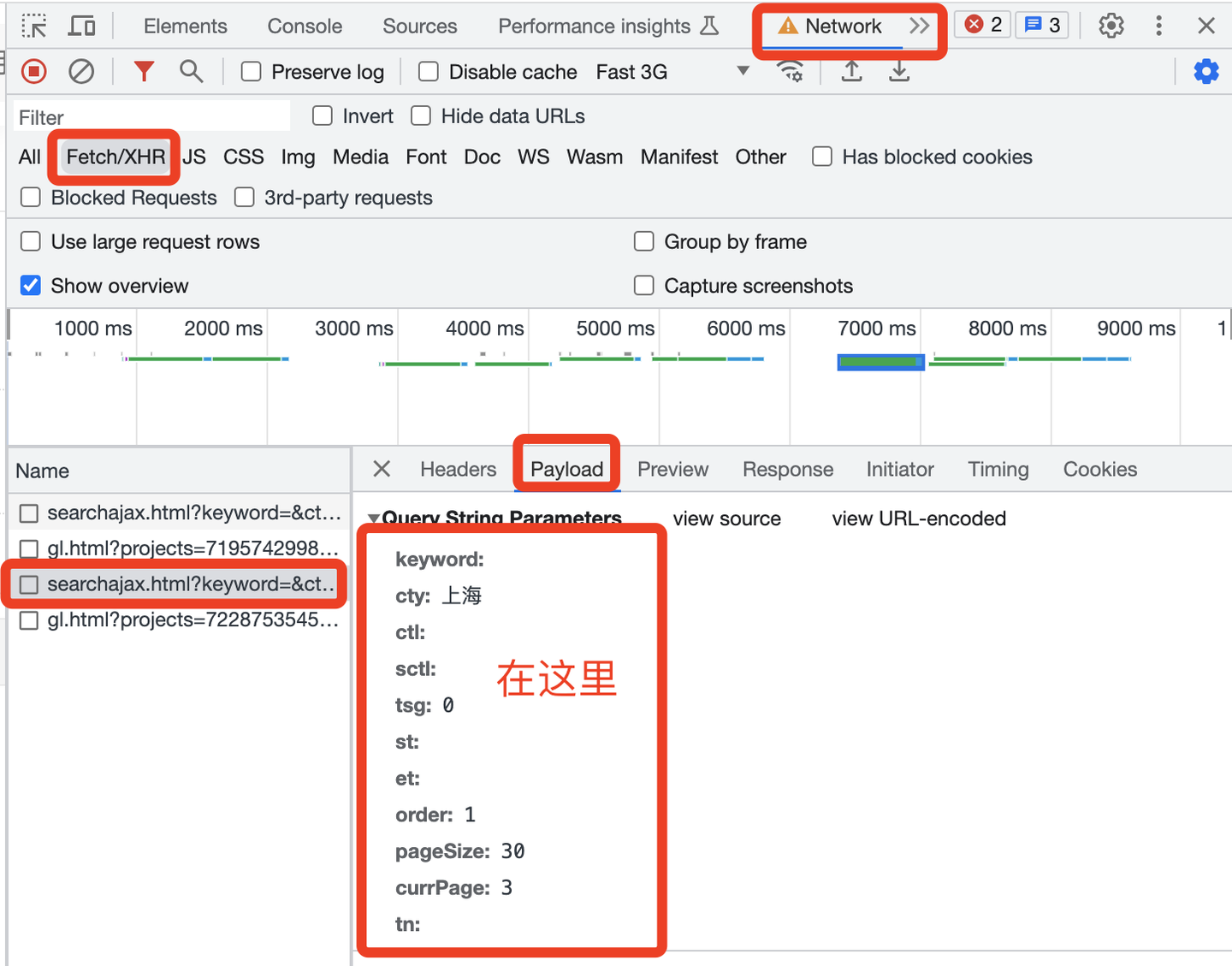

定义请求参数params,从PayLoad中获取:

发送请求,并且用json格式解析数据:

# 发送请求

r = requests.get(url, headers=headers, params=params)

# 解析数据

json_data = r.json()

以"演出标题"字段为例:

for data in json_data['pageData']['resultData']:

# 演出标题

title = data['nameNoHtml']

title_list.append(title)

print('演出标题:', title)

其他字段同理,不再赘述。

最后是保存到csv文件:

df = pd.DataFrame(

{

'页码': page,

'演出标题': title_list,

'链接地址': href_list,

'演出时间': time_list,

'演出城市': city_list,

'演出地点': loc_list,

'售价': price_list,

'演出类别': category_list,

'演出子类别': subcategory_list,

'售票状态': status_list,

}

)

# 保存到csv文件

df.to_csv(result_file, encoding='utf_8_sig', mode='a+', index=False, header=header)

其中,encoding参数设置为utf_8_sig,目的是防止csv文件产生乱码,不便读取。

整个代码中,还含有:设置sleep随机等待、判断循环停止条件、防止多次写入表头、用户input输入过滤条件、往csv文件名添加时间戳等功能,篇幅有限,详细请见原始代码。

四、同步视频

代码演示视频:

【Python爬虫演示】爬取大麦网任意城市的近期演出!

五、附完整源码

完整源码获取:【爬虫案例】用Python爬大麦网任意城市演出活动

我是@马哥python说 ,持续分享python源码干货中!

【爬虫案例】用Python爬大麦网任意城市的近期演出活动!的更多相关文章

- 我不就是吃点肉,应该没事吧——爬取一座城市里的烤肉店数据(附完整Python爬虫代码)

写在前面的一点屁话: 对于肉食主义者,吃肉简直幸福感爆棚!特别是烤肉,看着一块块肉慢慢变熟,听着烤盘上"滋滋"的声响,这种期待感是任何其他食物都无法带来的.如果说甜点是" ...

- 在我的新书里,尝试着用股票案例讲述Python爬虫大数据可视化等知识

我的新书,<基于股票大数据分析的Python入门实战>,预计将于2019年底在清华出版社出版. 如果大家对大数据分析有兴趣,又想学习Python,这本书是一本不错的选择.从知识体系上来看, ...

- 【Python爬虫案例】用Python爬取李子柒B站视频数据

一.视频数据结果 今天是2021.12.7号,前几天用python爬取了李子柒的油管评论并做了数据分析,可移步至: https://www.cnblogs.com/mashukui/p/1622025 ...

- Python爬虫实战二之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 前言 亲爱的们,教程比较旧了,百度贴吧页面可能改版,可能代码不 ...

- 转 Python爬虫实战二之爬取百度贴吧帖子

静觅 » Python爬虫实战二之爬取百度贴吧帖子 大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 ...

- 转 Python爬虫实战一之爬取糗事百科段子

静觅 » Python爬虫实战一之爬取糗事百科段子 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致 ...

- python 网络爬虫(一)爬取天涯论坛评论

我是一个大二的学生,也是刚接触python,接触了爬虫感觉爬虫很有趣就爬了爬天涯论坛,中途碰到了很多问题,就想把这些问题分享出来, 都是些简单的问题,希望大佬们以宽容的眼光来看一个小菜鸟

- python爬虫+词云图,爬取网易云音乐评论

又到了清明时节,用python爬取了网易云音乐<清明雨上>的评论,统计词频和绘制词云图,记录过程中遇到一些问题 爬取网易云音乐的评论 一开始是按照常规思路,分析网页ajax的传参情况.看到 ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- Python 简单爬虫案例

Python 简单爬虫案例 import requests url = "https://www.sogou.com/web" # 封装参数 wd = input('enter a ...

随机推荐

- .NET开源免费、功能强大的 Windows 截图录屏神器

前言 今天大姚给大家分享一款.NET开源免费(基于GPL3.0开源协议).功能强大.简洁灵活的 Windows 截图.录屏.Gif动图制作神器:ShareX. 功能特性 ShareX 是一个开源的屏幕 ...

- KingbaseESV8R6中查看索引常用sql

前言 KingbaseES具有丰富的索引功能,对于运行一段时间的数据库,经常需要查看索引的使用大小,使用状态等. 尤其重复索引的存在,有时会因为索引过多而造成维护成本加大和减慢数据库的运行速度. 下面 ...

- CVS Excell乱码怎么修改

问题描述 日常办公,从网页或者其他web端下载的表格(excel格式或csv格式),打开后发现中文乱码,如下: 常规解法 百度会发现,大部分提供的方法,就是通过excel的另存为,然后选择相应的编码, ...

- #线段树,矩阵乘法#洛谷 7453 [THUSCH2017] 大魔法师

题目 分析 首先考虑如果修改操作都是单点修改怎么做, 以第一种修改为例那么就是 \[\left[\begin{matrix}A\\B\\C\\1\end{matrix}\right] \times \ ...

- #高精度,卡特兰数#洛谷 2532 [AHOI2012]树屋阶梯

题目 分析 设\(dp[n]\)表示大小为\(n\)的树屋阶梯方案数,如何不算重也不算漏 考虑在左下角填充一个尽量大的矩形,一共有\(n\)种方法, 然后剩下的两头就可以用前面的结果表示 也就是\(d ...

- #启发式合并,链表#洛谷 3201 [HNOI2009] 梦幻布丁

题目 \(n\)个布丁摆成一行,进行\(m\)次操作. 每次将某个颜色的布丁全部变成另一种颜色的, 然后再询问当前一共有多少段颜色. (\(n,m\leq 10^5,col\leq 10^6\)) 分 ...

- SQL 查询优化指南:SELECT、SELECT DISTINCT、WHERE 和 ORDER BY 详解

SELECT 关键字 SQL的SELECT语句用于从数据库中选择数据.SELECT语句的基本语法如下: SELECT column1, column2, ... FROM table_name; 其中 ...

- Python 条件和 if 语句

Python支持来自数学的通常逻辑条件: 等于:a == b 不等于:a != b 小于:a < b 小于或等于:a <= b 大于:a > b 大于或等于:a >= b 这些 ...

- openGauss每日一练第三天

openGauss 每日一练第三天 本文出处:https://www.modb.pro/db/193083 学习目标 学习 openGauss 创建数据库.修改数据库属性和删除数据库 课后作业 1.分 ...

- Bash与shell的区别

Bash 与 shell 的区别 介绍 常见的 shell 解释器有 sh.bash 这两种,其他的 ksh.csh 和 zsh 等是不常见的.Mac OS 中默认安装了以上所有类型,Windows ...