Python 爬虫-Robots协议

2017-07-25 21:08:16

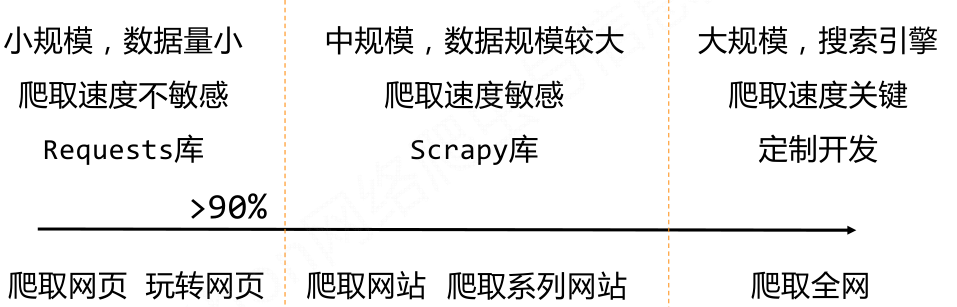

一、网络爬虫的规模

二、网络爬虫的限制

• 来源审查:判断User‐Agent进行限制

检查来访HTTP协议头的User‐Agent域,只响应浏览器或友好爬虫的访问

• 发布公告:Robots协议

告知所有爬虫网站的爬取策略,要求爬虫遵守

三、Robots 协议

作用:网站告知网络爬虫哪些页面可以抓取,哪些不行

形式:在网站根目录下的robots.txt文件

如果网站不提供Robots协议则表示该网站允许任意爬虫爬取任意次数。

类人类行为原则上可以不遵守Robots协议

https://www.baidu.com/robots.txt

http://news.sina.com.cn/robots.txt

举例:

https://www.jd.com/robots.txt User‐agent: *

Disallow: /?*

Disallow: /pop/*.html

Disallow: /pinpai/*.html?*

User‐agent: EtaoSpider

Disallow: /

User‐agent: HuihuiSpider

Disallow: /

User‐agent: GwdangSpider

Disallow: /

User‐agent: WochachaSpider

Disallow: / # 注释,*代表所有,/代表根目录

User‐agent: *

Disallow: /

Python 爬虫-Robots协议的更多相关文章

- 网络爬虫 robots协议 robots.txt

网络爬虫 网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成.传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上 ...

- 从零起步 系统入门Python爬虫工程师✍✍✍

从零起步 系统入门Python爬虫工程师 爬虫(又被称为网页蜘蛛,网络机器人)就是模拟客户端发送网络请求,接收请求响应,一种按照一定的规则,自动地抓取互联网信息的程序. 原则上,只要是浏览器(客户端) ...

- [python爬虫]Requests-BeautifulSoup-Re库方案--robots协议与Requests库实战

[根据北京理工大学嵩天老师“Python网络爬虫与信息提取”慕课课程编写 慕课链接:https://www.icourse163.org/learn/BIT-1001870001?tid=100223 ...

- 2.爬虫 urlib库讲解 异常处理、URL解析、分析Robots协议

1.异常处理 URLError类来自urllib库的error模块,它继承自OSError类,是error异常模块的基类,由request模块产生的异常都可以通过这个类来处理. from urllib ...

- [Python3网络爬虫开发实战] 3.1.4-分析Robots协议

利用urllib的robotparser模块,我们可以实现网站Robots协议的分析.本节中,我们来简单了解一下该模块的用法. 1. Robots协议 Robots协议也称作爬虫协议.机器人协议,它的 ...

- python3 爬虫5--分析Robots协议

1Robots协议 Robots协议告诉了搜索引擎和爬虫那些页面可以抓取,那些不可以,通常是存放在robots.txt文件里面,位于网站的根目录下 robots.txt中内容的示范: User-age ...

- Robots协议(爬虫协议、机器人协议)

Robots协议(也称为爬虫协议.机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓 ...

- 爬虫基础 - Robots协议

Robots协议 指定一个robots.txt文件,告诉爬虫引擎怎么爬取 https://www.taobao.com/robots.txt User-agent: Baiduspider Allow ...

- 爬虫的盗亦有道Robots协议

爬虫的规定 Robots协议 网站开发者对于网络爬虫的规范的公告,你可以不遵守可能存在法律风险,但尽量去遵守 Robots协议:在网页的根目录+robots.txt Robots协议的基本语法: #注 ...

随机推荐

- mysql普通查询日志

- Python: re.compile()

compile(pattern,flags=0) 1.编译一个正则表达式模式,返回一个模式对象 2.第二个参数flags是匹配模式,可以使用按位或‘|'表示同时生效,也可以在正则表达式字符串中指定 P ...

- Python: 字符串开头或结尾匹配str.startswith(),str.endswith()

问题 需要通过指定的文本模式去检查字符串的开头或者结尾,比如文件名后缀,URLScheme 等等. 解决方案 1.检查字符串开头或结尾的一个简单方法是使用str.startswith() 或者是str ...

- python管道pipe,两个进程,使用管道的两端分别执行写文件动作,带锁(lock)

#coding=utf-8import multiprocessing as mp def write_file(content,lock): lock.acquire() with op ...

- python网络编程之一

套接字的详细介绍会在另一篇博文指出,此片博文主要是python套接字的简单客户端编写. 两种套接字介绍: 面向连接的套接字:面向连接的套接字提供序列化,可靠的和不重复的数据交付.面向连接是可靠的传输, ...

- Shell学习笔记之shell脚本和python脚本实现批量ping IP测试

0x00 将IP列表放到txt文件内 先建一个存放ip列表的txt文件: [root@yysslopenvpn01 ~]# cat hostip.txt 192.168.130.1 192.168.1 ...

- Kali配置网络

虚拟机NAT网关:192.168.50.1 主机VM8网址:192.168.50.2 虚拟机网卡:192.168.50.30 vim /etc/network/interfaces # The loo ...

- tf.truncated_normal的用法

tf.truncated_normal(shape, mean, stddev) :shape表示生成张量的维度,mean是均值,stddev是标准差.这个函数产生正太分布,均值和标准差自己设定.这是 ...

- libcurl HTTP POST请求向服务器发送json数据

转载:http://blog.csdn.net/dgyanyong/article/details/14166217 转载:http://blog.csdn.net/th_gsb/article/de ...

- C++ 一串数字三位一节,用逗号隔开表示

#include <iostream> #include <string> #include <sstream> using namespace std; stri ...