Hive改表结构的两个坑|避坑指南

Hive在大数据中可能是数据工程师使用的最多的组件,常见的数据仓库一般都是基于Hive搭建的,在使用Hive时候,遇到了两个奇怪的现象,今天给大家聊一下,以后遇到此类问题知道如何避坑!

坑一:改变字段类型后更新数据不成功

关于hive插入数据的一个小坑,今天插入一个表中数据,插入时写的是常数,比如0.01 ,表中的字段也是DECIMAL(5,2),按照常理插入的应该是0.01,但是插入后查询是0,为甚!

遇到问题,咱也不能退缩!就分析呀,看语句没问题啊!还是上网查查有没有坑友。查了一圈发现还是观望最靠谱!上hive官网查,呀~ 发现了原因!

https://cwiki.apache.org/confluence/display/Hive/LanguageManual+Types#LanguageManualTypes-Decimals

根据官网描述,发现在插入分区表时会出现这种情况,此时需要对之前的分区处理下~:

那就测试一下 按照官网的说法:

先建表:

CREATE TABLE `tb_dw_test`(

`a` int COMMENT '微信服务量')

PARTITIONED BY (

`statis_date` varchar(8))

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '|' ;

然后插入数据:

insert overwrite table tb_dw_test partition (statis_date=20160501) values(1.02);然后查询:

hive> select * from tb_dw_test;

OK

1 20160501

发现结果跟想象中的一样~

然后修改表字段:

ALTER TABLE tb_dw_test REPLACE COLUMNS (a DECIMAL(5,2))然后再次插入数据:

insert overwrite table tb_dw_test partition (statis_date=20160501) values(1.02);查询:

hive> select * from tb_dw_test;

OK

1 20160501

发现有问题啦!

那么按照官网处理:

Determine what precision/scale you would like to set for the decimal column in the table. For each decimal column in the table, update the column definition to the desired precision/scale using the ALTER TABLE command:

ALTER TABLE foo CHANGE COLUMN dec_column_name dec_column_name DECIMAL(38,18);If the table is a partitioned table, then find the list of partitions for the table:If the table is not a partitioned table, then you are done. If the table has partitions, then go on to step 3

SHOW PARTITIONS foo;

ds=2008-04-08/hr=11

ds=2008-04-08/hr=12

...

This can be done with a single ALTER TABLE CHANGE COLUMN by using dynamic partitioning (available for ALTER TABLE CHANGE COLUMN in Hive 0.14 or later, with HIVE-8411):Each existing partition in the table must also have its DECIMAL column changed to add the desired precision/scale.

SET hive.exec.dynamic.partition = true;-- hive.exec.dynamic.partition needs to be set to true to enable dynamic partitioning with ALTER PARTITION-- This will alter all existing partitions of the table - be sure you know what you are doing!ALTER TABLE foo PARTITION (ds, hr) CHANGE COLUMN dec_column_name dec_column_name DECIMAL(38,18);

所以参照官网,这里对表作如下处理:

ALTER TABLE tb_dw_test PARTITION (statis_date) CHANGE COLUMN a a DECIMAL(5,2);再次插入数据:

insert overwrite table tb_dw_test partition (statis_date=20160501) values(1.02);然后查询:

hive> select * from tb_dw_test;

OK

1.02 20160501

Time taken: 0.066 seconds, Fetched: 1 row(s)

发现结果跟想象中的一样了。这个坑算是过去了~

坑二:增加字段后更新数据不成功

还是上面的例子那张表,再增加一个字段:

alter table tb_dw_test add COLUMNS (b varchar(5))然后查询

hive> select * from tb_dw_test;

OK

1.02 NULL 20160501

Time taken: 0.082 seconds, Fetched: 1 row(s)

发现新增的字段默认的值是NULL,现在我重新覆盖一下元数据,给增加的字段一个值:

insert overwrite table tb_dw_test partition(statis_date=20160501) values (2.01,0371);然后查询:

hive> select * from tb_dw_test;

OK

2.01 NULL 20160501

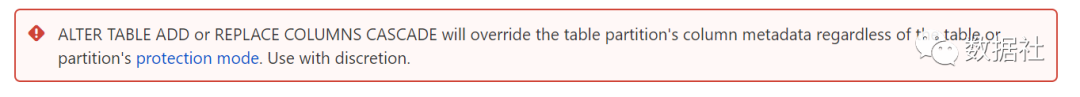

不是我们想象的结果,查看一下官方文档说明发现了问题的所在:https://cwiki.apache.org/confluence/display/Hive/LanguageManual+DDL#LanguageManualDDL-Add/ReplaceColumns

靠谱的官网用红色框框提示我们!那就这样处理:

alter table tb_dw_test replace COLUMNS (a decimal(5,2),b varchar(5)) CASCADE;直接查询,发现数据显示的数据已经发生了变化了~

hive> select * from tb_dw_etst;

OK

2.01 0371 20160501

避坑指南

综上发现,我们是按照Oracle这样的标准在考虑HiveSQL,但是通过阅读官方文档发现二者之间还是有很大不同的,底层原理差别还是有点大!通过这两次踩坑发现,仔细阅读官方文档的重要性!!!

所以,以后大家遇到大数据开源组件的报错问题,第一就是去找官方文档,然后就去找社区,总能发现惊喜!

Hive改表结构的两个坑|避坑指南的更多相关文章

- mysql大数据表改表结构方案

有一个表有上千W数据, 用什么方法给这个表加一个字段最快?1. alert2. 建一个表和第一个表一样,只是多了要加的字段,然后用多个INSERT INTO SELECT语句limit写入3. 就是导 ...

- MySQL和hive对比表结构脚本

#!/bin/bash source /etc/profile runlog='/tmp/zewei/check_schema_log' hive_database_schema=/tmp/hive_ ...

- 读取hive的表结构,生成带comment的视图建表语句

### 读取hive的表结构,生成带comment的视图建表语句 # 读取配置文件中的表并进行遍历 grep -v '^#' tablesFile|while read tableName do st ...

- mysql在线改表结构 pt-online-schema-change

https://www.percona.com/doc/percona-toolkit/2.1/pt-online-schema-change.html 不锁表更改数据库表结构 pt-online-s ...

- hive 查看表结构和属性

1.查看数据库/表 show databases/tables; 2.切换数据库 use database_name; 3.查看表结构 desc table_name; 4.查看表详细属性 desc ...

- HBase-修改表结构

HBase修改表结构 package com.hbase.HBaseAdmin; import java.io.IOException; import org.apache.hadoop.conf.C ...

- 007-Hadoop Hive sql语法详解2-修改表结构

一.表 更改表名:ALTER TABLE table_name RENAME TO new_table_name 增加表的元数据信息:ALTER TABLE table_name SET TBLPRO ...

- Hive 修改表结构常用操作

添加列 add columns alter table table_name add columns (id int comment '主键ID' ) ; 默认在表所有字段之后,分区字段之前. 替换 ...

- Hive metastore表结构设计分析

今天总结下,Hive metastore的结构设计.什么是metadata呢,对于它的描述,可以理解为数据的数据,主要是描述数据的属性的信息.它是用来支持如存储位置.历史数据.资源查找.文件记录等功能 ...

随机推荐

- Galera Cluster for MySQL 集群恢复

node1: 1.rm -rf grastate.dat 2.mysqld_safe --wsrep-recover 3.galera_new_cluster node2: systemctl res ...

- python 多个装饰器的调用顺序分析

一般情况下,在函数中可以使用一个装饰器,但是有时也会有两个或两个以上的装饰器.多个装饰器装饰的顺序是从里到外(就近原则),而调用的顺序是从外到里(就远原则) 样例: def func1(func): ...

- Inherent Adversarial Robustness of Deep Spiking Neural Networks: Effects of Discrete Input Encoding and Non-Linear Activations

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布! arXiv:2003.10399v2 [cs.CV] 23 Jul 2020 ECCV 2020 1 https://github.com ...

- CF1256A Payment Without Change 题解

OI生涯打的第一场CF比赛,写篇题解纪念一下吧 ------------可以想到先尽量用面值为1的硬币来凑,然后再用面值为n的硬币来补足.先算出用上所有面值为1的硬币还差多少钱,然后判断用面值为n的硬 ...

- nginx配置过程中出现的问题

在安装nginx时我们先创建用户useradd -s /sbin/nologin -M nginx 不然会报nginx: [emerg] getpwnam("nginx") fai ...

- Python 30道高频面试题及详细解答

开学啦,开学啦!周末坐地铁的时候看到很多同学推着行李箱,拎着大包小包的穿梭在人群中,哎新的一学期又开始啦,同时也意味着很多同学要准备毕业啦,尤其是准大四,准研三的同学. 今年的招聘行情并不乐观,小公司 ...

- Android(java)开发之将double类型,强制保留到小数点后两位解决方法。

作者:程序员小冰,CSDN博客:http://blog.csdn.net/qq_21376985 前提:当我们进行double数据类型与double进行运算的时候,可能会遇到 得到小数点后好多位,但是 ...

- C#显示百度地图API

http://dev.baidu.com/wiki/static/map/API/examples/?v=1.3&2_0#2&0 太原市的经纬度:112.596, 37.884 北京市 ...

- ffmpeg 编译Android

环境 macOS 10.15.4 NDK 21.3.6528147 ffmpeg 4.2.3 1.执行sudo xcodebuild -license,防止编译的时候找不到一些文件报错 2. ...

- [MRCTF]Web WriteUp

和武科大WUSTCTF同时打的一场比赛,最后因为精力放在武科大比赛上了,排名13 - -Web题目难度跨度过大,分不清层次,感觉Web题目分布不是很好,质量还是不错的 Ez_bypass 进入题目得 ...