用MR生成HFile文件格式后,数据批量导入HBase

环境hadoop cdh5.4.7 hbase1.0.0

测试数据:

topsid uid roler_num typ

10 111111 255 0

在Hbase 创建t2数据库: create 't2','info'。创建数据库t2, columnFamily:info

import java.io.IOException;

import java.net.URI;

import java.text.SimpleDateFormat;

import java.util.Date;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.hbase.KeyValue;

import org.apache.hadoop.hbase.client.HTable;

import org.apache.hadoop.hbase.io.ImmutableBytesWritable;

import org.apache.hadoop.hbase.mapreduce.HFileOutputFormat2;

import org.apache.hadoop.hbase.util.Bytes;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.input.TextInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class HFileCreate { static class HFileImportMapper2 extends

Mapper<LongWritable, Text, ImmutableBytesWritable, KeyValue> {

protected SimpleDateFormat sdf = new SimpleDateFormat("yyyyMMdd");

protected final String CF_KQ = "info";

protected final int ONE = 1; @Override

protected void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

String line = value.toString();

System.out.println("line : " + line);

String[] datas = line.split("\\s+");

// row格式为:yyyyMMdd-sid-uid-role_num-timestamp-typ

String row =

datas[0] + "-" + datas[1] + "-" + datas[2] + "-"

+ "-" + datas[3];

ImmutableBytesWritable rowkey = new ImmutableBytesWritable(

Bytes.toBytes(row));

KeyValue kv = new KeyValue(Bytes.toBytes(row),

this.CF_KQ.getBytes(), datas[3].getBytes(),

Bytes.toBytes(this.ONE));

context.write(rowkey, kv);

}

} public static void main(String[] args) {

Configuration conf = new Configuration();

conf.addResource("hbase-site.xml");

String tableName = "t2";

String input = "hdfs://node11:9000/datas/t3";

String output = "hdfs://node11:9000/datas/out12";

System.out.println("table : " + tableName);

HTable table;

try {

// 运行前,删除已存在的中间输出目录

try {

FileSystem fs = FileSystem.get(URI.create(output), conf);

fs.delete(new Path(output), true);

fs.close();

} catch (IOException e1) {

e1.printStackTrace();

} table = new HTable(conf, tableName.getBytes());

Job job = new Job(conf);

job.setJobName("Generate HFile"); job.setJarByClass(HFileCreate.class);

job.setInputFormatClass(TextInputFormat.class);

job.setMapperClass(HFileImportMapper2.class);

FileInputFormat.setInputPaths(job, input); job.getConfiguration().set("mapred.mapoutput.key.class",

"org.apache.hadoop.hbase.io.ImmutableBytesWritable");

job.getConfiguration().set("mapred.mapoutput.value.class",

"org.apache.hadoop.hbase.KeyValue"); FileOutputFormat.setOutputPath(job, new Path(output)); HFileOutputFormat2.configureIncrementalLoad(job, table);

try {

job.waitForCompletion(true);

} catch (InterruptedException e) {

e.printStackTrace();

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

} catch (IOException e) {

e.printStackTrace();

} } }

输出目录要有带columnFamily的文件HFile才生成成功:

4、需要先配置自己HBase_HOME 在配置文件中自己查看。

echo $HBase_HOME

5、我的配置:export HBASE_HOME=/home/hbase-1.0.0-cdh5.4.7

输入:

HADOOP_CLASSPATH=`${HBASE_HOME}/bin/hbase classpath` hadoop jar ${HBASE_HOME}/lib/hbase-server-1.0.0-cdh5.4.7.jar

例如我的:

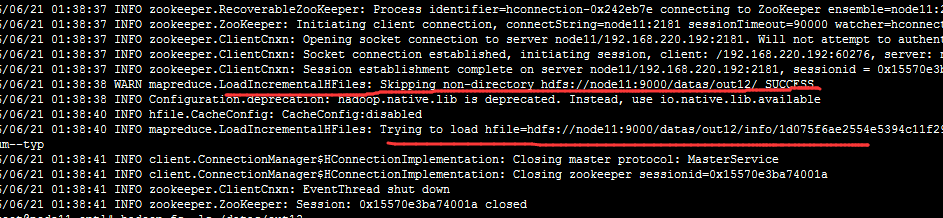

HADOOP_CLASSPATH=`${HBASE_HOME}/bin/hbase classpath` hadoop jar /home/hbase-1.0.0-cdh5.4.7/lib/hbase-server-1.0.0-cdh5.4.7.jar completebulkload /datas/out12 t2

一般执行到这步就 成功导入。

6、查询HBase

7、HBase-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!--

/**

*

* Licensed to the Apache Software Foundation (ASF) under one

* or more contributor license agreements. See the NOTICE file

* distributed with this work for additional information

* regarding copyright ownership. The ASF licenses this file

* to you under the Apache License, Version 2.0 (the

* "License"); you may not use this file except in compliance

* with the License. You may obtain a copy of the License at

*

* http://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

*/

-->

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://node11:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>node11</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property> <property>

<name>hbase.regionserver.wal.codec</name>

<value>org.apache.hadoop.hbase.regionserver.wal.IndexedWALEditCodec</value>

</property> <property>

<name>hbase.region.server.rpc.scheduler.factory.class</name>

<value>org.apache.hadoop.hbase.ipc.PhoenixRpcSchedulerFactory</value>

<description>Factory to create the Phoenix RPC Scheduler that uses separate queues for index and metadata updates</description>

</property> <property>

<name>hbase.rpc.controllerfactory.class</name>

<value>org.apache.hadoop.hbase.ipc.controller.ServerRpcControllerFactory</value>

<description>Factory to create the Phoenix RPC Scheduler that uses separate queues for index and metadata updates</description>

</property> <property>

<name>hbase.coprocessor.regionserver.classes</name>

<value>org.apache.hadoop.hbase.regionserver.LocalIndexMerger</value>

</property> <property>

<name>hbase.master.loadbalancer.class</name>

<value>org.apache.phoenix.hbase.index.balancer.IndexLoadBalancer</value>

</property>

<property>

<name>hbase.coprocessor.master.classes</name>

<value>org.apache.phoenix.hbase.index.master.IndexMasterObserver</value>

</property> </configuration>

用MR生成HFile文件格式后,数据批量导入HBase的更多相关文章

- 数据批量导入HBase

测试数据: datas 1001 lilei 17 13800001111 1002 lily 16 13800001112 1003 lucy 16 13800001113 1004 meimei ...

- SQL Server中bcp命令的用法以及数据批量导入导出

原文:SQL Server中bcp命令的用法以及数据批量导入导出 1.bcp命令参数解析 bcp命令有许多参数,下面给出bcp命令参数的简要解析 用法: bcp {dbtable | query} { ...

- .net core利用MySqlBulkLoader大数据批量导入MySQL

最近用core写了一个数据迁移小工具,从SQLServer读取数据,加工后导入MySQL,由于数据量太过庞大,数据表都过百万,常用的dapper已经无法满足.三大数据库都有自己的大数据批量导入数据的方 ...

- 将execl里的数据批量导入数据库

本文将采用NPOI插件来读取execl文件里的数据,将数据加载到内存中的DataTable中 /// <summary> /// 将Excel转换为DataTable /// </s ...

- mysql中把一个表的数据批量导入另一个表中

mysql中把一个表的数据批量导入另一个表中 不管是在网站开发还是在应用程序开发中,我们经常会碰到需要将MySQL或MS SQLServer某个表的数据批量导入到另一个表的情况,甚至有时还需要指定 ...

- ELK数据批量导入

数据批量导入 • 使用 _bulk 批量导入数据 – 批 ...

- [Django]数据批量导入

前言:历经一个月的复习,考试终于结束了.这期间上班的时候有研究了Django网页制作过程中,如何将数据批量导入到数据库中. 这个过程真的是惨不忍睹,犯了很多的低级错误,这会在正文中说到的.再者导入数据 ...

- 将Excle中的数据批量导入数据库

namespace 将Excle中的数据批量导入数据库{ class Program { static void Main(string[] args) { S ...

- Java实现Excel数据批量导入数据库

Java实现Excel数据批量导入数据库 概述: 这个小工具类是工作中的一个小插曲哦,因为提数的时候需要跨数据库导数... 有的是需要从oracle导入mysql ,有的是从mysql导入oracle ...

随机推荐

- Linux之systemd服务配置及自动重启

layout: post title: Linux之systemd服务配置及自动重启 date: 2019-09-09 tags: linux --- Linux之systemd服务配置及自动重启 0 ...

- facenet 人脸识别(一)

前言 已完成TensorFlow Object Detection API环境搭建,具体搭建过程请参照: 安装运行谷歌开源的TensorFlow Object Detection API视频物体识别系 ...

- macos Item2 添加 Shell Integration (ftp传输)

macos系统 的item2软件 的 Shell Integration (ftp传输) 功能强大,无需 安装其他ftp软件,也是为了保证 密码安全 在使用时报错如下(因为本地 ping不通): ...

- vue不是内部或外部命令的解决方法

1.在nodejs的安装目录下,找到vue.cmd,将此路径加到环境变量中,我是通过nvm管理node版本的,路径是C:\Users\hy\AppData\Roaming\nvm\v6.10.0,关闭 ...

- extjs6.0 treepanel设置展开和设置选中

var treePanel = { id: "treeUrl", xtype: "treepanel", useArrows: true, // 节点展开+,- ...

- 第三节 基本数据写入 --------增加&查询

启动mongodb服务 net start mongodb 链接mongodb 进入bin目录 mongo 127.0.0.1:12345 启动连接 show dbs 显示所有的数据库 use ...

- BZOJ3331 BZOJ2013 压力

考前挣扎 圆方树这么早就出现了嘛... 要求每个点必须被经过的次数 所以就是路径上的割点/端点++ 由于圆方树上所有非叶子圆点都是割点 所以就是树上差分就可以辣. 实现的时候出了一点小问题. 就是这里 ...

- 01.springboot入门--启用自动配置注解EnableAutoConfiguration

springboot入门 <parent> <groupId>org.springframework.boot</groupId> <artifactId&g ...

- 每天一个Linux命令:find(20)

find find命令在目录结构中搜索文件,并执行指定的操作.Linux下find命令提供了相当多的查找条件,功能很强大.由于find具有强大的功能,所以它的选项也很多,其中大部分选项都值得我们花时间 ...

- Dataphin的代码自动化能力如何助力商业决策

前言 随着大数据趋势的迅速增长,数据的重要性与日俱增,企业内看数据.用数据的诉求越来越强烈,其中最常见的就是各种经营报表数据:老板每日早晨9点准时需要看到企业核心的经营数据,以便进行企业战略及方向决策 ...