实验八. urllib模块、requests模块+BeautifulSoup模块使用、Feapder框架

一、实验目标:

熟悉模块的的用法,练习编写爬虫

二、实验要求:

编写代码,完成功能

三、实验内容:

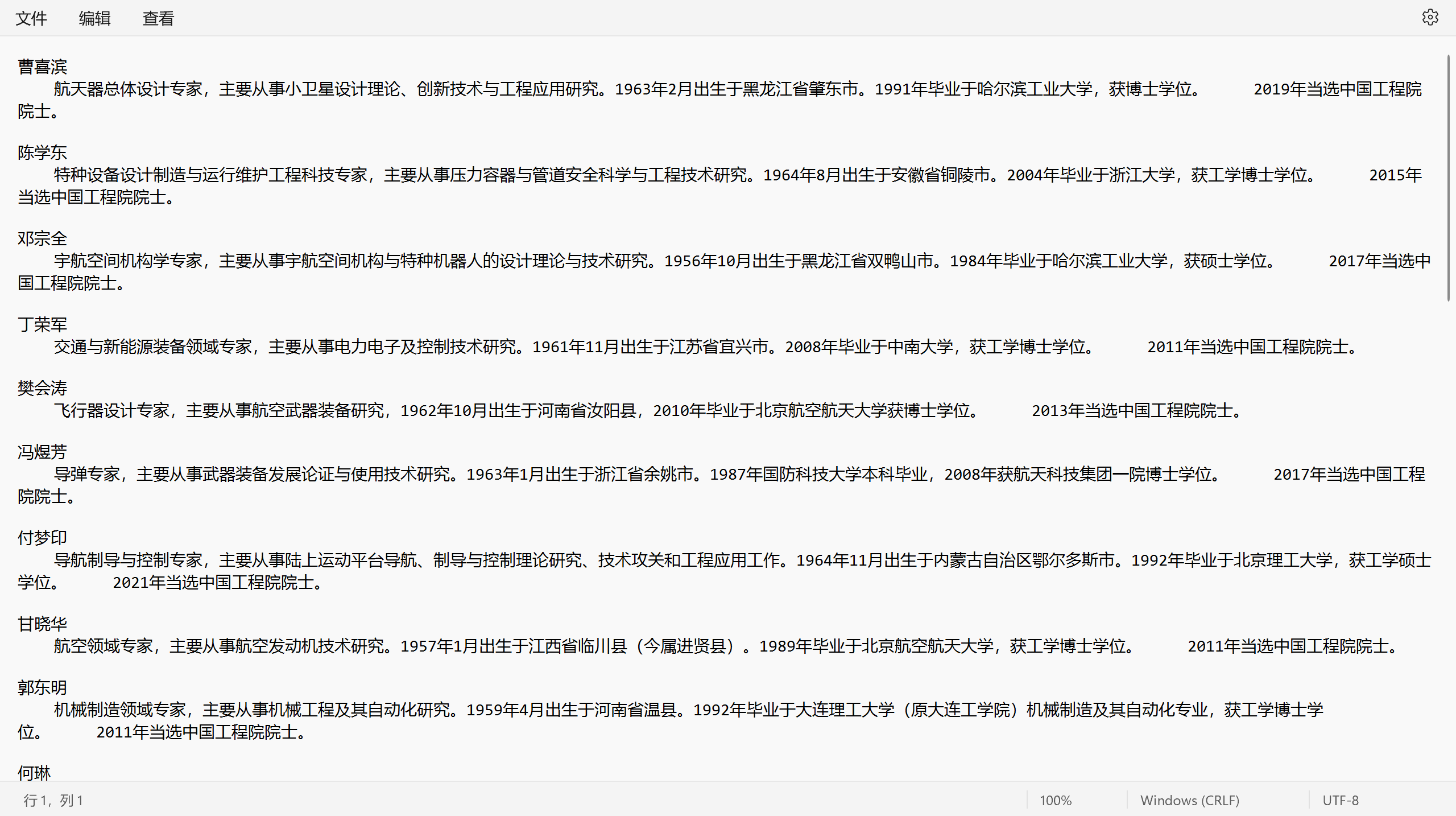

(1)使用urllib模块或request模块读取网页内容,并利用BeautifulSoup模块进行内容解析,编写爬虫从http://www.cae.cn/cae/html/main/col48/column_48_1.html爬取中国工程院院士信息

- 模块导入:

import requests

from bs4 import BeautifulSoup

- 伪造请求头:

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36 Edg/119.0.0.0"

}

- 爬取信息:

import requests

from bs4 import BeautifulSoup

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36 Edg/119.0.0.0"

}

response1 = requests.get("http://www.cae.cn/cae/html/main/col48/column_48_1.html",headers=headers)

content = response1.text

soup = BeautifulSoup(content, "html.parser")

names_lists = soup.find_all("li", attrs={"class": "name_list"})

for name in names_lists:

li = BeautifulSoup(str(name), "html.parser")

Name = li.find_all('a')

link = Name[0].get('href')

Link = "http://www.cae.cn"+link

Content = requests.get(Link,headers=headers).text

Soup = BeautifulSoup(Content,"html.parser")

Intro = Soup.find_all("div",attrs={"class":"intro"})

intro = BeautifulSoup(str(Intro[0]),"html.parser")

text = intro.find_all("p")

Text=''

for i in text:

Text=Text+i.text

with open(r"C:\Users\86135\Desktop\院士名单.txt", 'a', encoding='utf-8') as f:#写入文件

f.write(Name[0].string+'\n')

f.write(Text+'\n')

f.write('\n')

- 爬取结果:

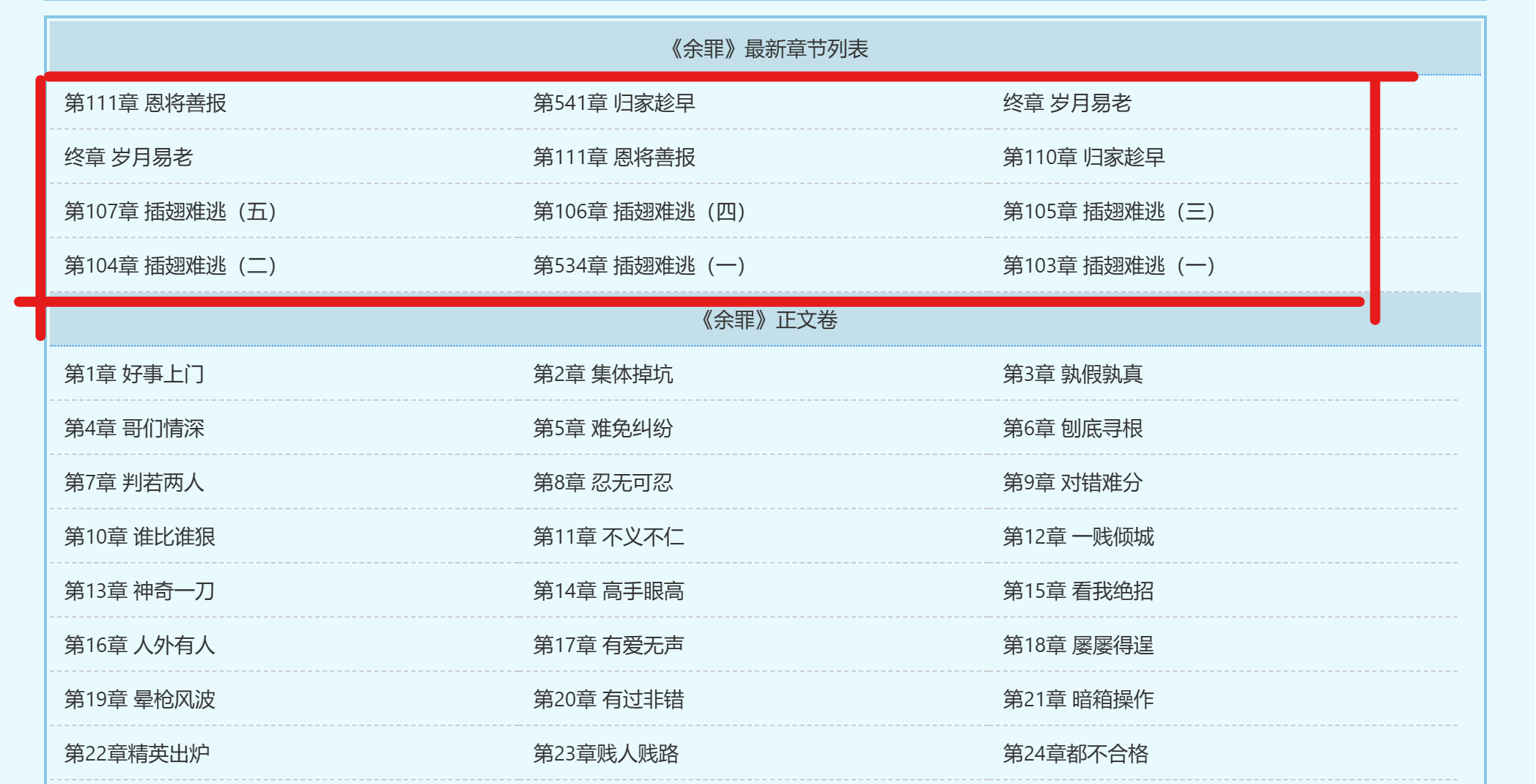

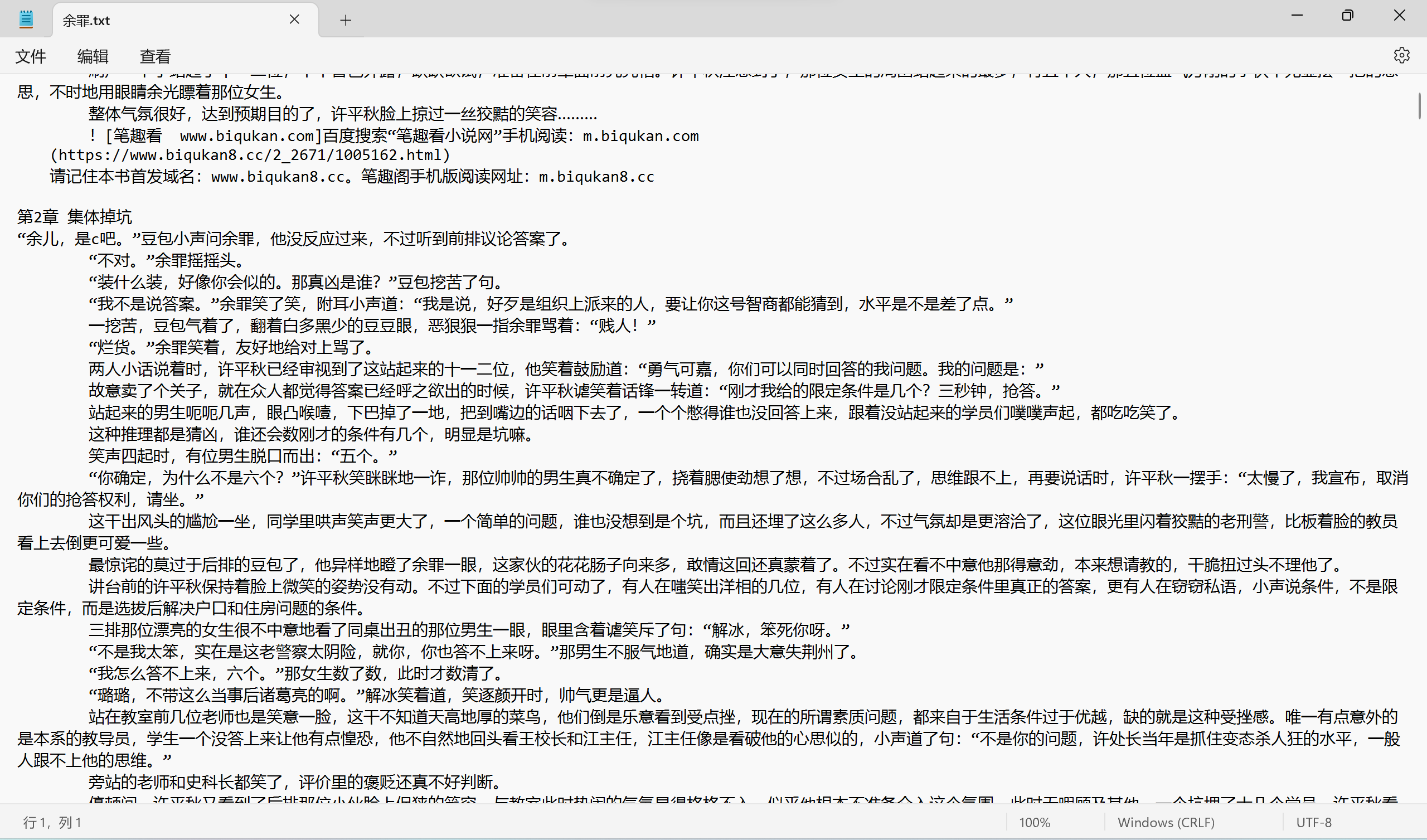

(2)使用urllib模块或request模块读取网页内容,并利用BeautifulSoup模块进行内容解析,编写爬虫从https://www.biqukan.com/2_2671爬取小说《余罪》的内容。要求最终爬取的内容从第一章开始,且不存在大量空格等非必要字符。

由于小说首页不是从第一章开始,我们需要确定第一章的起始位置和最后一章的终止位置

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36 Edg/119.0.0.0"

}

content = requests.get("https://www.biqukan8.cc/2_2671",headers=headers).text

soup = BeautifulSoup(content,"html.parser")

titles = soup.find_all('a')

num = 0

global start , end

for title in titles:

num = num + 1

if title.string == '第1章 好事上门':

start = num

if title.string == "都市之战神之王陈锋林雨欣":

end = num

然后处理html中的a标签中的href元素得到每一章跳转的url

for i in range(start-1,end-1):

link = BeautifulSoup(str(titles[i]),"html.parser")

Li = link.find("a")

Link = "https://www.biqukan8.cc/"+Li["href"]

然后爬取每一个Link中的特征为div,class为showtxt,id为content的小说正文,并将标题和正文写入文件

for i in range(start-1,end-1):

link = BeautifulSoup(str(titles[i]),"html.parser")

Li = link.find("a")

Link = "https://www.biqukan8.cc/"+Li["href"]

content = requests.get(Link,headers=headers).text

Soup = BeautifulSoup(content,"html.parser")

novel_content = Soup.find('div', {'class': 'showtxt', 'id': 'content'})

novel_text = novel_content.get_text(separator="\n")

with open(r"C:\Users\86135\Desktop\余罪.txt", 'a', encoding='utf-8') as f:

f.write(titles[i].string+'\n')

f.write(novel_text+'\n')

f.write('\n')

最后添加一个可以实时显示进度的功能,完整代码如下:

import requests

import sys

from bs4 import BeautifulSoup

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36 Edg/119.0.0.0"

}

content = requests.get("https://www.biqukan8.cc/2_2671",headers=headers).text

soup = BeautifulSoup(content,"html.parser")

titles = soup.find_all('a')

num = 0

global start , end

for title in titles:

num = num + 1

if title.string == '第1章 好事上门':

start = num

if title.string == "都市之战神之王陈锋林雨欣":

end = num

for i in range(start-1,end-1):

link = BeautifulSoup(str(titles[i]),"html.parser")

Li = link.find("a")

Link = "https://www.biqukan8.cc/"+Li["href"]

content = requests.get(Link,headers=headers).text

Soup = BeautifulSoup(content,"html.parser")

novel_content = Soup.find('div', {'class': 'showtxt', 'id': 'content'})

novel_text = novel_content.get_text(separator="\n")

with open(r"C:\Users\86135\Desktop\余罪.txt", 'a', encoding='utf-8') as f:

f.write(titles[i].string+'\n')

f.write(novel_text+'\n')

f.write('\n')

if (i + 1) % 10 == 0:

# 将下载进度输出到控制台,实时变动

sys.stdout.write(" 已下载:%.3f%%" % float((i + 1) * 100 / (end-start+2)) + '\r')

# 刷新缓存区

sys.stdout.flush()

print('下载完成')

print("————————END————————")

- 爬取结果:

(3)学习使用Feapder框架,编写爬虫,爬取中国工程院院士信息。

import feapder

class TophubSpider(feapder.AirSpider):

def start_requests(self):

yield feapder.Request("http://www.cae.cn/cae/html/main/col48/column_48_1.html")

def parse(self, request, response):

# 提取网站title

print(response.xpath("//title/text()").extract_first())

# 提取网站描述

print(response.xpath("//meta[@name='description']/@content").extract_first())

print("网站地址: ", response.url)

# 提取所有class为name_list的li元素下的a元素的href和文本内容

items = response.xpath("//li[@class='name_list']//a")

for item in items:

href = item.xpath("@href").extract_first()

person_name = item.xpath("string(.)").extract_first()

print("Found href:", href)

# Follow the link and parse the information from the 'intro' div

yield feapder.Request(url=href, callback=self.parse_intro, meta={'person_name': person_name})

def parse_intro(self, request, response):

# Extract information from the 'intro' div

intro_text = response.xpath("//div[@class='intro']//p/text()").extract()

# Concatenate the text and remove extra spaces

formatted_text = " ".join(map(str.strip, intro_text))

# Extract person_name from meta

person_name = request.meta['person_name']

# Write person_name and information to the file

with open(r"C:\Users\86135\Desktop\院士信息.txt", "a", encoding="utf-8") as file:

file.write(person_name + "\n")

file.write(formatted_text + "\n")

print(f"Information for {person_name} has been saved to 工程院士信息.txt")

if __name__ == "__main__":

TophubSpider().start()

四、实验总结:

本次实验对python的BeautifulSoup+request模块的使用有了更深刻的理解,对Feapder框架的使用有了进一步的了解。

实验八. urllib模块、requests模块+BeautifulSoup模块使用、Feapder框架的更多相关文章

- Python使用urllib,urllib3,requests库+beautifulsoup爬取网页

Python使用urllib/urllib3/requests库+beautifulsoup爬取网页 urllib urllib3 requests 笔者在爬取时遇到的问题 1.结果不全 2.'抓取失 ...

- requests和BeautifulSoup模块的使用

用python写爬虫时,有两个很好用第三方模块requests库和beautifulsoup库,简单学习了下模块用法: 1,requests模块 Python标准库中提供了:urllib.urllib ...

- python 跨语言数据交互、json、pickle(序列化)、urllib、requests(爬虫模块)、XML。

Python中用于序列化的两个模块 json 用于[字符串]和 [python基本数据类型] 间进行转换 pickle 用于[python特有的类型] 和 [python基本数据类型]间进 ...

- Python 网络请求模块 urllib 、requests

Python 给人的印象是抓取网页非常方便,提供这种生产力的,主要依靠的就是 urllib.requests这两个模块. urlib 介绍 urllib.request 提供了一个 urlopen 函 ...

- 【黑金原创教程】【FPGA那些事儿-驱动篇I 】实验八:PS/2模块② — 键盘与组合键

实验八:PS/2模块② — 键盘与组合键 实验七之际,我们学习如何读取PS/2键盘发送过来的通码与断码,不过实验内容也是一键按下然后释放,简单按键行为而已.然而,实验八的实验内容却是学习组合键的按键行 ...

- 3.10-通过requests、BeautifulSoup、webbrowser模块的相关方法,爬取网页数据示例程序(一)

import requests,bs4res=requests.get('https://www.hao123.com/')print('res对象的类型:',type(res))res.raise_ ...

- centos6装python3,并安装requests, lxml和beautifulsoup模块

一. 安装python3并设为默认版本,与python2共存 1.下载Python3.4安装包 wget https://www.python.org/ftp/python/3.4.4/Pytho ...

- bs4——BeautifulSoup模块:解析网页

解析由requests模块请求到的网页 import requests from bs4 import BeautifulSoup headers = {'User-Agent': 'Mozilla/ ...

- Python 爬虫三 beautifulsoup模块

beautifulsoup模块 BeautifulSoup模块 BeautifulSoup是一个模块,该模块用于接收一个HTML或XML字符串,然后将其进行格式化,之后遍可以使用他提供的方法进行快速查 ...

- requsets模块和beautifulsoup模块

2.requests模块方法 requests是基于Python开发的HTTP库,使用Requests可以轻而易举的完成浏览器可有的任何操作. request.get() request.post() ...

随机推荐

- CSS – Flex

前言 Flex 诞生在 Float 之后, Grid 之前, 它主要是取代 Float 来实现布局. 而它没有 cover 到的地方则由 Grid 弥补. 所以当前, 我们做布局时, 几乎不用 Flo ...

- GPT最佳实践:五分钟打造你自己的GPT

前几天OpenAI的My GPTs栏目还是灰色的,就在今天已经开放使用了.有幸第一时间体验了一把生成自己的GPT,效果着实惊艳!!!我打造的GPT模型我会放到文章末尾,大家感兴趣也可以自己体验一下. ...

- QT疑难杂症之如何使用自定义模型实现文件系统模型?类似QFileSystemModel,却比QFileSystemModel更好用

简介 本文讨论了QT文件系统模型QFileSystemModel的不足之处,并且讨论了改进目标,如何实现自定义文件系统模型,以及进一步改进的空间. 目录 QFileSystemModel的不足之处 改 ...

- SD卡的基本知识与选购指南

1.SD卡与TF卡 SD 卡:又叫标准 SD 卡,其尺寸大小为 32 x 24 x 2.1 mm ,一般用于数码相机.声卡和采集卡等设备. TF 卡:又叫 micro SD 卡,其尺寸大小为 15 x ...

- module_softdep

所谓的MODULE_SOFTDEP,就是两个两个模块之间本有依赖,但是一定要要加载顺序的要求. 用法很简单. #define MODULE_SOFTDEP(_softdep) MODULE_INFO( ...

- 技术分享 | 徐轶韬:从MySQL5.7升级到MySQL 8.0

在6月20日举办的[墨天轮数据库沙龙-MySQL 5.7 停服影响与应对方案]中,甲骨文MySQL解决方案首席工程师徐轶韬分享了<从MySQL5.7升级到MySQL 8.0>主题演讲,本文 ...

- iOS关于列表布局的几种实现方式小结

最近在项目开发中,遇到了常见的列表布局样式,功能的要求是最多六行,动态展示.当时想到的方案是,抽象出一个cell,初始化六个标签,动态的控制显示和隐藏,这样功能上没有问题,就是代码有些冗余.请教了身边 ...

- nextjs 的函数,参数,属性装饰器的使用

// 属性装饰器 const doc1:PropertyDecorator = (target:any,val: string | symbol) => { console.log(target ...

- flink jobmanager 终止任务失败问题

flink jobmanager 终止任务失败问题 :root { --default-font: ui-sans-serif, -apple-system, BlinkMacSystemFont, ...

- 全局负载均衡、CDN内容分发的原理与实践

CDN简介 CDN的全称是Content Delivery Network,即内容分发网络.CDN是构建在现有网络基础之上的智能虚拟网络,依靠部署在各地的边缘服务器,通过中心平台的负载均衡.内容分发. ...