用mapreduce 处理气象数据集

用mapreduce 处理气象数据集

编写程序求每日最高最低气温,区间最高最低气温

气象数据集下载地址为:ftp://ftp.ncdc.noaa.gov/pub/data/noaa

- 按学号后三位下载不同年份月份的数据(例如201506110136号同学,就下载2013年以6开头的数据,看具体数据情况稍有变通)

- 解压数据集,并保存在文本文件中

- 对气象数据格式进行解析

- 编写map函数,reduce函数

- 将其权限作出相应修改

- 本机上测试运行代码

- 放到HDFS上运行

- 将之前爬取的文本文件上传到hdfs上

- 用Hadoop Streaming命令提交任务

- 查看运行结果

本次的所有操作均在当前用户目录下的/temp/2018-05-09中

通过wget下载压缩文件,命令如下:

wget -drc --accept-regex=REGEX -P data ftp://ftp.ncdc.noaa.gov/pub/data/noaa/2015/6*

在这之前,需要配置好环境,在.bashrc中加入下面的命令

export PATH=$PATH:/usr/local/hbase/bin:/usr/local/hadoop/sbin:/usr/local/hadoop/bin

export HADOOP_HOME=/usr/local/hadoop

export STREAM=$HADOOP_HOME/share/hadoop/tools/lib/hadoop-streaming-*.jar

下载后解压,之后启动hdfs,将解压文件放入系统中,命令如下

start-dfs.sh

hdfs dfs -mkdir weather_data

hdfs dfs -put weather.txt weather_data/

文件放入系统后可以编写mapper.py了,主要代码如下:

import sys

for line in sys.stdin:

line = line.strip()

print('%s\t%d' % (line[15:23], int(line[87:92])))

reducer.py了,主要代码如下:

from operator import itemgetter

import sys

current_date = None

current_temperature = 0

date = None

for line in sys.stdin:

line = line.strip()

date, temperature = line.split('\t', 1)

try:

temperature = int(temperature)

except ValueError:

continue

if current_date == date:

if current_temperature < temperature:

current_temperature = temperature

else:

if current_date:

print('%s\t%d' % (current_date, current_temperature))

current_temperature = temperature

current_date = date

if current_date == date:

print('%s\t%d' % (current_date, current_temperature))

上面的reducer是求出最高气温,求出最低只需要将

if current_temperature < temperature:改为 if current_temperature > temperature:

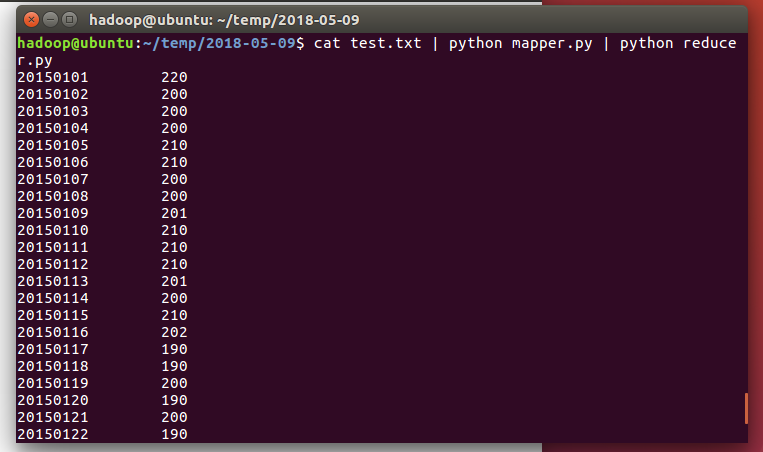

这里测试运行mapper和reducer,命令如下:

chmod a+x mapper.py

chmod a+x reducer.py

cat test.txt | python mapper.py | python reducer.py

test.txt中包含了部分的天气数据

下面是运行截图:

运行成功后可编写run.sh

hadoop jar $STREAM \

-D stream.non.zero.exit.is.failure=false \

-file /home/hadoop/temp/2018-05-09/mapper.py \

-mapper 'python /home/hadoop/temp/2018-05-09/mapper.py' \

-file /home/hadoop/temp/2018-05-09/reducer.py \

-reducer 'python /home/hadoop/temp/2018-05-09/reducer.py' \

-input /user/hadoop/weather_data/*.txt \

-output /user/hadoop/weather_output

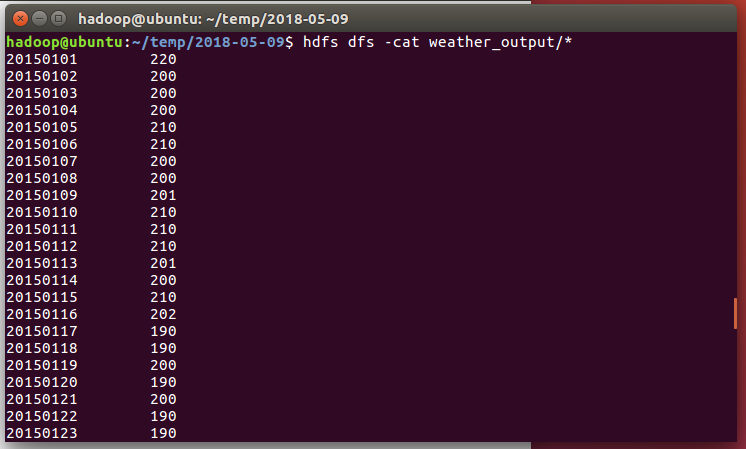

运行run.sh

source run.sh

最后的运行结果通过cat打印截图:

/temp下的文件在链接中下载

用mapreduce 处理气象数据集的更多相关文章

- MapReduce处理气象数据

老师:MissDu 提交作业 1. 用Python编写WordCount程序并提交任务 程序 WordCount 输入 一个包含大量单词的文本文件 输出 文件中每个单词及其出现次数(频数),并按照单 ...

- Hadoop第5周练习—MapReduce计算气象温度等例子

:对云计算的看法 内容 :使用MapReduce求每年最低温度 内容 :求温度平均值能使用combiner吗? 内容 :使用Hadoop流求最高温度(awk脚本) 内容 :使用Hadoop流求最高温度 ...

- Hadoop—MapReduce计算气象温度

Hadoop-MapReduce计算气象温度 1 运行环境说明 1.1 硬软件环境 主机操作系统:Mac OS 64 bit ,8G内存 虚拟软件:Parallers Desktop12 虚拟机操作系 ...

- 《Hadoop权威指南》(Hadoop:The Definitive Guide) 气象数据集下载脚本

已过时,无法使用 从网上找到一个脚本,修改了一下 #!/bin/bash CURRENT_DIR=$(cd `dirname $0`; pwd) [ -e $CURRENT_DIR/ncdc ] || ...

- Hadoop和MapReduce初识

我们生活在大数据时代!!!微博.微信.云存储等大数据的需求,Hadoop由此诞生. 以下面部分数据为例: 1)Facebook存储着约100亿张照片,约1PB存储容量: 2)纽约证券交易所每天产生1T ...

- mapreduce实战:统计美国各个气象站30年来的平均气温项目分析

气象数据集 我们要写一个气象数据挖掘的程序.气象数据是通过分布在美国各地区的很多气象传感器每隔一小时进行收集,这些数据是半结构化数据且是按照记录方式存储的,因此非常适合使用 MapReduce 程序来 ...

- 关于 MapReduce

继续摘抄<Hadoop 权威指南>第二章,跳过不少于我复杂的东西,但依然是捉急的效率,开始觉得看不完另外一本全英文的书,大概每天要看5页吧... 以上. MapReduce 是一种可用于数 ...

- MapReduce原理及操作

注意:本实验是对前述实验的延续,如果直接点开始实验进入则需要按先前学习的方法启动hadoop 部署节点操作系统为CentOS,防火墙和SElinux禁用,创建了一个shiyanlou用户并在系统根目录 ...

- Hadoop阅读笔记(一)——强大的MapReduce

前言:来园子已经有8个月了,当初入园凭着满腔热血和一脑门子冲动,给自己起了个响亮的旗号“大数据 小世界”,顿时有了种世界都是我的,世界都在我手中的赶脚.可是......时光飞逝,岁月如梭~~~随手一翻 ...

随机推荐

- JAVA基础第五章-集合框架Map篇

业内经常说的一句话是不要重复造轮子,但是有时候,只有自己造一个轮子了,才会深刻明白什么样的轮子适合山路,什么样的轮子适合平地! 我将会持续更新java基础知识,欢迎关注. 往期章节: JAVA基础第一 ...

- python enumerate() 函数的使用方法

列表是最常用的Python数据类型,前段时间看书的时候,发现了enumerate() 函数非常实用,因为才知道下标可以这么容易的使用,总结一下. class enumerate(object): &q ...

- 《HelloGitHub》第 34 期

公告 新年快乐!大家的年终奖都发了啥? <HelloGitHub>第 34 期 兴趣是最好的老师,HelloGitHub 就是帮你找到兴趣! 简介 分享 GitHub 上有趣.入门级的开源 ...

- 如何使用JS来开发室内地图商场停车场车位管理系统

在线体验到室内地图的功能后,手机对室内地图加载一个字,要显示“快”,目前微信和电脑都可以打开室内地图的要求是3秒内打开,能有定位导航的功能最好,这样方便找到要去的地方. 对于经常逛商场的MM来说,哪里 ...

- phpmyadmin登陆错误:The requested URL /phpmyadmin was not found on this serve

解决方法: 首先,重新安装apache2: sudo dpkg-reconfigure -plow phpmyadmin 配置时记得选择apache2 如果仍然无法登陆,再对phpmyadmin和a ...

- 【译】MongoDb vs Mysql—以NodeJs为例

亲爱的读者,您可能想知道为什么要写关于MongoDb和MySql这篇文章.那是因为我与NodeJs开发人员讨论在应用程序中使用哪种数据存储作为主要的数据存储方式. 我看过很多评论都在争论这个问题. 有 ...

- 阿里云或本地部署服务器(一)---nginx本地和服务器代理

具体步骤: 1.nginx下载 2.在G:\nginx-1.15.8\conf/nginx.conf改三处路径:nginx.conf 文件中配置的路径和端口要映射到vue项目工程 a.改 映射端口: ...

- PostgreSQL 10.7 linux 主从配置

PostgreSQL 10.7 主从安装 硬件环境 云服务商:华为云 Linux: CentOS7.1 工具:Xshell Xftp IP:114.115.251.168 Port: 5432 543 ...

- Microsoft Edge浏览器下载文件乱码修复方法(二)

之前有写过"Microsoft Edge浏览器下载文件乱码修复方法",发现很多情况下下载文件乱码问题还是存在,这里对之前内容做简单补充,希望可以帮到大家. 方法二: 默认如果提示下 ...

- Linux下ps -ef和ps aux的区别

Linux下显示系统进程的命令ps,最常用的有ps -ef 和ps aux.这两个到底有什么区别呢?两者没太大差别,讨论这个问题,要追溯到Unix系统中的两种风格,System V风格和BSD 风格, ...